Google parle de qualité, les SEO parlent de qualité, tout le monde parle de qualité… mais ce n'est pas évident de la mesurer ou au moins l'estimer...

Pourtant, c'est possible de le faire, en tout cas en partie. Je vais vous montrer qu'un de mes algos le fait.

Estimer la qualité technique SEO

La 1ère chose que vous devez faire, c'est valider que d'un point de vue technique, vos optimisations SEO sont toutes en place. Que tous les fondamentaux sont validés, que toutes les optimisations purement techniques sont vraiment bien exploitées.

Pourquoi ? Tout simplement car c'est ce que font tous ceux qui cartonnent ! Croyez-en mon expérience en référencement Google.

Vous ne pouvez pas vous plaindre de ne pas être n°1 dans Google si vous n'avez pas tout fait sur le plan technique (avant de parler de sémantique et de notoriété).

Evidemment, ça ne suffit pas : c'est une condition nécessaire.

- D'abord, validez que vous vous êtes donnés les moyens techniques de réussir votre référencement

- Ensuite, vous devrez peut-être revoir votre stratégie de contenus, et surtout améliorer encore la qualité de vos articles, les mettre à jour, mieux correspondre aux attentes des internautes...

OK, alors comment faire pour vérifier que la qualité technique est au top sur 100% du site ?

Algo pour évaluer la qualité

Avec mon associé Fabien Facéries, j'ai justement mis au point chez My Ranking Metrics un algorithme pour faire le job (en tout cas une partie). Le but est d'estimer la qualité SEO sous l'angle essentiellement technique.

Etant donné que Google évalue la qualité globale d'un site et indique que les pages de faible qualité peuvent dégrader les autres, si une page cumule beaucoup de lacunes on peut parler de risque.

C'est pour ça qu'on l'a appelé QualityRisk (ou QR pour les aficionados). Il va de 0 (page a priori sans problème) à 100 (page a priori horrible). En fait, plus une page a un QR élevé :

- plus c'est risqué car elle pourrait décevoir les internautes

- moins vous vous donnez de chances qu'elle soit performante (en SEO)

C'est vrai ça ? Je vous l'affirme comme ça...

Alors plutôt que de vous sortir une étude sur 36 milliards de pages/requêtes/backlinks, j'ai choisi de démarrer une série d'analyses de sites, publiées ici. Du très concret, vous allez voir.

Pour commencer, voici 2 études de cas :

- pour mon 1er exemple, j'ai pris un truc plutôt enthousiasmant (ça fait pas de mal en ce moment) : un site avec un démarrage canon

- pour mon second exemple, il s'agit d'un des sites ayant subi une grosse chute lors de l'update Google de mai 2020

Pour les suivants j'ai des idées, mais contactez-moi si vous voulez m'en parler.

Exemple 😃 : site dont le SEO décolle

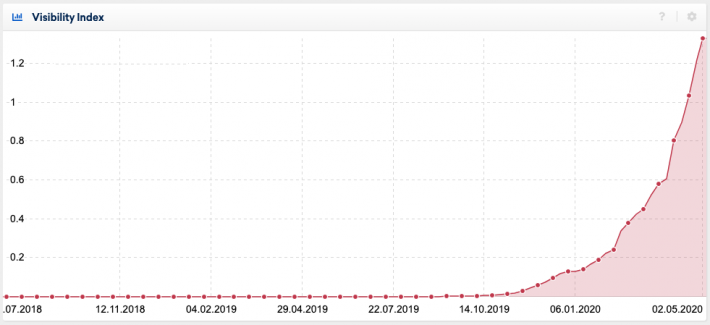

J'ai donc choisi un site d'environ 250 pages mis en ligne en septembre 2019, qui connait une excellente croissance d'après l'estimation de visibilité de Sistrix :

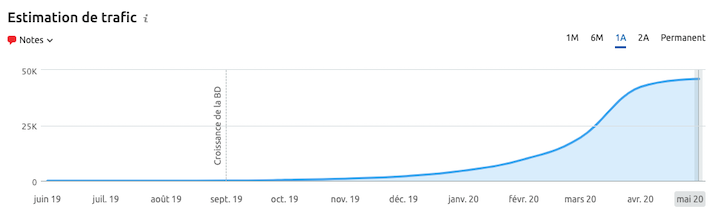

C'est confirmé par Semrush qui estime le trafic actuel à environ 45 000 visites par mois :

J'ai évidemment jeté un oeil à ses backlinks et c'est très très faible. 27 domaines référents dont au moins 20 qui sont des sites sans intérêt (ni notoriété), des sortes de moteurs de recherches d'images. Bref, son succès ne vient clairement pas de là.

Je décide de voir ce que ça donne en termes de QualityRisk. L'audit RM Tech indique avoir trouvé 235 pages indexables. N'ayant pas accès à Google Analytics (GA) et Google Search Console (GSC), je dois me débrouiller pour estimer quelles pages de ce site sont bonnes en SEO et quelles pages sont mauvaises ou font prendre des risques.

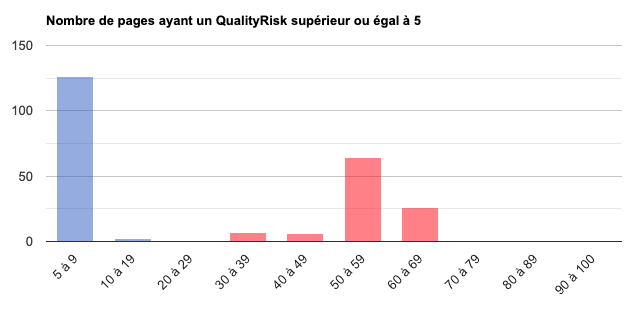

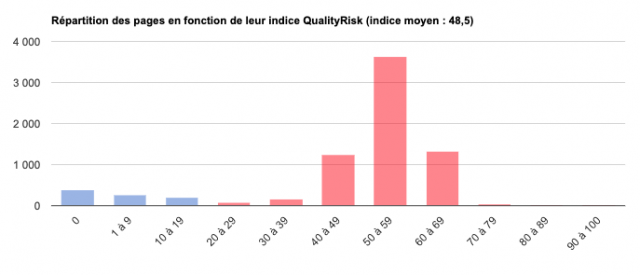

Pour ça j'ai mon algo QualityRisk, dont voici l'histogramme pour ce site :

Je vois un gros pic pour les pages à QR très faible, c'est excellent, c'est ce qu'il faut.

Mais je vois aussi un pic un peu trop élevé (surtout entre 50 et 70) : je pense que ces pages posent problème pour 2 raisons :

- elles sont un boulet pour les bonnes pages car elles peuvent réduire l'efficacité des bonnes pages (dixit Google)

- si elles sont trop nombreuses et restent ainsi en ligne (indexables) alors elles génèrent un risque pour le SEO futur

Je décide d'étudier et de regarder les 2 typologies de pages.

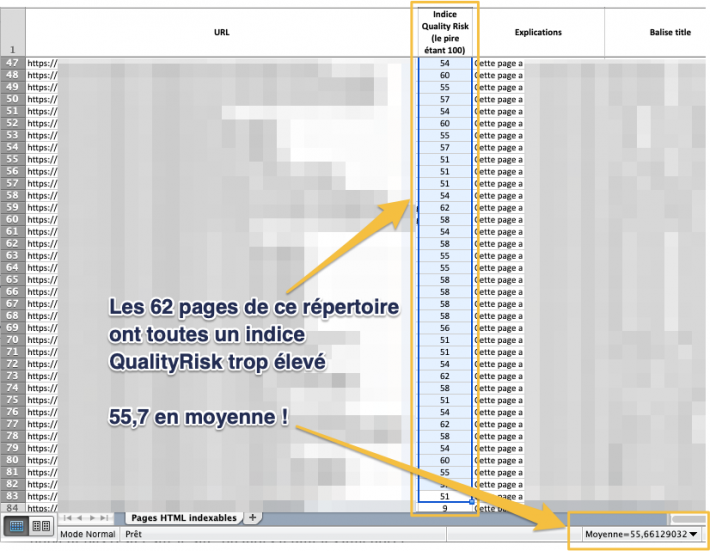

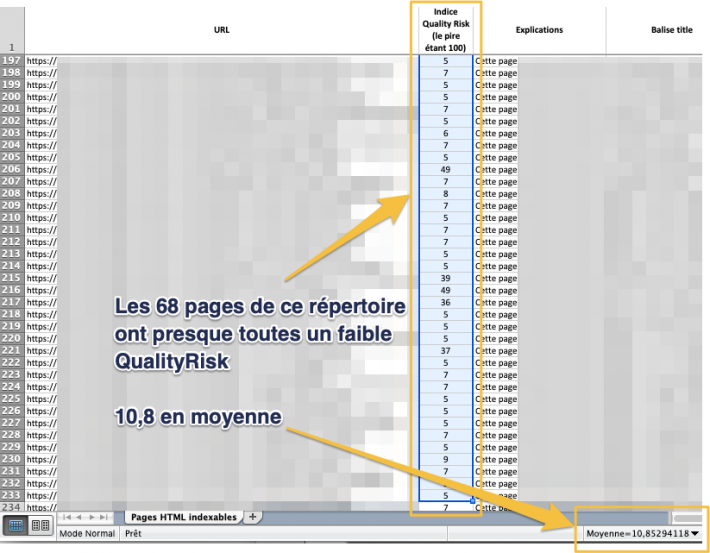

Les pages avec QualityRisk important sont pour la plupart dans un répertoire. Je regarde dans le fichier annexe qui détaille tout et j'en trouve 62. Leur QR moyen est de 55,6 : c'est bien trop élevé. A ce niveau, il est malheureusement probable que ces pages n'aient aucun succès SEO.

Pour le vérifier, j'utilise une super fonctionnalité de Sistrix, à savoir l'analyse par répertoire. L'outil m'indique que toutes ces 62 pages réunies totalisent une visibilité de... 0. Nada. Niet. Rien !

👉 Sistrix m'a confirmé la prédiction faite par mon algo QR : ces pages sont pourries et ne doivent pas rester sur le site, ou alors il faut les améliorer.

📊 Si j'avais accès à GA et GSC pour ce site, je pourrais faire mon analyse zombies et j'aurais des résultats encore plus précis et exploitables.

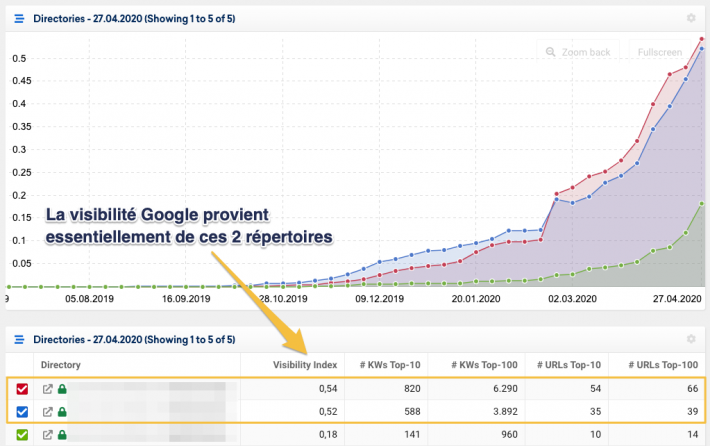

Pour info, Sistrix m'indique les principaux répertoires qui apportent de la visibilité à l'ensemble du site, c'est vraiment top comme analyse, surtout sur un concurrent (mais aussi sur le site d'un prospect). Ici ça donne ça :

OK, je passe à la 2ème catégorie de pages, celles à QR très faible. Une partie d'entre elles sont dans un répertoire précis, j'applique donc le même process. J'en trouve 68 avec un QR moyen de 10,8 : c'est très bien, le risque est vraiment très faible. Vous l'aurez deviné, il s'agit du répertoire de la courbe rouge dans l'image précédente...

J'utilise à nouveau l'analyse par répertoire dans Sistrix et voilà ce que j'obtiens : une excellente visi en énorme croissance :

👉 là encore, j'ai la confirmation que mon algo QR est en phase avec la perf SEO.

Rien qu'à ce stade, sans avoir accès à GA GSC, je peux retenir que :

- en quelques clics j'ai accès à l'ensemble de l'audit RM Tech, incluant l'histogramme QR

- je sais que les pages à fort QR peuvent réduire l'efficacité des bonnes (c'est vraiment idiot) et me font prendre des risques pour des updates futurs

- j'ai dans le fichier annexe tous les détails, avec pour chaque page son indice QR mais aussi les explications sur les raisons probables du mauvais score QR de certaines pages

- Sistrix me permet de confirmer/renforcer mes suspicions (sans avoir accès aux données GA et GSC)

Dit autrement :

QualityRisk est un prédicteur très utile, il peut m'identifier dès la mise en ligne de mes pages si d'un point de vue technique SEO, je leur ai donné toutes les chances de réussir.

Comme ici je n'ai pas accès à GA et GSC, je m'arrête là. Au passage, ça signifie que je sais déjà énormément de choses en ayant passé maximum 5 min. C'est TRES intéressant pour les agences/freelances qui s'adressent à un prospect...😜

Si j'ai accès à GA et GSC, c'est top car la méthode pages zombies me permet d'affiner énormément toute cette analyse. Lisez les détails de ma méthode et la notion de profil zombies.

🤔 Dernière précision : il peut arriver que sur un site, presque toutes les pages aient un indice QualityRisk très faible, et que pourtant le succès ne soit pas au rendez-vous. Cela signifie que vous vous êtes donnés les moyens techniques de réussir votre référencement, mais que votre contenu n'est pas encore de qualité suffisante, ou pas à jour, ou ne correspond pas aux attentes des internautes, ou que votre site n'a pas encore assez de notoriété... Pour faire la part des choses, je vous recommande alors d'appliquer ma méthode pages zombies, bien plus précise que QualityRisk. Mais il vous faut les données GA et GSC.

Exemple ☹️ : site dont le SEO s'écroule

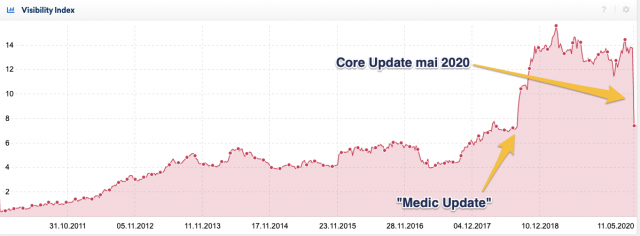

Maintenant qu'on a vu la tête de l'histogramme QualityRisk d'un site qui fonctionne super bien dans Google, je passe au cas inverse... J'ai donc consulté la liste des sites qui selon Sistrix ont le plus souffert du Core Update de Mai 2020 sur Google (source). J'ai choisi un site qui a perdu brutalement presque 40% de sa visibilité Sistrix.

Ce site avait pourtant super bien fonctionné, notamment au moment de l'update baptisé Medic. Il faut dire qu'il s'agit d'un site dit YMYL, en particulier ici un site qui traite de la santé.

Que s'est-il donc passé en mai pour que la chute soit aussi violente ?

Je ne prétends pas avoir toutes les réponses, mais dans ce cas de figure ma position est simple : il faut d'abord avoir éliminé tous les problèmes "classiques". Comment voulez-vous comprendre pourquoi l'algo de Google n'aime plus votre site, même/surtout un site estampillé YMYL, si vous n'avez pas corrigé tout ce qui pouvait l'être ?

J'ai donc lancé un audit RM Tech afin d'évaluer la qualité technique du site. Mon algo QualityRisk est sans appel sur ce site, voici les résultats :

On est bien d'accord que résoudre les problèmes techniques listés dans le rapport RM Tech ne suffit pas à éviter cette chute, ou la rattraper après coup. En partie tout de même, c'est possible...

Mais si ça vous arrive, ou mieux avant que ça vous arrive, assurez-vous d'avoir un pic de pages à QualityRisk 0 et rien d'autre. Aucune barre rouge.

Et vous, ça donne quoi sur votre site ?

Souhaitez-vous le même genre d'analyse pour votre site ?

Je fais quelque chose du genre gratuitement pour quelques jours encore !

Laisser un commentaire