Le 1er août 2018, quand une grande partie des SEO étaient en vacances, Google a mis en ligne ce qui semble être la plus grosse mise à jour algorithmique de l'année.

Comme à chaque fois, certains ont beaucoup perdu, d'autres gagné et parfois l'impact fut faible.

J'espère que ça a été pour vous ? Si ce n'est pas le cas, cet article devrait vous aider... En tout cas c'est mon objectif !

Plutôt que de vous rappeler la belle théorie, je me suis dit que j'allais me baser sur des exemples très concrets, de vous et moi. Vous trouverez donc dans ce dossier :

- un rappel de ce qu'on appelle "Medic Update"

- des retours d'expérience de sites ayant gagné en visibilité/trafic

- mes conseils SEO pour réussir avec le nouvel algo de Google

J'ai donc fait une sélection d'exemples de sites qui ont profité à plein de cette mise à jour. J'ai pris des exemples très variés. Et ensuite j'ai cherché à lister ce qu'il faut faire à mon humble avis pour rester en page 1 de Google avec son nouvel algo.

J'ai eu beaucoup d'échanges que ce soit sur les réseaux sociaux (suivez-moi !), sur le forum WebRankInfo et aussi avec les clients de ma plateforme SEO "My Ranking Metrics".

Bonne lecture, et dites-moi en commentaires comment ça s'est passé pour vous !

Qu'est-ce que la "Google Medic Update" ?

Le 1er août 2018, Google a mis en place un changement majeur de son algorithme utilisé pour le classement des résultats. En clair, ce qui concerne le référencement naturel.

Voici l'annonce faite sur Twitter (source) :

This week we released a broad core algorithm update, as we do several times per year. Our guidance about such updates remains the same as in March, as we covered here.

Ce qui signifie :

Cette semaine, nous avons publié une mise à jour de l'algorithme de base, comme nous le faisons plusieurs fois par an. Nos conseils sur ces mises à jour restent les mêmes qu'en mars, comme nous l'avons dit ici.

Ils font référence à la mise à jour de mars 2018 et à ce tweet.

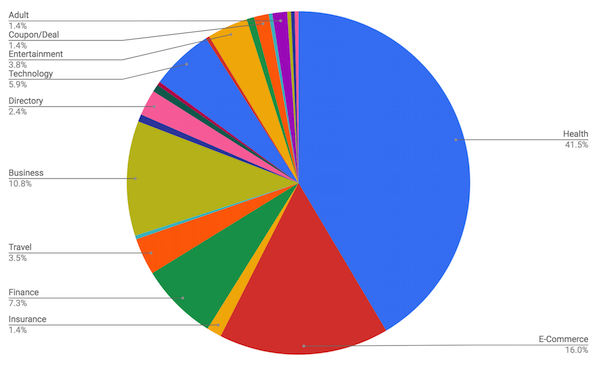

Plusieurs plateformes et SEO ont fait des analyses pour identifier des "patterns" et repérer ce qui pouvait avoir été modifié dans l'algo. Certains ont constaté que l'impact maximum concerne les sites de type YMYL (j'en reparle plus loin). Parmi ses sites, ceux qui traitent de la santé semblent avoir été spécialement visés. D'où cette appellation "Medic Update" proposée par Barry Schwartz suite à son enquête menée sur 300 sites.

Par exemple, Search Metrics indique que les thématiques les plus concernées sont la santé et la finance. Sistrix confirme que les changements les plus importants concernent la médecine. Mozcast a mesuré que la thématique de la santé est celle qui a connu le plus de changements (mais plein d'autres aussi).

Cette mise à jour concerne-t-elle seulement les sites YMYL ?

La réponse est non !

C'est Gary Illyes (de Google) qui l'a déclaré pendant l'événement Search Masters Brazil. Il a indiqué qu'elle n'était pas conçue pour cibler les types de sites YMYL. L'information a été rapportée par Pedro Dias, un ancien salarié de Google. Il a ajouté que selon Gary, "C'était juste une heureuse coïncidence que cela ait également eu un impact sur les sites de cette verticale".

Donc en gros, la communauté SEO va sans doute continuer de l'appeler "Google Medic Update", même si dans la réalité cette mise à jour concerne a priori tout le monde...

4 gagnants de l'update Google du 1er août 2018

J'ai choisi des exemples de sites très différents et correspondant à la majorité d'entre vous, pour vous montrer qu'il y a encore de l'espoir !

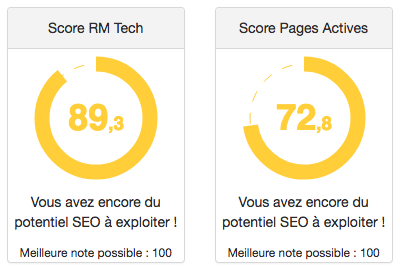

Remarque : pour uniformiser les données publiées ici, j'ai utilisé le même outil (SEMrush), qui permet d'avoir des données même pour les sites des concurrents. Mais je vous assure avoir vérifié que le trafic de ces sites a monté d'un coup au 1er août, tout comme leur positionnement s'est amélioré. Dans certains cas, j'ai complété avec d'autres graphiques.

Site ecommerce de 1600 pages (habillement)

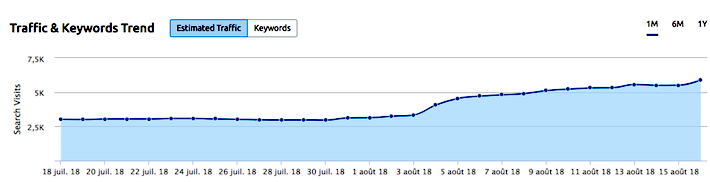

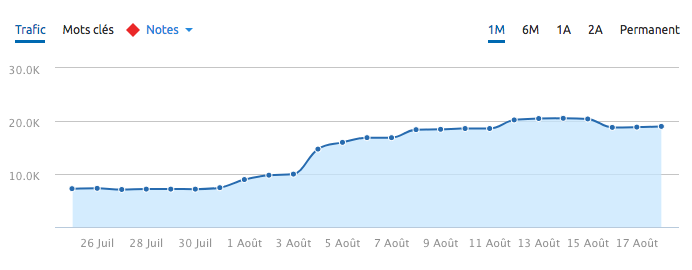

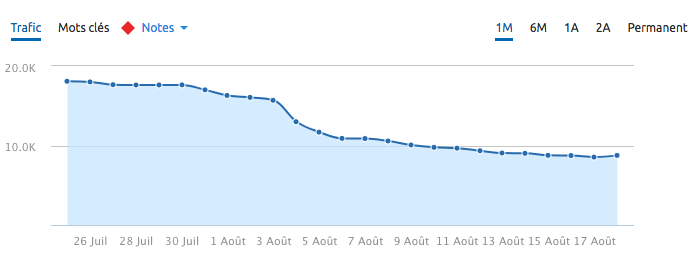

Je commence d'abord par les résultats : son trafic organique a quasiment doublé (pourtant dans une période creuse de l'année)

Voici la courbe Google Analytics (trafic Google/organic uniquement) :

Je vous cite ce qu'il m'a dit avoir fait principalement (quelques mois avant) :

Salut Olivier, suite à ta demande voici ce que j'ai fait :

- nombreuses corrections de problèmes techniques

- ajout de textes sur les pages catégories (environ 500 à 800 mots) et sur quelques fiches produits

- mise à niveau du design et de l'UX

- suppression de certaines pages jamais efficaces même sur 1 an (méthode WebRankInfo des pages actives)

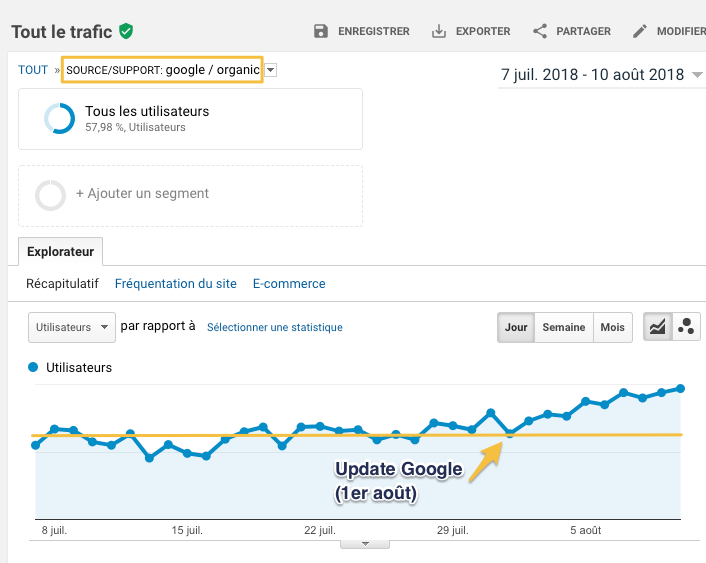

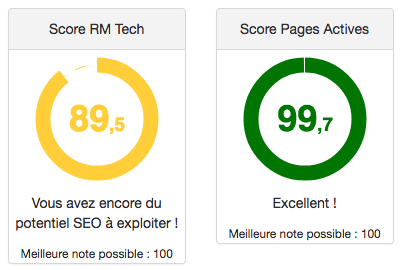

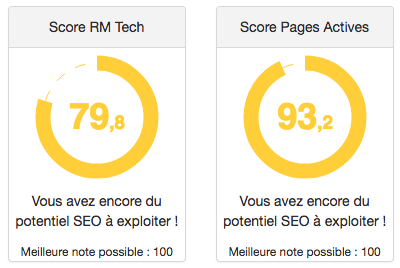

Ses notes avec l'audit RM Tech montrent qu'un gros boulot a déjà été fait :

Ce qu'il peut encore faire pour progresser à mon avis :

- travailler chaque fiche produit stratégique

- finaliser le nettoyage des pages inactives

- accélérer son site

Site de 400 pages dans la finance (YMYL)

Ici, on est en plein dans le site YMYL ("Your Money Your Life", j'en parle plus loin dans cet article, avec des conseils), avec donc des exigences particulières de l'algo de Google.

Voici ce qu'il m'a dit avoir fait :

Partagez l'info sur Twitter en cliquant ici !Click to TweetJ'ai sensiblement progressé lors de la dernière MAJ de l'algo.

Comme c'était le cas pour les précédentes, je note que les pages de faibles qualités décelées par ton outil RM Tech et retravaillées en profondeur finissent quasiment toutes par gagner des positions, parfois de manière spectaculaire. En revanche, j'ai noté qu'un léger "lifting" est parfaitement inutile et qu'il ne faut pas chercher simplement à rallonger la page. C'est pourquoi, je ne retravaille une page que si je pense la transformer en un dossier complet.

J'ai également travaillé en priorité les pages censées être les plus rentables selon RM Tech et dont la note de QualityRisk était la plus élevée. C'était le plus souvent des articles rédigés rapidement au départ, sans réelle plus-value pour l'internaute. Des pages très courtes aussi là où il était plus judicieux de rédiger un dossier complet. A quelques exceptions près, elles ont toutes fini par progresser, parfois de manière spectaculaire.

Ses notes avec l'audit RM Tech montrent qu'un gros boulot a déjà été fait :

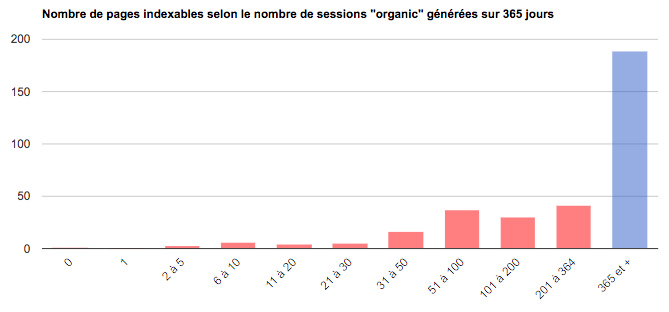

Toujours dans RM Tech, j'ai regardé ce que ça donne en termes de performances SEO, c'est-à-dire la proportion de pages qui arrivent à générer des visites sur 1 an. Dans son cas c'est plutôt bon :

Content de voir que l'aide apportée par mon outil et le travail effectuée ont permis une aussi belle progression !

Site ecommerce B2B de 200 pages

Je commence par un zoom sur début août 2018, on voit une nette progression du trafic issu du référencement naturel :

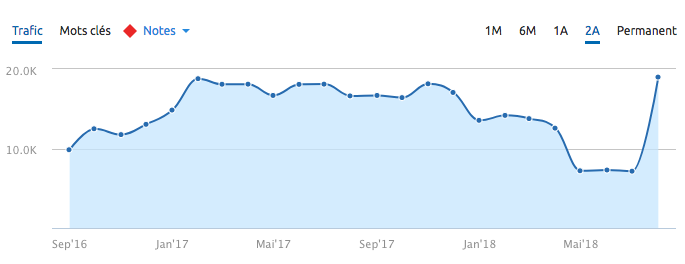

Ce site avait pris un gros coup vers le mois de mars 2018. Suite à ça, voici ce qu'il m'a dit avoir fait :

- ajout de contenu textuel sur les pages de mes listing de produits : pour la plupart une description d'environ 500 mots et pour certaines un guide complet a été ajouté (1200 à 1800 mots)

- suppression d'un nombre important de pages (400 sur 600) identifiées avec RM Tech (pages inactives sur 1 an) et correspondant à des produits non recherchés sur Google

Et voilà ce que ça donne avec le recul sur 2 ans :

Ses notes avec l'audit RM Tech montrent qu'un gros boulot a déjà été fait :

Encourageant non ?

Site de 500 pages dans la santé (YMYL)

Un autre site YMYL, avec des conseils et des services médicaux.

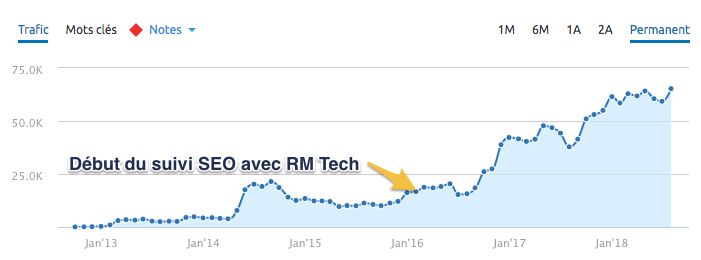

Client de My Ranking Metrics depuis 2016, on le connait bien. Il est hyper sérieux concernant son référencement, depuis des années. Il ne publie que du contenu hyper complet, avec l'auteur bien indiqué (expert reconnu). Dès qu'une erreur est repérée sur le site par RM Tech, il s'occupe de la corriger rapidement. Il a une excellente réputation aussi bien dans son métier que ce qu'on en voit sur le web. Il dispose de nombreux backlinks depuis des sites qui font autorité.

Je l'ai contacté après la mise à jour d'août pour en savoir plus. Sa réponse :

Je fais un monitoring régulier de mon référencement, non seulement avec RM Tech, mais aussi dans les résultats de Google ainsi que dans la Search Console. J'essaie de me mettre dans la peau des internautes que je vise et j'examine les SERP. Je cherche à évaluer si ma page répond correctement à la demande supposée de l'internaute. J'utilise Search Console en regardant sur quelles requêtes mes pages stratégiques sortent, et je vérifie que mes contenus correspondent bien à l'intention de la recherche.

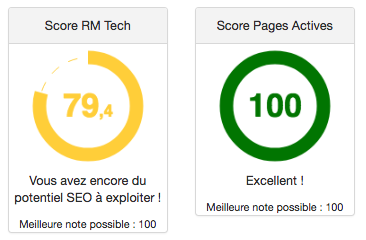

Ses notes avec son dernier audit RM Tech résument la situation :

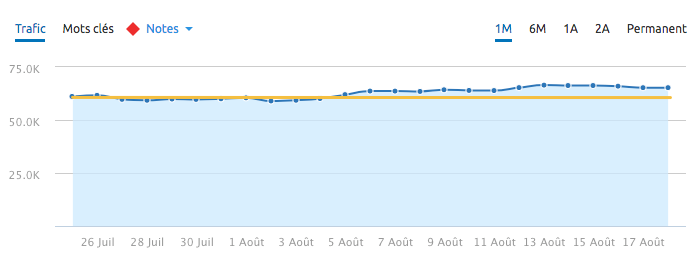

Résultat : à chaque update de Google, son trafic augmente 🔝

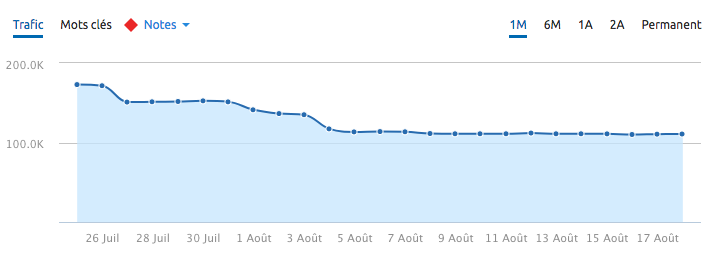

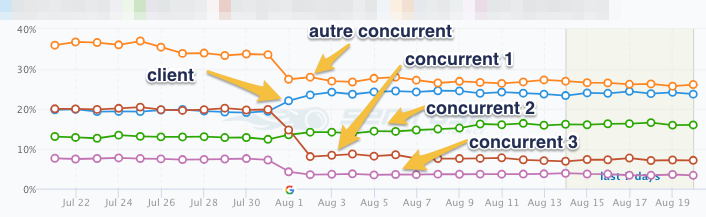

Avec l'update du 1er aout, il a gagné un peu :

Sans doute que ça n'impressionne pas, mais ses plus gros concurrents n'ont pas eu la même chance...

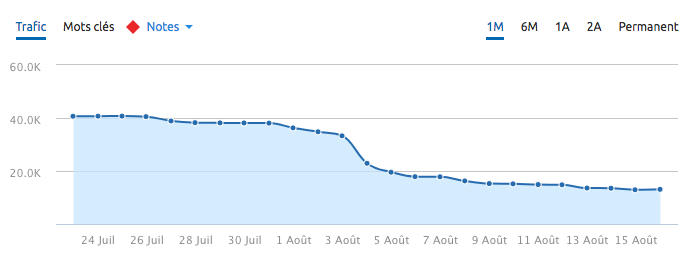

Voici son 1er concurrent le + important en termes business :

C'est resté à peu près stable pour son 2ème concurrent. Voici pour le 3ème concurrent le + important en termes business :

Voici le site du secteur qui fait (faisait) le plus de trafic, pas totalement concurrent en termes business, mais qui était bien établi depuis plus de 5 ans :

Voici une capture d'écran transmise par le client, représentant cette fois-ci la visibilité (sur près de 400 requêtes stratégiques). On voit bien que les changements de trafic sont liés à l'update de Google et que ce n'est pas conjoncturel :

Je reviens sur le client RM Tech...

Peut-être qu'il peut vous sembler obsédé par ses audits RM Tech, mais voici sa courbe sur 5 ans :

Le travail sur le long terme fonctionne donc vraiment bien pour lui, alors même qu'il est à 100% sur la typologie YMYL.

Conseils avec le nouvel algo de Google

Bon... Si vous lisez ceci c'est sans doute que votre site a fait partie des nombreux à chuter avec cet update.

J'ai encore du mal à comprendre toute la logique de Google (j'ai des contre-exemples encore inexpliqués). Cela dit, je pense avoir cerné en gros ce qu'il faut faire pour réussir en référencement, ou remonter la pente. L'avenir permettra de préciser les choses...

1 Faites un audit de votre site

Je sais, vous en avez sûrement déjà fait (ou fait faire) plein, mais si votre SEO n'est pas bon, c'est qu'il reste des choses à corriger.

Cet audit doit couvrir les éléments suivants :

- crawl complet du site

- repérage de tous les liens internes cassés ou passant par des redirections

- étude du maillage interne : ajoutez des liens pertinents vers les pages trop profondes ou vers les pages stratégiques manquant pourtant de liens. Pensez aussi à faire un maillage naturel, avec beaucoup de variété dans les textes cliquables. Améliorer le maillage interne est très souvent négligé et pourtant très efficace, surtout sur les sites d'au moins plusieurs centaines de pages.

- analyse du contenu principal des pages pour repérer celles qui manquent de texte

- adéquation entre titre / description et contenu principal de la page : il ne faut pas tromper ou décevoir l'internaute !

- étude des performances des pages : comprenez pourquoi certaines pages génèrent aussi peu (ou aucun) de trafic. Ne faites pas ça sur seulement 30 jours mais sur 1 an, c'est bien plus efficace (ma méthode complète est ici). Faites un gros nettoyage des pages sans intérêt.

👉 Si vous ne l'avez pas encore testé, essayez donc RM Tech, mon outil d'audit SEO adapté à tout ça (et plus...).

📌 Mettez en place toutes les recommandations liées à l'audit.

2 Relisez les consignes de Google aux Quality Raters

Pas simple, elles ne sont disponibles qu'en anglais (ici), je sais. Mais je considère vraiment qu'elles donnent plein d'indices sur ce que l'algo de Google cherche à identifier sur nos sites.

Au passage : juste avant l'update, les consignes ont pas mal changé. Je pense que ce n'est pas anodin alors lisez la discussion du forum WebRankInfo : les changements de juillet 2018 dans les consignes aux Quality Raters.

Si jamais vous traitez de sujets de santé, de sécurité, de finances ou de ecommerce de produits de valeur, faites spécialement attention : Google est vraiment très exigeant désormais dans ces cas-là. J'ai publié un dossier pour vous aider à comprendre l'impact SEO des sites YMYL (c'est comme ça que Google les appelle : Your Money Your Life).

📌 Appliquez tous les changements nécessaires suite à votre lecture des Search Quality Raters Guidelines (SQRG).

3 Analysez ensuite page par page

Si vous êtes à cette étape, c'est que vous avez travaillé sur l'ensemble du site et validé que tous les fondamentaux (voire plus) sont déjà en place. Sinon, n'espérez pas gagner avec les prochaines mises à jour de Google.

Il est temps désormais de vous pencher sur les pages qui ont le plus souffert avec cet update. Je ne parle pas de baisse de position sur une requête précise, mais de baisse du chiffre d'affaires généré par la page via le référencement naturel.

A vous d'avoir mis en place le tracking nécessaire pour mesurer tout ça (ecommerce, objectifs, etc.).

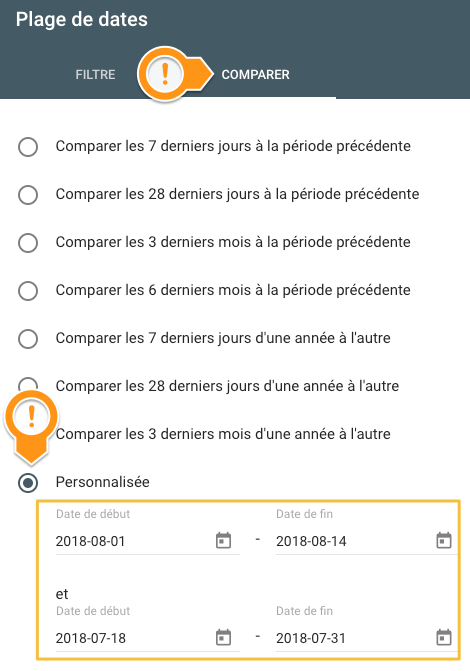

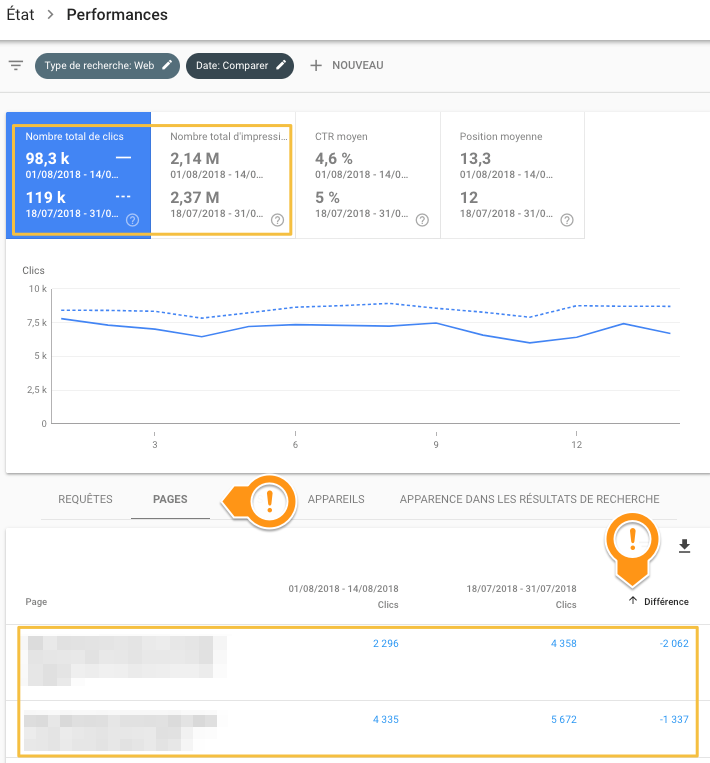

💡 Vous souhaitez commencer par une analyse facile ? Un moyen simple de repérer les plus grosses chutes est d'utiliser Google Search Console ("Etat > Performance" dans la nouvelle console).

Comparez par exemple 2 semaines avant et 2 semaines après le 1er août, en affichant les clics ou les impressions pour les pages (et non pas les requêtes) :

Triez par la colonne "différence", ordre croissant, vous aurez en 1er les pages qui ont le plus perdu :

Parfois, vous avez beau regarder votre page (qui a chuté), vous ne voyez pas ce qu'elle a de mal. Elle est peut-être bien en effet, mais seulement selon votre point de vue.

Comment savoir ce qui déplait aux internautes avec votre page ? 😟 Ou ce qui "déplait" à l'algo de Google ?

Réponse : examinez de près ce que font vos concurrents, c'est-à-dire ceux qui sont (désormais) en page 1 devant vous.

Apparemment, selon l'algo de Google, ces pages correspondent mieux à ce que cherche l'internaute. Vos concurrents ont sans doute mieux cerné que vous quelle est l'intention de l'internaute (pour cette page en tout cas). Pour certains éléments au moins, ils arrivent à mieux satisfaire l'internaute.

Il m'est déjà arrivé plusieurs fois de démasquer des atouts de concurrents en faisant un audit de leurs sites. Qu'est-ce qui vous empêche de le faire ? Lancez un audit RM Tech, en commençant par un audit RM Tech gratuit par exemple.

📌 C'est dans cette étape que l'expertise humaine est cruciale. Les outils sont indispensables pour repérer des détails dans une masse de données, ainsi que pour gagner du temps, mais l'humain reste la clé. A vous de savoir prendre du recul sur votre site et trouver les atouts de ceux qui sont devant vous. Parfois il ne s'agit plus de critères SEO classiques : ce sont plutôt les critères E-A-T qu'il faut travailler.

Et vous ?

Les commentaires sont disponibles pour vos questions, remarques ou retours d’expérience !

Crédits image d'illustration : Freepik par Flaticon, sous licence CC 3.0 BY

Bonjour à tous,

J'aimerais également vous apporter mon retour d'expérience quant à 3 sites dans le domaine de la rencontre et du coaching amoureux. Les 3 sites suivent le même profil de backlinks et à peu près la même ligne éditoriale.

Parmi ces 3 sites, 2 ont plongés radicalement après le 1er aout et 1 est resté inchangé. Après analyse, le facteur différentiant semble on-page dans mon cas. Les 2 sites ayant plongé sont basés sur un système ancien et le maillage interne est mal effectué.

Ma prochaine étape consiste à essayer de corriger la situation pour vérifier mon hypothèse. Si cela vous intéresse, je vous tiendrai au courant du résultat.

Bonne soirée,

Marc

Merci Marc, je veux bien savoir la suite !

L'un de mes sites (+les sites du même réseau) a été fortement pénalisé là où pour mes autres clients rien n'a bougé.

Pourtant, la qualité SEO du site en question n'est très satisfaisante surtout quand on compare avec les sites concurrents...

Bonjour,

Merci pour votre article d'excellente qualité ! Je n'avais pas pensé que les pages inactives pouvaient pénaliser tout le site.

Je me posais néanmoins une question : Que ce passe t'il dans le cas d'un forum de maladie de type doctissimo ?

Prenons l'exemple d'une discussion ayant 1000 pages de commentaires. Si cette discussion intéresse et se positionne on peut considérer que la première page est toujours active puisque c'est souvent le point d'entrée. Les dernières le sont également plus souvent que les autres.

Mais qu'en est-il des pages entre ?

L'utilisation des attribut rel=prev et rel=next permettent de " chainer " les pages d'une discussion pour indiquer à google qu'il s'agit de la même discussion.

Dans ces cas là, peut on considérer que tant que le sujet est un minimum visité, cela ne créera aucun problème de page inactif pour les centaines de pages plus visités ?

Le cas des forums (ou des contenus générés par les utilisateurs en général) est particulier. Généralement, on trouve un plus grand nombre de pages inactives (par exemple parce que les titres sont mal choisis).

Pour la pagination, en effet ça serait mieux de compter l'ensemble des pages regroupées afin de voir si le groupe génère des visites. Cela dit, c'est vraiment très rare de voir dans les SERP de Google des pages 2 et suivantes d'une discussion de forum.

Une discussion ayant 1000 pages de commentaires ? c'est vraiment pas du tout pratique pour l'utilisateur (et très inefficace pour le SEO)

je vois, donc en soit on peut considérer que l'on puisse être pénalisé pour ne pas désindexer les milliers de pages "inutiles" ?

Difficile à dire de façon catégorique, mais il est clair qu'un bon nettoyage semble faire le plus grand bien au référencement.

Merci pour votre avis.

De notre côté après analyses de tous les concurrents, l'update du 01 aout semble avoir pénalisé tous les sites de santé dont les informations proviennent d'utilisateur ( ex forum de santé ) pour privilégier les pages plus " trust ". C'est le cas principalement en France ( peux-être a cause du cadre juridique lier à la santé ? ) C'est d'ailleurs bien souvent des plateformes qui contiennent des milliers de page " inutiles " ce qui rejoins votre avis.

Selon nos analyses, il semblerait que ce soit wikipedia qui sorte grand gagnant de cette update, puisque ses impression aurait augmenté de 300% sur les occurrences lier à la santé. Les sites .gov ont également pu jouir de ce privilège.

Nous allons de notre côté effectuer une batterie de test complémentaires. Je vous tiendrais au courant si notre trafic augmente à la suite de l'élimination des pages inutiles pour valider votre intuition.

Kevin

Bonjour,

Je ne suis pas sur que l'utilisation de données issues de Semrush soit une bonne idée pour faire ce type d'analyse. Sur Semrush, on a un trafic très linéaire (par exemple le trafic le week-end est identique a celui de la semaine... ce n'est pas très réaliste).

Lorsque je compare les données Semrush et Google analytics, suivant les mois j'ai un écart allant de 2% à 43%. A partir de ce constat, je pense qu'il est préférable d'utiliser les données Google analytics.

Bonjour,

Je suis tout à fait d'accord avec vous, je pense que Semrush n'est largement pas aussi fiable que Google Analytics et c'est tout à fait logique. Par contre, je ne pense pas que tous les sites (surtout concurrents) donnent accès à leurs données GA sur simple demande, tandis que Semrush est accessible par tous.

Je pense que c'est pour cette raison qu'Olivier s'est basé sur Semrush qui facilite l'accès aux données des concurrents.

Au passage, je vous remercie pour cette étude très complète qui permet d'ouvrir les yeux sur les impacts des google update.

Bonne continuation !

J'ai déjà répondu et mis à jour mon article à ce propos.

En effet, SEMrush n'est pas si fiable que ça pour l'évaluation du trafic, mais n'ayant pas accès aux données de mesure de trafic des concurrents, je suis bien obligé.

Quand on complète par une analyse de visibilité et qu'elle confirme la tendance, il ne reste guère de doute pour moi.

Bonjour,

Vous montrez des mesures en trafic et non en positions dans les SERP. La chute de trafic n'est-elle pas en parti due à la saisonnalité du mois d'août et des vacances?

Aussi, les sites qui ont gagné du trafic ont travaillé leurs pages, et auraient donc gagné même sans cette MAJ Google. En clair il faut travailler ses pages pour gagner en SEO/trafic, avec ou sans MAJ Google.

J'ai mis à jour l'article avec des explications à ce sujet, ainsi qu'un graphique montrant l'évolution de la visibilité en plus du trafic.

Non, la chute du trafic des concurrents arrive d'un seul coup au 1er août, et le client (+ un de ses concurrents) n'a pas bougé ou légèrement progressé. Ce n'est donc pas lié à la saisonnalité.

Bonjour,

Retour d'expérience : l'utilisation de votre outil RM Tech m'a surtout permis de constater et surtout de prendre conscience de la masse noire des pages indexées sur Google. Je suis donc passé de 92000 pages en février 2018 à 8500 pages à ce jour. Et ce n'est pas fini, j'ai encore 7000 pages en cours d'analyse par Google qui devrait être désindexées.

J'ai décidé de désindexer ces pages qui n'avait pas lieu d'être : certaines (90%) sont des pages avec données (publiques) utilisateurs mais qui n'intéressent que très peu de personnes et pendant un laps de temps assez court (2 à 4 mois) et d'autres pages faisant parties intégrantes du site et ayant un intérêt en interne mais aucun intérêt en tant que "Landing page".

Cela à l'air de fonctionner, j'ai retrouvé la première page pour ma page principale sur LE mot clef principal (9ème position en février, puis 17ème (voir 3ème page de temps en temps) suite à màj GG d'avril, et de nouveau 9ème position depuis debut aout). Et cela reste stable depuis.

Pour mes autres landing page importantes (déjà en première page) j'ai gagné 2 positions sur le mot clef principal de ces pages et remontée en haut de page (1ere ou 2eme position) sur la longue traine.

Et enfin j'ai également travaillé un peu le maillage interne.

Ayant très peu de backlinck externe (hors réseaux sociaux où nous sommes assez actifs) en tout cas aucun provenant de "gros" site, je confirme que désormais, GG fait plus attention à la qualité (technique et UX) interne d'un site (et c'est tant mieux : fini la guerre des BL)

excellent ! merci du retour d'expérience

En complément mes notes RM TEch sont (depuis mes changements) :

Score SEO = 81,4

Score pages Actives = 91,2