En résumé :

- l'époque où Google indexait (presque) tout ce qu'on lui demandait est terminée

- en fait, Google ne veut même plus crawler toutes les pages (s'il ne crawle pas une nouvelle page, il ne risque pas de l'indexer...)

- la raison est le crawl prédictif : l'algo de Google évalue la probabilité qu'une page soit d'une qualité suffisante pour mériter d'être crawlée (et indexée)

- on ne connait pas les critères, mais Google se base sur la qualité globale des pages précédemment publiées sur le site

- l'indice QualityRisk (fourni dans mon outil RM Tech) permet une bonne estimation

- vous avez donc intérêt à optimiser vos pages afin de réduire leur indice QualityRisk

Petits rappels avant mes explications détaillées :

- en permanence, Google explore des pages, c'est ce qu'on appelle le crawl

- une fois la page crawlée, Google l'analyse et un algo évalue si elle mérite d'être indexée

- seules les pages indexées apparaissent dans les résultats de recherche (SERP)

- le classement (ranking) n'est donc que la dernière phase

Ce qui a tout changé dans le crawl de Google

Je vais prendre une image pour expliquer… 🏨

Imaginons une entreprise qui édite un guide des hôtels, très utilisé par les clients, donc incontournable pour les hôteliers. Elle envoie régulièrement ses "experts" vérifier la qualité des hôtels. Ces experts vont aussi bien tester des nouveaux hôtels que ceux déjà connus.

Tous ces tests coûtent cher, si bien que ce guide décide de réduire les tests. L'idée est de favoriser les bons hôtels et délaisser les moins bons…

Imaginons une chaîne d'hôtels (par exemple en franchise) qui n'est pas vraiment bien notée : trop de ses hôtels déçoivent. Le guide va moins souvent envoyer ses experts tester les hôtels de cette chaîne !

Si l'hôtel n'est même pas visité (testé), il est exclu sans avoir eu la chance de faire ses preuves !

- C'est frustrant si l'hôtel vient d'ouvrir : il est pénalisé par la réputation de la chaîne

- C'est horrible si l'hôtel a été racheté, alors que le nouveau propriétaire fait tout au top…

Vous l'avez déjà compris :

- L'entreprise qui édite ce guide qui fait la loi dans le marché, c'est Google

- La chaîne d'hôtels, c'est votre site. Chaque hôtel, c'est une page

- L'expert qui vient tester un hôtel, c'est Googlebot qui crawle une page puis l'évalue

Evidemment, le but principal du SEO c'est de réussir à être bien positionné. Le fameux ranking.

Avant ça, vous savez que vos pages doivent être indexées. Sans indexation, pas de ranking.

Mais si la page n'est même pas crawlée ?

pas de crawl ➡ pas d'indexation ➡ pas de ranking

(pas de chocolat non plus)

Si Google décide de ne pas venir crawler une page, toutes vos chances de réussite s'écroulent. Vous êtes dégoûté, comme l'hôtelier qui n'a même pas eu la chance de prouver sa qualité. Conclusion : Google instaure un délit de sale gueule !

Est-ce vrai tout ça ?

N'est-ce pas juste une histoire que j'invente ? 🎭

Si Google n'indexe pas mes pages, n'est-ce pas à cause de tous ses bugs ?

Désolé de vous décevoir : c'est bien vrai. Google a évolué…

Je l'ai identifié il y a bien longtemps, vers 2019 de mémoire.

En cherchant dans les déclarations publiques d'employés de Google, j'ai trouvé des réponses de Martin Splitt (de chez Google) à des questions de SEO sur YouTube.

Vers 20' sur cette vidéo, il déclare :

Je sais que nous utilisons le machine learning pour identifier ou prédire la qualité que nous obtiendrons d'un crawl. Il est intéressant d'essayer de prédire le niveau de qualité que nous pouvons obtenir d'un crawl spécifique avant même qu'il ne se produise.

Martin Splitt (de Google), le 11/11/2020

Cela permet à Google de planifier son crawl de manière plus intelligente.

Vous avez bien lu :

Google utilise l'IA pour évaluer à l'avance si ça vaut le coup de crawler une page

Plus récemment, Gary Illyes (analyste chez Google) a expliqué qu'en 2024, "sa mission est de trouver un moyen de crawler encore moins". Il a précisé :

La planification [du crawl] est devenue plus intelligente et nous nous concentrons davantage sur les URL qui ont le plus de chances de mériter d'être explorées.

Gary Illyes (de chez Google), 02/04/2024 (source)

Je vais vous expliquer qu'en creusant un peu, ce changement n'est pas une surprise. Si vous êtes pressé, vous pouvez sauter aux sections suivantes.

Google invente donc le crawl utile : on discute dans le forum de crawl prédictif.

Crawler le web devient très compliqué et même pour Google, ça coûte (trop) cher. Pour réduire le coût, Google veut identifier ce qui est prioritaire à crawler. Il ne veut plus crawler tous les sites, ou toutes les pages d'un site, ou trop souvent.

Revenons à cette idée de vouloir limiter le crawl. Ce changement est-il récent chez Google ?

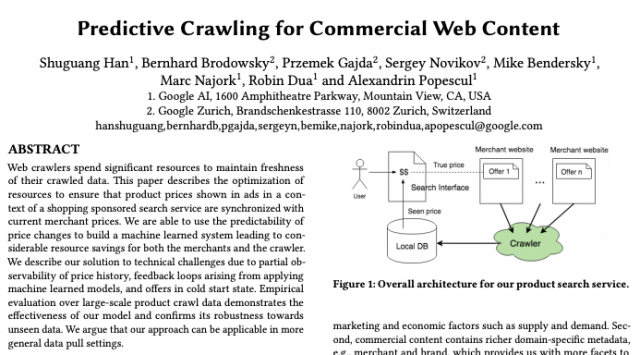

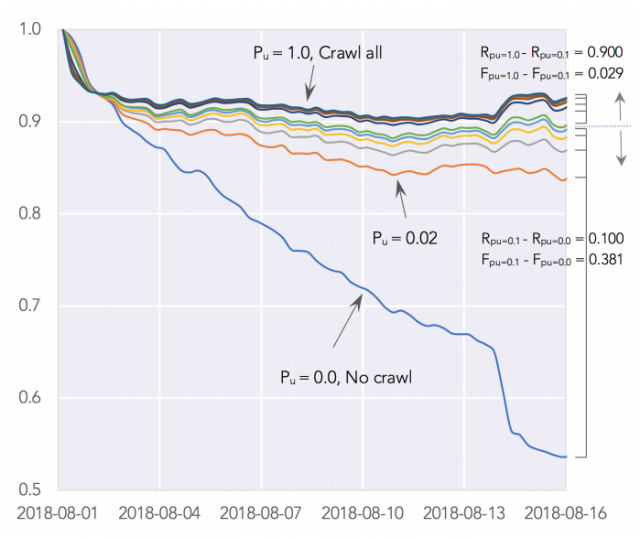

Dès 2019, des chercheurs chez Google ont publié un article détaillant des méthodes de crawl prédictif permettant d'économiser des ressources.

Je ne doute pas une seconde que vous irez lire et analyser cet article (source). Comme je suis très sympa, je vous fais un court résumé...

Cet article détaille un système qui prédit les changements de prix sur des sites ecommerce. Il permet d'éviter des crawls inutiles. Les auteurs expliquaient en 2019 pouvoir l'adapter à d'autres crawls plus génériques.

On va s'arrêter là dans la recherche et rentrer dans du concret...

Comment évaluer si Google apprécie votre site et va l'indexer ?

Les problèmes "Explorée non indexée" et "Détectée non indexée"

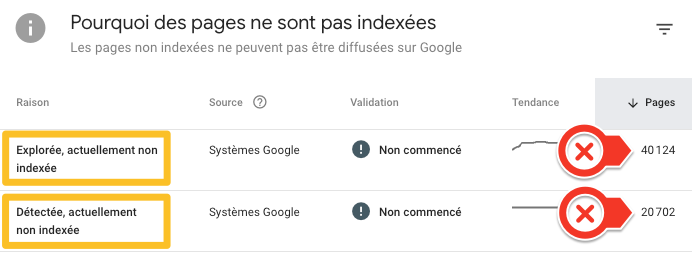

Vous avez sans doute déjà remarqué que dans Search Console, Google indique parfois comme raison de non-indexation "Explorée non indexée" ou bien "Détectée non indexée".

Erreur "Détectée actuellement non indexée"

Google indique "Détectée non indexée" quand l'URL n'a pas encore été crawlée, mais qu'elle est connue. Google n'a pas encore été la crawler...

- si l'URL est récente ce n'est pas préoccupant

- mais si elle est ancienne, alors ça signifie sans doute que Google a "prédit" que ça ne vaut pas le coup d'aller la crawler

Erreur "Explorée actuellement non indexée"

Google indique "Explorée non indexée" quand l'URL a été crawlée, mais qu'elle n'est pas (encore) indexée. Souvent, la page est pourtant techniquement indexable (rien ne s'oppose à son indexation).

- si l'URL est récente ce n'est pas préoccupant

- mais si elle est ancienne, alors ça signifie sans doute que Google a "décidé" que ça ne vaut pas le coup de l'indexer, ce qui n'est pas vraiment bon signe...

Comment chiffrer si le problème est important pour vous

Voici une petite astuce que je vous propose :

- allez dans le compte Google Search Console pour votre site

- dans la partie "Indexation", cliquez sur "Pages"

- dans le filtre en haut, remplacez "Toutes les pages connues" par "Toutes les pages envoyées" (il faut avoir déclaré votre sitemap pour l'avoir)

- notez le nombre dans le carré vert "Dans l'index" (attention, le "k" signifie milliers donc 2,3k signifie 2300). On va le nommer "INDEXEES"

- plus bas, dans "Pourquoi des pages ne sont pas indexées", notez le nombre de pages ayant l'erreur "Explorée, actuellement non indexée" (nommé EXPLOREES), ainsi que le nombre de pages ayant l'erreur "Détectée, actuellement non indexée" (nommé DETECTEES)

- calculez le pourcentage d'erreur par la formule ci-dessous :

erreur = (EXPLOREES + DETECTEES) / (EXPLOREES + DETECTEES + INDEXEES)

Plus ce pourcentage est élevé, plus vous avez de problèmes, et plus ça va être compliqué de faire indexer vos pages. Y compris les bonnes pages !

Remarque : pour cette astuce, il faut créer et déclarer votre sitemap dans search console, et bien entendu avoir créé votre compte search console.

L'estimation avec QualityRisk

QualityRisk est un indice calculé pour chaque page indexable, par mon outil RM Tech d'audit SEO. Il indique à quel point la page cumule des problèmes qui freinent le référencement de la page. C'est une valeur entre 0 (aucun problème constaté) à 100 (maximum).

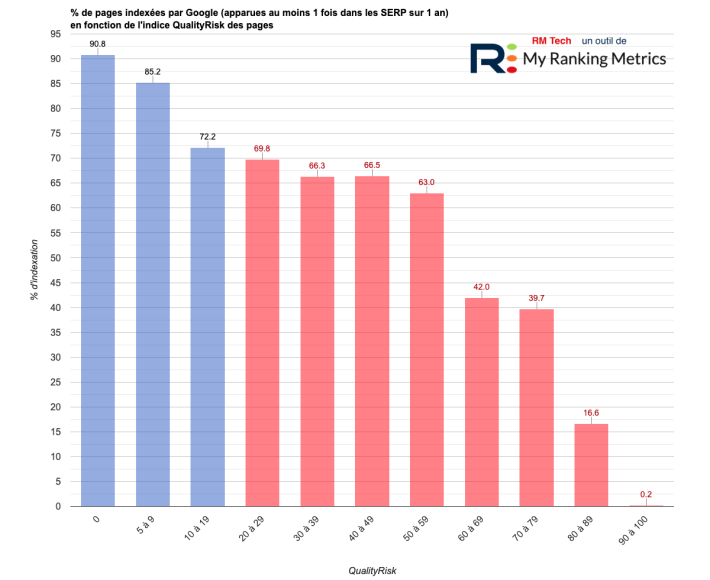

J'ai étudié sur des centaines de sites si on pouvait trouver une corrélation entre QualityRisk et l'indexation des pages. En gros, est-ce que c'est fréquent que Google indexe une page, en fonction de son indice QualityRisk.

En fait, au lieu de vérifier si la page est indexée, j'ai été un cran plus loin. J'ai cherché si la page est apparue au moins 1 fois dans les résultats de Google sur les 12 derniers mois. Si c'est le cas, c'est que Google l'a indexée.

Résultat :

La chance qu’une page à QualityRisk 0 soit indexée par Google est 45% plus importante que pour celles à QualityRisk > 20

Étude MyRankingMetrics sur QualityRisk et l'indexation Google

Conclusion : vous devriez vérifier si votre site a plein de pages à faible QualityRisk, ou à fort QualityRisk... J'ai un tuto qui explique comment réduire QualityRisk sur votre site.

Quelles solutions pour faire crawler et indexer vos pages ?

Un tuto premium avec explications avancées

Avec Fabien Facériès (mon associé chez My Ranking Metrics), on a fait de la R&D pendant quelques semaines sur ce sujet. On a abouti à une méthode qui intéressera ceux qui sont concernés par ces problèmes.

On a tout rassemblé dans un tuto vidéo premium :

- des explications plus complètes sur les changements de Google

- des moyens d'identifier de façon plus fine si un site est concerné, et mieux comprendre quelles pages (et donc deviner certaines causes ainsi que pour aider à prioriser les actions)

- la solution à court terme, pour 1 URL ou quelques unes

- la solution à moyen/long terme pour de multiples pages

- 3 bonus : ma méthode pour gagner un temps fou dans l'analyse des pages à problème, pour travailler par types de pages et pour se concentrer sur les pages récentes

Vous connaissez mon sérieux en SEO, ce tuto va sûrement vous plaire 🤩

Autres conseils

En plus de ce tuto vidéo, ne ratez pas mes autres ressources :

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Le but avoué de ces système gratuits d'indexation Google , étant de créer au final des clients annonceurs

Quand google se plante , les gens changent de système et reçoivent des cadeaux important chez les autres , tel Bing et ses 75€ d'offerts pour annoncer ...

Pour ma part je n'utilise plus rien de Google et mis des restrictions sur mon porte monnaye et restrictions dans robots.txt

Sans Google, il ne doit plus rester beaucoup de trafic alors !

pas de crawl ➡ pas d'indexation ➡ pas de ranking

chez Le journal abrasif Google Crawl beaucoup et déclasse à fond ! Sérieux, les nouvelles pages articles sont indexées en quelques minutes et les anciennes pages sont déclassées.

J'ai expliqué qu'une page non crawlée ne peut pas être indexée.

ça ne signifie pas qu'une page crawlée est forcément indexée.

de la même manière qu'une page indexée n'est pas forcément bien positionnée.

Merci Olivier, je suis un peu perdu… C'est plus clair ainsi.

En regardant "super size me 2" il y a quelques jours, je me suis rendu-compte que nous sommes nous aussi des petits producteurs qui dépendent d'un grand groupe.

Il y a des fermiers qui produisent des poulets et il y a nous qui produisons du contenu pour gagner notre vie sur internet.

Je suis frappée dans les deux cas de voir la détresse des "petits producteurs" qui pleurent au sens propre du terme quand ils se rendent compte qu'une grosse compagnie les a déclassés pour des raisons inexplicables.

C'est toujours pareil: "vous n'avez pas atteint les objectifs" ou "vous n'avez pas suivit correctement nos guidelines pourtant simples" alors on vous déclasse. Pourquoi? on ne sait pas. A-t-on un interlocuteur à qui demander des explications? Non.

Que nous travaillions dans la production de poulets, de sites internet c'est pareil: se sont de grosses sociétés américaines qui imposent leur lois et avec une façon de penser elle aussi très américaine.

La qualité? On s'en fiche complètement. Il faut qu'un site soit rentable, facile à crawler, il faut qu'un poulet grossisse en 6 semaines, le reste peu importe.

Le 4 mai, j'ai perdu une grosse partie de mes visiteur. Marre de devoir toujours tout refaire, je n'ai rien fait du tout. Update de décembre, remontée dans les serps. La qualité n'a donc, pour moi, plus rien de pertinent en SEO.

Mais surtout j'en ai marre de voir des webmasters malheureux parcequ'ils aiment leur métier...

On trouve toujours des contre-exemples, mais moi je vois aussi beaucoup de monde qui "pleure" ou ne sait pas quoi faire, alors que le site est bourré de problèmes techniques ou de contenus de qualité clairement insuffisante...

et donc @marina.. c'est le moment de passer au SEM ( mais pas que Fbook Ads et GG ads..) là au moins tu es sûre de recevoir du traffic..

Mais c'est vrai qu'on s'éloigne du SEO...

Bonjour, super article encore une fois, merci !

Assez d'accord avec Visaboy, on voit bien que la taille de l'entreprise et la stratégie qui en découle s'éloigne de + en + de l'utilisateur non rentable pour lui... Mais pour l'heure oui, pas le choix que de suivre les recommandations.

Nous sommes cependant actuellement en train de tester des outils français qui même s'ils ne se révèlent pas du tout à la hauteur pour le moment, pourraient être une première alternative à ce monopole aberrant du big G... Qwant, mailo, olvid, OVH... Avez-vous prévu d'écrire à leur sujet prochainement ?

Je ne suis pas d'accord, ce changement n'est pas diamétralement opposé à la satisfaction utilisateur. Les pages que Google ne veut plus crawler sont généralement de faible qualité, c'est ce que je constate quand j'étudie plein de sites.

Qwant comme alternative à Google, je n'y crois malheureusement pas.

Mais on ne sait toujours pas pourquoi Google ne pénalise pas encore les sites de grosse audience qui mettent des pop-ups dans tous les sens et fournissent des publicités douteuses...

Franchement, le matin, lorsque je lis sur la tablette les news dans Google Discover, ça devient plus que pénible comme expérience. Et j'ai oublié de parler aussi des sites qui détournent le retour arrière afin de rester plus longtemps. ça devrait être pénaliser ce type de procédés.

c'est surtout des gros cxxxx chez google, car à force de faire sans arrêt ce genre d'évolution (car maintenant qu'il a assez de page, il vire tout le monde) les gens vont commencés à en avoir marre et pire, se barrer définitivement du net, c'est ça qu'il lui pend au nez... sur 10 potes webmaster / réf, j'en ai plus que 3 sur skype depuis 3 ans... à force de jouer avec le feu et de trop tirer sur la corde, il va se brûler, ca c'est une certitude mathématique :-). Car la plupart des changements ne sont pas un but d'amélioration (j'ai dis la plupart, pas tous...) C'est uniquement dans un but commercial et financier, la preuve encore une fois de plus.... Et sois dit en passant pour ceux qui sont sur Youtube aussi il va y avoir de grosses modifs en 2021... donc, je dis attention à Google, car a force de trop tiré sur la corde ça va péter...

Bien entendu que c'est pour gagner de l'argent. C'est horrible à dire, surtout concernant une entreprise qui en gagne autant.

Maintenant, à notre niveau, je pense qu'il faut tenir compte de ces évolutions ou alors accepter de voir ses problèmes SEO augmenter...