Dans son blog -http://www.analytics.fr, Alan (le blogger) nous parle de sa dernière doscussion "SEO" avec David Degrelle (1ere posision) lors du dernier SES.

David Degrelle a une hypothèse intéréssant sur l'utilisation d'Analytics,

et le ranking.

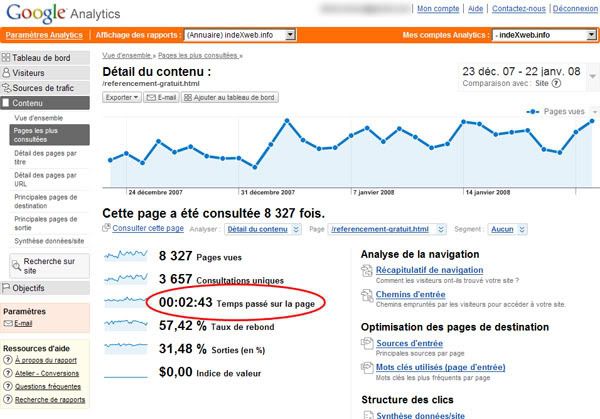

Il part de l'hypothèse que Google Analytics fournit officiellement a Google le tx de rebonds des sites analysés avec cet outils. Hors comme chacun le sait le tx de rebond à de l'importance sur le ranking. Partant de cette hypothèse, l'injection d'une ligne de code visant à tromper analytics et par la-même réduire le tx de rebonds calculé par GGAnal, permettrait d'optimiser ses positions.

Qu'en pensez-vous ?

Source : -http://www.analytics.fr/index.php/2008/01/20/ameliorer-son-referencement-grace-a-google-analytics-et-une-ligne-de-code/

NB: Tehnique pas vraiment SEO White HAT ;-)

David Degrelle a une hypothèse intéréssant sur l'utilisation d'Analytics,

et le ranking.

Il part de l'hypothèse que Google Analytics fournit officiellement a Google le tx de rebonds des sites analysés avec cet outils. Hors comme chacun le sait le tx de rebond à de l'importance sur le ranking. Partant de cette hypothèse, l'injection d'une ligne de code visant à tromper analytics et par la-même réduire le tx de rebonds calculé par GGAnal, permettrait d'optimiser ses positions.

Qu'en pensez-vous ?

Source : -http://www.analytics.fr/index.php/2008/01/20/ameliorer-son-referencement-grace-a-google-analytics-et-une-ligne-de-code/

NB: Tehnique pas vraiment SEO White HAT ;-)