Cet article fait partie des archives de WebRankInfo : certes, il est ancien, mais complet et détaillé pour son époque. Si vous cherchez d'autres informations, faites une recherche sur le site ou participez au forum. Contactez-moi si besoin.

La bonne réponse aujourd'hui

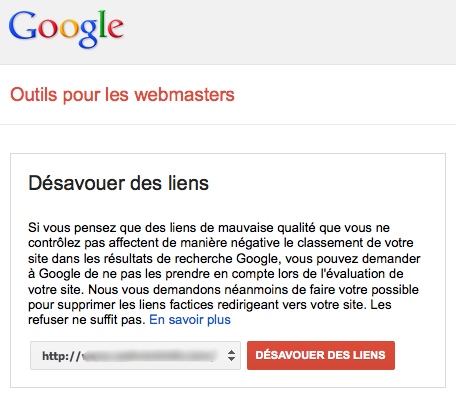

Désormais, le désaveu de liens n'est utile que si vous avez une pénalité manuelle (ou éventuellement une grosse attaque violente de negative SEO, ou plein de liens qui semblent créés pour booster votre SEO).

Si vous avez un doute, posez la question dans le forum ou passez par du consulting SEO avec moi.

La réponse de Matt Cutts en 2014

C'est très simple, la réponse est oui, c'est une bonne chose selon lui de désavouer les liens de mauvaise qualité que vous n'avez pas réussi à faire supprimer (ou modifier).

Sa réponse ne m'étonne absolument pas, mais je continue de penser que Google se fiche pas mal de nous dans cette histoire. Si son algorithme sait repérer les liens artificiels (c'est-à-dire qui ne respectent pas les consignes Google), pourquoi ne leur affecte-t-il pas tout simplement un poids de ZERO ? Ces liens n'aideraient absolument pas au référencement du site qui les reçoit, si bien que les gens comprendraient au fur et à mesure que cela ne sert à rien :

- d'aller s'inscrire en masse dans des annuaires (le comble c'est toutes les annonces AdWords bénies par Google qui vendent ce type de "prestation")

- d'aller spammer les commentaires des blogs

- d'aller spammer les forums dans les posts et/ou dans les signatures

- de pratiquer du référencement "négatif" comme disent les anglosaxons (Negative SEO ou NSEO) à base de liens toxiques

En fait, si Google n'a pas choisi cette option, c'est sans doute qu'ils ne peuvent pas détecter tous les liens spammy. Si ceux qu'il repère comme artificiels n'étaient pas toxiques (pondération négative), alors les spammeurs y iraient gaiement, n'ayant aucun risque. Par contre, le choix actuel de Google renforce le Negative SEO...

D'ailleurs, voilà une question que j'aimerais poser à Matt Cutts : l'outil de désaveu est-il la seule solution proposée par Google à ceux qui sont victimes de Negative SEO par le biais de liens toxiques ?

J'ai du mal à comprendre que Google exige de tout webmaster victime d'un concurrent sans éthique qu'il surveille en permanence ses backlinks, étudie chacun des nouveaux qu'il reçoit, et en cas de lien toxique cherche à contacter le webmaster (qui s'est fait spammer) pour qu'il retire le lien ou au final utilise l'outil de désaveu. Est-ce vraiment faisable quand chaque semaine arrivent des milliers de nouveaux liens toxiques ?

Car en gros, Google ne fait ni plus ni moins que demander aux webmasters de régler le problème du spam à la place de Google. Et au passage, l'équipe antispam de Matt Cutts récolte quantité d'informations gratuitement : n'est-ce pas précieux d'avoir la liste des sites les plus souvent dénoncés par l'ensemble des utilisateurs de l'outil de désaveu de liens ?

Maintenant, avec la toute puissance de Google et les risques liés à une pénalité algorithmique type Pingouin, je pense que vous ne pouvez pas vous passer d'une telle surveillance. C'est en tout cas ce que je fais pour mes clients. Egalement, je préfère clarifier car un commentaire m'a montré que ce n'était pas suffisamment le cas : oui j'utilise l'outil de désaveu, bien sûr ! Mais je considère qu'on ne devrait pas avoir à l'utiliser, en tout cas dans le cas du negative SEO.

On en parle régulièrement dans le forum, par exemple cette discussion : faut-il désavouer ses backlinks en cas de NSEO ?

Qu'en pensez-vous ? On en discute dans le forum.

Voici la vidéo :

Il l'a confirmé en mars 2014 sur Twitter suite à une conférence SMX :

@sugarrae only thing I'd add is if it's 1-2 links, may not be a big deal. The more it gets close to "lots," the more worthwhile it may be.

— Matt Cutts (@mattcutts) 13 Mars 2014

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Tu continues de penser que Google se fiche pas mal de nous dans cette histoire. Si son algorithme sait repérer les liens artificiels, pourquoi ne leur affecte-t-il pas tout simplement un poids de ZERO ?

Je fait du BH depuis quelques années, Si il font ça, je spam comme un fou et c'est Google qui fait le travail pour moi en sélectionnant les bons et mauvais liens... Donc grosse augmentation du spam

@babas : c'est déjà ce que j'ai écrit dans mon article ;-)

Cette article tombe à pic ! Je suis en plein dedans en ce moment...

Pour l'un de mes sites qui a été touché mais sans être pénalisé manuellement j'ai désavoué un bon nombre de liens il y a environ 15 jours.

Je touche du bois mais depuis hier, je vois tranquillement revenir mon site sur des mots clés sur lesquels il était très bien positionné avant "pénalité" et totalement invisible depuis...

Là il commence à réapparaitre. Il est encore "loin" des premières pages de résultat mais au moins il est réapparu !

Je n'ai rien fait d'autre sur le site depuis et le désaveu ne peut pas être une coïncidence. Enfin je pense.

Je rajouterai que les liens désavoués étaient principalement des inscriptions dans des annuaires avec comme ancre de liens les mots clés sur lesquels le site commence à réapparaitre...

Merci pour la réponse Olivier. Me voilà rassuré...

J'espère que la prochaine MAJ arrivera rapidement.

La premier chose a jouter c'est les liens de votre forum monsieur Olivier, je poste un message je trouve accoté de mon avatar, une icone, W, qui pointe vers mon site, j'aime pas ça, pourquoi tu le met pas en nofollow ?.

a vous bien.

@Mansour : ce type de lien ne pose pas de pb vu son anchor text, mais s'il vous gêne tant que ça, pourquoi le laisser dans votre profil ?

J'ai une question: En cas de pénalité non manuelle, faut-il attendre la prochaine mise à jour de penguin pour espérer une sortie de pénalité?

Je me suis servi de l'outil de désaveu en décembre et je n'ai pas vu d'évolution dans un sens ou dans l'autre...

oui reglisse, Matt Cutts vient de le reconfirmer, il faut attendre la prochaine mise à jour...

J'ai utilisé cette méthode depuis le mois d'octobre 2013, mais je n'ai rien remarqué, je vois toujours les mêmes liens restent sur webmaster tools.

@Amina : c'est normal, Google a confirmé que les liens désavoués restent listés dans Google Webmaster Tools

@olivier : je n'avais pas vu que tu avais répondu.

Pour information, j'ai cravaché pour produire du contenu frais avant le premier, et j'ai finis au bout de 2 mois par récupérer ma première place. Depuis c'est de nouveau bien campé en première place. Donc au final, pas trop d'impact (même si passé de la première à la seconde place fait perdre énormement de visiteurs, juste divisé par 3 ...)

Bien joué Steve M.

Tu as détruit le positionnement du site d'un concurrent de ton client si j'ai bien compris, juste pour voir comme ça !

Joli sens de l'éthique pour un professionnel.

Pas la peine de critiquer Google avec ce genre de comportement...

Ça devait arriver, j'ai eu le droit à mon premier coup de Negative SEO en 9 ans de société sur le net ... L'impact n'est pas énorme, je perd 1 place de temps en temps sur un mot clé très précis sur lequel je suis premier depuis lonnnngtemps.

Spam classique sur des blogs de langue exotique (enfin que je ne connais pas en tout cas :))

@maloc : alors t'as fait quoi, un désaveu ? tu t'en es rendu compte comment ? bonne chance pour la suite...

Par prévention j'ai fait le tour de tous mes liens entrants (+ de 750), une 50ène de site de mauvaises qualité (annuaires à l'abandon, site suspect,...)

Mis à part ça il y a des sites pour lesquels je n'arrive pas à me décider de supprimer :

- Site en langue japonaise ou russe

- Site n'étant plus accessible

- Domaine mis sur un site du genre sedo parking

- Annuaire avec ancre trop optimisé

- Le site picsearch qui revient avec des extensions différents.

ça serait quoi votre conseil ?

Merci.

Ca fait un bon bout de temps que je suis WRI, et même étant professionnel du SEO, et je te remercie pour tous ces articles et ce temps passé pour nous.

Pour réagir à cet article, je suis entièrement d'accord avec toi Olivier, et en même temps outré par cette politique Google.

Je m'explique, j'ai fais un test il y'a 3 semaines de Negative SEO sur un domaine qui était ranké, et concurrent à l'un de mes clients, pour en avoir le coeur net.

J'ai passé en tout et pour tout 1H à scraper, et à paramétrer 2 logiciels très connus dont je tairai les noms ici, et spécialisés dans le commentaire en masse.

Et le résultat est sans appel, au bout de 2 semaines, le site concurrent à chuté de façon monumentale dans les SERPS !

Alors quoi ?? On peut faire chuter n'importe quel site aussi simplement aujourd'hui ? On peut nuire à n'importe quel site qui émerge tout juste ? Bien entendu je ne parle pas de sites de masse ou volumineux tel que WRI, qui serait très dur à descendre, mais des "moyens" et "petits" sites.

Je suis largué, vraiment, je ne comprend pas comment Google peut se permettre d'attribuer une note négative aux liens de mauvaise qualité, au lieu de le négliger tout simplement.

comme tu l'as si bien dis, les gens se rendraient compte à un moment qu'ils ne servent à rien.

sauf que, soyons clair, installé un WordPress sur un hebergement lambda, laissez le ouvert aux commentaires pendant 2 semaines, revenez, et admirez les milliers de commentaires venant de toute la planète... Je crois bien, comme toi, que Google ne peut pas les trouver réellement, ou en tout cas en partie, sinon les BH et autres Ref ne perdraient plus de temps à spammer les WP, blogEngine et autres.

Donc entièrement d'accord avec cet article qui me donne envie d'aller m'enterrer dans une grotte ^^

A bientot.

Steve M.

Je ne comprends pas que beaucoup n'aient pas encore compris que cet outil ne sert qu'à donnerà Google des indications qu'il n'a pas et qu'il va dégager des désaveux reçus, par le jeu des recoupements et des grands nombres. A la seule et unique exception du cas de Negative SEO (lequel ne passe généralement pas inaperçu). Point final!

Et que ceux qui se servent de ce désaveu dans les autres cas commencent par définir ce qu'est un lien de qualité. C'est facile de citer des exemples simples de liens factices. Mais dans énormément de cas, on peut discuter.

Prenez l'exemple du lien sur la page d'accueil de Google vers Apple le jour du décès de Steve Jobs. Lien considéré comme le summum (car seul lien sur page PR 10 à trafic gigantesque). Or c'était un lien ultra éphémère, non pertinent thématiquement, basé sur un PR super élevé et sur rien d'autre, avec quasi tous les attributs d'un lien acheté (lien inusuel sur la page d'accueil, différence de langues pour les versions non anglaises de Google,...). Alors si vous êtes chez Apple, vous le désavouez ?

Ok l'exemple précité est tiré par les cheveux . En voici un autre: voyez les pages échanges de liens annuaires d'un site français, bien connu, de locations de vacances, filiale Google. Ce sont des annuaires plutôt de seconde ou troisième qualité (je suis encore gentil) et même des morts. Est-ce que cela empêche ce site de truster les premières places dans les SERPs ?

Ils doivent surement partir du principe que le NSEO est beaucoup plus rare que les spammeurs. Ce qui n'est pas faux, mais malheureusement ça peut coûter très très cher aux victimes de Negative SEO. espérons une amélioration de leurs algo et qu'ils seront en mesure de faire la différence entre du spam et du Nseo (c'est pas gagné).

@Olivier, merci pour ta réponse plus haut. Si je comprends bien pour le moment tu n'as encore jamais eu vent de sites pénalisés manuellement "après" avoir utilisé l'outil de désaveu?

Pourquoi ne donne t'il pas une valeur de zero à un lien entrant qu'il juge spammy ?

Peut être parce que ça rendrait la tache un peu simpliste non? On spamme comme des porcs, v que de toute façon, on ne peut pas être dévaluer.

Non je ne pense pas que ce soit la solution.

En effet Xavier, j'ai d'ailleurs complété mon article à ce sujet. Matt Cutts a choisi l'option qui autorise le Negative SEO mais qui renforce la guerre avec les spammeurs.

Olivier, tu as répondu toi même à la question que tu te poses, du moins en partie : en remontant des sites/liens en désaveux, on participe au "machine learning" et à enrichir l'algorithme du filtre pingouin (entre autres). N'oublions pas non plus que Google considère ces remontées comme de simples suggestions.

De même ne perdons pas de vue une chose : quand Google nous propose un service dans notre intérêt, en amont c'est avant tout pour le sien.

Il existe en effet des sites qui n'ont rien à se reprocher dans les faits et qui reçoivent pourtant de tels messages par les GWT, ma question est :

Quelqu'un a-t-il le numéro de SIRET de GG en France pour que les référenceurs envoient leur factures à Google. Les référenceurs font le boulot sur demande explicite de Google, non ?

@Christian : je ne parle pas des cas où Google inflige une pénalité manuelle, car bien qu'ayant audité ou étudié un grand nombre de tels cas, je n'ai encore jamais trouvé parmi eux un site qui n'avait effectivement rien à se reprocher.

Ohhhh sentirais-je comme un début de retournement d’opinion d'Olivier sur ce fabuleux, merveilleux et indispensable outil ?

Non parce que c'est marrant le nombre de point commun que l'on retrouve avec un article que j'avais écrit...

Tu me répondra que ton article parle du désaveux de lien sans pénalité préalable...

Oui, ok, mais c'est un bon début à une vrai prise de conscience sur cet outils malfaisant.

@Koxin-l : tu as mal compris le sens de mon article, d'ailleurs je l'ai complété rien que pour toi, pour préciser qu'au contraire de ce que tu penses, j'utilise l'outil de je conseille de l'utiliser.

100% d'accord avec le fait que ces liens devraient se voir attribuer un poids de zéro. Cela serait nettement plus simple -et peut-être même plus efficace- que de tout vérifier soi-même.

Par contre, en quoi la liste des sites les plus dénoncés pourrait être utile à Google ? Puisqu'il peut détecter les sites spammeurs, il peut établir lui-même ce genre de liste, alors en quoi la dénonciation lui apporterait plus d'infos ?

@Edward : justement, Google ne sait pas repérer tous les sites spammeurs ou les liens spam, donc la base de données associée à l'outil de désaveu est certainement exploitée par l'algo de Google.

Lorsqu'on n'a pas subit de pénalité manuelle (mais juste algorithmique), n'y a t-il pas un risque en utilisant l'outil de désaveux d'être repéré par google et d'être contrôlé, et par conséquent de subir une pénalité manuelle si on a encore pas mal de liens que google pourrait considérer comme "factices" et qui ne sont pas encore désavoués?

Pour résumer : En utilisant l'outil de désaveux ne va t-on pas attirer l'attention sur son site?

Le côté préventif ok, mais est-ce que ça risque pas de jouer des tours?

Certains ont-il déjà subit une pénalité manuelle après avoir utilisé l'outil de désaveux?

@Noren : je crois qu'il sera dur de prouver un lien de cause à effet. Les paranos vont éviter d'utiliser le désaveu pour cette raison, les autres vont l'utiliser à titre de prévention. Je fais plutôt partie des seconds.

"pourquoi ne leur affecte-t-il pas tout simplement un poids de ZERO ?"

Tout simplement parce qu'ils ne savent pas les détecter tous, des concurrents hyper crados j'en ai encore à la pelle qui sont là et bien là malgré les divers penguin (ils ont perdus la moitier de leur centaine de sites, mais l'autre centaine est toujours en place).

Donc le fait de juste ne pas prendre en compte les liens spam, fait que tu pourrais spammer comme un bourrin, en espérant que 10% des liens spam soient pris en compte, et les 90% de bourrins ne seraient pas compter, mais après ? Ce n'est pas comme si il était impossible d'automatiser l'obtention de ses liens.

Le fait de sanctionner évite ce problème tant qu'ils ne seront pas détecter à 100%, mais c'est pour ainsi dire impossible ... Evidemment, le défaut c'est qu'il faut suivre son référencement au quotidien.

Il y a moyen de voir d'une manière ou d'une autre si un lien a été désavouer par un concurrent ? (je suis très étonné du leader dans mon domaine qui a reçu des centaines de liens hyper crados en 3 jours, [mode sadique]en soit ça pourrait être positif pour moi[/mode sadique]). Je pense que non, mais sait-on jamais.

@maloc : tu as raison je pense, d'ailleurs c'est comparable à Panda qui peut pénaliser l'ensemble d'un site si une partie est de trop mauvaise qualité. On ne peut plus rajouter à un site une partie bien pourrie en se disant "au mieux ça m'apporte quelques visites, au pire aucune mais sans dégrader le reste"...

Mais alors, est-on condamné à repérer tous les liens crados faits par des concurrents et les ajouter à la liste des sites désavoués ?

L'outil de désaveu serait utile s'il était traité rapidement par Google le mammouth. Ca fait 2 mois que j'ai soumis, je vois toujours les liens en question dans GWT...

Il ne me semble pas que Google ait promis que les liens désavoués disparaissent de GWT...