Mettre à jour une page permet de lui redonner un boost SEO. Voici les meilleures techniques pour actualiser et optimiser vos contenus, que j'applique moi-même.

Découvrez les méthodes d’optimisation du référencement naturel de WebRankInfo.

Mettre à jour une page permet de lui redonner un boost SEO. Voici les meilleures techniques pour actualiser et optimiser vos contenus, que j'applique moi-même.

Guide de la pagination pour le SEO (+ impact sur maillage interne)

La pagination web est très présente mais rarement bien faite. Découvrez comment la faire de façon optimale pour le SEO et les utilisateurs. Voyez aussi pourquoi il faut éviter la pagination et quoi faire à la place.

Meilleures pratiques pour gérer un site en préprod pour le SEO

La préproduction est une étape essentielle dans la gestion d’un site (refonte, migration, tests). Voici mes conseils pour bien organiser et gérer un site en préprod, bâtir une bonne stratégie SEO tout en évitant les erreurs courantes.

Les 12 types de balises meta et leur impact SEO (référencement)

Est-ce que Google tient compte de toutes les balises meta ? C'est sans doute un classique mais cette fois la réponse vient de Google directement... L'occasion de revenir sur chaque balise pour préciser son intérêt pour le référencement. Voici donc un tuto balises meta sous forme de liste complète de ces "meta tags" et de leur impact sur le référencement.

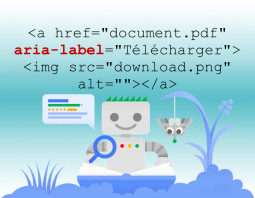

Qu'est-ce que l'attribut aria-label ? Est-ce une bonne idée de l'utiliser ? Google en tient-il compte ? Réponses dans ce dossier...

Mettre à jour vos contenus est indispensable en SEO (et pour fidéliser vos utilisateurs). Je vais vous expliquer comment trouver les pages prioritaires, celles pour lesquelles ça serait le plus rentable de les actualiser.

Vous savez à quel point c'est majeur de mettre à jour vos contenus pour réussir en SEO. Mais c'est crucial aussi pour satisfaire vos utilisateurs, améliorer votre image et même économiser de l'argent ! Je vous explique tout ça dans ce dossier.

Désormais, votre site DOIT être en HTTPS : pour la sécurité, pour inciter à la confiance, et pour l'intérêt SEO. Ce guide gratuit détaille toutes les étapes à suivre pour cette migration.

Que faut-il savoir au sujet de l'optimisation des URL pour le référencement ? Cet article liste tous les éléments à connaître avec plein de conseils issus de 20 ans d'expérience en SEO...

Les balises de titres (h1, h2, h3...h6) servent à structurer l'information dans une page web. Comment bien les utiliser pour améliorer le référencement naturel en plus de la lisibilité de la page ? Voici le guide ultime !

Optimiser le référencement de son site dans une zone géographique précise

Voici les solutions pour être bien positionné dans Google pour un pays donné (depuis l'abandon du ciblage géographique dans Search Console).

Tout pour la redirection HTTP vers HTTPS (.htaccess, Apache, IIS, Nginx, Lighttpd)

Si votre site est en HTTPS, il faut mettre en place une redirection 301 de toute URL en HTTP vers son équivalent en HTTPS. Idem pour l'inverse ! Cet article explique comment faire (sous Apache, IIS, Lighttpd et Nginx).

Quelles données structurées faut-il ajouter pour un meilleur référencement ? Comment trouver les bonnes ? Réponse dans ce dossier.

Les données structurées ne servent pas seulement à obtenir des rich snippets, mais aussi à optimiser son site (SEO) pour le web sémantique.

C'est quoi les "données structurées" ? Quel rapport avec les entités et schema.org ? Format JSON-LD ou autres ? Réponses dans ce dossier complet.

Piochez dans ces idées pour améliorer votre référencement naturel notamment sur Google. Elles sont toutes validées, bien expliquées et applicables en pratique. Technique, contenu, satisfaction utilisateur, notoriété : il y a de tout ! Mis à jour en juillet 2020

Gérer les produits temporairement indisponibles sans perdre en référencement

La rupture de stock est une situation assez fréquente sur les sites ecommerce. Elle s'accompagne souvent de déception chez l'internaute et parfois de perte de CA. Voici comment gérer le cas des produits temporairement non disponibles (stock épuisé), sous l'angle SEO mais aussi expérience utilisateur.

D'après de nombreux retours d'expérience que j'ai pu avoir, la majorité des SEO et éditeurs de sites pensent que les images sont bien optimisées. C'est pourtant rarement le cas, surtout en ecommerce. Voici les erreurs importantes que vous devez éviter...

Référencement : comment repérer et corriger les erreurs Soft 404

Si vous avez sur votre site des erreurs de type "Soft 404", les moteurs de recherche peuvent perdre du temps à crawler et indexer des pages sans intérêt, au détriment de vos pages de contenu. Google vous aide à les détecter en les listant dans l'interface de Google Search Console. Explications...

Les images jouent un rôle majeur sur votre site, ainsi que dans les pages de résultats de Google. Voici ce que je vous conseille d'analyser en termes SEO (référencement naturel) et UX (expérience utilisateur).

Comment indiquer à Google si l'adresse officielle est avec www ou sans ? Voici le point sur ce que Google appelait le domaine favori...

Comment lister ses pages indexées par Google avec la commande site:

Le B-A-BA du référencement, c'est de faire indexer les pages de son site. Mais dans Search Console, Google ne liste pas celles qu'il a indexées, alors voici des astuces pour obtenir la liste des pages indexées, avec tuto vidéo.

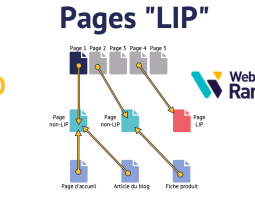

La pagination peut masquer des problèmes, vous empêcher de comprendre que le maillage interne est loin d'être optimal. Voici des explications en vidéo et une méthode pour faire les tests sur votre site.

Les pages LIP (Lost In Pagination) sont des pages handicapées en termes SEO par un très mauvais maillage interne. On en trouve sur les gros sites, notamment ecommerce. Les identifier permet de corriger le problème et d'augmenter le trafic. Explications...

Les principaux moteurs de recherche gèrent l'URL canonique, un procédé permettant de réduire les problèmes de contenus dupliqués (duplicate content). Ce dossier WebRankInfo rédigé par Olivier Duffez explique tout sur l'utilisation de cette balise spéciale link rel=canonical.

Suivez cette méthode concrète pour sélectionner les pages de votre site qui présentent le meilleur potentiel de croissance des visites SEO en passant de la page 2 de Google au bas de la page 1.

Référencement : les 13 + grosses erreurs sur l'URL canonique

L'URL canonique sert à indiquer aux moteurs quelle est l'URL officielle d'une page ; c'est utile dans certains cas pour résoudre les problèmes de contenus dupliqués. Mais attention : mal utilisée, l'URL canonique peut nuire à votre SEO !

Maîtrisez l'URL Rewriting ! Tuto complet avec astuces pour un bon SEO

Découvrez comment utiliser la technique de l'URL rewriting pour réussir le référencement de votre site avec des URL dynamiques. Apprenez aussi quels sont les bons formats d'URL, efficaces pour votre SEO.

Sous-domaine ou répertoire pour le référencement naturel Google ?

Le sujet fait couler moins d'encre que l'histoire du underscore comme séparateur, mais on voit souvent des discussions au sujet de l'intérêt des sous-domaines pour le référencement. Est-ce plus efficace que les répertoires ? Est-ce risqué vis-à-vis des moteurs ? Google a-t-il changé son algorithme récemment ? Voici quelques réponses...

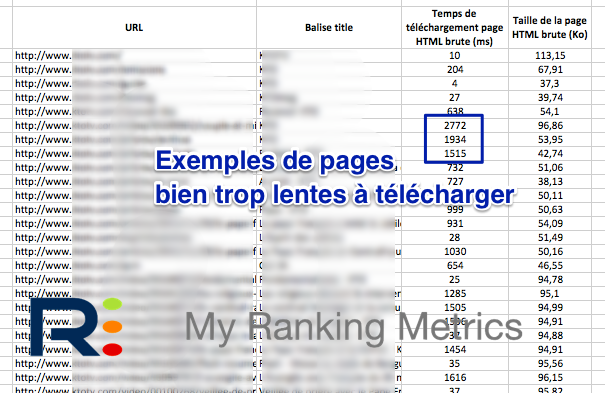

Plus vos pages sont longues à télécharger pour Googlebot, plus cela réduit le nombre de pages téléchargées par jour pour votre site, ainsi que la fréquence de crawl. Search Console ne donne pas le détail des temps par page, voici donc comment faire pour obtenir cette info pourtant sont utiles.

Bien souvent on lit que Google pénalise un site pour cause de contenus dupliqués et ce type de déclaration fait parfois débat. En réalité les choses sont plus complexes que cela : il serait peut-être plus juste de dire que le contenu dupliqué handicape le référencement d'un site et que dans certains cas (overdose ?) le filtre de Duplicate Content applique une sanction. Cet article tente de clarifier les choses sur ces fameux duplicate content ("DC" pour les intimes)...

Les données structurées pourraient devenir un critère de l'algorithme de Google

Même si jusqu'à présent Google a toujours indiqué que l'utilisation de données structurées n'apportait aucun avantage dans le classement des résultats, ça pourrait devenir un jour un critère de son algorithme... Mais vous devez quoi qu'il arrive vous y intéresser, voici pourquoi.

Il peut arriver dans la vie d'un site d'avoir à changer de nom de domaine, souvent pour des raisons marketing (changement de nom de société, rachat, nouveau positionnement marketing, etc.). Pour les moteurs de recherche, les adresses de toutes les pages vont changer, et donc ils vont découvrir un nouveau site. Voici comment faire pour ne pas repartir de zéro dans le référencement, et optimiser la transition.

Ce dossier spécial de WebRankInfo aborde les points suivants : en quoi consiste vraiment Google Panda ? Quels sont ses critères ? Quelle chronologie ? Comment adapter son site à Panda ?

Google Panda : analyse de 4 critères liés au comportement de l'internaute

Il est certain que l'algorithme Panda de Google soit basé sur des éléments liés au comportement de l'internaute sur les SERP et sur les sites visités. Cet article cherche à faire le point sur certains critères (taux de rebond, taux de clic SERP, temps passé sur les pages, etc.) pour évaluer s'ils sont exploitables par Google...

La plupart des webmasters n'y font pas attention, mais leur site est souvent accessible en tapant le nom de domaine avec ou sans le sous-domaine www. Ceci peut poser des problèmes car les moteurs pourraient indexer un duplicata du site. Ce dossier donne les solutions pour les serveurs Apache, nginx, lighttpd et IIS. Explications...

La création de (nombreuses) pages satellite (créées uniquement pour positionner un site sur des requêtes bien précises) est interdite depuis longtemps par Google et les autres moteurs. Google a mis à jour son algo pour mieux détecter (et sanctionner) ce type de pages.

Comment changer d'hébergement web sans casser le référencement

Il est fréquent dans la vie d'un site d'avoir à changer son hébergement (je parle ici des changements d'adresse IP et pas de nom de domaine). Voici ce qu'il est conseillé de faire pour ne pas pénaliser son référencement sur Google.

Les problèmes liés aux contenus dupliqués (duplicate content ou DC) figurent désormais parmi les sujets les plus fréquemment discutés sur les forums de référencement comme WebRankInfo. Et pour cause : les moteurs de recherche luttent de plus en plus activement contre les contenus dupliqués. Google a notamment un filtre de détection de contenu dupliqué qui dans certains cas peut faire chuter de 95% le trafic généré vers un site. Ce tutoriel passe tout en revue pour vous aider à mieux comprendre ce qui se passe et mettre en oeuvre des solutions.

Référencement e-commerce : comment gérer les fiches des produits supprimés ?

Sur un site marchand, c'est fréquent d'avoir des produits qui sont supprimés définitivement du catalogue. Comment gérer cette situation de façon optimale pour le référencement ? Explications...

L'algorithme de Google visant à pénaliser les pages ayant trop de publicités

Découvrez l'algorithme Page Layout de Google, qui tente de pénaliser les pages avec trop de publicité, surtout au-dessus de la ligne de flottaison. 3 versions ont été officialisées de 2012 à 2014. Explications.

Voici quelques infos partagées par les responsables du site HomeAdvisor qui ont changé de nom de domaine alors que leur site existait depuis 13 ans, qu'il contenait 10 millions d'URL et générait 200 millions de dollars de revenus... Comment gérer la migration en préservant le référencement ?

Référencement naturel : dans les URL, le tiret meilleur que l'underscore

Si vous avez déjà passé un peu de temps sur un forum dédié au référencement, vous avez sans doute participé à des discussions enflammées à propos du tiret (-) et du underscore (_). Lequel faut-il utiliser ? Voilà une réponse claire issue d'un test de 2004 toujours valable, complété d'une réponse en vidéo par Matt Cutts...

Dans une vidéo de réponse à une question référencement, Matt Cutts conseille de privilégier la technique de la redirection permanente (code 301) plutôt que celle de la balise d'URL canonique.

Algo Google contre les noms de domaine à mots-clés (EMD: Exact Match Domain)

Matt Cutts vient d'annoncer la mise en place d'un nouvel algorithme visant à réduire la visibilité des sites dont le nom de domaine (NDD) ne contient que des mots-clés et dont la qualité est jugée mauvaise par Google.

La suroptimisation du référencement naturel combattue par un filtre de Google

Est-ce simplement une annonce de plus ou bien Google prépare-t-il réellement un filtre de détection des sites "sur-optimisés" d'un point de vue référencement naturel (SEO) ? En tout cas Matt Cutts a laissé échapper quelques infos. MAJ du 26/04 : conseils complétés, et informations mises à jour suite à l'officialisation de ce filtre par Google le 24/04.

Si vous souhaitez analyser finement les internautes que Google vous envoie, il vous faut d'une part un bon outil de mesure d'audience (par exemple Google Analytics, XiTi, etc.) installé sur votre site et d'autre part vous devez connaître la signification de tous les paramètres de Google. Cet article liste tous les paramètres pour lesquels un tracking est possible, avec à chaque fois des explications et les valeurs attendues.

Par le biais de Matt Cutts, responsable de l'équipe de lutte contre le spam, Google a annoncé vouloir lutter contre les sites de type ferme à contenu, jugés produire des contenus de trop faible qualité. Le 24/02/2011, Google a annoncé officiellement avoir déployé son nouvel algorithme anti content farms. Mais sur quels critères un algorithme peut-il se baser pour détecter ces usines à contenu ? Voici quelques pistes, histoire de lancer le débat et quelques réflexions.

Début mai, Google a mis en ligne une modification de son algorithme de référencement naturel, comme plusieurs centaines de fois par an. Mais cette fois-ci le changement a été fortement ressenti par de nombreux webmasters et emarketers. Certains ont connu une baisse soudaine de près de 20% et bien entendu d'autres ont au contraire bénéficié de fortes augmentation de trafic. Vous trouverez dans cet article des explications sur ces changements d'algo de Google, qui devraient avoir un impact assez fort dans les mois et années à venir, notamment sur l'optimisation de la longue traîne (Long Tail).

Le cloaking est une technique qui consiste à configurer un site web pour que le contenu d'une page diffère selon le type d'utilisateur qui cherche à la consulter. Les moteurs interdisent cette pratique dès lors que le contenu fourni aux robots est différent de celui fourni aux internautes. Voici quelques cas particuliers commentés par Google...

Les Rich Snippets de Google, basés sur l'analyse des données web structurées

Depuis le temps que les spécialistes du secteur se demandaient pourquoi Google n'exploitait pas plus les données structurées ! Google vient d'annoncer qu'ils allaient utiliser les 2 principaux formats de marquage de données structurées (les microformats et le standard RDFa) pour afficher certains résultats de manière enrichie : note moyenne et nombre d'avis par les consommateurs, adresse d'une entreprise, etc. Un petit pas vers le web sémantique... Cet article détaille tout cela et explique comment les webmasters doivent mettre à jour leurs sites pour en tirer profit.

Google tient compte des mots-clés dans l'URL, mais leur impact est moins fort que vous le pensez

Conseils d'optimisation des URL pour le référencement : quelle est l'importance réelle de la présence de mots-clés dans l'URL ? Explications par Olivier Duffez.