Article mis à jour le 20/07/2015, publié initialement le 27/05/2011

Sommaire

- Taux de rebond

- Taux de clic dans Google

- Durée de visite

- Pogo sticking Google (allers-retours dans les SERP)

Le taux de rebond

Définition du taux de rebond

Le taux de rebond (d'un site) correspond au pourcentage de visites à une page. C'est donc le pourcentage d'internautes qui arrivent sur le site et repartent sans consulter la moindre autre page du site. On utilise le terme "rebond" car dans un certain nombre de cas, l'internaute quitte le site en cliquant sur un lien : on considère alors qu'il rebondit sur le site. En anglais vous trouverez l'appellation Bounce Rate.

La définition de Google Analytics : Le taux de rebond est le pourcentage de visites d'une seule page, c'est à dire le pourcentage de visites au cours desquelles l'internaute quitte votre site dès la page d'entrée (ou "page de destination"). Ce taux constitue un indicateur de la qualité des visites. Lorsqu'il est élevé, cela signifie généralement que les pages d'entrée sur le site ne correspondent pas aux attentes des visiteurs. Plus vos pages de destination sont attrayantes, plus les visiteurs restent sur votre site et plus vous enregistrez de conversions.

Attention à ne pas mélanger avec le taux de conversion (= taux de transformation) qui correspond au pourcentage de visites pour lesquelles l'objectif fixé pour le site a été atteint. Si par exemple l'objectif est que l'internaute s'inscrive à la newsletter, le taux de conversion est le pourcentage de visiteurs du site qui s'inscrivent.

Le taux de rebond peut-il être exploité par Google ?

On entend souvent dire qu'un taux de rebond élevé est mauvais car l'internaute n'est pas satisfait. Si c'est vrai dans beaucoup de cas, ce n'est pas toujours le cas ! Un exemple parmi tant d'autres : un internaute cherche un numéro de téléphone, fait une recherche sur Google, clique sur un des résultats et trouve le numéro immédiatement sur la page d'arrivée. Il est très satisfait et pourtant il n'a consulté qu'une seule page sur le site.

On peut aussi se demander comment Google pourrait avoir accès à la valeur du taux de rebond d'un site. Certes, il y a des millions de sites avec Google Analytics, mais si le taux de rebond devait être un critère de l'algo, il faudrait que Google le connaisse dans tous les cas.

Par ailleurs, on peut s'amuser à falsifier la valeur du taux de rebond telle qu'elle est enregistrée dans Google Analytics ! Il suffit que dans le code de suivi, la fonction ga('send', 'pageview'); soit affichée plusieurs fois pour chaque page (et chaque internaute). Par exemple pour diviser par 2 son taux de rebond, il faut faire 2 appels à ga('send', 'pageview') (au lieu d'1) pour une visite sur 2. Cela gonflera artificiellement votre nombre de pages vues et votre taux de rebond sera divisé par 2. Vous pouvez même parvenir à un taux de rebond nul (0%) en faisant 2 appels à ga('send', 'pageview') (au lieu d'1) dans tous les cas... Mais vous aurez bien compris que cela n'a aucun intérêt pour vous !

Cela étant, Google dispose d'un grand nombre de moyens pour estimer le taux de rebond : sa barre d'outils, le navigateur Google Chrome, les publicités AdSense ou DoubleClick, etc.

Ma conclusion : Google ne peut pas se baser uniquement sur le taux de rebond, il doit l'analyser conjointement avec d'autres critères.

Mon conseil : calculez le taux de rebond en regroupant les pages d'un même type. Par exemple, calculez le temps moyen passé sur vos fiches produits, ou bien sur vos articles rédactionnels, ou sur votre page d'accueil, etc. Ca n'a quasiment aucun intérêt de calculer le taux de rebond moyen sur l'ensemble du site. Pour faire cela, si vous utilisez Google Analytics, vous aurez besoin de segments avancés. Posez-vous ensuite la question : est-ce normal d'avoir ce genre de valeur ? Comment puis-je améliorer les page de ce type pour que l'internaute soit plus satisfait ?

Le taux de clic dans les résultats (CTR dans les SERP)

Définition du taux de clic dans les SERP

Le taux de clic d'un résultat dans les SERP (pages de résultats de recherche) correspond au pourcentage d'internautes qui cliquent sur le résultat. On le calcule en divisant le nombre de fois où un internaute a cliqué sur le résultat par le nombre de fois où le résultat est apparu dans les SERP. En anglais on parle de CTR : click through rate.

Le taux de clic peut-il être exploité par Google ?

Si vous avez bien suivi, vous savez sans doute que Google intègre du tracking dans ses pages de résultats. Cela signifie qu'un grand nombre d'actions de l'internaute sont enregistrées pour évaluer la qualité des SERP et l'ergonomie de la page. Google dispose donc des valeurs exactes des taux de clics. Si le taux de clic est mauvais, c'est soit que le résultat n'incite pas assez l'internaute à cliquer (mauvais titre ou descriptif ou URL), soit que Google fait apparaître une page dans ses résultats alors qu'elle n'est pas pertinente pour la requête. Pour renforcer la fiabilité de cet indicateur, Google peut très bien :

- comparer le CTR d'un résultat au CTR moyen mesuré par Google pour des milliards de requêtes, pour une position donnée. Google sait qu'en général le 1er résultat obtient X%, le 2ème Y%, etc. Google peut tenir compte du type de requête (recherche d'information, intention d'achat, simple navigation, etc.)

- mesurer le CTR moyen associé à un site. Si le CTR moyen sur les résultats qui mènent à votre site est plus faible que la moyenne calculée sur un grand nombre de sites (à position égale), la faute à ce mauvais CTR vient de vous...

Ma conclusion : il est probable que Google exploite le taux de clic dans les SERP. Par contre ce critère n'est pas forcément utilisé de façon directe (un mauvais CTR pénalisant systématiquement le positionnement) mais aussi de façon indirecte (pour confirmer un autre critère ou pour déclencher des analyses complémentaires en cas de CTR anormal).

Mon conseil : rédigez vos balises title très soigneusement, chaque titre devant décrire très précisément le contenu de la page. Prenez le temps de rédiger une description d'environ 2 lignes à mettre dans votre balise meta description : vous aurez plus de chances que Google utilise votre descriptif en guise de snippet, plutôt qu'un extrait de votre page. D'une manière générale, assurez-vous d'optimiser une page pour ses expressions stratégiques principales et pas pour des expressions trop éloignées. Si cela vous arrive, essayez de comprendre pourquoi et si besoin, corrigez la structure de votre site.

On sait aussi que le CTR est pris en compte dans l'algo Navboost.

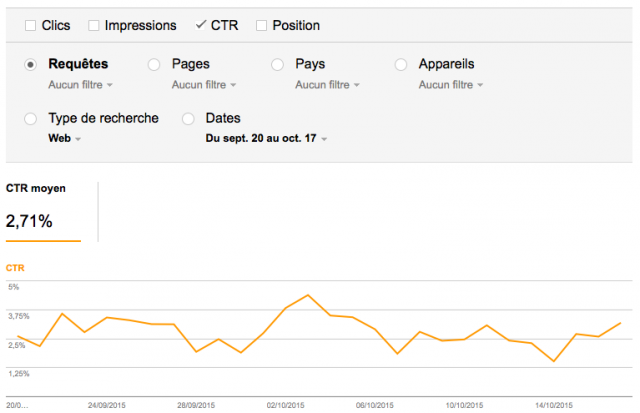

Les plus attentifs parmi vous auront remarqué que le CTR est indiqué dans votre compte Google Search Console, rubrique Trafic de recherche > Analyse de la recherche :

Le temps passé sur le site

Définition de la durée de visite

Comme tous les autres outils de web analytics, Google Analytics mesure le temps passé sur une page en calculant des différences entre des dates d'arrivée (le moment où le script est exécuté). Cela signifie que :

- Google Analytics est incapable de mesurer le temps passé sur la dernière page vue par un internaute sur un site

- Google Analytics attribue une durée de visite nulle (zéro seconde) à toutes les visites d'une seule page (les fameuses visites considérées comme des rebonds).

- la durée moyenne de visite des internautes sur votre site, telle que calculée par Google Analytics, est fausse. En réalité elle est toujours supérieure au chiffre indiqué.

La durée de visite peut-elle être exploitée par Google ?

Comme pour le taux de rebond, il existe quantité de situations où une faible durée moyenne de visite n'est pas synonyme d'échec. Malgré tout, on peut imaginer que si votre durée moyenne de visite est vraiment très faible, ce n'est pas bon signe. Si en plus Google arrive à évaluer le type du site (institutionnel, boutique en ligne, etc.) ou sa taille (nombre de pages indexées), l'analyse de la durée de visite peut sans doute donner des pistes sur la qualité du site (perçue par les internautes).

Encore une fois, comme pour le taux de rebond, il est sans doute possible de falsifier la durée moyenne de visite (mesurée par Google Analytics) en simulant des pages vues. Je n'ai pas dit que c'était intéressant ou utile, juste que c'était sans doute possible ;-)

Ma conclusion : Google ne peut pas se baser uniquement sur la durée de visite (ou le temps passé sur une page), il doit l'analyser conjointement avec d'autres critères. Néanmoins, avoir une durée de visite très faible n'est en général pas bon signe, surtout comparativement à d'autres sites similaires.

Mon conseil : calculez le temps moyen passé sur vos pages (même si vous savez que cette mesure n'est pas assez fiable), en regroupant les pages d'un même type. Par exemple, calculez le temps moyen passé sur vos fiches produits, ou bien sur vos articles rédactionnels, ou sur votre page d'accueil, etc. Posez-vous ensuite la question : est-ce normal d'avoir ce genre de valeur ? Comment puis-je améliorer les page de ce type pour que l'internaute soit plus satisfait ?

Pogosticking (allers-retours dans les SERP)

Définition du pogosticking

Ce terme vient du nom d'un jouet intitulé Pogo stick, une sorte de baton sauteur sur lequel on se tient et qu'on utilise pour faire des bonds, un peu à la manière d'un kangourou :-) Le pogosticking correspond à l'activité d'un internaute qui va et vient sur une même page de résultats de recherche, cliquant sur les résultats, visitant les sites et revenant en arrière dans Google pour cliquer sur d'autres résultats.

Ce terme vient du nom d'un jouet intitulé Pogo stick, une sorte de baton sauteur sur lequel on se tient et qu'on utilise pour faire des bonds, un peu à la manière d'un kangourou :-) Le pogosticking correspond à l'activité d'un internaute qui va et vient sur une même page de résultats de recherche, cliquant sur les résultats, visitant les sites et revenant en arrière dans Google pour cliquer sur d'autres résultats.

Le pogosticking peut-il être exploité par Google ?

Imaginez un internaute qui fait une recherche sur Google, qui clique sur un résultat, qui revient en arrière rapidement puis clique sur un autre résultat et ne revient plus sur Google. N'est-ce pas a priori un internaute qui a été déçu par le premier résultat ? Il est vrai qu'on a besoin parfois de voir plusieurs sites parmi les résultats pour comparer ou obtenir des informations complémentaires. Mais Google peut affiner cette analyse de plusieurs façons :

- en supposant que globalement les résultats de Google sont classés de façon pertinente, il est fréquent que les internautes soient satisfaits majoritairement par les tout premiers résultats. Si une page est mal classée selon ce "critère du pogosticking" alors qu'elle figure en tête des résultats, c'est "statistiquement anormal" si je peux me permettre d'utiliser cette expression. Et donc on peut estimer que l'internaute a été déçu.

- en faisant la moyenne de la note obtenue par un site selon ce "critère du pogosticking", Google bénéficie d'un critère sans doute plus fiable. Il peut même comparer la note à celle obtenue par des sites similaires (par exemple ceux visités par les mêmes internautes).

- en associant cette note à la mesure du temps passé sur les pages ou la durée de visite, Google peut affiner et disposer d'un critère qui me semble intéressant pour évaluer la qualité perçue par les internautes.

Ma conclusion : il est probable que Google utilise des critères proches de ce que je viens de décrire ici sous le terme pogo sticking. Je rejoins l'avis de plusieurs experts SEO dont Jim Boykin qui a beaucoup publié sur ce sujet, notamment sur la notion de "short clicks" et "long clicks" (respectivement les visites courtes et longues des internautes sur les pages trouvées dans les résultats Google).

Mon conseil : le problème auquel vous êtes confronté est qu'il vous est impossible de détecter les cas de pogosticking (à moins de disposer régulièrement de plusieurs résultats dans la même page de SERP !). En d'autres termes et à peu de choses près, seul Google peut effectuer les mesures que j'ai décrites ici. Dans ces conditions, c'est difficile d'améliorer votre site en fonction de ce critère. Voici ce que je vous conseille malgré tout : identifiez les (types de) pages qui ont une faible durée de visite et un fort taux de rebond. Si possible, incluez également la taille de votre page dans l'analyse.

Votre avis sur ces critères

J'espère que vous avez apprécié ce genre d'analyse (même si mon article est un peu long...). Alors, pensez-vous que le comportement de l'internaute soit un des facteurs du filtre Panda ?

Je n'ai étudié que 4 critères, quels autres critères pensez-vous que Google pourrait exploiter (ceux qui concernent le comportement de l'internaute) ? Par ailleurs vous avez certainement des remarques à faire sur cet article. J'attends donc vos commentaires pour alimenter le débat !

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Un indicateur lié au comportement de l'utilisateur que Google utilise sûrement : le CTR relatif.

Tout simple : si pour une requête donnée, les utilisateurs cliquent davantage sur le second lien que sur le premier, le second remonte.

Vous êtes d'accord ?

Oui, cet article en parle : https://www.webrankinfo.com/dossiers/conseils/meta-description-seo

Bonjour, j'ai un taux de rebond de 80% et j'aimerais le baisser, vous dites :

"Par ailleurs, on peut s'amuser à falsifier la valeur du taux de rebond telle qu'elle est enregistrée dans Google Analytics ! Il suffit que dans le code de suivi, la fonction trackPageView soit affichée plusieurs fois pour chaque page (et chaque internaute). Par exemple pour diviser par 2 son taux de rebond, il faut faire 2 appels à trackPageView (au lieu d'1) pour une visite sur 2. Cela gonflera artificiellement votre nombre de pages vues et votre taux de rebond sera divisé par 2. Vous pouvez même parvenir à un taux de rebond nul (0%) en faisant 2 appels à trackPageView (au lieu d'1) dans tous les cas..."

Je ne trouve pas trackpageview dans le code de suivi, j'ai

ga('send', 'pageview');

Est-ce que c'est ce code ?

Et est-ce que la manip consiste seulement à afficher ce code deux fois dans le code de suivi ?

Merci

Bon article Olivier,le comportement de l'internaute est une donnée essentielle à analyser et à comprendre.

La durée de visite, le taux de rebond, le taux de sortie et le nombre de pages consulté par les visiteurs sont désormais des informations à analyser et à intégrer dans la stratégie de référencement.

Si vous êtes « mauvais » sur ces indicateurs, il y a de fortes chances que PANDA déclasse votre site sur bon nombre de requêtes...

J'aime bien la théorie "pogosticking", elle a été ajouté après coup si je ne m'abuse?

J'ai un annuaire de jeux qui a été pénalisé par panda, l'utilisateur ne trouve en effet aucun jeu sur le site. Ce qui effectue un fort taux de rebond avec un très léger temps passé sur le site.

Ca va me faire réfléchir à l'idée de transformer cet annuaire en véritable site de jeux...

Non Xavier, je l'avais incluse dans mon article dès le début et je suis convaincu que c'est la meilleure façon d'analyser les choses

Je cherchais justement une explication aux visites à 0:00s (relativement nombreuses) et ça me rassure. Je craignais un peu qu'il ne s'agisse d'un problème technique qui empêche la page de s'afficher...Un très grand merci, donc!

Article intéressant !

Donc d'après ce que j'en comprends, le critère le plus pertinent resterait le comportement et retour aux résultats de recherche (pogosticking).

Effectivement ça permettrait de pénaliser certains sites qui sortent complètement des "normales", mais difficile d'en tirer des conclusions précises.

Une page peut-être très intéressante mais sans forcément traiter de l'intégralité du sujet, et donc inciter fortement à aller chercher d'autres résultats pour en savoir plus.

Devra-t-on en déduire que le site en question est mauvais ?

Après c'est sûr que si 95% des visiteurs retournent aux résultats, il n'y a pas beaucoup d'illusions à se faire...

Cet article est il toujours valable après la MAJ de Pingouin ?

Quant aux évaluateurs humains, pour moi ils sont plus là pour lutter contre les abus que pour le classement, je ne vois pas bien en quoi ils pourraient juger que tel site mérite d'être à la 3e place ou à la 30e, c'est au final l'intérêt de l'utilisateur et la popularité qui fait le classement.

Oui cet article est tout à fait encore valable, Pingouin n'a pas changé l'algo Panda à ma connaissance.

Les évaluateurs humains n'ont pas pour objectif de commenter les classements mais de dire à quel point une page répond à la demande de l'internaute.

Comme le dit iadeo, les évaluateurs humains vont apporter de plus en plus d'infos très intéressantes et facilement accessibles pour google, plus les gens resteront connectés à google+, moins on en saura et plus google lui aura de quoi se faire une bonne idée de la pertinence du site ou de la page...

Surveillez vos statistiques et principalement les visites ayant google+ comme source...

En plus des calculs, Google utilise les services d'evaluateurs de site humains et c'est l'association des 2 qui font le classement des sites.

L'on peut même en déduire que le résultat des Googgle raters sert aussi à vérifier et affiner la justesse de l'algorythme du moteur. Pour Bing c'est pareil mais à une echelle réduite.

il est si difficile de référencer un site quand on a un petit budget

Exemple dans notre cas, un site de vente en ligne de tissage brésiliens satishair.com

Merci pour cet article

L'idée est claire et l'optimisation du taux de rebond demeure l'objectif de tout le monde.

Mais, il reste à rappeler que tout dépend de la catégorie du site, de son volume et des services qu'il offre.

En tout cas, merci pour le rappel :)

Pour info voici un teste sur le taux de rebond comprendre, analyser : optimiser ses pages web.

google se sert déjà de nos historiques pour nous proposer une page de résultats plus personnalisée .

je pense qu'à terme google va encore plus personnalisée les pages de résultats en se basant sur notre réseau créé à partir de nos comptes google :

- avec gmail : on a déjà la mention " monsieur dupont a partagé ce résultat "

- sur youtube : les " j' aime " j' aime pas " vont influencer les vidéos présentes dans la recherche

- le +1 sur les pages aura sans doute plus d' influence si un de mes contacts a fait +1

...

est-il possible que google privilégie ses propres réseaux sociaux dans son algo au détriment notamment de facebook et twitter ?

Si Google en avait vraiment... Tu penses à quoi concrètement ?

Sur un plan général, il semble qu'au final, se distingue deux domaines différents et qui ne sont pas lié, ou j'en doute.

Panda devrait être un filtre pour éliminer un certains nombre de sites, mais à mon avis, ne serait pas lié au comportement de l'internaute.

Mais ce ne serait pas stupide.

Imaginons que nous soyons "le service d'amélioration" de Google (...), nous pourrions faire la proposition que le comportement des internautes sur un site puisse être étudié, et selon certains critères, déclencherais une "re visite" de Panda.

Avec un certain grand nombre de site "dans le collimateur" , il serait alors plus aisé de les comparer avec ceux qualifiés de "correct" , de trouver des similitudes nouvelles chez les mauvais, et renvoyer dessus un Panda amélioré ...

En effet, mais le pire n'est pas à craindre ??? Panda doit être une mise à jour de l'algoritme servant à Analyser les Backlinks puisqu'il fait référencement aux farms links et à l'édition de contenu ou plutôt soupe pour les moteurs de recherche...

Mais là on s'éloigne du sujet sur le taux de rebond et le taux de clic... désolé :S

Il ne faut pas confondre les content farms et les farm links. Il ne me semble pas que Panda cible les fermes de liens...

Ce n'est pas tellement dans l'article mais dans les réactions que se trouvent les choses intéressantes, pour moi.

Article :

"mon hypothèse est...", "d'après tel livre ", "est-ce que quelqu'un a des preuves étayant ceci" ?

C'est de la spéculation.

Dans les réactions :

1) Matt Cutts "Google n'utilise pas les données de GG Analytics, d'aucune façon".

Mon avis : il n'en a pas besoin, il a ses logs serveurs.

2) Webmaster central blog : "In some high-confidence situations, we are beginning to incorporate data about the sites that users block into our algorithms."

Cette mesure me semble plus pertinente, mais ce n'est ni CTR, ni bounce rate, ni chronométrage.

3) interview de Matt à Search engine Land juin 2010 : "To the best of my knowledge, the rankings team does not use bounce rate in any way."

Et c'est surtout ce qui est dit juste après cela qui est intéressant : les différentes façons de voir les long-clicks et short-clicks.

Je vais de ce pas voir si on discute de ceci dans le forum ;-)

@bigbanbgel : si on devait s'en tenir uniquement aux déclarations de Google (Matt Cutts ou autres), et les croire sur parole, alors autant arrêter de bosser le SEO ;-)

Cet article est justement là pour lancer un débat sur des éventuels critères. Que ce soit à l'occasion de Panda ou pas, je pense que c'est utile de temps en temps de s'intéresser à d'autres façons de voir les choses, dont son site et son optimisation.

Enfin au final, si tu as trouvé des choses intéressantes grâce à l'article, tant mieux !

Moi, je continue à penser que c'est trop difficile de tirer des conclusions à partir du CTR et du bounce rate dans les SERPs.

Voici un article (en anglais) qui dit mieux que moi ce que j'en pense ...

@bigbanbgel : l'auteur que tu cites rejoint bien l'avis que j'ai exprimé ici. Il dit "my hypothesis is that Google has recently decided to use long click rates as a signal of a high quality site". En d'autres termes, en chronométrant les actions des internautes sur les SERP (et donc aussi sur les sites visités), Google peut avoir des idées assez précises de la satisfaction de l'internaute.

Pour certains sites d'infos, de contenus explicatifs ou "communautaires" etc .. cette analyse du comportement et l'optimisation ergonomique en seule vue de faciliter les utilisateurs conduisent a ne même plus utiliser google pour les trouver.

genre WRI, comme beaucoup, je tape directement l'url pour aller chercher ce que j'ai besoin comme info.

Le genre de site dont à l'inverse, Google a plutôt intérêt a bien positionner s'il ne veux pas passer pour un "médiocre" aux yeux de celui qui cherche un bon forum sur le référencement...

Cette optimisation et suivi des comportement des utilisateur est très bon pour un site (ou mauvais si négligé) , et surement un critère chez Google.

Pris en compte ou pas, Olivier à raison dans le sens qu'il vaut mieux anticiper en mettant en avant des idées "logiques", au conditionnel bien sur.

Quel est l'intérêt de chercher ce que personne ne saura jamais ? :-) Au mieux on se rapprochera des réponses, Google le saura, et changera les règles. Du pain béni pour WRI certes, mais un débat sans fin...

C'est simplement l'occasion de discuter de plusieurs moyens de trouver quelles parties d'un site il faut améliorer et d'en donner des pistes. Améliorer pour l'internaute et probablement pour le référencement. C'est déjà pas si mal ;-)

Bonjour Olivier,

Le taux de rebond peu en effet être très différente d'un site à l'autre, pour un annuaire d'entreprises, il est obligatoirement très élevé.

il peut aussi l'être pour un grand nombre de sites et tout a fait normal.

Ce que peux surtout faire Google, c'est d'analyser les termes de la requête suivante, car l'on peu passer du coq à l'âne dans sa navigation sur internet.

Si cette requête est dans le même sujet, ou comporte des mots clés identique, il est plus évident de déterminer si l'indexation est correcte ou pas, et a google de rectifier ainsi le tir.

Un taux de rebond peut indiquer que le classement est très pertinent, ou à l'inverse, si l'internaute clique sur un autre lien ou récidive + ou - la même requête, le classement est mauvais.

Le sujet est intéressant, surtout si l'on veut aboutir au meilleur service pour l'internaute.

C'est vrai qu'un site avec un design et un contenu de qualité devrait avoir un taux de rebond très faible.

Néanmoins pensez-vous que les liens sponso et les sites présents dans les pubs n'enregistrent pas un gros taux de rebond ?

Google les déclasserait en référencement naturel ? Je ne pense pas trop, mais bon tout est possible.

Pour ma part, j'édite un site de vente en ligne qui enregistre 0,01% de taux de rebond, mais m'autres facteurs plus importants comme le nombre et la qualité de liens ont permis de lui faire gagner des positions après pendant...

Juste pour signaler un errata :

"Pour diviser par 2 son taux de rebond, il suffit d'appeler 2 fois la fonction trackPageView pour chaque page. Cela gonflera artificiellement votre nombre de pages vues (x2) et votre taux de rebond sera divisé par 2."

Si cette fonction permet de doubler le nombre de pages vues alors chaque "rebond" compte 2 pages vues, il n'y a donc plus de rebond. Cette fonction ne divise pas le taux de rebond, elle le supprime carrément soit 0% de taux de rebond avec cette méthode.

Pour diviser par 2 le taux de rebond il suffit de la doubler une fois sur 2 ;)

En effet, merci, j'ai corrigé mon article.

La durée de visite peut également être faussée de manière non intentionnelle par l'internaute qui ouvre une multitude d'onglets dans son navigateur, qui ouvre une nouvelle fenêtre, ou tout simplement s'il prend une 'pause' au milieu de son surf.

Un peu trop hasardeux pour être pris avec sérieux, ... mais qui peu donner un certain ordre d'idée il est vrai.

Je suis 100% d'accord avec toi : il est impossible pour google de faire appel aux taux de rebond tellement cette variable ne veut rien dire seule, que l'on peut la modifier à volonté et que le moteur ne peut le mesurer sur tous les sites (cf mon article sur l'utilité du taux de rebond.

La remarque est également valable pour la durée de la visite, qui est un critère encore pire car je peux avoir ouvert une page depuis une heure dans un onglet alors que je vais la consulter réellement 5 secondes...

Par contre, Google serait capable de mesure les visiteurs qui effectue une nouvelle recherche peu de temps après, ce qui voudrait dire que les résultats ne conviennent pas ou qu'ils ne sont pas assez complets. Je ne savais pas d'ailleurs que l'on appelait cela le pogosticking.

@Dolfy : je doute que le pogosticking permettent de déduire un taux de rebond. Car je peux très bien aller sur un site, visiter plusieurs pages, puis refaire une recherche pour affiner le contenu que je recherche.

Bonjour Olivier,

Personnellement, j'ai du mal à percevoir que Google puisse utiliser ce genre d'indice. Bien que ton analyse soit pertinente, comment Google pourra identifier les vrais des faux internautes utilisant son moteur de recherche ?

En effet, les gens qui seront conscients de ces critères pour le classement dans les SERPs pourront simuler très facilement des internautes et donc faire grimper leur site.

Google sait tellement de choses sur chacun de ses utilisateurs qu'il doit savoir sans problème différencier les vrais des faux internautes, ou même identifier les comportements artificiels...

Le "pogosticking" ne peut-il pas déterminer le taux de rebond d'un site ?

Je pense qu'il est possible que google prenne en compte la notion de fidélité du visiteur(taux de nouvelles visites et taux de visiteurs connus)dans ses critères pour évaluer les sites de "qualité".