Google ne veut plus indexer tout ce qu'on lui donne. C'est pourtant son job non ?

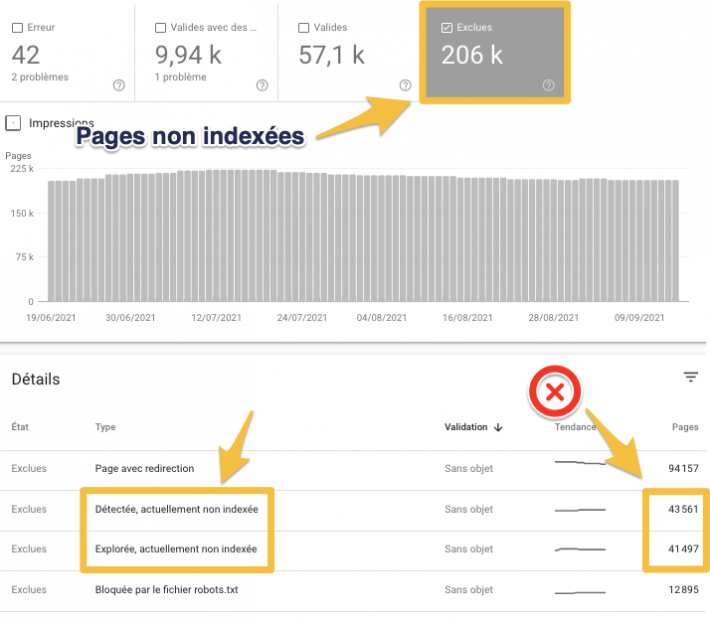

Une page non indexée ne risque pas de faire du trafic, c'est là tout le problème. Le comble, c'est que parfois Google ne veut même pas crawler une page qu'il connait pourtant. C'est la fameuse erreur "Détectée, actuellement non indexée" dans la search console, encore plus pénible que "Explorée, actuellement non indexée".

Je vais vous expliquer comment repérer les pages non indexées et pourquoi Google limite l'indexation.

Et bien entendu vous fournir des solutions à ce problème majeur SEO.

Comment trouver les pages non indexées ?

J'aurais bien voulu vous dire que c'est très simple, mais ce n'est pas toujours le cas. Si vous avez un petit site de quelques pages, c'est sûr que c'est plus facile qu'avec des milliers.

Liste des pages non indexées (et qui devraient l'être)

Voici pour commencer une méthode qui marche déjà bien pour avoir une vision globale :

- Allez dans Google Search Console, rubrique "Index", rapport "Couverture".

- Cliquez sur "Exclues" pour afficher les pages non indexées (cliquez aussi sur "Erreur" pour désactiver ce filtre)

- Identifiez dans le tableau sous le graphique si vous avez une ou deux des lignes suivantes :

- Explorée, actuellement non indexée

- Détectée, actuellement non indexée

Comment savoir si une URL en particulier est indexée ?

- la méthode officielle est d'utiliser l'inspecteur d'URL (tapez l'URL dans le champ de recherche en haut de la search console)

- essayez aussi la commande site:{URL} même si elle n'est pas faite pour ça (attention, ce n'est pas toujours exploitable)

- ou bien la commande inurl:{URL}

- ou bien tentez votre chance et cherchez dans Google un bout de phrase présente dans la page à tester (avec des guillemets éventuellement)

- ou bien avec des outils (vérifiez leur fiabilité...)

Vous comprenez que non seulement ce n'est pas si simple, mais en plus c'est infaisable pour toutes les URL de votre site. Sans compter qu'il peut aussi y avoir des différences selon les data centers de Google.

Le problème est que parfois, le rapport de couverture de l'index n'est pas à jour. Il arrive que :

- une page est déclarée non indexée alors qu'avec l'inspecteur d'URL elle est indexée. Ou bien l'inverse...

- une page est déclarée non indexée alors que vous la voyez dans les SERP !

Pourquoi Google n'indexe plus toutes les pages ?

Allez savoir, peut-être que Google trouve qu'il y a désormais trop d'URL à traiter chaque jour ? Qu'il faut réduire les coûts du crawl et de l'indexation ? Bien entendu, mais il y a une explication... découvrez-la ici.

En tout cas, pour avoir beaucoup étudié la question, je peux vous dire que c'est une volonté claire et nette chez Google de vouloir sélectionner les URL à indexer. En fait c'est même en amont que ça se décide : Google cherche à deviner si ça vaut le coup de crawler une page (a priori pour l'indexer), avant même de l'avoir crawlée.

Pour en savoir plus, lisez mon dossier sur le crawl prédictif de Google.

En gros, ce qu'il faut retenir, c'est que Google utilise des techniques d'IA pour évaluer à l’avance si ça vaut le coup de crawler une page.

Voici d'ailleurs ce qu'a déclaré Martin Splitt (ingénieur chez Google) :

Je sais que nous utilisons le machine learning pour identifier ou prédire la qualité que nous obtiendrons d’un crawl. Il est intéressant d’essayer de prédire le niveau de qualité que nous pouvons obtenir d’un crawl spécifique avant même qu’il ne se produise. Cela permet à Google de planifier son crawl de manière plus intelligente.

Martin Splitt (de Google), le 11/11/2020

Et voici le conseil de John Mueller (Search Advocate chez Google) :

"Si un nouveau contenu ne se fait pas indexer rapidement, le problème n'est pas qu'il est de qualité insuffisante, le problème vient vraiment de la qualité de l'ensemble du contenu existant sur le site."

John Mueller, août 2021

Voilà, je crois que vous avez compris qu'il faut s'intéresser à la qualité de toutes les pages que vous demandez à Google de faire indexer... Celles trouvables en suivant les liens, mais aussi les pages orphelines indexables.

Comment faire indexer toutes les pages d'un site ?

Après les conseils officiels de Google et les résultats de mon étude sur ce sujet, je vous propose plusieurs solutions.

Les conseils de Google pour faire indexer les pages

Bon, alors comment faire comprendre à cette Intelligence Supérieure (sic) que vos pages méritent d'être crawlées, et même d'être indexées ?

Il se trouve que cette question revient très souvent dans les sessions Google SEO office-hours. Voici par exemple en août 2021 :

Je publie régulièrement du contenu sur mon site et mes nouveaux articles ne sont pas traités par Google. Ils ne sont pas indexés assez rapidement. Que puis-je faire ?

La réponse :

Je pense que c'est quelque chose que vous devez améliorer au fil du temps, surtout si c'est un nouveau site. ça prend du temps aux algorithmes de Google d'évaluer tout ça, de crawler rapidement et souvent le contenu que vous ajoutez. Surtout s'il s'agit de nouveau contenu que vous publiez, on tient compte d'éléments tels que la qualité globale que nous avons pu constater sur le site au fil du temps.

Si c'est un nouveau site, l'algo ne dispose pas d'assez de contexte concernant la qualité.

Si c'est un site plus ancien et que vous voyez que Google ne vient pas crawler ou indexer les nouveaux contenus, j'essaierais de prendre du recul et de réfléchir à ce que vous faites pour qu'il soit clair qu'il s'agit d'un contenu de haute qualité et que vous n'avez pas sur le site de mélange entre des contenus de haute qualité et de faible qualité.Voici donc mon conseil : si le nouveau contenu ne se fait pas indexer rapidement, le problème n'est pas qu'il est de qualité insuffisante, le problème vient vraiment de la qualité de de l'ensemble du contenu existant sur le site.

John Mueller (Google), août 2021 (source)

Etude QualityRisk / Indexation Google

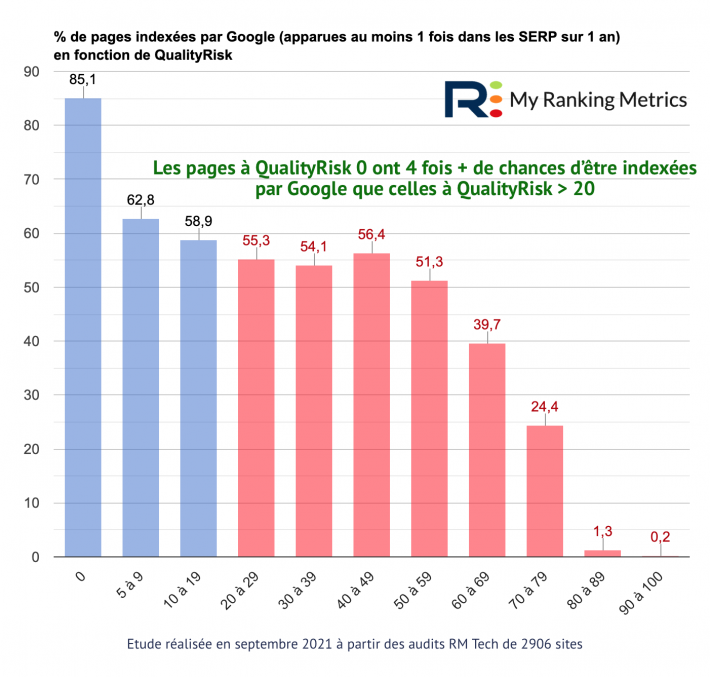

Alors là, je vous le dis tout de suite : ça tombe bien, j'ai exactement développé cette fonctionnalité dans mon outil RM Tech d'audit SEO. C'est en place depuis 2016 et ça s'appelle QualityRisk.

L'indice QualityRisk d'une page évalue si elle risque de décevoir (aussi bien l'internaute que l'algo Google). Un indice de 0 est parfait, tandis que 100 est la note la pire.

Avec mon associé Fabien, j'ai donc fait une étude de grande ampleur sur près de 3000 sites. L'objectif était de voir si cette évaluation de la qualité de chaque page (et donc aussi de l'ensemble du site) était corrélée ou pas à ce refus de Google d'indexer certaines pages.

Le résultat de l'étude QualityRisk / Indexation Google est sans appel :

QualityRisk est donc un excellent indicateur pour anticiper si Google "acceptera" d'indexer la page :

Les pages à QualityRisk 0 ont 4 fois + de chances d’être indexées par Google que celles à QualityRisk > 20

Etude My Ranking Metrics, septembre 2021

Remarque : si votre site est très récent, ou qu'il traite d'un sujet pour lequel Google est très exigeant (santé, finance, etc.), vous devez examiner d'autres critères pour comprendre les problèmes d'indexation.

Et pour votre site ? Je vous offre le test !

Pour réussir à faire indexer vos pages actuelles et futures, vous devez donc les améliorer pour réduire leur indice QualityRisk.

Tout est expliqué dans chaque rapport d'audit RM Tech, avec les données détaillées dans les fichiers annexes.

Je propose de vous fournir l'analyse (pages indexées selon QualityRisk) avec les données réelles pour le site de votre choix 👌

Vous obtiendrez un pré-audit RM Tech en version complète, sur le site de votre choix jusqu'à 10.000 URL (mais sans les annexes pour cette version offerte).

La cerise sur le gâteau 🍰

En fait, ce n'est pas une cerise mais une salade entière ! Je vais vous expliquer ça.

Si vous avez trop de pages que Google refuse d'indexer, c'est sans doute que vous avez trop de pages à fort QualityRisk.

Les pages à fort QualityRisk :

- sont beaucoup moins souvent indexées

- celles qui le sont quand même, sont bien moins efficaces (génération de trafic)

- empêchent des bonnes pages d’être indexées

- empêchent les prochaines bonnes pages d’être indexées

- dégradent la qualité globale perçue (par les internautes et par l’algo de Google)

Donc... Si vous corrigez ces pages (l'audit détaille tout !), c'est tout l'inverse qui devrait se produire avec vos pages à faible QualityRisk :

- la plupart d'entre elles seront indexées

- elles génèreront bien plus de trafic organique

- elles n'empêcheront plus les bonnes pages actuelles d’être indexées

- elles n'empêcheront pas les prochaines bonnes pages d’être indexées

- elles amélioreront la qualité globale perçue (par les internautes et par l’algo de Google)

Comment apprendre à améliorer ces pages et réduire le QualityRisk ?

J'explique tout ça dans un webinar... Je vous offre même le replay :

Avis d'autres SEO

J'ai pu discuter avec Stéphane Madaleno, qui a justement bossé sur ce sujet des pages non indexées par Google (cf. IsIndexed.com). Voilà ses conclusions :

En tout cas, sur à peu près tous les sites audités, 30% des pages d'un site après audit ne sont pas indexées. Le fait de les forcer sur Google Search Console améliore le truc, mais cela ne fait pas de miracles.

Stéphane Madaleno, septembre 2021

Sur 1 test qui date d'il y a 1 mois, 4% des pages qui étaient indexées le mois dernier ne sont plus indexées aujourd'hui. C'est très étrange… Je pense que la désindexation est liée à des pages de faible qualité, périmé ou contenu faible.

J'ai aussi discuté plusieurs fois avec Glenn Gabe, que je considère comme le meilleur spécialiste SEO des USA sur ce sujet, qu'il appelle Quality Indexation (que l'on peut traduire sans doute aussi bien "qualité de l'indexation" que "indexation de qualité). Voici ce qu'il dit :

J'ai abordé l'importance de ce que j'appelle « la qualité de l’indexation » à plusieurs reprises dans mes articles sur les principales mises à jour des algorithmes. C'est un sujet extrêmement important, surtout pour les sites de grande taille. Lorsque je parle de qualité de l’indexation, je fais référence à l'importance de s'assurer que votre contenu de qualité supérieure est indexé, tout en veillant à ce que votre contenu de faible qualité ou superficiel soit exclu de l'indexation.

Assurez-vous de vous concentrer sur une compréhension approfondie des niveaux de qualité de l'indexation sur l'ensemble du site. Ne vous retrouvez pas avec un grand nombre de pages de faible qualité indexées.

Élaborez un plan d'attaque pour améliorer l'indexation de qualité sur le site.

Google ayant confirmé que chaque page indexée est prise en compte dans l'évaluation de la qualité, le fait d'avoir de nombreuses pages supplémentaires de faible qualité indexées n'est pas une bonne chose.

Glen Gabbe, février 2020 (source)

Et vous, qu'en pensez-vous ?

Dites-le dans les commentaires ou sur le forum (Que faire en cas de problèmes d'indexation Google), ou contactez-moi.

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Mouais. Langue de bois et compagnie. Les bonnes pratiques, gnagnagna. Tout ça, c'est de la daube et nous le savons pertinemment. D'Olivier Andrieu à BHW, nous sommes tous du même avis: Google fait à la fois ce qu'il veut et n'importe quoi. C'est sans aucun rapport avec la qualité des sites, avec la pertinence des requêtes ou quoi que ce soit de rationnel. Un type a fait une étude sérieuse après les updates de rentrée (4-5 d'un coup!) et a prouvé que sur les sites qui avaient morflé, c'étaient les sites propres (white hat=75%) qui avaient pris trois quart plus cher que les sites sales (black hat=25%) J'ai vu des autuggests qui ne devraient pas exister, des pages indexées qui ne devaient pas l'être, des sites pourris qui rankent et de bons sites qui stagnent ou disparaissent. Google n'est pas notre ami et se fout des bonnes pratiques.

Je ne fais que m'appuyer sur des données, notamment des centaines d'audits de sites différents, donc je pense que ça fait un échantillon assez représentatif.

Bien entendu que l'algo de Google se plante, mais globalement ce que je décris fonctionne.

Bonjour Olivier, je viens de tomber sur ton article. Connaissant aussi ses services d'indexation, je me pose la question de savoir jusqu'à quel point peut-on aller ?

De plus pour les propos de Glenn Gabe, de se concentrer que sur les pages de bonne qualité et de sortir de l'indexation les pages de mauvaises qualité, peut-on être d'accord à 100% ? Même si ces page de faible qualité sont indexées mais ne rankent pas à fond, elles peuvent faire parti d'un écosystème de maillage interne. C'est donc à prendre avec des pincettes surtout que dernièrement on a pu voir ce genre de recommandations de la part de certaines agences seo, qui au final ont amené le site à perde 60 de son trafic....

Ni Glenn ni moi ne conseillons de désindexer les pages de mauvaise qualité. En tout cas pour ma part, la méthode Pages Zombies permet d'identifier très simplement et rapidement les pages qui posent problème ET celles qui cartonnent. L'idée étant d'avoir les infos pour corriger ce qui ne va pas sur les pires pages, parfois en s'inspirant de ce qui marche sur les bonnes.

Si certains s'imaginent qu'une page zombie c'est une page qui ne fait pas de trafic (c'est faux) et qu'il faut la supprimer/désindexer (c'est faux), c'est leur problème.

Si vous lisez ce commentaire, je vous conseille de visionner le replay gratuit de mon webinar sur les pages zombies.

Verdict : je vais continuer à produire du contenu et à me rendre populaire sur la toile. Le problème réside dans la qualité de mes articles.

Pour mon blog webmarketing, j'ai voulu adopté 2 stratégies. La 1 ère consiste à publier des articles remarquables, genre des dossiers de 3000 à 6000 mots sur des thèmes précis.

La 2nde, je l'ai souhaitée plus spontanée. Càd que j'écris des post d'humeur sans véritable plan.

J'ai également un dictionnaire. Par définition (sans jeu de mot huhu), un dico propose des pages relativement courtes (200 à 600 mots environ).

Mais tout cela me permet de proposer régulièrement du contenu sur le blog. Ce qui me paraît le plus important.

Je retiens la citation de John Mueller. Améliorer la qualité du site au fil du temps. Je vais pas trop me poser de questions...

Merci pour l'article, ça permet de bien cerner le problème !