Vous utilisez un navigateur non à jour ou ancien. Il ne peut pas afficher ce site ou d'autres sites correctement.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Échec : Impossible d'atteindre Robots.txt

- Auteur de la discussion samy2022

- Date de début

Quel site ?

Lorsque ./robots.txt est interrogé deux réponses sont admissibles : 200 (le fichier existe) ou 404 (le fichier n'existe pas) interprété comme explorable sans restriction. Les autres codes (et notamment les erreurs de type 5xx) posent problème (en pratique les redirections semblent passer).

Outil de test du fichier robots.txt : https://support.google.com/webmasters/answer/6062598?hl=fr

Lorsque ./robots.txt est interrogé deux réponses sont admissibles : 200 (le fichier existe) ou 404 (le fichier n'existe pas) interprété comme explorable sans restriction. Les autres codes (et notamment les erreurs de type 5xx) posent problème (en pratique les redirections semblent passer).

Outil de test du fichier robots.txt : https://support.google.com/webmasters/answer/6062598?hl=fr

merci de votre réactivité !

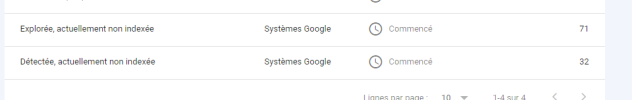

Oui effectivement mon robot.txt est correct d'aprés la search consol, j'ai également des URL qui ne sont pas indexé avec motif :

"Détectée, actuellement non indexée"

Explorée, actuellement non indexée

Mon robot.txt :

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

EXPORTER

PARTAGER

Toutes les pages connues

EXPORTER

PARTAGER

Toutes les pages connues

EXPORTER

PARTAGER

Toutes les pages connues

Oui effectivement mon robot.txt est correct d'aprés la search consol, j'ai également des URL qui ne sont pas indexé avec motif :

"Détectée, actuellement non indexée"

Explorée, actuellement non indexée

Mon robot.txt :

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

EXPORTER

PARTAGER

Toutes les pages connues

EXPORTER

PARTAGER

Toutes les pages connues

EXPORTER

PARTAGER

Toutes les pages connues

Fichiers joints

Faut voir de quand datent les explorations qui ont entraîné le message d'erreur.mon robot.txt est correct d'aprés la search consol

Il est possible que ton site ait connu un incident technique au moment où googlebot interrogeait robots.txt (regarde les erreurs d'exploration) où que cette requête envoyait une erreur corrigée depuis.

Ça, c'est d'une malheureuse banalité depuis 1 ou 2 ans."Détectée, actuellement non indexée"

Mais il est possible que la raison soit le blocage, réel ou perçu, via robots.txt

Plus ennuyeux, il faut voir pour quelle raison. Si ce sont des pages no-index, c'est pas un soucis, c'est c'est Google qui, d'autorité, a considéré qu'il n'était pas utile d'indexer ces pages, c'est peut être parce qu'il a estimé qu'elles n'étaient pas d'une qualité suffisante.Explorée, actuellement non indexée

Non pas de page en non-indexFaut voir de quand datent les explorations qui ont entraîné le message d'erreur.

Il est possible que ton site ait connu un incident technique au moment où googlebot interrogeait robots.txt (regarde les erreurs d'exploration) où que cette requête envoyait une erreur corrigée depuis.

Ça, c'est d'une malheureuse banalité depuis 1 ou 2 ans.

Mais il est possible que la raison soit le blocage, réel ou perçu, via robots.txt

Plus ennuyeux, il faut voir pour quelle raison. Si ce sont des pages no-index, c'est pas un soucis, c'est c'est Google qui, d'autorité, a considéré qu'il n'était pas utile d'indexer ces pages, c'est peut être parce qu'il a estimé qu'elles n'étaient pas d'une qualité suffisante.

Alors, oui, il faut être patient en SEO, mais attendre ne fait pas tout. S'il y a un autre problème que "c'est trop récent", il vaut mieux l'identifier au plut tôt.

Je suis assez "inquiet" par les pages explorées et non indexées, ce n'est pas particulièrement bon signe. Est-ce qu'elles ont un contenu de qualité ? par exemple qu'en dit 1.fr ?

Je suis assez "inquiet" par les pages explorées et non indexées, ce n'est pas particulièrement bon signe. Est-ce qu'elles ont un contenu de qualité ? par exemple qu'en dit 1.fr ?

je vous cache pas que je viens de se lancer dans ce monde de référencement etc...

Contenu de qualité je dirais oui, j'ai un balisage Hn optimisé, bon maillage interne, attribut alt....

comment peut on avoir la certitude qu'un contenu est de qualité ?

Merci de votre réponse

Contenu de qualité je dirais oui, j'ai un balisage Hn optimisé, bon maillage interne, attribut alt....

comment peut on avoir la certitude qu'un contenu est de qualité ?

Merci de votre réponse

Il n'est de certitude dans ce monde.

https://1.fr/ a un service d'analyse et d'optimisation du contenu, il est possible de tester gratuitement quelques pages. Ce n'est pas magique, on peut avoir des scores relativement faibles (30-50%) y compris pour des contenus élaborés susceptibles de se positionner de façon correcte, et les cas un peu particuliers ne sont pas forcément convenablement traités. Mais ça donne une idée.

https://1.fr/ a un service d'analyse et d'optimisation du contenu, il est possible de tester gratuitement quelques pages. Ce n'est pas magique, on peut avoir des scores relativement faibles (30-50%) y compris pour des contenus élaborés susceptibles de se positionner de façon correcte, et les cas un peu particuliers ne sont pas forcément convenablement traités. Mais ça donne une idée.

WRInaute accro

J'espère que tu parles bien de robots.txt avec un "s" et non de robot.txt sans "s" qui ne sert à rien.merci de votre réactivité !

Oui effectivement mon robot.txt est correct d'aprés la search consol, j'ai également des URL qui ne sont pas indexé avec motif :

"Détectée, actuellement non indexée"

Explorée, actuellement non indexée

Mon robot.txt :

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sinon, vu que tu as eu d'autres pistes sur un autre topic, il va falloir faire preuve d'un peu de patience maintenant tout en bossant le contenu

=> https://www.webrankinfo.com/forum/t/page-non-indexee-page-avec-redirection-301.200454/

Discussions similaires

Search Console

Pages signalées en échec d'indexation Google

- Réponses

- 16

- Affichages

- 1K

- Réponses

- 7

- Affichages

- 7K

- Réponses

- 13

- Affichages

- 4K

- Réponses

- 3

- Affichages

- 2K

- Réponses

- 8

- Affichages

- 1K

- Réponses

- 9

- Affichages

- 2K

- Réponses

- 11

- Affichages

- 4K

- Réponses

- 0

- Affichages

- 414

- Réponses

- 15

- Affichages

- 1K

- Réponses

- 2

- Affichages

- 873

- Réponses

- 0

- Affichages

- 579

- Réponses

- 5

- Affichages

- 599

- Réponses

- 1

- Affichages

- 653

- Réponses

- 8

- Affichages

- 3K

- Réponses

- 0

- Affichages

- 2K

- Réponses

- 12

- Affichages

- 7K

- Réponses

- 7

- Affichages

- 4K

Search Console

Impossible de demander une indexation manuelle, état exclut

- Réponses

- 2

- Affichages

- 3K