Quel est le nombre maximum de répertoires pour un bon référencement ?

Article mis à jour le

Faut-il limiter le nombre de niveaux des répertoires à 3 maximum ? Au-delà, Google indexe-t-il les pages moins bien ?

RÉPONSE :

C'est simple : Google ne tient pas compte du nombre de répertoires !

La profondeur d'une page n'a aucun rapport avec son URL, le nombre de slashes (/) ou sa longueur.

En regardant uniquement l'URL, vous ne pouvez pas savoir laquelle de ces URL est la plus profonde :

/hotels/espagne/barcelone/barcelona-universal/hotels/espagne/barcelona-universal/hotels/barcelona-universal

Par contre ce qui compte, c'est la distance d'une page quelconque vers une autre page quelconque, calculée en nombre de liens. Il faut minimiser cette distance (mais la règle des 3 clics ne peut pas s'appliquer à tous les sites...).

Vous devez donc identifier le niveau (profondeur) de chaque page afin de le réduire, surtout pour vos pages les plus stratégiques.

Comment mesure-t-on la profondeur d'une page dans un site ?

La profondeur correspond au nombre de clics nécessaires sur des liens, pour atteindre la page, en partant de la page d'accueil.

Le plus simple est de calculer la profondeur de chaque page du site par rapport à la page d'accueil. Si vous n'avez pas d'outil pour le faire, lancez un audit de votre site avec mon outil RM Tech (testez au moins la version gratuite).

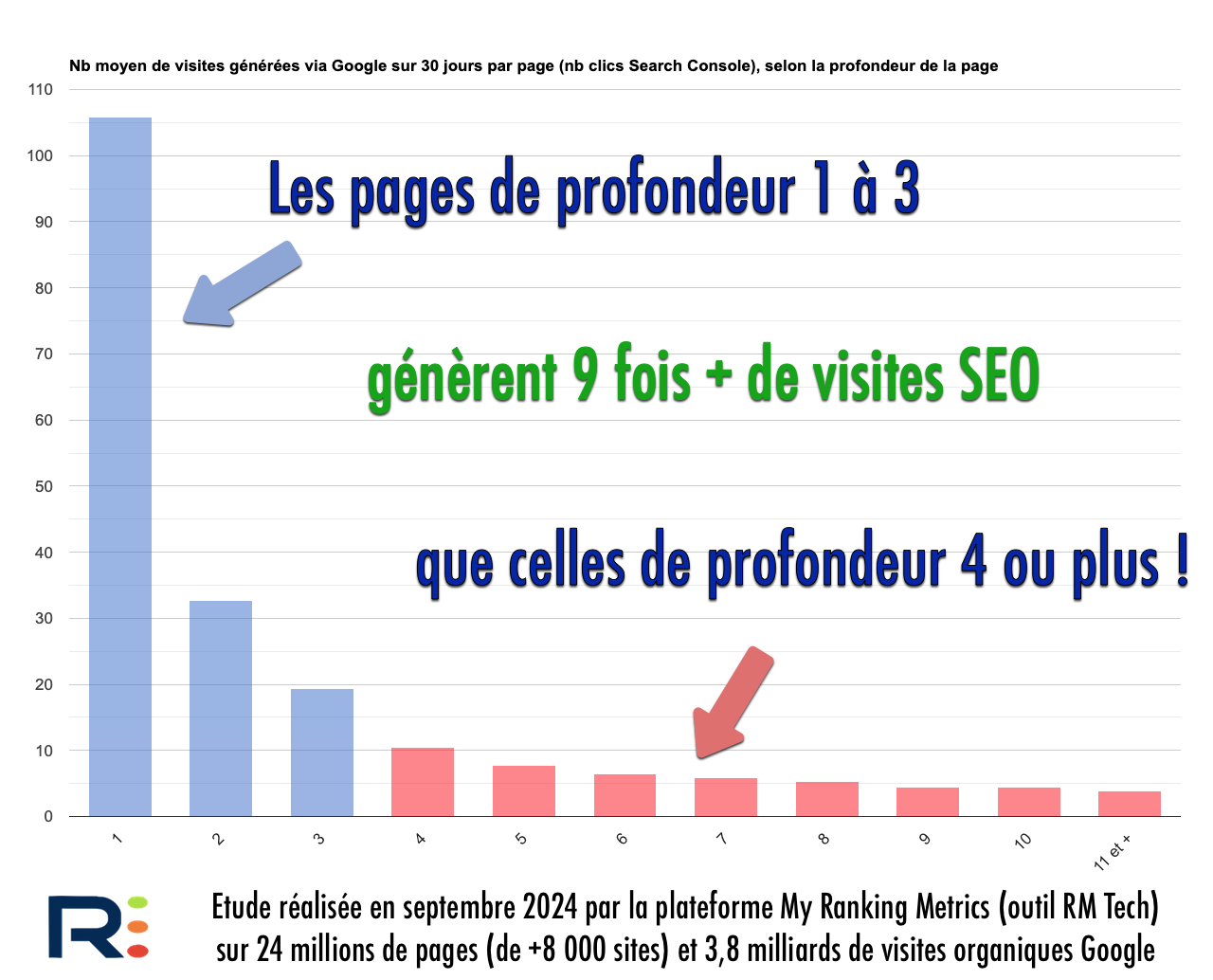

Si vous n'y avez pas fait attention et que votre site est gros (au moins 500 pages), sachez que la profondeur a un impact fort sur les performances SEO. En gros, plus une page est profonde, plus ça diminue ses chances d'être très bien positionnée. C'est un fait très connu, que j'ai pu confirmer par une étude portant sur des millions de pages et des milliards de visites "organic" :

Bonjour, ce phénomène de visites SEO moindre pour les pages profondes est-il seulement lié à la profondeur des pages ? ou faut-il y voir plus simplement un phénomène de longue traîne ? (les pages de longue traîne étant naturellement plus profondes et moins recherchées).

Je ne vois pas bien ce qu'est une "page de longue traîne", vu que la longue traîne c'est ce qui est pas souvent cherché. Peut-être une contenu hyper spécifique ?

A mon avis, la forte corrélation entre profondeur (nb de clics sur des liens) et performance SEO est directement liée au PageRank (encore utilisé par Google rappelons-le). Plus une page est loin d'une page populaire (l'accueil généralement), plus son PageRank est faible et donc ses performances SEO sont difficiles.