Description de l'interface des "actions manuelles"

Avant tout, petite remarque de vocabulaire : Google préfère utiliser l'expression "action manuelle" pour signifier "pénalité... Histoire d'avoir une connotation moins négative ;-)

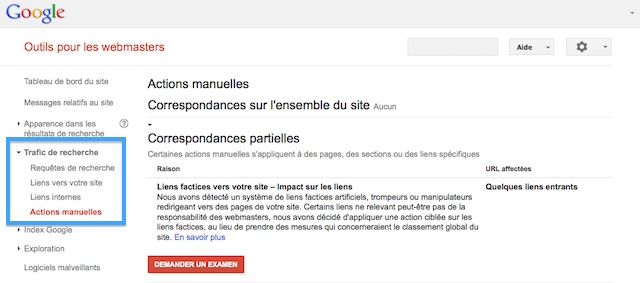

Pour savoir si une action manuelle a été mise en place sur votre site par l'équipe antispam de Google, connectez-vous à votre compte Google Search Console et cliquez sur "Actions manuelles" dans la rubrique "Trafic de recherche".

Si tout va bien pour vous, vous devriez voir le message suivant :

Aucune action manuelle trouvée pour cause de spam sur une page Web.

Sinon, vous verrez 2 sections :

- Correspondances sur l'ensemble du site : il s'agit des pénalités touchant l'ensemble de votre site

- Correspondances partielles : il s'agit des actions manuelles qui s'appliquent à des pages, des sections ou des liens spécifiques de votre site

Cliquez sur chaque section pour déplier la liste des "actions manuelles" concernées. Vous trouverez pour chacune :

- l'intitulé de la raison

- des explications correspondant aux messages traditionnellement envoyés via la messagerie de Google Webmaster Tools

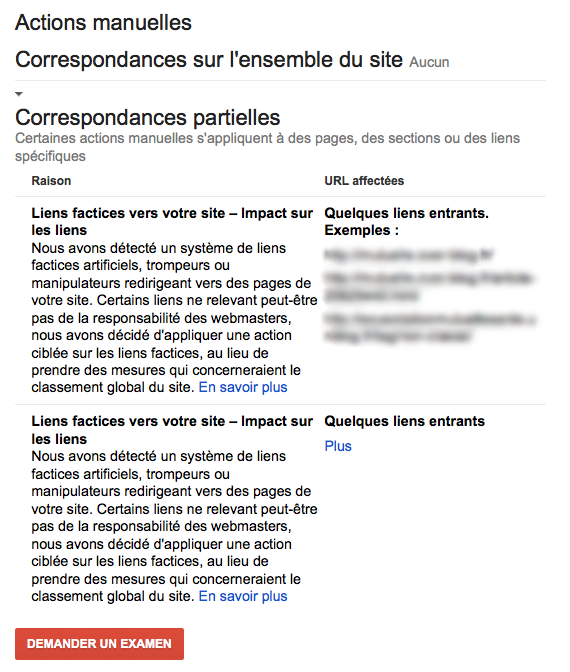

- des indications sur les URL affectées : la plupart du temps, Google indique simplement un message général, par exemple "Quelques liens entrants" sont concernés. Mais parfois, Google donne des détails : par exemple, nous avons enfin des exemples de liens jugés "factices" par Google. Si une action manuelle concerne plus de 1000 URL ou parties du site, seules les 1 000 premières peuvent être répertoriées ici.

Vous trouverez plusieurs exemples plus bas dans cette page...

Un bouton permet de demander un examen de la part de l'équipe antispam de Google. Utilisez-le seulement si vous pensez avoir corrigé le problème ! Selon l'annonce de Matt Cutts, ce bouton mène à un formulaire simplifié de demande de réexamen.

Etre pénalisé sans action manuelle indiquée ?

Un site peut-il être pénalisé par Google sans aucune action manuelle ? On m'a souvent posé cette question et la réponse est "oui". Mais encore faudrait-il définir ce qu'on appelle une pénalité : on pourrait essayer de s'entendre pour définir qu'une pénalité résulte forcément d'une action manuelle de Google, mais qu'une baisse de visibilité Google brutale peut également intervenir de façon algorithmique.

En d'autres termes, si vous avez connu une baisse brutale du trafic Google vers votre site et qu'aucune action manuelle n'est indiquée dans votre compte Google Webmaster Tools, il est fort probable que le problème vienne d'une mise à jour de l'algorithme de Google (Panda ou Penguin pour ne citer que les plus importantes).

Si vous avez besoin d'aide

D'abord, lisez bien mes explications détaillées sur tous les messages envoyés par l'équipe webspam de Google. D'ailleurs, si Google annonce une action manuelle contre votre site, vous devriez déjà avoir reçu un tel message.

Si cela n'est pas assez clair pour vous, demandez de l'aide sur le forum WRI.

Si vous préférez l'analyse d'un professionnel, demandez-moi un devis : audit SEO global ou spécifique, par exemple sur les liens artificiels.

Exemples d'actions manuelles

Ayant accès à plusieurs sites de clients ou de relations, j'ai accès à une petite liste de messages... En voici une sélection.

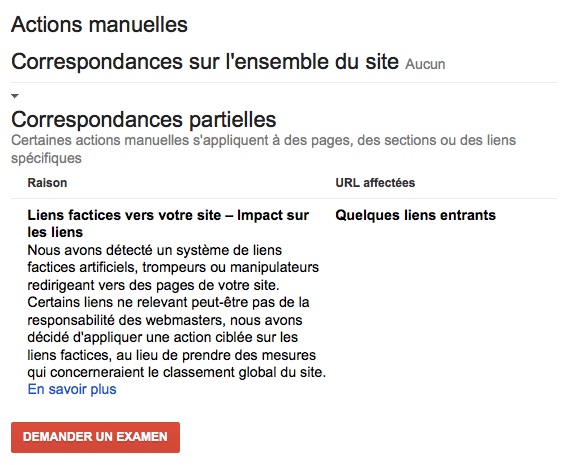

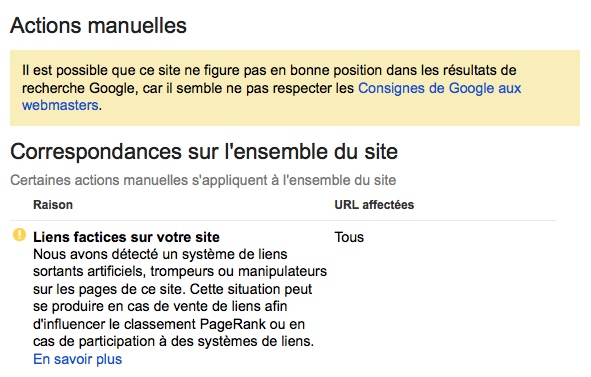

Exemple d'un site ayant des backlinks "factices" selon Google :

Exemple où la pénalité Google touche l'ensemble du site (vous noterez que dans cet exemple Google reproche des liens sortants et non entrants) :

Encore un exemple de problème de liens factices, mais cette fois avec des exemples, comme Matt Cutts l'avait promis :

Liste officielle des pénalités possibles

Voici les 10 pénalités que Google peut vous signifier avoir infligées à votre site :

- Liens artificiels vers votre site avec un impact sur les liens

- Liens artificiels vers votre site

- Liens artificiels sur votre site

- Site piraté

- Contenu peu informatif avec peu ou pas de valeur ajoutée

- Spam agressif

- Spam généré par l'utilisateur

- Techniques de dissimulation (cloaking) et/ou redirections trompeuses

- Texte caché et/ou accumulation de mots clés

- Hébergeurs gratuits associés à du spam

Votre avis

Que pensez-vous de tout ça ? C'est tout de même bien un peu plus de transparence de la part de Google, non ? Bien entendu c'est loin de régler tous les problèmes...

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

J'ai reçu une action manuelle de Google Correspondance partielle : Liens factices vers votre site – Impact sur les liens (Quelques liens)

Cette pénalité à eu lieu seulement un moi après que je créez régulièrement du contenu sur le site (Site ecommerce) Création de page par département et ville avec des liens internes ce redirigeant vers les départements, et la question est : Google ne mais t'il pas un message standard comme Liens factices vers votre site alors que cela pourrait venir des liens internes que je créez maintenant régulièrement depuis un moi ? Si quelqu'un à plus d'infos si une pénalisation pour lien interne existe, Merci

@Alain : non, Google ne confond pas liens entrants et liens sortants, il s'agit de 2 pénalités différentes. Quand Google parle de liens vers votre site, il s'agit de liens venant d'autres sites web. Suivez les conseils donnés sur https://www.webrankinfo.com/dossiers/strategies-de-liens/detection-liens-factices et si vous n'y arrivez pas, contactez-moi pour un audit via https://www.webrankexpert.com/services/

Bonjour,

est ce que l'échange de liens sur des plateformes comme Linkmarket est considéré comme du spamming.

Merci pour vos réponses

Je ne connais pas mais ça m'a l'air créé uniquement à des fins d'optimisation du référencement. Donc a priori risqué vis-à-vis des consignes de Google.

Mon site (locations-de-vacances.fr) a été dégradé en février de position 6 a (déclassé) puis position 120-80-120 (yoyo) mais aucune explication en vue...

Donc finalement, même quand Google devient plus transparent il reste terriblement obscur.

Enfin !! On est en 2013, il aura juste fallu attendre 10 ans pour que google soit un temps soit peu transparent.

Il est toujours pas en ligne je crois, car je l'ai testé ce matin et toujours rien...

La pénalité "Contenu peu informatif avec peu ou pas de valeur ajoutée" est quand même extrêmement limite. Qui juge que le contenu est peu informatif ? Un algorithme ou un humain ? Si c'est un humain, j'espère qu'il parle la même langue que moi et qu'il est de mon pays parce que si sinon, il y a des kilomètres de contenu qui peuvent paraitre inintéressants.

@Christophe : il s'agit ici de pénalités manuelles exclusivement, donc décidées par un humain du département qualité de la recherche chez Google. Tu as reçu ce message ?

Bonjour,

Moi j'avais cette option hier et j'ai pu consulter cette option pour les differents sites existant dans mon Webmaster Tools... Aujourd'hui cette option d'action manuelle n'est plus disposible !

Fady

@ abdou, Patrick, galac et Fady : c'est expliqué dans mon article, à cause d'un bug cet outil est temporairement indisponible

Abdou, pinguin est un filtre ... donc une sanction automatique. On parle ici de sanction manuelle ce qui n'est pas du tout la même chose.

Dans mon interface Google Webmaster Tools, "Actions manuelles" n'apparait pas dans la rubrique "Trafic de recherche" ..

Bonjour,

je viens de regarder mon compte Webmaster Tools et je n'ai pas non plus cette option d'actions manuelles ...

Amicalement

Patrick

pour ma part j'ai pas encore cette rubrique "actions manuelles" alors que je suis belle et bien touché par pinguin

Merci pour l'explication mais maintenant si je me retrouve dans le cas de figue ci-dessus, que faire ?

Bonjour

en effet ça fait du bien d'avoir quelques indices enfin, ça permet de donner une direction aux actions à envisager, car sans cela, on est tenté de tout supprimer ou de ne rien faire, ce qui, dans les deux cas, peut s'avérer catastrophique.

ça c'est TRES intéressant je trouve. Même si je n'ai aucun site touché, au moins je sais que seul mon travail peut faire sortir de vieux sites du fond.