Cet article fait partie des archives de WebRankInfo : certes, il est ancien, mais complet et détaillé pour son époque. Si vous cherchez d'autres informations, faites une recherche sur le site ou participez au forum. Contactez-moi si besoin.

Article mis à jour le 04/10/2012 avec l'ajout des explications en vidéo de Matt Cutts.

En quoi consiste ce changement ?

D'après les explications fournies par Amit Singhal, Google a procédé à une modification de son algorithme de recherche ayant pour objectif de favoriser les pages récentes dans le cas des requêtes nécessitant de la fraîcheur. Il cite 3 types de requêtes concernées :

- Les événements récents et les sujets d'actualité chaude : dans ce cas Google cherche à mettre en avant dans les résultats des pages très récentes, fraîches, datant de quelques minutes

- Les événements récurrents, revenant régulièrement : l'internaute n'aura plus besoin de préciser qu'il cherche des informations actuelles. Par exemple en tapant [élections présidentielles], Google devine qu'il s'agit des élections de 2012.

- Les requêtes qui nécessitent des mises à jour fréquentes car les informations changent souvent. Par exemple des recherches d'avis sur des produits.

Cette recherche de pages web toujours plus récentes est la suite logique de la mise à jour Caffeine de Juin 2010 : si Caffeine était un changement d'infrastructure technique ("seulement"), cette mise à jour est un changement algorithmique qui exploite les possibilités techniques de Caffeine.

35% des recherches seraient concernées

Amit Singhal précise qu'environ 35% des recherches sont impactées par cet algorithme. J'ai lu plusieurs articles dans lesquels l'auteur s'inquiète du fait que ce pourcentage est très élevé, 3 à 4 fois plus important que pour Google Panda. Quand on sait les dégâts causés à certains sites par Panda, ça parait logique en effet d'être préoccupé.

Mais quand on creuse et qu'on se renseigne, on apprend que jusqu'à présent environ 17% des requêtes étaient déjà concernées par l'algorithme Query Deserved Freshness (QDF). Sorti en 2007, ce dernier avait déjà pour but de booster la visibilité des pages récentes pour les requêtes qui nécessitent de la fraîcheur.

Mais d'ailleurs, il faut bien lire la déclaration officielle : "[this update] impacts roughly 35 percent of searches". Il s'agirait donc des recherches et non des requêtes distinctes. Si certaines requêtes très populaires sont dans l'actualité très récente, ça change beaucoup les choses !

On connait aussi depuis encore plus longtemps la fameuse prime de fraîcheur qui favorise temporairement les pages quelques temps après leur mise en ligne (et découverte par Google).

Conclusion : 35% est une valeur très élevée, mais il ne faut pas la comparer aux 12% associés à la sortie de Panda 1.0 aux USA...

Comment Google peut-il détecter les requêtes "fraîches" et tenir compte de l'ancienneté des documents ?

Google n'explique pas grand chose : comment Google choisit qu'une requête nécessite des résultats très frais ? Comment Google sélectionne les pages qui doivent bénéficier d'une prime de fraicheur ? Parmi les problèmes à gérer : ces pages récentes n'ont pas encore de backlinks, ou très peu, ou pas encore détectés par Google. Dans ces cas-là, Google doit donc utiliser d'autres critères, peut-être des critères sociaux (User Rank, User Authority).

J'ai trouvé intéressantes les idées de Justin Briggs. En voici quelques éléments...

Détection des requêtes nécessitant des résultats récents

Si le nombre d'internautes effectuant des requêtes avec une expression donnée augmente rapidement, alors il y a des chances que cette requête soit liée à une actualité ou à une demande récente des utilisateurs. Il faut alors tenter de fournir des résultats plus récents que d'habitude.

Ancienneté d'une page et impact sur le positionnement

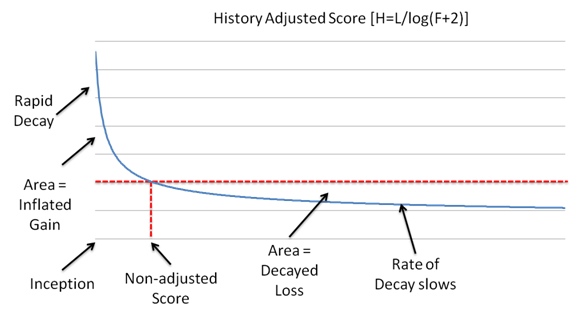

Google analyse la date de naissance d'une page (ou de n'importe quel document indexé), la fameuse inception date. Il y aurait plusieurs façons de la déterminer, mais on peut considérer qu'il s'agit de la date (le jour et l'heure précise) de la première découverte de la page par le crawler. Connaissant cette date et celle de la requête faite par l'internaute, Google peut calculer pour chaque requête l'âge précis des pages de son index. Si la requête nécessite des résultats récents, alors le critère âge de la page web sera amplifié pour favoriser les pages récentes. Si l'on se réfère au brevet Document Scoring Based on Document Inception Date (attribué à Google), on découvre cette formule :

H = L / log (F + 2)

- H est la valeur du boost d'un document basé sur son âge (attention, au début il est positif, ensuite il passe négatif)

- L est un score de popularité classique basé sur les liens vers le document

- F est l'âge du site (au moment de la requête)

Pour reprendre le graphique d'illustration de Justin :

Cette courbe illustre le fait que tant que le document est récent, il est favorisé, mais ensuite quand il devient trop ancien, il est au contraire pénalisé.

L'impact des réseaux sociaux

Ce n'est pas la première fois (ni la dernière !) qu'on remarque que les réseaux sociaux ont un impact sur le référencement naturel. Dans le cas qui nous intéresse cette fois, il est évident que les événements très récents sont bien plus faciles à trouver d'abord sur des réseaux sociaux (comme Twitter ou Facebook et Google+), plutôt que sur les moteurs généralistes comme Google. D'ailleurs, pour l'instant (8 novembre 2011) Google n'a pas signé de nouvel accord avec Twitter pour rétablir l'indexation temps réel des tweets, l'empêchant de remettre en ligne la recherche temps réel.

En attendant, Google peut tenir compte du fait qu'une page web est souvent citée ou partagée sur les réseaux sociaux.

Utilisation des algorithmes de WOWD

Bill Slawski se demande si Google ne pourrait pas également utiliser les algorithmes de WOWD (dont Google a racheté un brevet en octobre 2011). Le principe est de proposer aux internautes qui le souhaitent d'installer un plugin dans leur navigateur pour recommander des pages. En analysant les remontées de ces utilisateurs, le système peut déterminer des pages qui ont été fortement recommandées récemment. A priori Google n'a pas encore utilisé ce système.

Comment optimiser son site pour ce Fresh Update ?

Bien évidemment, cette mise à jour va inciter les webmasters à produire plus de contenus, plus souvent. Je sens que les rédacteurs web ne vont pas chômer ! Déjà depuis l'arrivée de Panda, ils sont certainement plus sollicités qu'avant, je pense que ça va continuer. C'est ce que je pronostique depuis 2010 dans mes formations Rédaction Web et SEO. Espérons néanmoins que ça ne mène pas à du spam de contenus frais ! Vous pouvez bien entendu aussi permettre à d'autres de publier sur votre site, en ouvrant des blogs ou forums pour vos utilisateurs.

A part créer des nouveaux contenus, vous pouvez aussi mettre à jour vos anciens contenus : c'est ce que j'essaie de faire régulièrement sur WebRankInfo, pour maintenir les informations à jour. C'est très difficile mais utile pour l'internaute. D'ailleurs si vous repérez des contenus dépassés sur ce site, n'hésitez pas à me les signaler (par un commentaire).

Malheureusement, Google aurait indiqué à SearchEngineLand que les pages mises à jour ne sont pas favorisées par ce nouvel algo : Google se baserait uniquement sur la date de première découverte de la page par le crawler.

Pour favoriser le crawl de vos pages récemment publiées, n'oubliez pas d'utiliser une ou plusieurs de ces techniques :

- flux RSS (et protocole Pubsubhubbub)

- sitemaps listant les dernières pages mises en ligne ou fortement mises à jour

- partages sur Twitter, Facebook, Google+ et tous les autres réseaux sociaux

Votre avis sur la mise à jour "Fraîcheur Google"

Que pensez-vous de cette évolution de Google ? Est-ce une bonne idée d'un point de vue internaute ? En tant que webmaster ou référenceur, avez-vous déjà noté un impact sur votre site ? Comment comptez-vous modifier votre méthodologie de référencement naturel suite à cela ?

Vidéo d'explication par Matt Cutts

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

L'idée n'est pas forcément mauvaise d'après moi mais c'est par contre complètement stupide de ne pas tenir compte de l'évolution d'une même page, inutile d'en créer une nouvelle à chaque une information s'ajoute !

De même j'espère que ça ne touche pas les requêtes qui ne doivent à priori pas être trop sensibles au temps. Comme le disait un commentaire, inutile de savoir si une recette date de 1 jour ou de 15 ans a priori ça ne change pas grand chose...

Bon je réagis avec un peu de retard mais peut-être que ça ajoutera du contenu frais à cette page au moins :)

En tout cas je remarque que google a pénalisé ses propres sites (fraicheur ou autre algo?)

Avant quand je cherchais une fonction sur google analytics ... j'avais en première page de google.fr que des résultats google dupliqués (support.google.com, fr.google.com/support...) avec exactement le même contenu.

aujourd'hui je ne retrouve plus ce genre de résultats.

Pensez vous que google applique manuellement des filtres à ses propres services ou est-ce vraiment automatique ?

IL est évident que afficher du contenu nouveau quotidiennement est favorable à un bon référencement.

Désormais, avec une section "news" ou "blog" sur son site internet que ce soit marchand ou vitrine est indispensable.

Le netlinking dérivant de ce genre de structure est vraiment apprécié du moteur de recherche.

Pour la disparition des pages ds le top 10 par contre, c'est encore pas pour tout de suite hélas, google n'a pas intérêt à trop sanctionner ses fidèles..

Bonne continuation.

Effectivement, je pense que ça concerne que les sites qui font de l'actualité. Je doute qu'il y ai un impact sur les e-commerce ou sur de simples sites vitrines. Enfin quoi que... j'ai gagné 6 places depuis le début de la semaine :)

C'est ce que je disais ce matin dans : l'article Google lance Panda 20, version importante avec changement d'algo

@moi « Faire une mise à jour journalière, liens, articles, partage... »

Ils ont annoncé cela le 3, mais depuis quelques jours voir une bonne semaine, je me suis aperçu que la fraîcheur de certaines pages était beaucoup plus présente, et aussi sur des pages beaucoup plus vieilles.

À suivre.

Si je comprends, nous aurons besoin d'afficher chaque jour de contenu pour bien se positionner...mais comment Google peut distingué le mot clé le plus récent est ce qu'on fonctionne au nombre des utilisateurs qui tapent ce mot en temps réel ou autre chose...enfin Google reste qu'une machine, et la machine a besoin toujours d'entretiens...

Suis d'accord avec Manu et beaucoup d'entre vous. Google est maitre en France. Mais faire passer l'actualité en tête ???????????????

Je pense que l'internaute qui veut de l'actualité sur tel ou tel sujet doit taper son sujet suivi de "actualité". Il faut procéder par ordre. De plus sur certains mots "générique" GG ne présente que de l'actualité et des pub youtube. Je ne vois pas l'interêt de l'internaute.

Je serais étonné que les mises à jour ne soient pas prises en compte.

C'est illogique, cela revient à dire que toutes les pages style rubriques ou catégories ne ressortiront plus.

Prenons l'exemple de la catégorie football de l'équipe.fr. Cette page est mise à jour plusieurs fois par jour avec des actualités fraiches.

Google raisonne toujours par la logique. Je vois mal ce genre de pages disparaitre des premières positions.

Yoann, je n'ai pas encore pu vérifier ce que Google a dit à SearchEngineLand, à savoir que les pages mises à jour n'ont pas la prime de fraicheur qu'ont les nouvelles pages...

Que Google ne prenne pas la MAJ des pages c'est vraiment dommage, c'est un bel effort de la part des webmestres pour les internautes...

Il y aura plusieurs façons de faire soit comme sur commentcamarche (pour les tutos)ou développez.com (pour les cours) segmenter les paragraphes avec un lien suivant et un index (pour ceux qui veulent rester pro visiteur), ceux qui ne pensent qu'au réf et vont segmenter l'article avec dans le titre (part1, part2, etc..) et les BH qui vont faire un cloaking vers un index sauf pour GG.

Pour l'utilisateur , je trouve que c'est un plus (du moins en théorie), mais en concret pour les webmaster et référenceur ça va être une sacré pagaille comme le pense beaucoup de monde, cela va être la fête à l'article publié en 10 fois pour avoir un contenu régulier.

Sauf que celui qui s'amuse à publier un article en 10 bouts (pour profiter de l'effet fraicheur) recevra sans doute très peu de backlinks (spontanés), en tout cas beaucoup moins que s'il avait publié tout en une seule page, comme le fait par exemple Wikipédia...

Les pages sont notés maintenant aussi en fonction de la fréquence de mise à jour pondérée par la surface de la page réellement mise à jour, ainsi plus la surface changée dans un blog est petite plus la fréquence de ces changements doit être élevée, les changements de type code ( javascript, alt, title, etc... ) sont pondérés aussi différemment. L'accélération des changements serait aussi tracée.

Quelle est ta source d'information ? A ma connaissance il ne s'agit que d'hypothèses.

D'après une étude de seomoz publié en 2009, la prime de fraicheur était déjà un facteur très important (deuxième après le fait que le contenu sois unique et original).

Maintenant le contenu unique et original sera indispensable (il l'est déjà) mais en plus il va falloir que la page mise en ligne soit régulièrement mise à jour ...

Non, apparemment (d'après les infos de SEL, voir mon article) les modifications d'une ancienne page ne suffisent pas. La prime de fraîcheur concernerait uniquement les nouvelles pages...

L'idée d'afficher les pages plus récentes d'abord, me paraît bonne. En effet que de plus inutile quand on cherche à un avis ou information actuelle que de trouver au poste nº 1 de GG, une page datant de 2001 ou avant ...

Cependant, comme d'autres l'ont dit, cela peut induire des effets néfastes, tels que la course à la prolifération de contenu frais mais rébarbatif et d'autre part l'enfouissement de pages informationnelles qui se modifient peu, par exemple: description d'un appartement de vacances, déclaration de mission d'une société. mais qui restent cependant utiles et actuelles.

"En même temps, mettre du contenu à jour n'a pas vocation à attirer des visiteurs via Google. Je ne vois pas pourquoi ca le serait d'ailleurs. Pour attirer des visiteurs sur un ancien dossier, il faut les prévenir de ce changement."

@Finstreet: Pas forcement d'accord car quand un contenu évolue avec le temps, par exemple des idées pour améliorer la recette du clafouti (utiliser un moule en silicone par ex ou rajouter un ingrédient), je ne vois pas pourquoi le contenu serait moins avantagé car il s'agit d'informations utiles et pertinentes et ce serai dommage qu'un moteur de recherche s'en prive.

Faut pas s'inquiéter, adwords ne prend pas en compte ces changements seulement il faut payer... Google tue le référencement à petit feu, en tout cas ça en prend la route

"Google fais ce qu'il veux, quand il veux, comme il le veux... et je vois pas trop ce qu'on peux faire."

@Jonathan: Peut-être moins suivre leur logique et moins utiliser leur service, puis se réunir.

Le web est un métier, je ne comprends pas qu'il n'y ait pas de syndicat ou de groupement sérieux à ce jour comme le font bon nombre de professions.

C'est pour moi la seule façon de se faire entendre ou du moins se faire respecter.

Donc si on prend google à la lettre qu'est ce qui empêchera les webmasters de republier du contenu déjà publié afin de changer de date de découverte? Techniquement c'est très simple à faire, un 301 de l'ancien article sur la homepage et ensuite l'ancien article devient nouveau avec une belle url que Google découvrira lors de son crawl. C'est le risque principal de cette annonce je trouve, qu'en pensez vous?

"Par contre les petits qui bossent le + et qui finalement sont la base du web ne pourront même pas mettre à jour leur contenu pour faire connaître leur site"

En même temps, mettre du contenu à jour n'a pas vocation à attirer des visiteurs via Google. Je ne vois pas pourquoi ca le serait d'ailleurs. Pour attirer des visiteurs sur un ancien dossier, il faut les prévenir de ce changement.

En même temps, quand je tape clafoutis, c'est pour avoir des recettes de clafoutis. Je me fous de savoir que la recette a été mise en ligne (et non inventée) y'a 24h. L'idée est bonne mais certains vont encore détourner tout cela. Perso ca va m'inciter à remettre à jour mes fiches mais en aucun cas à les changer d'adresses. Si Google ne fait pas la différence entre de fausses nouvelles pages, et de vraies mises à jour, c'est la faute du moteur.

@Manu: je partage à 100% ton ressenti mais je pense que tu te trompe. Google ne perdra jamais le soutien des webmasters, si certains s'en vont d'autres se feront un plaisir de s'y installé pour gagner des €€€.

Regarde le SAV des émissions d'Omar & Fred, ça illustre parfaitement:

- Fred: c'est la journée des anti-pollution aujourd'hui ?

- Omar: oui c'est ça, chacun évite de prendre sa voiture pendant un jour

- Fred: haha, ça fera plus de place sur l'autoroute !!!

Google fais ce qu'il veux, quand il veux, comme il le veux... et je vois pas trop ce qu'on peux faire.

Oui mais Wiki aura bien sur un traitement de faveur !

Par contre les petits qui bossent le + et qui finalement sont la base du web ne pourront même pas mettre à jour leur contenu pour faire connaître leur site, même si il a de l'intérêt et des commentaires...

Comment contrôler le monde en 2 leçons, pff c'est vraiment énervant de devoir subir ces trusts, on a pas besoin d'eux pour exister et développer nos sites.

En parlant de ferme, Google me fait penser à ce que font certaines entreprises envers les agriculteurs ou autres.

Il stockent le blé (là les pages), n'en distribue qu'une partie (Panda) au prix d'affamer des populations et font monter les cours (Adwords et l'intérêt pour les services Google). C'est très américains finalement. Il ne faut pas laisser passer ça !

Malheuresement il n'y a aucun syndicat ou contrepoids pour les webmasters donc ils se permettent ce qu'ils veulent. Nous ne sommes même pas consultés.

Google a profité des critiques avant Panda pour nous la faire à l'envers et en tirer tous les avantages donc cet algorithme de fraîcheur c'est encore pour brider, ça n'a aucune logique, ils prétendent lutter contre les fermes, ça va vers l'inverse. Il y a quelques choses qui ne collent pas !

Faut voir si c'est 35% de requêtes en terme de 35% des mots clés, ou en terme de volume (p.ex peu de mots clés concernés mais très populaires) Dans le dernier cas ça peut être une niche, les sites qui ont des mots-clés dans le zeitgeist seront plus concernés que les autres.

Parce que je ne vois pas trop l'intérêt de republier les dossiers de WRI, par exemple, alors que même ceux qui ne datent pas d'hier sont encore parfaitement d'actualité. Ça n'aurait pas de sens. Pareil pour Wikipedia. Tandis que si ça concerne Lady Gaga, les élections, un tremblement de terre, etc, c'est effectivement justifié.

Donc Wikipedia va perdre pas mal de requêtes car les pages datent toutes de plusieurs années, et vu que les mises à jour comptent pas :)

On va suivre ça avec attention, ça ne ferait pas de mal de voir Wiki baisser un peu, non ?

Très bon article effectivement, qui aide à bien comprendre le mécanisme de ce nouvel algorithme sans tomber dans une panique ou une paranoïa excessive.

Pfff cela va aboutir à des créations de contenu inutile en masse, c'était bien mieux avant panda !

En plus si l'update des contenus n'est même pas pris en compte, ça sert plus a rien de travailler sur le référencement d'une page !

La formula algorithmique montre bien comme le dit justement olivier

Pour infos, j'ai perdu 1/3 voire quasi 2/3 des visiteurs de mon site en - de 2 ans (je parle sur des pages de contenu, pas des mots clefs).

De toute manière, on ne trouve rien sur Google quand on cherche qqch de précis en ce moment. Les stats montrent que l'on reçoit de plus en plus de requêtes avec tout signes du style + "" etc... qui veut bien dire que les gens ne trouvent pas vraiment ce qu'ils cherchent et qu'il essaient d'utiliser des artifices pour trouver. Maintenant elles vont "not provided" pour cacher la misère !

Vous trouvez légal et constitutionnel de ne même pas savoir d'où viennent les visiteurs de votre site alors que c'est vous qui bossez dessus ? C'est quoi ce délire ! Il se prennet pour qui, pour dieux le père ?

Google bride le marché et essaye de vendre du Adwords, toute la politique de l'entreprise est basée là dessus en ce moment, et oui c'est la crise ! Enfin pas pour tous le monde !

Si Google continue ainsi il va perdre son soutien principal, à savoir les webmasters et le premier concurrents fiable qui passera par là récupérera l'intérêt.

Toute façon ça ne change pas, Google a fait comme plein d'entreprises, ils sont loin d'être novateur... maintenant qu'ils ont moins besoin des webmasters pour doper leurs services ils les escroquent en leur faisant croire implicitement en + que c'est eux qui travaillent mal !

En tout cas tout va dans ce sens en ce moment, c'est du grand n'importe quoi, toute façon il ne l'emporteront pas, c'est certain.

Très bon article, merci Olivier.

Pour répondre à Benoit dans un commentaire plus haut, les sites d'autorité (je travaille pour l'un d'entre eux) sont aussi très inquiets de l'impact de cette nouvelle update, car les gros sites n'ont pas forcément les moyens pour produire X nouveaux contenus par jour, même si il est vrai, toujours un peu plus que les petits/moyens sites. Google une fois de plus jette un pavé dans la mare, reste à savoir comment la vague va tomber sur nous

C'est plus que certain que cet algorithme va relancer le système de "fermes de contenu". Les puissants vont écrire des tonnes d'articles pour bénéficier de cette prime de fraicheur. Je trouve que cet algo fait un croche-pied au Panda.

Personnellement, j'arrive à écrire 1 à 2 articles pour mon site généraliste, je ne vois pas comment je vais pouvoir lutter contre les gros producteurs de contenus. L'avenir est assez sombre pour les petits.

Bonjour Olivier et merci pour ce compte rendu précis et très instructif. Pour le coup, voilà une mise à jour qui me parait extrêmement sensée. Reste que cela risque d'accroître encore un peu plus les inégalités entre les sites bien installés et les petits nouveaux puisque si je comprends bien, 35% des requêtes pointeront désormais uniquement vers les sites avec "autorité".

mais du coup, ça concerne surtout les gros sites de publication en ligne ? je vois mal mes boutique produire du contenu frais toutes les heures... et encore quand on dit heure à mon avis, il faudrait en créer en permanence sur des sujets divers et variés mais qui suscite l'intérêt de l'internaute...