Nouveau WRInaute

Bonjour à tous,

je me renseigne depuis plusieurs jours sur les attaques negative seo car mon site en subit une.

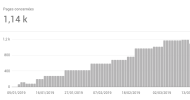

Des milliers de domaines différents (us, ru, ch...) duppliquent des articles que j'ai écrit, les font pointer vers des url inconnues sur mon site, ce qui crée des 404.

Conséquence : Google m'a immédiatement blacklisté : je ne suis plus présent sur les résultats...

J'ai identifié les domaines grâce à semrush et j'ai tout listé dans un .txt pour l'envoyer à Google et désavouer les liens :

https://www.google.com/webmasters/tools/disavow-links-main?hl=fr

Mais concrètement, que faire ? Quelqu'un a-t-il déjà subit ce genre d'attaques ?

Les 404 générées en masse sont du genre :

domaine.com/nom-article/amp/tireàlacon

Mon site gêne énormément la concurrence c'est une évidence.

Merci pour vos éventuels conseils.

je me renseigne depuis plusieurs jours sur les attaques negative seo car mon site en subit une.

Des milliers de domaines différents (us, ru, ch...) duppliquent des articles que j'ai écrit, les font pointer vers des url inconnues sur mon site, ce qui crée des 404.

Conséquence : Google m'a immédiatement blacklisté : je ne suis plus présent sur les résultats...

J'ai identifié les domaines grâce à semrush et j'ai tout listé dans un .txt pour l'envoyer à Google et désavouer les liens :

https://www.google.com/webmasters/tools/disavow-links-main?hl=fr

Mais concrètement, que faire ? Quelqu'un a-t-il déjà subit ce genre d'attaques ?

Les 404 générées en masse sont du genre :

domaine.com/nom-article/amp/tireàlacon

Mon site gêne énormément la concurrence c'est une évidence.

Merci pour vos éventuels conseils.