Bonjour,

Je me permets de venir à votre rencontre suite à un problème avec le SEO d'un site et j'ai aucune idée de comment régler ça. (malgré plusieurs recherches)

Je vais détailler le problème en 5 points. (histoire d'essayer de vous rendre la lecture buvable)

1. L'histoire du site

J'ai un site qui tourne depuis plusieurs années grâce à 2 articles. Il réalisait environ 10 à 20 visites / jours mais était à l'abandon.

J'ai décidé récemment de refaire le site, et de le positionner sur certains mots clés.

2. Les conséquences de la refonte

Dès la refonte effectuée, j'ai plusieurs pages qui se sont positionnés dans le top 5.

2-3 jours après, j'ai constaté une disparition totale des nouvelles pages sur les mots clés spécifiques.

Quelques jours après, les 2 articles positionnés depuis plusieurs années top 0 à 3 sur des mots clés ont eux aussi disparu totalement des SERPs.

Résultat : plus aucune page positionnée sur mes mots clés. En revanche, en faisant site:monsite.com, les pages sont toujours indexées (+ la GSC qui m'indique aussi la même chose)

3. Qu'est ce qui a été fait sur le site ?

En ce qui concerne le contenu :

- Pas beaucoup de contenu, placé sur des requêtes faciles/moyennes à positionner d'après semrush, des articles optimisés SEO, mais certains le son moins du fait qu'il générait un peu de trafic avant la refonte et que je me suis dis "je les réoptimiserai plus tard mais je veux les garder pour l'instant".

On a 8 articles, et 11 pages actuellement

- Des anciens articles avec 0 clics et peu d'impressions ont été supprimés et redigérés via une 301 vers :

- soit des articles similaires à l'ancien,

- soit vers des pages "hub" du genre /actualites/

En ce qui concerne la technique du site :

- Un score moyen mobile et ordi à 90/100

- Les images en webp et optimisées

- blablabla le travail nécessaire pour rendre un site rapide au yeux des moteurs de recherche

Le site est plutôt rapide à s'afficher et à naviguer.

En ce qui concerne la popularité :

- Rien du tout (bouuuh)

- D'après Semrush, on est à 6 en DA

Pour le site : elkear.com

4. Mon analyse perso + que dit la belle GSC

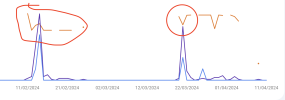

Dès la refonte, on constate une augmentation des impressions et des apparitions dans Discover.

Dès la disparition des pages sur les MCs, une diminution des impressions et 0 clics.

En expérience, on est dans le vert, pas de problème à signaler. Robots.txt valide, sitemap aussi...

Le problème se gatte dans les statistiques d'explorations. On s'aperçoit :

- Une augmentation du temps de réponse moyen

- l'état de l'hôte qui détecte un problème la semaine dernière

- La connectivité du serveur avec un taux d'échec élevé (+/- 33%)

En creusant plus, je remarque que dans les détails de l'exploration ou sont affichés les pages en 200/3XX/4XX.. j'ai une ligne "impossible d'accéder à la page" avec des temps de réponse moyen à 50 000ms depuis la refonte. En revanche, toutes les pages présentes dans la liste sont accessibles (en 404 mais accessible), malgré ce qu'indique les robots.

J'ai aussi mon domaine racine en non sécurisé qui s'affiche. (http://monsite.com sans le S à http) Pourtant, mon domaine racine redirige bien vers le https.

5. Ce que j'en pense

- Soit le problème de pertes des positions vient du fait que la refonte est récente, et je dois juste attendre un peu : mais ça reste bizarre de perdre toutes les positions d'un coup même si le site n'avait déjà pas beaucoup de page ni d'autorité à l'origine, sachant qu'il se positionnait sur mes nouveaux articles/pages juste après la refonte du site.

- Soit le problème vient du temps de réponse moyen, et j'ai aucune idée de comment résoudre ça.

- Soit je suis à côté de la plaque et ça a rien à voir avec tout ça.

Qu'en pensez-vous ?

J'espère que mon problème trouvera preneur. Désolé pour le pavé. Je suis disponible si vous avez besoin de plus d'info!

Tristan.

Je me permets de venir à votre rencontre suite à un problème avec le SEO d'un site et j'ai aucune idée de comment régler ça. (malgré plusieurs recherches)

Je vais détailler le problème en 5 points. (histoire d'essayer de vous rendre la lecture buvable)

1. L'histoire du site

J'ai un site qui tourne depuis plusieurs années grâce à 2 articles. Il réalisait environ 10 à 20 visites / jours mais était à l'abandon.

J'ai décidé récemment de refaire le site, et de le positionner sur certains mots clés.

2. Les conséquences de la refonte

Dès la refonte effectuée, j'ai plusieurs pages qui se sont positionnés dans le top 5.

2-3 jours après, j'ai constaté une disparition totale des nouvelles pages sur les mots clés spécifiques.

Quelques jours après, les 2 articles positionnés depuis plusieurs années top 0 à 3 sur des mots clés ont eux aussi disparu totalement des SERPs.

Résultat : plus aucune page positionnée sur mes mots clés. En revanche, en faisant site:monsite.com, les pages sont toujours indexées (+ la GSC qui m'indique aussi la même chose)

3. Qu'est ce qui a été fait sur le site ?

En ce qui concerne le contenu :

- Pas beaucoup de contenu, placé sur des requêtes faciles/moyennes à positionner d'après semrush, des articles optimisés SEO, mais certains le son moins du fait qu'il générait un peu de trafic avant la refonte et que je me suis dis "je les réoptimiserai plus tard mais je veux les garder pour l'instant".

On a 8 articles, et 11 pages actuellement

- Des anciens articles avec 0 clics et peu d'impressions ont été supprimés et redigérés via une 301 vers :

- soit des articles similaires à l'ancien,

- soit vers des pages "hub" du genre /actualites/

En ce qui concerne la technique du site :

- Un score moyen mobile et ordi à 90/100

- Les images en webp et optimisées

- blablabla le travail nécessaire pour rendre un site rapide au yeux des moteurs de recherche

Le site est plutôt rapide à s'afficher et à naviguer.

En ce qui concerne la popularité :

- Rien du tout (bouuuh)

- D'après Semrush, on est à 6 en DA

Pour le site : elkear.com

4. Mon analyse perso + que dit la belle GSC

Dès la refonte, on constate une augmentation des impressions et des apparitions dans Discover.

Dès la disparition des pages sur les MCs, une diminution des impressions et 0 clics.

En expérience, on est dans le vert, pas de problème à signaler. Robots.txt valide, sitemap aussi...

Le problème se gatte dans les statistiques d'explorations. On s'aperçoit :

- Une augmentation du temps de réponse moyen

- l'état de l'hôte qui détecte un problème la semaine dernière

- La connectivité du serveur avec un taux d'échec élevé (+/- 33%)

En creusant plus, je remarque que dans les détails de l'exploration ou sont affichés les pages en 200/3XX/4XX.. j'ai une ligne "impossible d'accéder à la page" avec des temps de réponse moyen à 50 000ms depuis la refonte. En revanche, toutes les pages présentes dans la liste sont accessibles (en 404 mais accessible), malgré ce qu'indique les robots.

J'ai aussi mon domaine racine en non sécurisé qui s'affiche. (http://monsite.com sans le S à http) Pourtant, mon domaine racine redirige bien vers le https.

5. Ce que j'en pense

- Soit le problème de pertes des positions vient du fait que la refonte est récente, et je dois juste attendre un peu : mais ça reste bizarre de perdre toutes les positions d'un coup même si le site n'avait déjà pas beaucoup de page ni d'autorité à l'origine, sachant qu'il se positionnait sur mes nouveaux articles/pages juste après la refonte du site.

- Soit le problème vient du temps de réponse moyen, et j'ai aucune idée de comment résoudre ça.

- Soit je suis à côté de la plaque et ça a rien à voir avec tout ça.

Qu'en pensez-vous ?

J'espère que mon problème trouvera preneur. Désolé pour le pavé. Je suis disponible si vous avez besoin de plus d'info!

Tristan.

Dernière édition: