Il y a de nombreux cas de figure et ce tuto les décrit a priori tous. Si vous êtes dans un cas particulier non listé, n'hésite pas à me l'indiquer ! Et si vous ne vous en sortez pas tout seul, contactez-moi pour du consulting.

Pourquoi faut-il parfois désindexer des pages ?

Il y a plusieurs situations :

- vous n'aviez pas réalisé que certaines pages étaient indexées - et ce n'était pas prévu

- certaines pages créent du contenu dupliqué interne et vous souhaitez vous en débarrasser

- vous estimez que des pages (de faible qualité) vous font prendre trop de risques avec l'algorithme de Google (ou même avec l'équipe qualité de la recherche si elle venait à passer par là) et vous souhaitez donc les supprimer de Google

- une ou plusieurs pages vous posent des problèmes juridiques et vous devez les retirer au plus vite de votre site et de Google

- votre site a subi un piratage

- etc.

Si vous êtes déjà venu à ma formation, vous savez que je décris le concept de masse noire (des pages que Google crawle et parfois indexe et qui ne devraient pas l'être). Si la part de la masse noire devient trop importante sur votre site, il est grand temps de faire le ménage !

A voir aussi : comment supprimer son historique de recherche sur Google ?

Quelle différence entre page indexable et page indexée ?

Une page indexable est une page qui respecte toutes les conditions techniques pour qu'elle soit indexée.

Une page indexée est une page que Google a crawlée et "décidé" d'ajouter à son index (il arrive que Google crawle une page indexable et ne l'indexe pas malgré tout).

Je rappelle que pour être indexable, une page doit évidemment être "crawlable" !

Une page crawlable est une page autorisée au crawl : en clair, non bloquée dans le fichier robots.txt même s'il existe un cas particulier que j'expose plus loin. Elle doit également être accessible (à Google) et d'un format pris en charge.

A l'inverse, une page non-indexable est une page pour laquelle on indique à Google qu'il ne doit pas l'indexer.

Comme vous l'avez deviné, pour désindexer une page de Google, vous devez suivre 2 étapes :

- la rendre non-indexable pour Google

- puis la désindexer

Je détaille ces 2 étapes ci-après, ainsi que des situations spéciales (désindexer tout un site, désindexer tout un sous-domaine).

Comment rendre une page non-indexable ?

La première question à vous poser est sans doute la suivante : la page que vous souhaitez désindexer doit-elle rester consultable par les internautes ?

Comment désindexer une page toujours accessible aux internautes ?

Dans ce cas de figure, vous devez choisir parmi ces solutions (les liens donnent les détails si besoin) :

- ajouter une balise meta robots noindex (ou none) permet d'indiquer aux moteurs que vous ne souhaitez pas qu'elle soit indexée. Si jamais elle est actuellement indexée, elle sera désindexée quand Google détectera cette balise dans la page ; si elle n'est pas encore indexée, alors elle ne le sera pas non plus à l'avenir (il s'agit donc de prévention)

- envoyer un entête HTTP spécial (X-Robots-Tag) : c'est la même idée que la balise meta robots noindex. Elle s'impose quand le document à désindexer n'est pas une page HTML, car dans ce cas vous ne pouvez pas ajouter de balises meta (PDF, documents Word ou Excel, etc.).

- définir une URL canonique différente de l'URL de la page à désindexer. Par exemple, une fiche produit est accessible aussi bien à l'URL A qu'à l'URL temporaire B pour cause de promotion. Vous pouvez définir dans la page B une URL canonique faisant référence à A. Attention, l'URL canonique est un indicateur que vous fournissez à Google, lequel ne s'engage pas à le respecter dans 100% des cas.

Ensuite, soit vous attendez que Google désindexe la page, soit vous accélérez le processus (voir ci-dessous).

Comme je sais que vous avez bien suivi mes explications, vous avez compris que votre page doit être crawlable, n'est-ce pas ? Car si vous interdisez à Google de la crawler, il ne pourra pas constater que vous demandez qu'elle soit désindexée. Je discute de ce cas de figure dans ce dossier.

Comment désindexer une page qui n'est plus accessible ?

Dans ce cas de figure, vous devez choisir parmi ces solutions les plus courantes :

- envoyer un code HTTP 404 ou 410 : ceci indique à Google que la page n'existe pas (404) ou plus (410). Le code 410 semble plus efficace, car avec un code 404 il peut se passer plusieurs mois avant que Google décide enfin de désindexer la page ! Si vous êtes perdu dans tous ces codes HTTP, consultez ma liste.

- envoyer un entête HTTP spécial (X-Robots-Tag) : c'est la même idée que la balise meta robots noindex. Elle s'impose quand le document à désindexer n'est pas une page HTML, car dans ce cas vous ne pouvez pas ajouter de balises meta (PDF, documents Word ou Excel, etc.).

- rediriger en 301 vers une autre page : on utilise cette méthode quand on pense que l'URL à supprimer avait obtenu des (bons) backlinks (par exemple en ecommerce ou site de petites annonces). Pour éviter d'en perdre le bénéfice, il faut mettre en place une redirection permanente. Notez que si vous faites ça sur une grosse quantité d'URL, il est probable que Google considère ça comme des soft 404 et qu'au final les pages ne soient pas désindexées.

Ensuite, soit vous attendez que Google désindexe la page (ça peut être très long), soit vous accélérez le processus (voir ci-dessous).

Comment vérifier qu'une page est non-indexable ?

Vous pouvez utiliser différents outils pour vérifier que vous êtes bien dans une des situations exposées précédemment.

Je vous recommande néanmoins de passer par un logiciel spécialisé (comme RM Tech, celui que j'ai conçu chez My Ranking Metrics). Après une analyse exhaustive de votre site, il vous listera l'ensemble des URL des pages HTML non-indexables.

Vous pourrez ainsi confirmer que les pages non-indexables sont bien celles que vous avez prévues. Dans le cas contraire, si l'outil liste des pages non-indexables qui devraient être indexables, autant dire que c'est une erreur plutôt grave...

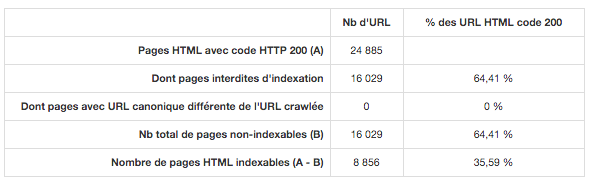

Voici un exemple de rapport d'audit qui montre qu'un très grand nombre d'URL sont interdites d'indexation à cause d'une balise meta robots noindex (espérons pour son propriétaire que c'est voulu) :

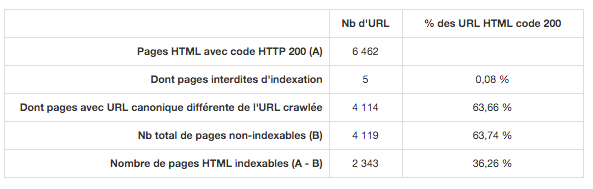

Voici un autre exemple de rapport d'audit similaire avec de nombreuses URL non indexables en raison d'une URL canonique différente de l'URL crawlée :

En combien de temps Google supprimera mes pages ?

Maintenant que vous avez vérifié que la ou les pages à supprimer de Google sont "non-indexables", qu'elles soient encore en ligne ou pas, vous devez attendre...

En effet, la page ne sera désindexée qu'au moment où Google cherchera à y accéder (la crawler). Et encore, dans le cas d'une erreur 404, je vous ai indiqué que ça pouvait prendre beaucoup de temps...

Mais vous pouvez accélérer le traitement !

Comment supprimer rapidement une page de Google ?

Supprimer une page grâce à Search Console

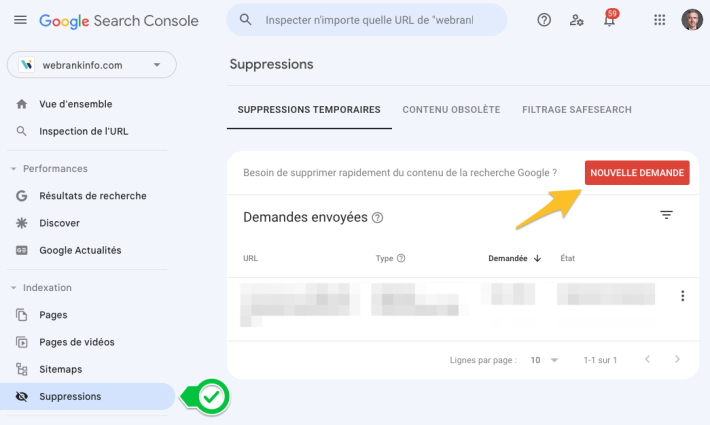

Si vous avez une seule page à supprimer, ou un petit nombre, le plus efficace est certainement de faire une demande explicite dans Google Search Console. Allez dans le module "Suppressions" et cliquez sur nouvelle demande.

Pour la suite des explications :

Si par contre vous avez de nombreuses URL, il sera peut-être fastidieux voire impossible en pratique de passer par des demandes individuelles dans la Search Console.

Rassurez-vous, j'ai une astuce :-)

Elle n'est pas très connue et je vous l'offre ici : listez toutes les URL à désindexer dans un fichier sitemap ! Un simple fichier texte avec une URL par ligne suffit largement (encodage UTF-8), avec le nom de votre choix. Déclarez ce fichier dans Search Console (rubrique Exploration > Sitemaps) et patientez.

L'idée est qu'un sitemap ne sert pas à faire indexer des pages, mais à inciter Google à crawler des URL.

Grâce à ce sitemap :

- Google viendra assez rapidement crawler toutes ces URL

- il constatera qu'elles doivent être désindexées

- au fur et à mesure qu'il viendra les crawler, il les désindexera

- en plus, à chaque fois que vous irez consulter Search Console, vous saurez combien d'URL de ce sitemap sont encore présentes dans l'index.

Dès que toutes les URL sont désindexées, vous pouvez supprimer ce sitemap.

Résumé à partager sur Twitter :

Peut-on utiliser le fichier robots.txt pour désindexer des pages ?

Réponse rapide : "non", pour la bonne raison que le fichier robots.txt ne gère pas l'indexation mais le crawl.

Concrètement, si vous ne faites qu'interdire le crawl d'une URL, Google ne viendra plus la crawler, c'est tout. Si jamais l'URL était indexée, il ne la désindexera pas ! Simplement, il ne viendra plus jamais la mettre à jour. C'est d'ailleurs une erreur classique, que vous pouvez partager sur Twitter :

Certes, il y a une petite remarque à faire : il est possible de supprimer une page via Search Console, et pour éviter qu'elle revienne à l'avenir dans l'index de Google, on la bloque dans le fichier robots.txt. Ce n'est donc pas le fait de la mettre dans le robots.txt qui la désindexe, mais la combinaison "demande de désindexation dans GSC + blocage dans robots.txt".

Dernier point : la directive Noindex: située dans le fichier robots.txt, . Pendant des années, Google en a tenu compte alors qu'elle n'a jamais fait partie du standard et que Google n'en a jamais parlé nulle part dans ses pages d'aide. Mais en juillet 2019, Google a indiqué qu'il ne faut plus l'utiliser, car à partir du 1er septembre 2019 il arrêterait de la supporter.

Si vous souhaitez en savoir plus, consultez le dossier où j'ai testé le Noindex dans le robots.txt.

Comment supprimer/désindexer tout un site de Google ?

Pour désindexer tout un site, avec tous ses sous-domaines, il suffit de faire la demande dans Google Search Console.

- choisissez bien la propriété Search Console concernée :

- si vous choisissez une propriété domaine, ça supprimera TOUS les sous-domaines

- si vous choisissez une propriété "préfixe d'URL", ça supprimera uniquement le sous-domaine de la propriété

- cliquez sur la gauche dans Suppressions puis sur "Nouvelle demande"

- dans l'onglet "Supprimer temporairement l'URL", cochez "Supprimer toutes les URL avec ce préfixe"

- à l'endroit où vous devez indiquer une URL, mettez l'URL de la page d'accueil, commençant par

httpet se finissant par/ - validez

Comment supprimer/désindexer la préprod indexée par Google ?

Pour désindexer un sous-domaine de préprod que Google a indexé, faites une demande de suppression en choisissant une propriété Search Console de type préfixe d'URL qui correspond uniquement au sous-domaine concerné.

Suivez les explications données précédemment.

Ensuite, pour éviter de faire d'autres bêtises lors de vos prochaines refontes, suivez mon guide vidéo de la refonte SEO.

Besoin d'aide ?

J'ai passé pas mal de temps à rédiger ce dossier, ainsi qu'à organiser la logique de sa structure afin qu'il soit facile à comprendre.

- Si j'ai oublié des cas, ou si vous avez des questions, merci de les indiquer dans les commentaires ou dans le forum Indexation Google sur WebRankInfo.

- Si vous souhaitez vérifier que votre site ne contient aucune page NON indexable, lancez un audit RM Tech gratuit.

- Si vous n'y arrivez pas tout seul, demandez-moi un devis.

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Bonjour Olivier,

à la demande justifiée d'un client, j'ai fait désindexer toutes les pages de son site de Google comme tu l'expliques dans l'article en allant sur la Search Console et supprimant les pages.

Il m'a demandé il y a un mois de remettre les mêmes pages de son site en ligne et là, il ne ressort plus aussi bien qu'au départ, ne serait ce que sur son prénom et nom, il est en fin de 2ème page.

Est ce qu'il a subi une pénalité ?

Merci par avance pour une piste

Je ne trouve pas ça étonnant, désindexer tout un site ce n'est pas anodin ! Il faut sans doute patienter, et vérifier que tout le site est correctement fait pour le SEO.

Hello Olivier,

merci pour ton tuto très complet comme toujours.

Je me pose une question depuis un moment et j'avoue ne pas avoir trouvé plus d'info.

Il s'agit des pages de type "mon compte", "panier", etc... que l'on va trouver sur un site e-commerce.

D'après toi est-ce judicieux de les désindexer ?

Ce sont des pages qui auront peu de contenu intéressant et qui n'ont pas vocation à se positionner dans les résultats de recherche.

Pour autant, je trouve intéressant de les laisser accessibles à Google dans la mesure où il pourrait trouver étrange qu'une boutique en ligne n'ait pas ce type de page.

J'ai regardé divers gros sites e-commerce qui marchent bien en référencement naturel et il ne semble pas y avoir de consensus sur le sujet.

D'après toi parmi ces solutions laquelle te paraît la meilleure ?

- Bloquer le crawl ET l'indexation

- Laisser la page crawlable et bloquer l'indexation.

- Autoriser crawl et indexation

- Bloquer en disallow via un robots.txt (crawlable, indexable mais avec un contenu vide pour Google, c'est ce que fait cdiscount par exemple).

Qu'en penses-tu ?

Je serai curieux d'avoir ton avis :)

A mon avis, les pages pour lesquelles il faut être connecté n'ont pas à être accessibles à Google. Donc noindex et par sécurité disallow.

Par contre (mais ce n'est pas ta question !), je conseille de laisser indexer les pages de mentions légales, de contact, etc.

Super merci Olivier ;)

En effet pour les mentions légales et contact c'est mieux pour google de les voir tout simplement pour la confiance qu'il accordera au site ;)

Super article ! Hyper complet ! merci ;)

Petite question : Pour désindexer les pages inutiles aux SEO, je place ma balise noindex sans bloquer dans le robots.txt et j'attends que Google repasse dessus. Jusqu'ici tout va bien.

Ma question est surtout : Une fois les pages desindexées, est-ce que je les disallow dans le robots.txt pour ne pas gaspiller de crawl budget ou dans tous les cas les spiders n'iront plus les visiter ?

S'il y a des liens vers ces pages, alors elles seront encore crawlées.

S'il faut vraiment empêcher le crawl, le robots.txt peut convenir.

Si ces pages n'ont plus aucune raison d'exister, autant complètement les supprimer.

Bonjour, je viens de reprendre un site et de recevoir un message de la search console indiquant: 2 pages "Indexée malgré le blocage par le fichier robots.txt" - les liens amenent vers des erreurs 404. Si je comprend bien je dois les désindexer mais même après avoir lu l'autre article je ne comprends pas comment faire sur la search console :/ Pouvez-vous m'aider?

Elles ont sans doute été indexées à une époque où elles n'étaient pas en 404, contrairement à maintenant. Mais comme elles sont bloquées au crawl, Google ne peut plus les désindexer. Dans ce cas, le plus rapide est de demander une suppression de chaque URL via l'outil de suppression dans l'ancienne search console.

Bonjour, je ne comprends pas pourquoi la search console me renvoie une erreur:

URL envoyée désignée comme "noindex" : vous avez envoyé cette page pour qu'elle soit indexée, mais elle contient une directive "noindex" dans une balise Meta ou un en-tête HTTP. Si vous souhaitez que cette page soit indexée, vous devez supprimer cette balise ou l'en-tête HTTP.

C'est-à-dire qu'il faut dire à google de ne plus crawler cette page grâce à robots.txt? (car je veux la garder non indexable) ou faut-il la supprimer via l'ancienne search console?

Merci

Ce n'est pas une erreur au sens où la situation correspond exactement à ce que vous voulez, à savoir que Google crawle une page mais ne l'indexe pas.

Du point de vue de Google, c'est logique de prévenir que cette situation est potentiellement une erreur, car cela ne correspond pas à la majorité des cas.

Bonjour,

Lorsque l'on demande une "suppression de page" via l'outil de Google (ma page étant en no-index et non bloqué par le robots.txt)

A parti de quand peut on remettre le disallow dans le robots.txt pour éviter des crawl inutiles ?

En effet, il y a plusieurs semaines j'avais demandé ce genre de suppression, le lendemain Google me dit que l'URL est "supprimée". Je l'ai donc remis dans le robots.txt, mais plusieurs semaines après cette page ré-apparait dans la rubrique "Indexée malgré le blocage par le fichier robots.txt".

On peut bloquer la page dans le robots.txt avant ou après avoir rempli le formulaire de demande de suppression.

Bonjour Olivier, merci pour ce que tu fais depuis des années !

J’ai un pb : url on été indexer avec un thème qui a été effacé

Je voudrais supprimer des url mais les url ne sont plus disponible sur mon site . Google les laisse indexer .

Ma question est comment faire un site map pour à dire à Google de supprimer tout ces liens auquel moi même je n’ai plus accès

Je dois tout rediriger en 410 avant de faire la demande ?

Merci...

Ces URL sont-elles vraiment encore indexées ? ou bien seulement Google les crawle et les signale en erreur

Si elles renvoient déjà un code 404, tu peux attendre.

Sinon :

Si un répertoire entier peut être désindexé, c'est faisable dans l'ancienne search console.

S'il y en a peu à désindexer, c'est faisable une par une dans l'ancienne search console.

Bonjour, comme la Search Console remonte désormais en erreur les pages envoyées dans un sitemap mais mises en no-index. Est-ce toujours une bonne idée d'utiliser un sitemap pour les pages à supprimer ?

Quand on fait un sitemap listant des URL à désindexer, on sait très bien ce qu'on fait ;-)

Donc non ce n'est pas un problème, mais quand les URL ont été désindexées, le sitemap doit être supprimé.

Bonjour Olivier et merci pour cet article.

En utilisant l'outil RM Tech, je vois dans les résultats que la page "Contact" de mon site est considérée comme faible en contenu (en effet, c'est juste une formulaire). Pensez-vous que je devrais mettre cette page en noindex ?

Désolé si cette question est ridicule mais je débute dans le web. Merci !

Non, il faut la laisser indexable et ignorer cette indication de RM Tech pour cette page.

Bonjour Olivier, si je suprime l url de sitemap est ce que cette methode est efficace pour désindexer une page de Google? merci

non, absolument pas. Pour désindexer une page, il faut suivre les indications de ce tuto ;-)

Bonjour,

Pour désindexer plusieurs milliers de pages (suite à erreur conception) je les route toutes vers un code HTTP 410, mais comme cela va prendre du temps j'ai envie de rajouter un header x-robots-tag noindex

ce header sera-t-il pris en compte avec le code 410 ? ou faut-il absolument avoir un code 200 pour prendre en compte le noindex du header ?

Le code x-robots-tag noindex ne serait de toutes façons pas plus rapide que le code 410, ce qui est long c'est davantage que Google vienne crawler tout ça. D'où l'idée d'un sitemap qui liste les URL concernées. A mon avis le code 410 est le plus approprié ici.

Bonjour, quand je fais un site:www.monsite.com j'ai environ 39000 pages

mais dans GG search console > etat de l'indexation j'ai 13200 pages.

Est ce normal cette différence ?

la commande site: n'est pas assez fiable pour ça

l'état de l'indexation est + fiable, notamment la couverture de l'index dans la nouvelle search console

Merci pour l'astuce du sitemap obsolete à rajouter

J'espère que cela marchera

Merci pour l'article Top !

Bonjour,

Je préfère avoir une url sans www.

Préférence esthétique ;)

Une solution, pour remédier au problème?

Merci d'avance.

Bonjour,

Je l'ai vu dans la Search Console.

Oui, il y a une redirection 301.

En fait, avant j'avais mon site (un onepage), sur l'url avec les 3 www.

Puis, je suis passé à la version sans les www.

J'ai tout redirigé sur cette version et mis comme domaine préféré.

J'ai déclaré toutes les versions de mon site.

Mais, cette page reste indexée aussi avec la version www, alors que tout passe sur la version sans les www.

Merci :)

Peut-être que cette URL a bien plus de backlinks que la nouvelle. Je me demande pourquoi avoir fait ce changement de suppression des www

Bonjour,

J'ai une propriété principale (https sans les www) où j'ai mes pages indexées.

Par contre, j'ai une page qui est indexée aussi sous une autre propriété (https avec les www).

Ma question:

Est-ce un problème, et si oui, que faire?

Merci d'avance :)

Patrice

non ce n'est pas dramatique, mais autant essayer de le corriger.

Y a-t-il une redirection 301 de cette URL vers celle qui correspond réellement à cette page ?

comment avez-vous identifié que cette URL est indexée ?

OK merci. Et on bloque dans le robots.txt au même moment (toujours dans le cas d'une page 404) ? Ou est-il préférable d'attendre que la demande dans Search console soit prise en compte (cad que la page soit désindexée) ?

Et si la page n'est pas en 404 : noindex ou noindex + blocage robots.txt ?

Cdlt,

Si la page est en 404 actuellement (mais qu'elle a été indexée), il suffit d'une demande de désindexation dans Search Console, et rien d'autre.

Si la page n'est pas en 404, c'est détaillé dans mon article :-)

Bonjour Olivier. Merci pour cet article très instructif...

Au final quelle "méthode" recommanderiez-vous pour désindexer une URL:

- balise noindex (puis blocage du crawl dans le robots.txt pour éviter qu'elle soit re-indexée un jour ? Ou bien est-ce inutile car avec une noindex par définition aucun risque de re-indexation future ?)

- demande de suppression dans Search console puis blocage dans le robots.txt

Nb : pour Search Console, GG insiste désormais sur le fait qu'il s'agit d'une suppression temporaire...

Merci :-)

PS : je parlais d'une page en 404

Si la page est en 404, on ne peut pas lui mettre de balise meta robots noindex, donc il faut attendre que Google la désindexe tout seul, ce qui peut être long. Pour ne pas attendre, la seule solution efficace est une demande manuelle et individuelle (par URL ou répertoire) dans Search Console.

Bonjour,

Je suis pas un pro du referencement.

J'ai eu un souci de hacking en juillet 2016 sur mon site en 2 langues, ecommerce, 400 produits.

L'infra et le site ont été purgé de toutes ces URLs indesirables.

Par dessus le marché le pirate a pris la main sur ma GSC et généré des sitesmaps à sa sauce.

Je me retrouve avec 186 000 URLs introuvables (11000 sur mon domaine ou j'ai l'explication) et 170 000 pages en 404 que j'aimerais supprimé définitivement.,

La méthode décrite dans cette page a savoir un sitemap spécifique en txt avec la liste des URL pour forcer GG a crawler ses URL pour les supprimer est elle tjrs d'actualité ?

Merci par avance

@ripa31 : oui, cet article est bien à jour :-)

Si les URL à désindexer sont toutes dans un même répertoire, il suffit de l'indiquer dans l'outil de désindexation de Search Console.

Bonjour Olivier, Bonjour les gens qui suivent Webrankinfo et cette page en particulier.

Je m'interroge à désindexer une page en particulier, j'ai besoin d'avis sur le sujet

J'ai une iframe que j'utilise dans des guides conseils :

http://www.lesartisansdemenageurs.fr/devis-demenagement-iframe-step1.html?provenance=les-artisans-demenageurs

C'est une page indexée, on la retrouve bien dans le SERP.

Je préférais renvoyer mon trafic de cette page vers une page qui transforme mieux.Une page "complète" :

http://www.lesartisansdemenageurs.fr/devis-demenagement.html

Comme l'iframe est intégrée dans tous mes guides, je ne peux pas faire de 301, sinon sur mes guides ça va afficher la page "complète" la place de l'i frame.

Je m'interroge à mettre un no-index pour cette page "iframe", quitte à ce que le trafic soit perdu (idéalement récupéré par mon autre page "complète").

Sur Google analytics, j'ai un taux de rebond supérieur à 40 % et une durée de visite inférieur à sec sur le la page avec que l'iframe. Je ne sais pas si ça vient de l'affichage dans les guides (les robots passent du guide à l'iframe) ou si j'ai vraiment ces chiffres là pour la page indexée de l'iframe, dans ce cas il faut que je trouve une solution (!).

Merci de votre aide,

Christelle

on pourrait mettre la page "complète" en tant qu'URL canonique sur la page iframe

Ah d'accord merci Olivier !

Je vois bien comment signaler ds le robots.txt qu'une page ne doit pas être crawlée mais pour moi le sitemap indique les pages à crawler, pas à désindexer. Il faut mettre une fréquence à 0 ?

En effet, le sitemap indique les URL à crawler : la notion d'indexation n'est pas liée au sitemap.

Si on incite Googlebot à crawler une page contenant une balise meta robots noindex, il va venir la crawler et constater qu'on ne veut pas l'indexer.

Bonjour Olivier,

je suis vraiment intéressé par ta solution du sitemap. Etant assez "jeune" dans le référencement, aurais-tu un tuto à proposer pour concrètement réaliser cette sitemap?

Merci d'avance.

Pour faire un sitemap, il faut créer un script sur-mesure, à moins que le site soit basé sur un CMS (dans ce cas un plugin peut le faire). si besoin de plus d'infos, merci de créer une discussion dans le forum WRI

Bonjour Olivier,

Je ne comprends pas l'astuce du fichier sitemap pour demander à désindexer les pages, pouvez-vous développer ? Google viendra crawler les URL mais comment verra t-il qu'il faut les désindexer ?

@ Newki75 : comme expliqué dans l'article, pour désindexer une page, il faut la mettre en situation d'être désindexée, puis attendre que Google la crawle (ce qui est accéléré avec un sitemap)

@Alexandre :

1/ je ne te recommande pas de continuer... il est très facile pour Google de voir ce que tu fais ;) et ça va contre ses consignes...

2/ pour contourner ton problème, il te faut passer des paramètres d'attente (une ou deux secondes) entre les actions. Ce script se jouait bien mais comme Google s'en est rendu compte il a fait ce qu'il faut. Ma solution marchait (j'ai eu à sortir quelques dizaines d'URL il y a un an) mais si tu as trop d'URLs à virer, je te renvois au premier point ;)

Bon courage

Arnaud

Bonjour,

@UsagiYojimbo, je me permets de poster un commentaire suite à votre message. J'ai essayé la suppression d'un lot de pages via le plugin iMacros mais le process de suppression d'url sur la search console n'est pas complété par la macro utilisée. Je dois confirmer l'envoi de la demande de suppression. Ci-dessous la macro utilisée :

VERSION BUILD=7500718 RECORDER=FX

SET !DATASOURCE C:\DOSSIER\VERS\LE\FICHIER\url-to-remove.csv

SET !DATASOURCE_COLUMNS 1

SET !TIMEOUT_STEP 0

SET !ERRORIGNORE YES

SET !EXTRACT_TEST_POPUP YES

SET !LOOP 1

TAB T=1

URL GOTO=https://www.google.com/webmasters/tools/url-removal?hl=fr&siteUrl=***URL_DU_SITE***

TAG POS=2 TYPE=DIV ATTR=TXT:Nouvelledemandedesuppression

TAG POS=1 TYPE=INPUT:TEXT FORM=NAME:newremovalform ATTR=ID:urlt CONTENT={{!COL1}}

TAG POS=1 TYPE=INPUT:BUTTON FORM=ID:newremovalform ATTR=NAME:urlt.submitButton&&VALUE:Continuer

TAG POS=1 TYPE=SELECT FORM=ACTION:/webmasters/tools/removals-submit-ac?hl=fr&siteUrl=***URL_DU_SITE*** ATTR=NAME:removalmethod CONTENT=%DIRECTORY

TAG POS=1 TYPE=INPUT:SUBMIT FORM=ID:the-form ATTR=ID:submit-button

J'ai trouvé cette macro sur la toile. La search console a surement évoluée, ou des sécurités ont été ajoutées. J'ai vu dans le code source un security token.

Pourriez vous me dire si vous voyez qqc d'erroné dans la macro ou si il manque qqc ?

Merci par avance. Et Bonne Année 2016 à tous.

De manière à demander la désindexation d'un lot de pages, il est aussi possible d'utiliser le plugin iMacro pour automatiser la demander de suppression d'une liste d'url incluse dans un fichier csv.

Bonjour Olivier,

Je vois souvent que le canonical se comporte comme une 302 : l'URL reste indexée, pas son contenu (/sa page).

Lors de l'affichage du cache associé à cette URL, c'est l'URL et le contenu proposé dans le "canonical" qui est affiché à l'utilisateur.

Du coup, avec du "canonical" on désindexe bien la page, mais pas son URL.

Et si on veut désindexer un contenu assez rapidement, on peut jouer aussi avec du 410* (traité plus rapidement par Google que du 404) même si on maintient le contenu en place.

* document supprimé

@nico : à la base, l'URL canonique ne sert pas réellement à faire désindexer, même si c'est censé être ce qui arrive au final. C'est utile aux cas ou plusieurs URL affichent le même contenu, ou quasiment le même.

Bonjour Olivier,

Il y a également une autre option qui peut être utile pour désindexer une page via la Search Console : l'utilisation des paramètres d'URL.

Je suis justement en train de faire un test et en cochant "Aucune URL" dans "Parmi les URL contenant ce paramètre, lesquelles doivent être explorées par Googlebot ?" certaines pages ne sont plus visibles dans les résultats de recherche.

Qu'en penses-tu ?

Merci ;)

Bonjour Jérôme

Je suis contre l'utilisation de ce paramétrage, car ça ne semble pas si bien marcher que ça mais surtout car je considère que le pb doit être réglé sur le site. En utilisant cet outil, il faut le refaire pour chaque moteur (ce qui n'est pas une bonne idée à la base, même avec les parts de marché que l'on connait pour Google). Et ceux qui interviennent sur le site ne savent pas qui a configuré quoi et quand...