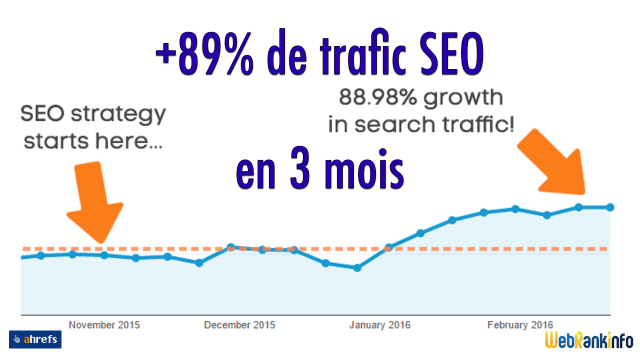

En 3 mois, 89% de hausse du trafic du référencement naturel

Je vous fais ici un résumé commenté d'un article publié par Ahrefs (pour les détails, je vous invite à le lire, en anglais).

Il m'a particulièrement intéressé car :

- ils communiquent en toute transparence en détaillant ce qu'ils ont fait

- ils ont obtenu un bon résultat, rapidement

- ça colle exactement avec 2 points essentiels du référencement Google actuellement (selon moi) :

- les fondamentaux du référencement doivent être respectés (aucune erreur technique)

- vous ne devez plus laisser se faire indexer des pages de mauvaise qualité. Il faut les identifier, les améliorer ou les supprimer, puis publier d'autres contenus de bonne qualité

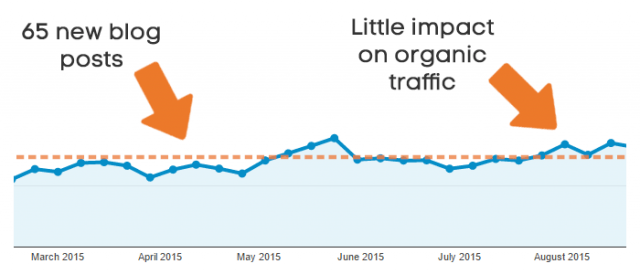

Pendant longtemps, même en publiant plein d'articles sur leur blog, leur trafic généré par le référencement naturel n'augmentait presque pas :

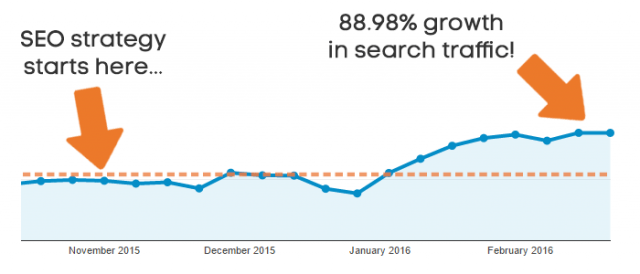

Si bien que fin 2015 ils sont mis le paquet, ce qui a conduit a 89% d'augmentation des visites SEO en 3 mois :

En résumé, voici ce qu'ils disent avoir fait (j'ai mis en gras 2 points essentiels et faciles à identifier) :

- Nous avons effectué un audit du contenu et supprimé les articles de mauvaise qualité qui ne généraient aucun trafic

- Nous avons mis en place une stratégie éditoriale de 6 mois, basée sur des mots-clés

- Nous avons réduit la fréquence de publication sur notre blog et nous sommes focalisés sur la qualité plutôt que la quantité

- Nous avons rehaussé les exigences en termes de qualité pour nos contributeurs invités (guest posting)

- Nous avons vérifié que chaque nouvel article était correctement optimisé pour son mot-clé cible

- Nous avons effectué une promotion massive de nos nouveaux contenus

- Nous avons corrigé un certain nombre de problèmes techniques SEO

Vous aussi, doublez votre trafic SEO !

Vous souhaitez faire la même chose pour doubler votre trafic SEO en quelques mois ? Ca nécessite du boulot, mais voici quelques conseils...

Pour corriger les problèmes techniques SEO, il est indispensable de lancer un audit technique exhaustif avec un outil. Comme vous le savez j'ai participé au développement de ma plateforme My Ranking Metrics qui propose RM Tech, un audit SEO en ligne. Quel que soit l'outil que vous utilisez, il doit couvrir au moins ces aspects :

- l'audit doit être exhaustif (toutes les pages du site doivent être étudiées)

- le rapport doit lister non seulement les problèmes mais aussi les moyens de les corriger (avec des explications et toutes les données utiles)

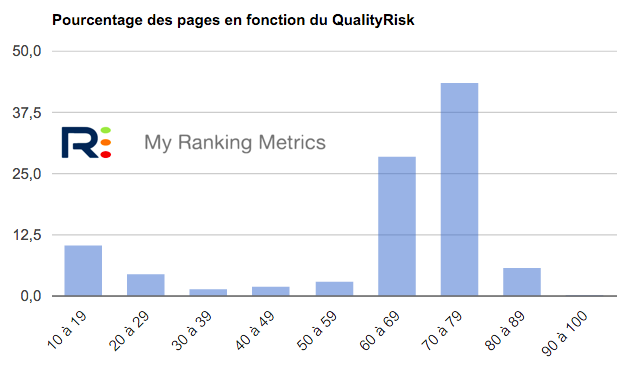

Pour repérer les pages de mauvaise qualité, regardez déjà celles qui ont des scores QualityRisk trop élevés (par exemple supérieurs à 30). Par expérience, je vois qu'il faut absolument éviter d'en avoir trop sur son site et qu'en les améliorant, le référencement Google progresse en quelques semaines/mois. Pour en savoir plus sur QualityRisk, lisez mon dossier "Qualité des contenus et SEO".

Voici à quoi ressemble l'aperçu des problèmes de qualité dans un rapport RM Tech :

Si vous n'arrivez pas à établir de stratégie éditoriale ou à rédiger des contenus de haute qualité, passez par les rédacteurs web spécialisés SEO : c'est leur métier, ils font ça très bien.

Pour vérifier que chaque page est optimisée pour son mot-clé cible (et plein d'autres expressions stratégiques proches, n'oubliez surtout pas la longue traîne) :

- Commencez par la phase d'adéquation mot-clé/contenu. En d'autres termes : pour tous les mots-clés stratégiques pour votre activité, vérifiez que vous avez une page qui "en parle" très bien (sinon il faudra la créer) et notez-la dans Excel.

- Ensuite, triez votre tableau par pages plutôt que page mot-clés. Vous aurez une bonne vision des mots-clés associés à chacune de vos pages importantes.

- Débrouillez-vous pour obtenir les principales caractéristiques de ces pages (mon outil RM Tech le fera très bien quel que soit le nombre de pages) et vérifiez que cela "colle" bien aux mots-clés identifiés précédemment :

- son titre (balise title)

- sa balise meta description

- est-elle bien crawlable par Google, et même indexable ? il faut le vérifier

- son titre éditorial (balise H1)

- son contenu

- sa profondeur (en nombre de clics depuis la page d'accueil) : pour une page stratégique, il faut une très faible profondeur (1 ou 2)

- Lancez un audit de ses backlinks externes (avec Search Console ou mieux : un outil spécialisé comme Ahrefs justement) pour vérifier qu'ils sont de qualité et adaptés à la page cible

Remarque : ceci n'est qu'un très court extrait des conseils que je fournis en formation SEO...

Faites la promotion de vos bons contenus ! Que ce soit via les réseaux sociaux, votre newsletter, des forums ou même de la publicité, n'hésitez pas à faire savoir à vos abonnés que vous avez publié des nouveaux contenus (ou mis à jour des anciens).

Pour connaître en détails la méthode d'audit à appliquer, suivez mon guide complet !

Petite question pour Olivier Duffez, nous avons un e-commerce avec lequel nous travaillons depuis 2 ans et en ce moment nous sommes en cours de changement de cms(wordpress-->prestashop).

La question est:

Allons-nous être impacté par le referencement si nous gardons au final les 2 cms, cad 2 sites et bien sûr avec 2 URL différentes.

Je te remercie d'avance pour ta réponse.

@Tarik : il faut remplacer les anciennes pages (WordPress) par les nouvelles (Prestashop), si possible en conservant les URL (ce qui risque d'être difficile). En cas de changement d'URL, il faut prévoir un plan de migration avec les bonnes redirections 301 de page à page.

En fait, comme j'ai suivi votre dernier webinar et que vous parliez de "budget de crawl", je me disais que c'était peut-être mieux de les éliminer....

Attention, je ne remets pas en cause Ranking Métrics qui m'a super bien aidé, ce n'est pas la question, c'est juste par rapport à mon cas, savoir si il vaut mieux que j'élimine ces pages sans clic malgré leur qualité ou si je dois les laisser malgré leur manque de clic. Tout ça dans un but de meilleur référencement. D'ailleurs, ces pages ne me servent pas pour le référencement direct de mon site, je pensais "diversifié" mon contenu avec elle.

OK, mais elles ont très peu voir pas du tout de clic. Or je pensais que si une page avait pas de clic, Google en tenait compte pour le référencement. Certes, elles ont du texte, une image, un tire ... mais pas de clic.

Elles n'ont que peu de clics car elles n'ont pas assez de valeur ajoutée...

Une question : J'ai bien utilisé Ranking Métrics afin d'améliorer la "qualité" de mes pages et au final je n'ai plus de "mauvaises" pages. Pourtant je me demande une chose : les pages que j'ai "réparé" ont très très peu de visites et pour certaines aucun lien externe qui pointent vers elle. Elles représentent environ les 2/3 de mon site. Donc est-ce que je dois les garder sachant qu'elles ont du contenu mais peu de valeur ajoutée par rapport au reste du site.

Est-ce qu'au final ce n'est pas pénalisant ?

Merci de vos réponses.

Vous ne pouvez pas à la fois dire que vous avez corrigé les pb de qualité sur ces pages et indiquer qu'elles ont peu de valeur ajoutée... QualityRisk aide à repérer des problèmes de manque de qualité, et dans ce cas il faut tout faire pour se ramener à un bon niveau.

Peut-être que l'augmentation est simplement due aux mises à jour Google concernant la qualité d'un site, non ? Elles ont été nombreuses en janvier. Et donc que la date coïncide avec la fin de leur optimisation. J'ai exactement les mêmes augmentations de constatées sur différents sites internet (allant de début janvier à fin janvier ).

Si la visibilité augmente sur les sites qui ont fait la chasse au mauvais contenu, ça confirme que c'est une bonne stratégie ! Je crois qu'on dit la même chose au final...

Merci beaucoup pour le partage d'expérience, il y a de quoi s'occuper à améliorer nos sites ! Lester

Bon j'ai un peu regardé. Et comme je me doutais, j'ai énormément de pages non vues, mais d'excellentes qualités. Problème de linking interne. Aucun lien pour faire court. Mais bon, ça va me faire réfléchir à regrouper plusieurs pages trop "light" pour être honnêtes :)

Est-il envisageable de ne pas supprimer les contenus mais de les passer en noindex ?

Quand on a une base de données dont le but est d'être plutôt complète, elle contient aussi des choses peu populaires ou sur lesquelles il y a peu d'infos, bref à la fois des pages avec peu de contenu, mais aussi des pages très rarement visitées.

Faut-il vraiment les virer et faire du net un endroit bien uniforme où on ne parle que de ce qui est connu/populaire ? Parce que c'est un peu ça le corollaire de la suppression de tout ce qui ne "marche" pas et ça me dérange franchement.

Oui, on peut passer des pages en noindex, mais si elles sont de mauvaise qualité, est-ce vraiment une bonne idée de les proposer aux internautes ? L'idéal est donc bien entendu d'améliorer la qualité (plutôt que supprimer plein de pages), mais ça peut demander pas mal de boulot.

Excellent article comme toujours ! En revenant aux fondamentaux, en insistant sur la qualité des contenus et en étant patient, j'ai moi aussi constater une amélioration de la position et un gain de trafic, surtout quand les concurrents sont mauvais. Comme quoi il faut avant tout rester attaché aux bases :)

Merci pour le partage. J'ai un retour d'expérience qui confirme la méthode et les résultats.