Cet article fait partie des archives de WebRankInfo : certes, il est ancien, mais complet et détaillé pour son époque. Si vous cherchez d'autres informations, faites une recherche sur le site ou participez au forum. Contactez-moi si besoin.

Plusieurs mises à jour non officielles de l’algo de Google semblent toucher l’évaluation de la qualité (en plus de Panda). Faute de nom, celles qui ont eu lieu entre 2015 et 2017 ont été regroupées dans la « famille Phantom » :

Analyse de l'update Phantom 2 (mai 2015)

Nous sommes nombreux à avoir identifié de gros changements dans les résultats Google à partir du 29 avril 2015, se stabilisant environ une semaine après, début mai.

Google n'ayant pas communiqué dessus, nous avons été contraints d'émettre des hypothèses, dont voici mon compte-rendu résumé.

Certains ont pensé qu'il s'agissait de l'update sur la prise en compte du critère mobile-friendly (les pages compatibles mobiles sont favorisées pour les recherches sur des mobiles). Mais rapidement nous avons pu conclure que cela n'avait rien à voir. Il faut dire que Google avait indiqué que l'impact serait significatif, et pourtant ce fut faible.

Ayant pu étudier plusieurs sites impactés négativement par l'update de fin avril, j'ai constaté que cela n'avait aucun rapport avec l'algo Pingouin et j'ai d'abord cru que c'était une mise à jour de Panda. En effet, j'ai compris que le problème venait des pages de trop faible qualité, et d'ailleurs tous les sites ayant chuté fin avril avaient déjà eu des problèmes avec des mises à jour Panda. Mais Google avait répondu clairement au site spécialisé SearchEngineRoundtable qu'aucune mise à jour de Panda ou de Pingouin n'avait été faite.

J'ai également pensé qu'il pouvait s'agir de l'algo de Google contre les pages satellites (doorway pages), surtout que sa mise en ligne a été confirmée. Mais aucune date n'a été fournie et désormais je ne suis pas certain que ce soit ça.

Certains ont ensuite publié des analyses de cet update. Par exemple Glenn Gabe de hmtweb.com a identifié certaines causes possibles de chute : contenu trop faible (thin), contenu créé pour attirer les clics (clickbait), contenu saturé de publicité, contenu constitué uniquement d'une série de vidéos intégrées dans la page. Son très bon article a été repris par CNBC, chose très rare pour être soulignée. Le site hubpages.com a "avoué" avoir connu une chute de trafic à ce moment-là et a émis l'hypothèse que Google avait spécialement pénalisé les pages qui ciblent les requêtes du type "comment faire" (how to).

Le 19 mai 2015, Google a enfin confirmé qu'il avait effectivement procédé à une modification de son algorithme. Précisément, ils disent avoir mis à jour le coeur de l'algorithme, dans la partie qui évalue la qualité. On n'en sait pas plus ! S'agit-il d'une évaluation par page ou par site ? Il me semble d'après mes premières analyses que c'est au moins par rubrique dans un site. On ne sait pas si Google a ajouté des nouveaux critères (signals) ou simplement modifié la pondération des critères déjà en place.

Barry Schwartz (de SearchEngineLand) a baptisé cette mise à jour Quality Update, mais ce n'est pas un nom officiel.

Analyse de l'update Phantom 3 (novembre 2015)

On en parle dans le forum : Update Google Phantom 3.

Analyse de l'update Phantom 4 (juin 2016)

Après Phantom 2 en mai 2015 et Phantom 3 en novembre 2015, voici donc Phantom 4 en juin 2016 !

Je n'ai pas encore eu le temps de faire des analyses approfondies, mais pour l'instant je me rapproche des conclusions d'autres spécialistes (par exemple Glen Gabbe). Comme pour les autres mises à jour "Phantom", il semble que l'algo de Google arrive de mieux en mieux à estimer le degré de satisfaction de l'internaute.

Je vous suggère de relire ce que j'expliquais dès 2011 : le comportement de l'internaute est surveillé par Google, notamment l'internaute qui vient des SERP.

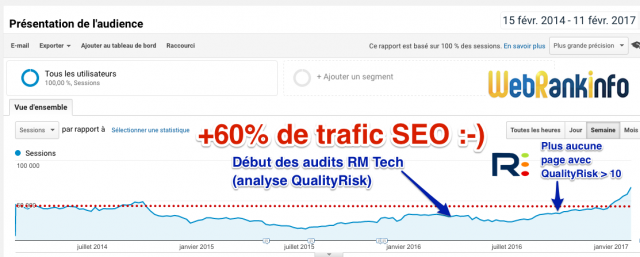

Si votre site (ou celui de votre client) est trop gros, ça risque d'être difficile d'évaluer les pages qui ont des problèmes de qualité. Je vous propose de "dégrossir le terrain" en identifiant les pages qui ont des problèmes relativement évidents. Pour cela, vous n'avez qu'à lancer un audit (payant) avec mon outil RM Tech. Il s'agit d'un crawler qui génère un rapport d'audit SEO compréhensible par tous, avec plein d'explications et toutes les annexes nécessaires.

Grâce à l'algo maison "QualityRisk", vous aurez la liste des pages qu'il faut corriger, avec leur score QualityRisk (QR). Plus il est important, plus la page a de problèmes.

Si vous préférez voir les explications en vidéo, c'est possible :-)

La vidéo sur QualityRisk (replay d'un webinar) :

Analyse de l'update Phantom 5 (février 2017)

Après Phantom 2 en mai 2015, Phantom 3 en novembre 2015 et le 4 en juin 2016, voici donc Phantom 5 en février 2017 !

Comme les autres fois, je me rapproche des conclusions d'autres spécialistes (par exemple Glen Gabbe). Comme pour les autres mises à jour "Phantom", il semble que l'algo de Google arrive de mieux en mieux à estimer si l'internaute est satisfait.

Voilà par exemple les idées de Search Metrics :

- Phantom se concentre sur la "qualité du contenu (ce qui nécessite une évaluation complexe)

- L'algo fonctionne URL par URL : son impact se situe au niveau de pages individuelles, ou de répertoires, mais pas de sites entiers

- Le déploiement peut durer plusieurs semaines

- Les grandes marques sont souvent parmi les gagnants (ou les perdants !), sans doute car cela concerne beaucoup les requêtes marques

- Les sites sont souvent "impactés" par plusieurs algorithmes ou mises à jour, et parfois aussi bien en tant que gagnants et perdants

- Les gros changements sont souvent reliés à des marques ou des requêtes de tête de longue traîne (head keywords)

- Des critères liés à l'utilisateur semblent jouer un rôle dans l'évaluation de la qualité. En particulier, l'intention de l'utilisateur est un aspect majeur.

Je vous suggère de relire ce que j'expliquais dès 2011 : le comportement de l'internaute est surveillé par Google, notamment l'internaute qui vient des SERP.

Si votre site (ou celui de votre client) est trop gros, ça risque d'être difficile d'évaluer les pages qui ont des problèmes de qualité. Je vous propose de "dégrossir le terrain" en identifiant les pages qui ont des problèmes relativement évidents.

Il s'agit d'un crawler qui génère un rapport d'audit SEO compréhensible par tous, avec plein d'explications et toutes les annexes nécessaires.

Grâce à l'algo maison "QualityRisk", vous aurez la liste des pages qu'il faut corriger, avec leur score QualityRisk (QR). Plus il est important, plus la page a de problèmes.

Et plus vous avez de pages à fort QR, plus c'est risqué avec l'algo de Google...

Si le rapport gratuit montre que vous êtes dans ce cas, achetez des crédits pour faire des audits complets (avec annexes).

Pour vous montrer que les updates Phantom ne font pas que des malheureux, voici un site sur lequel je travaille le SEO. Il avait chuté avec Panda en 2014 et a battu ses records de trafic d'avant Panda, grâce à la correction de plein de problèmes dont une large partie identifiés par QualityRisk :

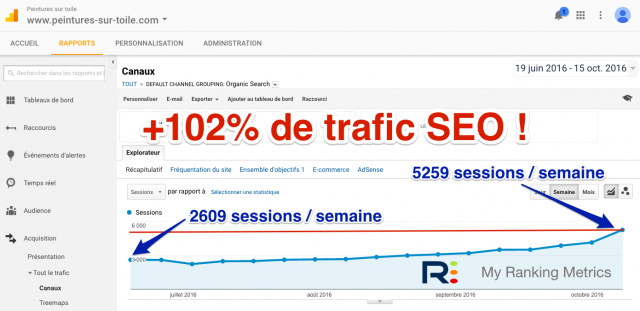

Pour rappel, j'ai déjà communiqué sur un autre site qui avait doublé son trafic SEO en travaillant également pour réduire le QualityRisk de ses pages :

Si vous préférez voir les explications en vidéo, c'est possible avec le replay gratuit de mon webinar :-)

Source de l'image : Shutterstock (sous licence)

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Bonjour,

Merci Olivier pour l'information.

De mon coté j'ai mon site et la plupart des sites de mes clients qui sont soit impacté positivement soit pas impacté. À coté de ça, le site d'un client qui recense des produits immobiliers est impacté négativement. À noter qu'il avait été impacté par Panda ou Pingouin, mais que depuis, de gros efforts ont été faits à tous niveaux.

Je pense que la clé pour passer cette MAJ sans trop de souci c'est d'avoir un contenu unique et informatif, pas trop optimisé, une bonne gestion des redirections (pas trop de 404) un SEO propre et pas trop poussé.

Le problème c'est que sur plus de 2000 pages pour le site de mon client impacté négativement, c'est un travail de titan de reprendre les contenus, sans compter que la plupart des contenus sont récupérés par des flux que beaucoup d'autres récupèrent également.

Ça devient compliqué de suivre les MAJ des algo de Google !

Va encore falloir se remonter les manches...

Bon courage à tous !

J'ai pris une grosse claque sur mon annuaire, -35% de trafic depuis cet update.

Pour le moment, je cherche le critère majeur de ce nouveau filtre.

Avec forte une baisse de rentabilité d'adsense de -40% (Google abuse carrément avec ces annonces dont il garde pour lui désormais une majorité d'offres, sympa le partenariat), c'estquasiment 60% de baisse de rentabilité.

Heureusement que j'ai une structure très légère et ça ne me met pas en danger, mais certains ont surement "mal aux fesses". En utilisateurs unique jour, le trafic a chuté de 23 000 à 15 000, pour les lundi (jour le plus fort).

Patiente, premsgo est pret a démarrer, le moteur est fonctionnel, c'est juste le risque de buzz et toute la stratégie / backoffice des pro qui necessite encore un peu de travail. Le moteur fera dans tous les cas le même trafic sans Google, et donc sans plus aucun risque (sauf d'évoluer).

bon courage Marc !

Bonjour

Mon site était très bien référencé en géolocalisation jusqu'à jeudi.

Depuis vendredi 24 mai : patratas !!!

Google a t'il changé aussi ses modes pour la géo ? Car maintenant apparait en premier sites nationaux (mes concurrents sont à la même enseigne que moi).

Cordialement

@Olivier qu'est ce qui aurait pu me faire perdre temps de place à partir du 15 mai? -20 place pour un mot clé dont j'étais stable depuis 2 ans.

Désolé Alex, je n'en sais rien et ne peux pas deviner !

J'ai quelques sites qui ont été impactés (3 dont 1 plus sévèrement que les autres)

La partie Pingouin est à exclure car rien n'a été fait dans ce sens (du moins pas pour les 3)

Une fonctionnalité est apparue il y a peu : Ressources bloquées

2 sites (qui ont des versions responsive) en ont quelques unes qui sont bien entendu bloquées sur l'ensemble des pages. L'autre n'est pas responsive mais n'a pas de ressources bloquées. Peut être une partie d'explication qui pourrait mettre en relation avec la dernière MAJ mobile.

Par contre, 2 autres points sont communs aux 3 et susceptibles de faire partie de la liste des critères que Google a réévalué.

Le premier est lié à la duplication des contenus générés par les CMS (pages de filtres, de tri, hors réécriture,...)

Le second est lié a des fonctionnalités de textes en partie affiché (système d’ascenseur, js pour afficher plus)

La qualité des contenus est bonne mais certains sont orientés sur des howto.

Aucun de ces sites n'avait fait l'objet d'une pénalité par le passé.

Vous en pensez quoi ?

@Mathieu : je pense aussi que ça n'a pas de rapport avec le mobile (et les ressources bloquées) et avec les backlinks (Penguin)

je ne pense pas que la duplication de contenus à cause d'erreurs techniques du CMS suffise à expliquer le pb, il doit y avoir autre chose

J'ai connu une baisse importante de mon positionnement google, sur des requêtes stables depuis plus de 2 ans, à partir du 15 mai d'après mon suivi SEO "Myposeo".

est ce que cela pourrait être lié à Phantom?

@Alex : si c'est entre le 28 avril et début mai, c'est fort probable.

Effectivement, il y a eu des changements dans les serp pour certains de mes clients en bien comme en mal, du moins juste quelques places de perdues mais rien de bien méchant.

Pas de Gros changement en ce qui me concerne... Est-ce que cela devrait continuer ou Ggle a décidé de stabiliser tout ça ?

@Les Résoteurs : à mon avis c'est stabilisé depuis la fin de la 1ère semaine de mai environ