WRInaute passionné

Il est désormais possible de reporter à Google les pages usant de scraping...

Dans de nombreux cas, les contenus ainsi "pillés" sont reproduits sur le site du voleur, accompagnés de publicité.

En termes de référencement, la nuisance du duplicate content ainsi généré s'ajoute aux problèmes légaux évoqués ci-dessus.

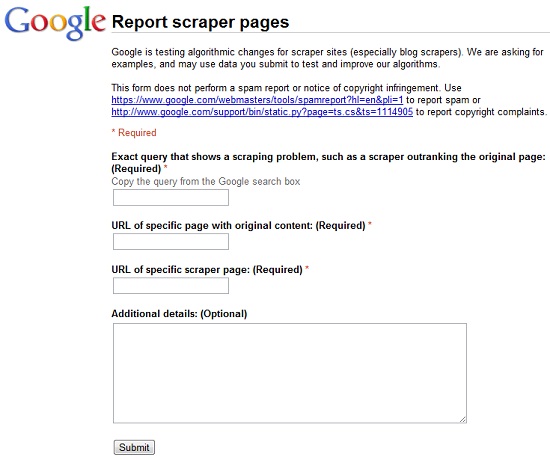

Le formulaire de Google d'appel à la dénonciation de scrapers

Google demande des exemples de sites qui pratiquent le scraping. Ces exemples serviront à "tester et améliorer" les algorithmes de l'équipe qualité du moteur de recherche.

Rien ne dit que les sites dénoncés seront forcément pénalisés ou bannis de Google, mais il y a fort à parier qu'ils seront au moins surveillés de près.

Contrairement au formulaire classique de spam report, vous n'avez pas besoin d'être connecté à votre compte Google pour le remplir...

Google veut lutter contre le scraping et crée un formulaire de dénonciation

Ce n'est pas tout à fait comme le formulaire de spam report, mais ça y ressemble fort : Google vient de mettre en ligne un formulaire dédié à la dénonciation des scrapers (les sites qui pillent le contenu des autres pour l'afficher sur leur site).Qu'est-ce que le scraping ?

Le (web) scraping est une pratique consistant à récupérer des contenus situés sur un autre site, en général de manière automatisée (par un script) et sans accord du site concerné. Il s'agit donc de vol et d'infraction au code de propriété intellectuelle (droit d'auteur).Dans de nombreux cas, les contenus ainsi "pillés" sont reproduits sur le site du voleur, accompagnés de publicité.

En termes de référencement, la nuisance du duplicate content ainsi généré s'ajoute aux problèmes légaux évoqués ci-dessus.

Le formulaire de "scraping report"

Dans le cadre du développement d'un nouveau filtre (un des ~500 changements annuels de son algorithme) de lutte contre les sites de scraping, Google a mis en place ce formulaire Google Docs.

Le formulaire de Google d'appel à la dénonciation de scrapers

Google demande des exemples de sites qui pratiquent le scraping. Ces exemples serviront à "tester et améliorer" les algorithmes de l'équipe qualité du moteur de recherche.

Rien ne dit que les sites dénoncés seront forcément pénalisés ou bannis de Google, mais il y a fort à parier qu'ils seront au moins surveillés de près.

Contrairement au formulaire classique de spam report, vous n'avez pas besoin d'être connecté à votre compte Google pour le remplir...