Le 1er semestre 2018 fut compliqué en termes SEO pour pas mal de sites, pour vous aussi peut-être ?

J'espère que vous avez pu au contraire en profiter pour remonter, mais si ce n'est pas le cas, ce dossier devrait vraiment vous y aider...

Suite à ma proposition (dans ma newsletter et sur Twitter), près d'une centaine d'entre vous m'ont contacté en indiquant que leur site (ou celui de leur client) avait chuté dans Google (en référencement naturel). Chute brutale ou chute continue, dans les 2 cas ce n'est pas ce qu'on souhaite.

Je les ai tous passés en revue, dans un premier temps dans Google Analytics (quand j'avais obtenu l'accès) et dans SEMrush (pour estimer l'état de santé SEO).

Pour 43 sites, j'ai pu confirmer que leur trafic issu du référencement naturel avait chuté (brutalement ou progressivement).

Même si je n'ai pas trouvé de causes communes à ces 43 sites, j'ai fait une constatation intéressante (à partager sur Twitter) :

Je ne prétends pas que c'est la cause de leur chute, ni la seule explication, ni que tous les sites qui chutent ont cette caractéristique, mais pour avoir "creusé le truc", il y a pas mal de choses intéressantes que j'aimerais vous expliquer.

En gros, je vous propose d'analyser le référencement sous un angle un peu différent de d'habitude. Histoire de lui donner un nom, je vais l'appeler la méthode Analyse SEO des pages actives sur 1 an.

J'ai décidé de tout vous expliquer dans un grand dossier, afin que vous puissiez appliquer la même méthode à votre site ou ceux de vos clients. Vous allez voir que j'ai des exemples de sites qui "cartonnent" !

Voilà donc ce que vous trouverez dans cet article :

- un bref rappel des mises à jour de début 2018

- l'indicateur de pages actives SEO sur 1 an

- exemples de sites analysés sous l'angle des pages actives sur 1 an

J'ai aussi publié la suite : les principaux problèmes SEO trouvés sur les sites qui ont chuté

Updates Google de début 2018

De janvier à mai 2018, plusieurs mises à jour de l'algorithme de Google ont eu de fortes conséquences sur la visibilité des sites dans les SERP. Voici un rappel des updates...

Vers le 7 ou le 9 mars 2018, une mise à jour importante a eu lieu (voir la discussion dans le forum). Elle semble concerner ce que j'appelle "l'évaluation de la qualité globale d'un site".

Fin mars, il y a eu encore des secousses - soit des remous du 7 mars, soit du nouveau.

Le plus important fut sans doute celui du 16 avril 2018 (voir la discussion dans le forum).

Une autre mise à jour du "coeur de l'algo de Google" semble avoir eu lieu vers le 30 avril. Elle semble en lien avec celles du 7 mars et du 16 avril.

Vers le 7 ou 8 mai, j'ai aussi repéré de gros changements.

Si vous souhaitez une liste très complète, la meilleure que je connaisse est celle de Marie Haynes.

OK, voilà pour les dates, maintenant place à ma méthode puis aux analyses de sites !

Pages actives SEO sur 1 an

Une majorité des sites pénalisés par l'algo Google depuis fin 2017 ont une caractéristique commune : + de 30% de leurs pages indexables n'ont pas généré la moindre visite depuis les moteurs de recherche. Détails sur cet indicateur...

Définition de page active

Peut-être connaissez-vous la notion de "page active" en référencement naturel ? Il s'agit d'une page qui a généré au moins 1 visite sur la période étudiée.

Généralement, ceux qui en parlent font une analyse croisée entre un crawl et les logs (ce qui est une excellente idée). Le problème, outre que l'accès aux logs est difficile pour beaucoup de monde, c'est qu'il est compliqué de le faire sur une longue période (en raison des volumes de données). C'est pour cela qu'en général l'analyse des pages actives ne se fait que sur 30 jours.

30 jours c'est bien pour étudier certains aspects du référencement, mais nettement insuffisant pour détecter les pages qui "déplaisent" à Google. C'est pourtant un point absolument essentiel, au coeur des algorithmes "qualité" que Google met justement à jour très souvent...

Ma définition de page active sur 1 an

Mon idée est donc la suivante : allonger à 1 an la période de l'analyse, ça change tout !

- vous tenez compte de l'éventuelle saisonnalité (sur 30 jours, vous passez à côté)

- vous donnez vraiment à chaque page une chance de pouvoir générer du trafic

Concrètement, mon hypothèse est donc la suivante (à partager sur Twitter) :

Comment calculer le taux de pages actives sur 1 an ?

La formule est simple :

taux de pages actives sur 1 an =

(nb de pages actives sur 1 an) / (nb de pages indexables)

Pour le calcul, vous avez donc besoin de 2 choses.

Je commence par les pages indexables : il s'agit des pages avec lesquelles vous voulez "jouer dans Google". En gros, ce sont toutes les pages de votre site que vous laissez se faire indexer.

Si vous faites bien les choses, vous avez un sitemap (ou un ensemble de sitemaps) qui les liste toutes, de façon exhaustive : ça vous permet d'en avoir la liste et donc leur nombre.

En pratique, je vous conseille néanmoins d'aller un cran plus loin :

- faites un crawl de votre site en suivant tous les liens (follow et non bloqués par un fichier robots.txt) depuis votre page d'accueil

- filtrez pour ne récupérer que les pages HTML répondant en code 200

- parmi elles, vérifiez lesquelles sont bien indexables (pas de noindex, pas d'URL canonique différente de l'URL crawlée)

Vous verrez avec l'expérience qu'il y a souvent des différences entre ces pages indexables effectivement trouvées sur votre site et celles listées dans votre sitemap (que vous pensiez être exhaustif).

Je passe maintenant aux pages actives : il s'agit des pages qui selon Google Analytics font partie des pages de destination, pour le support "organic". N'allez pas dans le rapport "Comportement > Contenu du site > Toutes les pages" mais bien dans "Comportement > Contenu du site > Pages de destination".

Avant de faire l'export de ces pages, vérifiez bien ces points :

- la période d'analyse doit être de 1 an

- le rapport doit être généré uniquement pour les visites dont le support est organic, ce qui correspond au référencement naturel (tous moteurs de recherche confondus). Pour cela, soit vous aviez prévu le coup et créé une vue Google Analytics dédiée au support "organic" (via un filtre), soit vous devez appliquer un segment. Si vous n'y arrivez pas, suivez mon tuto vidéo "Analyse du trafic SEO".

- il ne doit pas y avoir d'échantillonnage, sinon les données ne sont pas fiables.

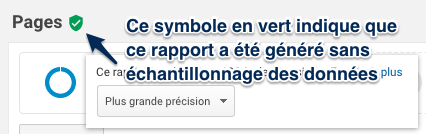

Pour vérifier qu'il n'y a pas d'échantillonnage, assurez-vous que ce symbole en vert est affiché :

Si vous n'êtes pas familier avec cette notion, visionnez ma vidéo :

à voir aussi sur YouTube : SEO : comment éviter l'échantillonnage Google Analytics

Maintenant que vous avez vos 2 listes (URL indexables et URL actives), faites un croisement des 2 pour distinguer les pages actives et les pages inactives.

Tout ça vous parait compliqué ? Oui, c'est vrai que ça fait pas mal de manipulations. Vous comprendrez en lisant la suite que c'est pourtant impératif d'avoir votre liste des pages indexables inactives...

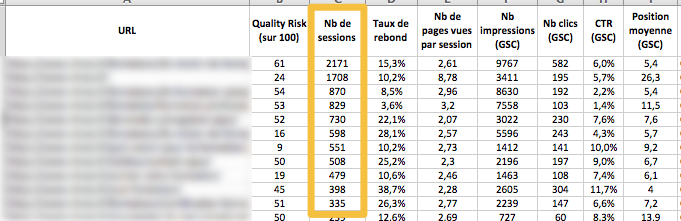

En plus d'automatiser ces récupérations de données et analyses croisées, vous aurez tout sous la main comme vous pouvez le voir dans cet extrait d'annexe :

Encore mieux que l'analyse des pages actives sur 1 an

Quand on parle de "page active", il s'agit d'une page qui a généré au moins 1 visite. OK, mais que dire des pages qui n'ont généré qu'une seule visite en 1 an ? Ou même 2, ou 10 ? Reconnaissez que c'est encore extrêmement peu.

Je ne sais pas où il faut fixer un seuil (donnez-moi votre avis dans les commentaires), mais pourquoi pas le fixer à 1 visite par jour ? Mon idée est la suivante :

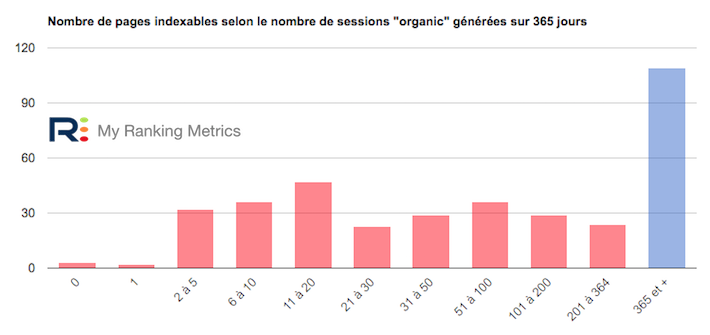

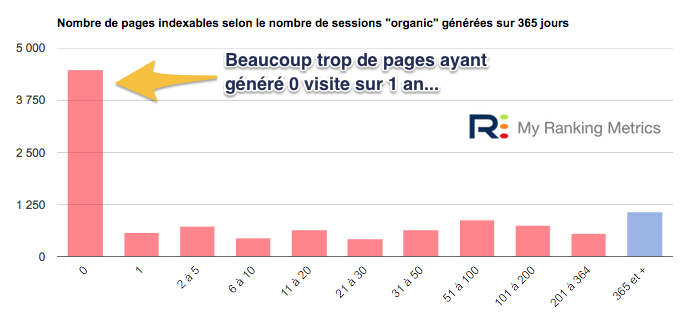

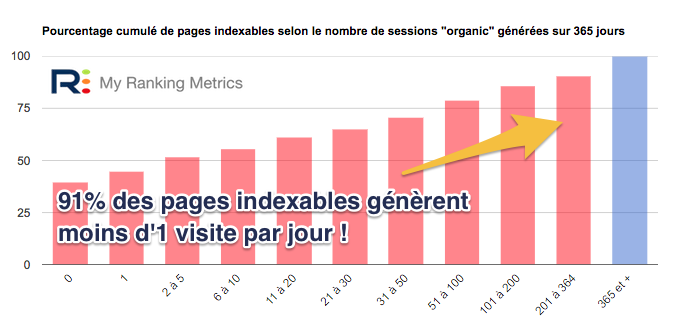

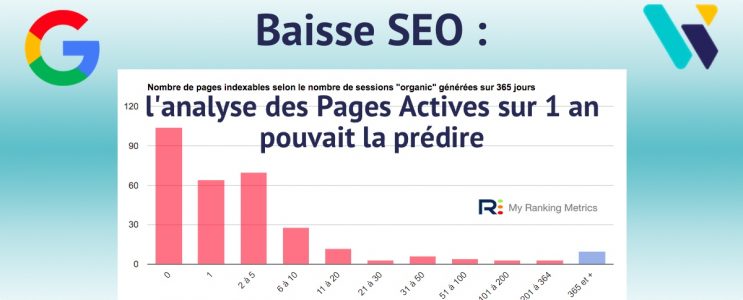

C'est pourquoi j'ai décidé d'ajouter un nouvel histogramme dans les rapports d'audit de mon outil RM Tech. Il indique combien de visites vos pages indexables ont généré en 1 an. Vous voyez tout de suite non seulement combien de vos pages n'ont rien généré du tout (pages inactives), mais aussi les performances des autres. Car si vous en avez beaucoup qui n'ont généré qu'une seule visite en 1 an, c'est quasiment des pages inactives...

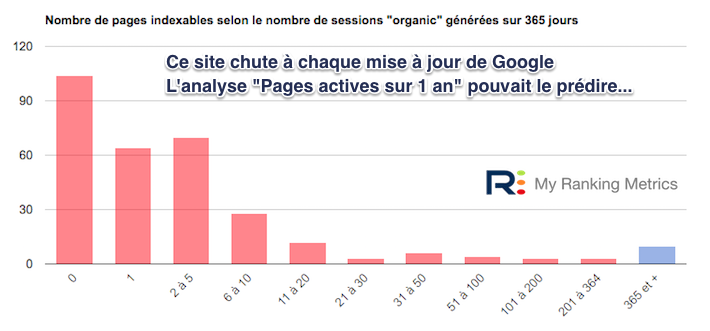

Voici un exemple (j'en présente d'autres dans le reste de l'article) :

Bon, après ces définitions, place aux exemples concrets.

Exemples de sites audités sous l'angle des pages actives sur 1 an

Parmi tous les sites que j'ai étudiés, voici quelques exemples : 2 sites dont le référencement chute, 1 qui s'était effondré et qui est remonté et 1 dernier qui progresse en permanence.

Parmi les 43 sites étudiés, il y en avait environ 1/3 qui ont chuté brutalement (à une mise à jour de Google), les autres subissant une baisse régulière de leur trafic "organic".

Pour vous aider à mieux vous rendre compte de l'importance de cette métrique "Taux de pages actives sur 1 an", je vous montrerai aussi des exemples de sites qui cartonnent dans Google.

Exemple 1 : grosses chutes du trafic SEO

Je commence par un des sites étudiés, qui a connu une très forte baisse de son trafic SEO à chaque mise à jour Google depuis 2017 :

La même analyse dans Google Analytics (j'ai eu accès à son compte) :

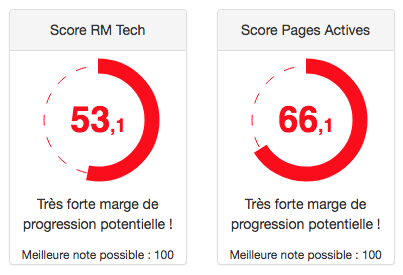

L'audit RM Tech révèle immédiatement que ce site cumule trop de problèmes :

Mon audit a montré que seulement 66% des pages indexables ont été actives sur les 365 derniers jours !

Pire encore, même parmi les pages actives, un grand nombre n'ont généré que quelques visites en 1 an :

Mesurer le taux de pages actives sur 1 an permet de se rendre compte de la situation du site, en termes de référencement. Ici, j'ai fait l'analyse après coup, c'est-à-dire après les chutes et sachant qu'il avait chuté. Mais connaître ce taux en amont permet d'anticiper les choses et d'éviter ce type de situation très difficile à vivre.

Ensuite, passer en revue les pages inactives permet de comprendre les problèmes et de trouver des solutions. C'est ce que je détaillerai dans la suite de cet article.

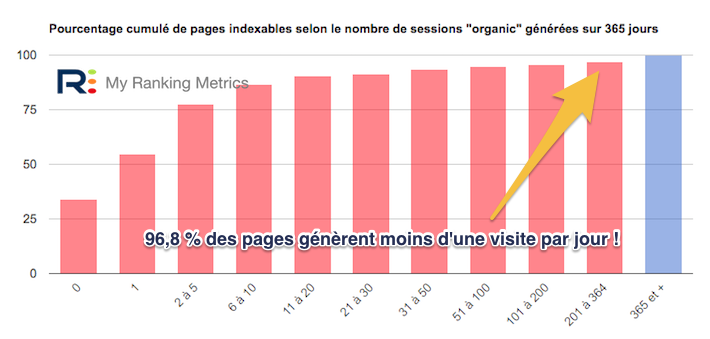

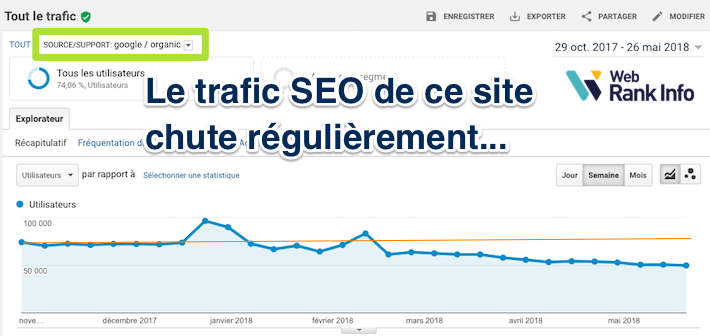

Exemple 2 : chute régulière du trafic SEO

Je continue avec un autre exemple de site qui ne s'en sort pas très bien avec l'algo actuel de Google : son trafic naturel baisse de façon inéluctable...

A votre avis, pouvait-on prévoir ça avec l'analyse des pages actives sur 1 an ? Mon audit a montré que seulement 60% des pages indexables ont été actives sur les 365 derniers jours !

Pire encore, même parmi les pages actives, un grand nombre n'ont généré que quelques visites en 1 an. Pour être précis, l'histogramme cumulé me l'indique directement : 91% des pages génèrent moins d'une visite par jour !

Je vous expliquerai plus loin ce qui ne va pas sur ce site. Mais avant cela, passons aux exemples de sites qui cartonnent...

Exemple 3 : hausse régulière du trafic SEO

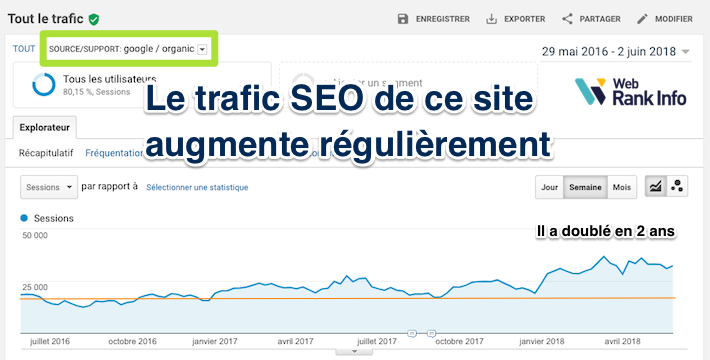

D'abord, la courbe de son trafic organique Google (il a doublé en 2 ans) :

Ce site a 410 pages indexables, dont 409 d'actives sur 1 an (la dernière étant les mentions légales...). Pas de surprise pour moi qu'il fonctionne si bien !

Pourtant, l'histogramme ci-dessous me montre un potentiel de croissance avec certaines pages qui génèrent encore trop peu de trafic.

Je trouve ce type d'affichage utile pour se rendre compte en un coup d'oeil de la situation.

Exemple 4 : remontée spectaculaire du trafic SEO

Mon dernier exemple est le site qui a "sauvé son SEO". La courbe du trafic issu du référencement naturel Google parle d'elle-même :

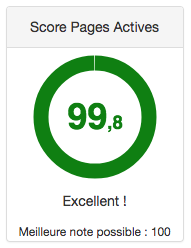

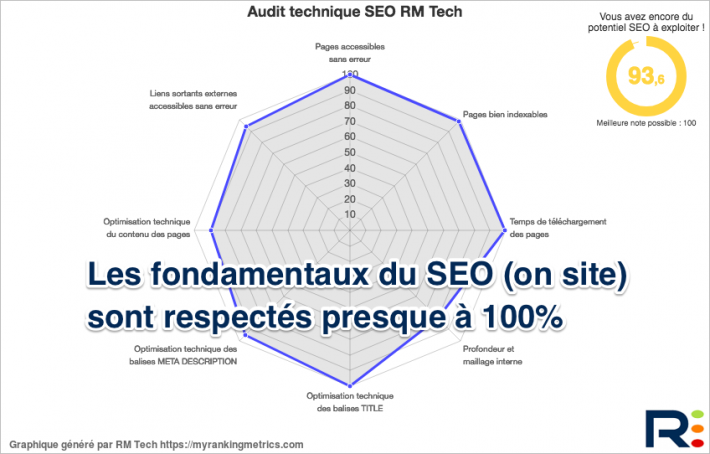

Il a commencé à travaillé avec la méthode "Analyse des pages actives SEO sur 1 an" en février 2018, en découvrant ma plateforme My Ranking Metrics. A ce moment, il avait 61% de pages actives sur 1 an, soit un score beaucoup trop faible.

Concrètement, il avait 1524 pages indexables, dont 580 d'inactives. Il a fallu beaucoup de travail, mais au moins il savait exactement quelles pages traiter et quoi faire avec elles.

Voilà à quoi ressemble les performances de son site pour les 8 familles de critères de RM Tech :

Et maintenant ça donne quoi ?

Désormais il a 1090 pages indexables, dont seulement 187 d'inactives. Il est ainsi remonté à 83% de pages actives sur 1 an (et encore, ça ne fait que quelques semaines que son trafic est remonté).

- les pages actives sont celles qui ont généré des visites (référencement naturel) sur une période donnée

- analyser les pages actives sur 1 an révèle des informations précieuses sur un site

- le taux de pages actives sur 1 an (parmi les pages indexables) indique l'état de santé SEO du site

- conserver un trop faible taux de pages actives sur 1 an est risqué avec l'algo de Google (évaluation de la qualité)

- si ce taux est trop faible (< 70%) il faut améliorer les pages ou au pire en supprimer (sans risque de perdre du trafic...)

- parmi les pages actives, celles qui génèrent très peu de visites par an doivent également être analysées

J'aimerais savoir ce que vous pensez de tout ça ? Dites-le dans les commentaires !

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Retour d'expérience : après avoir éliminé mes pages inactives, passant de 92000 pages indexées mi février 2018 à 300 pages indexées en septembre 2018. Je suis passé de la 17ème place (punition Google avril 2018) à la 5ème place début aout 2018 sur LE mot clef principal de mon activité. De plus j'ai gagné une place dans mes mots clefs de "moyenne" traine (passant de 3ème à 2ème postion voir première).

Par contre je m'offusque de voir mon concurrent avec plusieurs centaines de milliers de pages (forcément inactives) pour un site comptant environ 200 pages (vu avec outil RTM) n'avoir subit aucune "punition" Google. Olivier si tu veux l'URL de ce site en message privée pour analyse, pas de problème.

Bravo Fred pour la remontée du ranking!

Je partage complètement ce sentiment de ne pas toujours être traité avec équité par rapport à ses concurrents. J'ai aussi des exemples dans mon secteur de sites bien mieux classés que mon site mais dont le bon classement reste pour moi énigme:

Exemple1: Un site avec des dizaines de milliers de pages avec un contenu très faible, plein de pub, qui semble avoir fait une remontée spectaculaire avec l'update Medic du mois d'aout!

Exemple2: contenu faible de très nombreuses pages, certaines n'ont même aucun contenu et sont indexées, chaque page contient des dizaines/centaines de liens internes avec la même ancre, un profil de backlinks qui n'a rien d'exceptionnel, etc... et pourtant ce site est le leader sur la thématique, en première position sur tous les mots clés.

C'est assez frustrant quand on arrive pas à comprendre pourquoi ;-)

Bonjour,

J'ai une boutique de vêtement d'environ 500/550 produits, certains produits n'ont pas de visite depuis 1 an et invendu et j'avoue certain sont dépassé, année de la mise en ligne du produit 2012 ...

je me suis cassé la tête à faire 350 mots minimum par page sans duplication.

je peux réutiliser le texte en l'adaptant sur des produits similaires, mais j'aurai 90% de la description dupliqué, le produit sera changé de catégorie, du coup le lien changera aussi,

Si je fais une redirection vers le nouveau produit Google prendra comme une duplication ?

Par contre votre outil m'a permis de connaitre des pages que j'avais laissées à l’abondant avec une description de 50 mots et des photos .... à faire fuir le client et qui généré 700/800 visites an

cordialement

Tant mieux si RM Tech a permis d'identifier plein de produits dont l'URL n'a généré aucune visite en 1 an et qui sont dépassés : a priori, sauf cas particulier, il faudrait les supprimer du catalogue (et renvoyer un code 410 pour les pages concernées).

A quoi bon faire des textes de 300 mots en faisant attention à la duplication si le produit est totalement dépassé ?

Il est possible de réutiliser le texte sans problème, puisque les pages où il était vont être désindexées.

Enfin, si RM Tech a trouvé des pages performantes malgré une faiblesse du contenu, ça veut dire qu'elles ont un fort potentiel. En les améliorant, elles devraient générer encore plus de visites et donc de ventes.

Bonjour Olivier,

Merci pour votre retour.

Vous pouvez me confirmer pour mettre une page en 410

j'ai trouvé sur un forum:

La seule solution c'est de passer par Google Webmaster Tools

Vous allez dans "Optimisation"

Vous sélectionnez "URL à supprimer"

on m'avait conseillé de gardé les produits, car c'est toujours un plus .... plus de contenu pour google bref.... faut faire attention à certaine personne sur les forums...

puis par la suite je me suis dit c'est bête de garder un produit avec un design moche... le client arrive sur le site il risque de s'enfuir.... mais bon j'ai tellement pris de temps pour rédiger mes articles que j'avais du mal à supprimer^^

mais votre outil m'a booster à me décider et encore plus quand vous me dites que je peux réutilisé mes textes pour d'autres produits

Bonjour,

Si je fais une redirection sur la catégorie parente, google va automatique supprimer le produit et d'ici 1 à 2 mois ? je pourrais utiliser la description ?

Je vais supprimer 220/250 produits entre 0/5 visites an, mais invendu depuis 2 ans voir 3 ans ....

Faire une redirection vers la catégorie parente est conseillé dans les rares cas où la fiche produit a reçu des (bons) backlinks issus d'autres sites.

Sinon il faut renvoyer un code 410, si possible avec des explications à l'écran pour l'internaute qui tomberait dessus (lui expliquant que le produit n'est plus en vente, et lui fournissant des liens vers des produits similaires, ou une/des catégorie(s) à visiter.

Bonjour,

Merci je viens de réussir à faire la redirection 410 + la personnalisation de la page produit

c'est très compliqué sur prestashop heureusement j'ai trouvé un module https://eoliashop.com/redirect-SEO + il m'a donné les lignes de code pour afficher la catégorie parente.

Demain je commence la suppression de produit, je reviendrai faire un retour d'ici quelques mois

Encore merci pour vos conseils et d'avoir pris le temps de me répondre

Détail : 410 n'est pas une redirection. Il faut bien vérifier tous les codes avec des outils appropriés.

Erreur de ma part ce n'est pas une redirection j'ai bien la page 410 expliquant que le produit n'est plus disponible avec lien pour la catégorie parente

j'ai fait un test ici http://www.redirection-web.net/ j'ai bien le code Gone (410)

Bonne soirée

Bonjour, très intéressant cette article. Néanmoins, dans mon cas, quelle stratégie adopter sur un site d'actualités (jeux vidéos) ?

Une news qui date de plus d'un an doit elle être supprimée ? (sachant quelle n'est plus pertinente et n'a généré qu'une seule visite).

Merci !

Si tu dis toi-même qu'elle n'est plus pertinente, autant la supprimer non ?

Je vais en parler dans la 3ème partie de ce dossier (qui sera bientôt publiée).

En gros, concernant les actus, si l'internaute arrive sur une très vieille actu mais que la date est clairement indiquée et qu'il est logique que le contenu n'ait pas changé (car cela ne le nécessitait pas), je ne pense pas que ça pose problème.

Cela dit, c'est à vous de choisir, si vous souhaitez supprimer des actualités vraiment très vieilles et jamais consultées, cette méthode vous aide à les repérer.

1 avantage de plus pour un site en one-page :) . Très bon article, merci

L'avantage est d'avoir 100% de pages actives, mais l'inconvénient est que c'est peu performant du point de vue SEO ! Ou alors adapté à des cas très particuliers.

Bonjour Olivier, et merci pour cette analyse précieuse.

Pour info, le crawl sur 365 jours me montre 22 % de pages inactives. Tandis que le crawl sur 90 jours me montre 40 % de pages inactives.

La logique voudrait donc que je me concentre sur le crawl de 90 jours, ce qui donne 794 pages actives et 535 inactives.

Après un rapide coup d'œil, sur ces 535 pages inactives environ 300 ne peuvent pas être mises à jour car leur contenu n'est plus d'actualité et ne présente plus d'intérêt aujourd'hui pour les internautes.

Je vais donc procéder à des regroupements de pages ainsi qu'à des désindexations, mais avant de faire des bêtises j'aimerais solliciter votre opinion.

Concernant ces pages que l'on ne peut pas mettre à jour, qu'est-ce qui est mieux pour le SEO : les désindexer et regrouper en 301, ou tout simplement les supprimer ?

Merci d'avance.

Comme expliqué dans mon article, je recommande de se baser sur une analyse de 365 jours et non pas seulement 90 jours.

Ensuite, pour savoir ce qu'il faut faire des pages concernées (inactives sur 1 an), ça dépend des situations. Je n'ai pas encore fini mais je l'expliquerai dans la 3ème partie de ce dossier...

En gros, il faut récupérer d'autres données spécifiques au site (nb de consultations de la page, CA généré, backlinks, etc.) puis prendre une décision "humaine".

désindexer seulement, ça veut dire que l'internaute peut la consulter. Sort-elle du maillage interne ? c'est à décider

regrouper en 301, ça signifie même thématique et fusion des différents contenus. ou bien suppression des contenus : à décider

supprimer, ça renvoie un code 404 (parfois 410) : pourquoi pas, c'est aussi une solution

C'est fait, je viens de désindexer les pages non-actives depuis 90 jours (il y en avait plus que sur le 365 jours).

Resultat sur MRT :

- score global passe de 85,8 à 86,2

- score pages actives passe de 78,1 à 97,4.

Je l'ai ajouté dans la discussion ici : https://www.webrankinfo.com/forum/t/que-faire-des-pages-inactives-ne-presentant-plus-dinteret.193647/#post-1576923.

J'ai pourtant bien précisé qu'il vaut mieux se baser sur 1 an et pas 90 jours. C'est normal qu'il y ait plus de pages inactives sur une courte période...

Merci, un rappel de la partie 2:

#1 Manque de contenu dans la zone principale

#2 Contenu qui n’est plus à jour et fausses promesses

#3 Qualité insuffisante sur la page

#4 UX et/ou design catastrophique

#5 Trop de pub envahissante

#6 Pages bien trop profondes

#7 Masse noire

#8 Temps de téléchargement et de chargement énormes

#9 Trop de pages non indexables mais crawlables

Je poste ce message pour m'abonner aux commentaires de cette page si possible.

Bonjour,

Très bon article qui m'a bien servi pour évaluer et commencer a réécrire mes articles de fond qui ne généraient pas assez ou pas de clics sur un an ( j'ai mis la barre a 24 -> 2 par mois mini ) je n'ai pas encore de retour, patience !

Par contre je lis qu'il faut améliorer ( et pas forcément supprimer ou désindexer) les pages avec trop peu de visites sur 1 an, je ne sais pas comment faire pour la partie forum qui représente 90% du site ( j'ai environ 40.000 sujet ) je n'en maitrise pas le contenu puisque c'est les membres qui l'alimente, j'ai bien pensé a supprimer les sujets sans réponse de plus de X mois et de moins de Y mots qui ne génèrent pas assez de visites ( ca sera déjà ca ) , mais il y a les autres, ceux qui sont du blabla pour ne rien dire, les réponses lol ou +1 , et la il faudrait une IA pour les repérer.

je suis dans un cas de figure similaire, avec 3x plus de discussions...

Et donc que prévois tu de faire sur le forum WebRankinfo, est ce le forum qui explique la chute de trafic de WRI depuis janvier 2017 (d'après Semrush) ?

Malheureusement pour SEMrush, cette courbe est vraiment très loin de la réalité. On dirait qu'elle accentue aussi bien les sommets que les gros trous !

Il s'est passé bcp de choses aussi bien chez Google que sur mon site, qui expliquent ces turbulences. Plus récemment (début 2018) j'ai également retiré l'annuaire.

J'applique sur WebRankInfo tous les conseils que je recommande (à vrai dire, je les applique des mois voire années avant). Par exemple, j'ai supprimé 1000 articles (parfois regroupés ou déplacés, pas tous réellement supprimés). Sur le forum j'ai supprimé pas mal de discussions et je continue de le faire quand je trouve le temps.

Bonjour Olivier,

J'ai commencé la lecture du dossier qui est très intéressant. Cependant, en voulant analyser mon site pour comparer les résultats, je suis bloqué sur GA. En effet, si j'utilise le segment "Organic", la vue maximale est de 3 mois. De ce fait, l'analyse tombe à l'eau...

Tu dois confondre avec Search Console, car il n'y a pas cette limite de 3 mois dans Google Analytics

Autant pour moi, j'ai utilisé un mauvais segment. J'ai réutilisé le bon : "Trafic généré par les résultats naturels" et je retrouve la bonne période d'analyse.

Hâte d'avoir la suite du dossier.

Pour les pages actives vous confirmez que vous utilisez "Comportement > Contenu du site > Pages de destination" ?

Moi j'ai l'habitude d'utiliser "Acquisition > Campagnes > mot clé naturel (page de destination)" mais les chiffres sont légèrement différent...

Oui j'utilise habituellement « Comportement > Contenu du site > Pages de destination » avec un segment "Trafic généré par les résultats naturels".

Chez moi les valeurs sont identiques au rapport que vous indiquez.

Pour mon blog qui traite d'évènements ponctuels, les articles plus vieux de 3 ans ne rapportent pas (ou peu) de trafic. Je pense que si mettais à jour ou améliorais le contenu, il n'auraient pas plus de visite car ils n’intéressent (et n’intéresseront plus personne). J'envisage de les supprimer, qu'en pensez vous ?

en effet, ça peut valoir le coup d'en supprimer. Ne connaissant ni le site ni le contexte, je ne peux pas l'affirmer.

ça me rappelle l'audit d'un site qui avait des milliers d'actu remontant à + de 10 ans en arrière. Le pire étant un article du genre "Finalement, la kermesse de l'école XYZ aura lieu le 12 juin et non pas le 10 juin". 10 ans après, on se passe volontiers de cette actu ;-)

Merci pour cet article très intéressant !

Pendant un an, j'ai publié sur mon blog de courts conseils quotidiens. Avec Google Search Console, je viens de voir que sur les 90 derniers jours, seules 238 pages sur 602 ont eu des clics. Parmi les pages qui n'ont pas eu de clics, beaucoup sont des conseils similaires, qui pourraient être regroupés dans des articles plus longs. J'imagine que ce sera tout benef: avoir des articles plus longs et moins d'articles sans clics.

Exactement Jérôme, c'est ce qu'il faut faire ! Et si certains conseils ne sont plus du tout applicables, il faut les supprimer.

Merci pour ce dossier à la fois intéressant et utile.

En revanche, est-ce que cela ne dépend pas également de la typologie de site ? Pour un e-commerce, je comprend que chaque page produit doit être active (avoir des visites purement SEO).

Mais prenons l'exemple d'un site plus informatif. Par exemple si je crée un site sur la ville de Bordeaux. Je peux avoir des pages qui répondent à une intention de recherche (que visiter, où sortir, où se loger...) mais il y aura également certainement des pages qui décrivent des endroits précis, des quartiers, des petites rues.

L'internaute ne connait pas forcément le nom précis de ces endroits et les pages génèreront pas ou peu de visites SEO. Pourtant elles participent à la qualité du site, et l'internaute va forcément y aller durant sa navigation.

Ces pages à elles seules sont même la véritable plus-value d'un tel site. Elles en constituent la substantifique moelle. Elles n'ont que peu d'intérêt SEO mais vont aussi permettre de pousser les pages plus généralistes (qui elles ont un intérêt SEO) via le maillage interne.

Si ces pages ont une "véritable plus-value", je ne doute pas que des internautes les trouveront en faisant des recherches dans leur moteur.

Encore une fois, un outil (comme RM Tech) aide à repérer des choses difficiles à repérer manuellement, mais au final c'est bien à vous de réfléchir et de s'adapter à la situation.

Bonjour,

Peut-on provoquer la visite des pages pour qu'elles soient considérées comme actives ?

Exemple : j'ai 360 produits, chaque jour je poste un lien sur Facebook avec un petit descriptif qui provoque le clic vers la page...

merci

On veut que les pages soient actives non pas pour faire plaisir à Google ou avoir une pastille vert dans un rapport d'audit, mais pour que des internautes arrivent sur notre site et remplissent nos objectifs (ecommerce, publicité, contacts, etc.). Il n'y a donc strictement aucun intérêt de simuler des fausses visites, ou de polluer sa page Facebook de cette façon...

Bonjour, merci pour cet article !

Cependant je reste avec une question, jusque où faut il aller dans certaine situation ?

Imaginons un site e-commerce qui vend des bouquets de fleurs, il aura traditionnellement des catégories par budgets, par occasions, par couleurs qui pourront avoir des textes descriptifs... mais aussi des dizaines de fiches produits de bouquets de fleurs qui se ressembleront toutes (à l'exception d'une description minuscule, d'un changement de nom de bouquet et de photo). Ces pages présentes en quantité ne seront donc pas de bonne qualité (manque de contenu) et ne généreront pas de visites depuis Google.

Faut il qu'un site de ce genre indexe uniquement ses catégories ?

Excellente journée à vous et merci pour vos éclaircissements !

ça fait très longtemps que j'explique que dans le cas (rare) d'un site qui vend des produits ultra basiques, il ne faut pas faire indexer (et même crawler) les pages produits, il faut se concentrer sur les catégories. En formation on donne l'exemple d'une catégorie "gommes" ou "trombones"

pour les bouquets de fleurs, je ne me rends pas compte si ça rentre dans ce cas de figure

Complètement d'accord avec cette analyse.

Je ne suis pas allez aussi loin que toi, mais j'ai constaté ce problème chez pas mal d'e-commerçant ainsi que sur mon blog.

J'ai donc supprimé plus de 100 articles qui n'étaient pas assez bons et n'amenaient pas ou peu de trafic organique.

Résultat j'ai vu mon trafic monter :).

J'ai des clients sur prestashop qui ont utilisé mon module NoIndex (https://www.store-opart.fr/p/37-module-no-index.html) pour désindexer les pages de trop mauvaise qualité (parce qu'ils n'avaient pas le temps de les améliorer) et ils ont vu aussi leur trafic remonter.

Merci Olivier pour ton retour d'expérience. Il ne faut tout de même pas oublier que c'est toujours mieux d'améliorer une page que de la mettre en noindex, mais c'est très intéressant de trouver encore de nouveaux exemples qui illustrent bien le fait que nettoyer pour ne garder que des bonnes pages aide au référencement.

Bonjour,

je suis dans le même cas de figure que sunnmagic, beaucoup de produits, avec des pages bien optimisées, du texte...mais très peu de visites.

Je rebondis sur la remarque d'Olivier Clémence car j'a testé le module noindex qui n'a pas donné les résultats escomptés.

Mais couplé avec cette nouvelle analyse d'Olivier Duffez, qui me permettra d'analyser quelles pages sont les moins intéressantes pour les désindexer grâce au module noindex, donnera peut-être des résultats...

Je croise les doigts ;) (mais pas trop sinon je ne peux pas taper sur le clavier)

BOnjour, très bon article, merci

pour ma part j'ai ce jour un site d'environ 700 pages indexables et indexées.

Après analyse il y a environ 600 de ces pages, qui sont très utilisées en interne par mes utilisateurs (une sorte d'assistant de recherche produit), mais qui ne génère effectivement (quasiment pas) de trafic DIRECT depuis moteur de recherche Google.

SI je comprends bien la démarche, il s'agit d'un masse noire qu'il faudrait que je désindexe.

Ok mais cela représente 85% de l'ensemble de mes pages.

Si je fais le "désindexage" n'y aurat-il pas un effet de bord ? genre Google dira un site de quelaues dizaines de pages, c'est un site inintéressant .

Qu'en pensez-vous ?

Merci Fred pour ces commentaires.

1- Avec quel outil ou quelle méthode avez-vous obtenu ces chiffres ?

2- avant toute désindexation, il faut comprendre la cause et toujours tenter d'abord de conserver la page en l'améliorant

j'ai utilisé votre outil RTM qui me signifie que ces 600 pages sont de trop faibles contenus. En effet elles n'affichent que des vignettes produits (attention il ne s'agit pas d'un site e-commerce) répertoriés par catégories (chaque catégories étant une page).

Puis sur GG Analytics, je constate que ces pages sons pas ou très peu cliquées depuis moteur de recherche et que le taux de rebond est important

Don je me suis dit que si j'améliore le contenu de ces pages (masse de travail énorme, et pas forcément judicieux pour mes utilisateurs) j'aurai , je pense, toujours un taux de rebond important (car l'objet de mon site n'est pas de vendre des produits)

qu'en pensez- vous ?

Sans savoir de quel site il s'agit, je ne peux pas en dire plus.

Merci pour cet excellent article :)

Quand on a des centaines de pages produits et/ou catégories inactives depuis 1 an, quelle est la meilleure stratégie à adopter ?

Des centaines de fiches produits qui génèrent aucune visite à l'année ? Je ne sais pas combien il y en a en tout, mais c'est clairement un gros problème. Ces produits se vendent-ils ? Sont-ils super bien décrits ? Le site a-t-il des problèmes techniques ou des sous-optimisations "évidentes" ? Voilà le genre de questions qu'il faut se poser à mon avis.

Je donnerai pas mal de pistes dans la prochaine version de mon article, avec des exemples.

Oui, aucune visite à l'année.

En effet, c'est un gros problème... Tous les produits ne se vendent pas, clairement.

En termes de contenu, les fiches sont très complètes avec des textes conséquents (description du produit, caractéristiques techniques, exemples d'utilisation, etc.), la structure Hn est respectée, et les balises Title & Description sont bien renseignées...

Il n'y a donc - à priori - pas de problème technique ou de contenu :/

Très intéressant (comme d'habitude), mais ça soulève aussi des questions quasi-existentielles.

Bon, l'exemple caricatural reste les mentions légales ; il est normal qu'une telle page ne génère pas de trafic.

Mais qu'en est-il de certaines pages essentielles bien que peu porteuses ?

Un exemple concret serait une page de support sur un produit. Dans l'idéal, personne n'en a besoin, mais si d'aventure c'était le cas, sa présence est nécessaire.

Pour des raisons évidentes, elle ne va pas être incluse comme une partie de la page du produit. Elle sera donc différente, avec très peu de visites (ou alors il faut carrément revoir le produit !).

Il est pourtant essentiel qu'elle soit indexée en cas de besoin (et pas seulement accessible via de multiples pirouettes de l'utilisateur). Mais elle représenterait un poids mort, voir un handicap SEO pour l'ensemble du site ? Il est pourtant hors de question de la supprimer ou de la désindexer.

Voilà la principale question que soulève la lecture de cet article.

Bien cordialement.

Merci pour ton commentaire.

Pour les mentions légales, tu peux ignorer la page si tu veux, mais pour ma part je continue à la laisser indexable. D'ailleurs elle génère souvent des visites sur 1 an.

Pour les autres, la question est surtout "quelle proportion de l'ensemble des pages ces pages de support représentent ?". Ensuite, je ne sais pas à quoi ressemblent ces pages, mais :

- soit la page support est détaillée, répondant à plein de questions que se posent les utilisateurs, dans ce cas elle est de grande qualité et devrait générer des visites sur 1 an

- soit ce n'est pas le cas et la page pourrait être rapatriée sur la fiche produit (ou complétée si ça s'y prête)

Hop, j'y reviens après un moment d'observations et de recherches.

Déjà, c'est vrai que qu'elles sont faiblement, mais régulièrement visitées. Une politique de liens intelligente (c'est à dire basique : un lien sur du texte dans du texte descriptif), peut-être un peu de données structurées de ci de là, et les moteurs sont suffisamment "intelligents" pour faire le reste.

Bref, une construction somme toute basique suffit pour que la magie agisse : les moteurs remonteront comme des grands dès qu'un utilisateur leur posera une question.

Quant à ceux qui viennent directement sur la page produit à la recherche d'une réponse à une question, il leur suffit de savoir lire pour suivre le lien.

Pas besoin d'alourdir la page produit avec des informations non essentielles. Et la page, importante occasionnellement et peu porteuse servira exactement son propos quand il le faut.

Que du bonheur en somme :-)

Excellent dossier qui, malheureusement, va me filer du boulot en plus pour un moment ! :-D

Un qui sait vaut mieux que deux qui cherchent...