Je suis en contact avec pas mal de personnes dans le SEO et j'ai accès à pas mal de sites, ce qui me permet de faire un certain nombre d'analyses.

En permanence, j'évalue "l'état de santé référencement" de ces sites, que leur trafic organique progresse ou décline...

Dans ce dossier, je vais vous "révéler" les problèmes les plus fréquemment observés parmi tous les sites étudiés dont le SEO a chuté.

L'idée est la suivante... Mon conseil est très simple :

Si votre site est concerné par au moins 1 des problèmes ci-dessous, corrigez-le (les) complètement dès que possible. D'une part car la prise en compte par Google n'est pas immédiate et d'autre part car l'algo a besoin de constater une amélioration significative sur l'ensemble du site (pour vous faire remonter).

Pour chacun de ces sites :

- il a été étudié avec la méthode que j'ai appelée Pages Zombies SEO (par moi directement ou son responsable SEO). Cette méthode (incluse dans mon outil RM Tech) facilite l'identification des principaux problèmes et la priorisation des pages à corriger.

- des analyses complémentaires ont été faites, pour les critères non gérés par mon outil (par exemple les backlinks ou la publicité)

- j'ai observé que le site était concerné par 1 ou plusieurs des problèmes listés ci-dessous

- je ne peux pas garantir qu'il s'agit de la cause directe de sa baisse en référencement, mais j'affirme qu'il faut d'abord les corriger avant d'espérer remonter

En réalité, tout ce qui est détaillé ici s'applique aussi aux sites dont le SEO se porte bien mais qui comportent certaines faiblesses. En les corrigeant, le SEO pourrait s'améliorer.

Les problèmes suivants sont triés par occurrence décroissante. Cela signifie que j'indique en premier les problèmes les plus souvent rencontrés sur tous les sites que j'ai audités.

#1 Manque de contenu dans la zone principale

C'est de loin le problème le plus fréquent dans les sites que j'ai pu étudier et dont le SEO naturel ne fait que chuter. Ça ne fait que 20 ans qu'on dit que le contenu est important, il faut sans doute attendre encore avant que tout le monde le comprenne :-)

OK Olivier, combien faut-il de mots par page ? 300 mots c'est bon ?

Voilà ce qu'on me demande régulièrement. Cette indication de 300 mots a si souvent été donnée qu'elle semble faire SEO. Pourtant, il faut bien comprendre :

- ce qui compte, c'est que le texte soit intéressant. Inutile de faire du remplissage juste pour faire plaisir à l'algo de Google ou d'un outil d'audit.

- quand on parle de nombre de mots, c'est pour la partie principale de la page. Si la page est un article comme ici, c'est le nb de mots de l'article. Surtout pas de l'ensemble des mots présents dans la page, incluant le menu, la barre latérale, les zones complémentaires et le pied-de-page !

- la quantité attendue dépend du contexte et par exemple du type de site ou de page. Pour un dossier comme celui que vous lisez, 1000 à 1500 mots me semble un bon objectif (celui-ci dépasse les 3500). Il faut adapter les exigences en fonction du contexte.

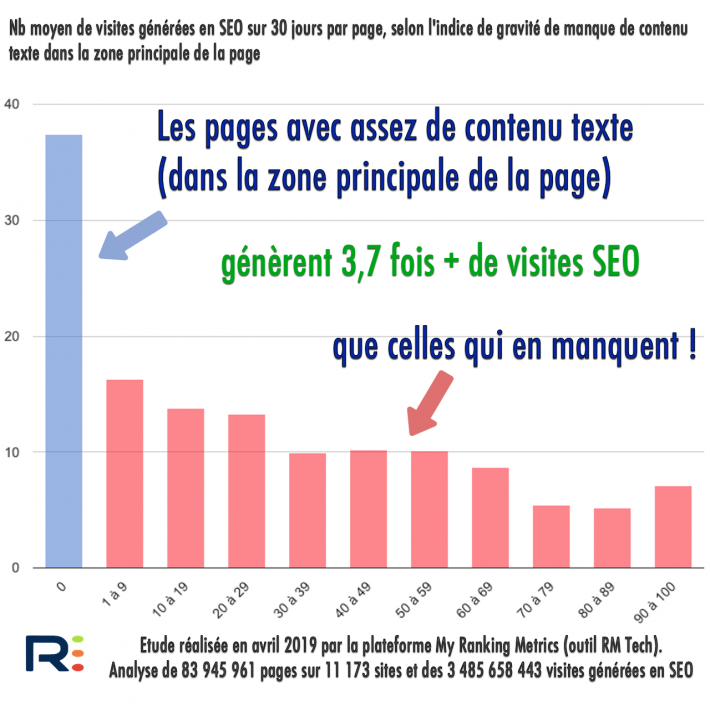

Dans mon outil d'audit, l'algo que j'ai fait développer tient compte de tout ça (à part la mesure de l'intérêt d'un texte, très subjectif). Pour valider que c'est un élément majeur du SEO, j'ai fait une étude sur des milliers de sites et des milliards de visites générées par le SEO naturel. Résultat : les pages qui ont suffisamment de contenu dans la partie principale génèrent ~4 fois + de visites en SEO que celles qui en manquent :

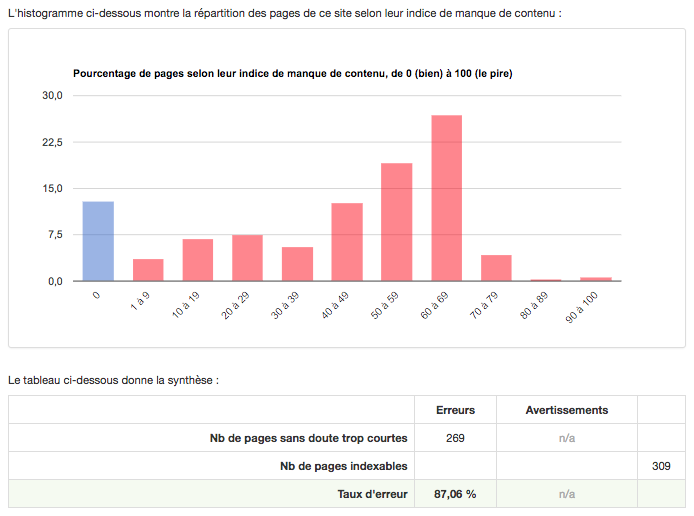

Je vais prendre l'exemple d'un site dont le trafic SEO s'est écroulé dans les 10 derniers mois. Voici comment se répartissent ses pages :

Il a donc seulement 13% des pages qui semblent avoir assez de contenu dans la zone principale.

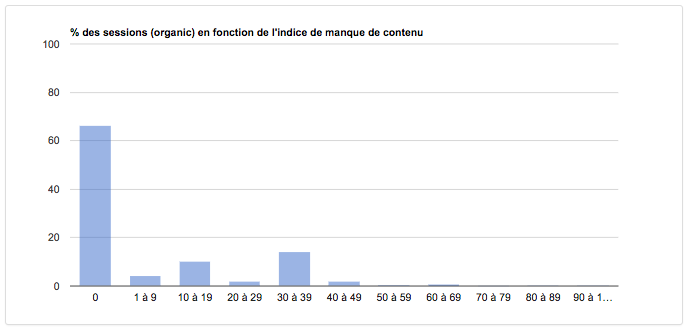

Si on regarde quelles pages lui génèrent des visites SEO (analyse sur 1 an) :

C'est clair non ?

#2 Contenu qui n'est plus à jour et fausses promesses

Comme je l'ai dit à plusieurs reprises :

Et comme Google ne veut pas décevoir ses utilisateurs, son algo est programmé pour rétrograder les sites qui déçoivent trop les internautes.

J'ai rencontré dans mon panel un paquet de sites avec 2 erreurs que je regroupe :

- des contenus dépassés, plus à jour 📆 : l'internaute s'en rend compte très vite et perd confiance dans le site. Le "Trust" fait partie des 3 piliers pour un référencement naturel solide: Expertise + Authority + Trust (expertise, autorité et confiance).

- une fausse promesse 💔 : dans les SERP, l'internaute clique sur votre résultat car le titre (et/ou le descriptif) laissent entendre qu'il trouvera ce qu'il veut. Arrivé sur la page, la réalité est toute autre ! Le pire étant quand le but du site n'est pas de fournir l'information ou la solution que l'internaute voulait, mais de lui proposer d'acheter un produit ou un service, ou de lui demander de remplir un formulaire (lead). Faites attention à votre titre (balise title) : certes, il doit inciter au clic, mais doit correspondre au contenu de la page.

Dans un style proche, j'ai aussi rencontré les erreurs suivantes :

- une agence immobilière qui laisse en ligne des annonces périmées depuis des années. Le but étant de montrer qu'en tout, elle a géré un grand nombre de transactions... Mais si dans 90% des cas l'internaute qui arrive de Google tombe sur une annonce périmée, que va-t-il faire ? Un retour en arrière dans les SERP, signal catastrophique pour le site...

- un gros site ecommerce qui laisse en ligne beaucoup de produits sans bouton d'achat. Il ne s'agit pas d'articles hors stock, mais non disponibles à la vente...

- un site à fort contenu éditorial avec des pages qui annoncent des événements à venir... mais passés depuis des années désormais. A supprimer !

- un pied de page affichant fièrement une année de copyright 3 ans en retard

- un lien mentions légales qui ne pointe nulle part (le fameux

<a href="#">)

Pour ma part, je ne sais pas (encore) repérer automatiquement ces pages à partir de leurs caractéristiques. Par contre, en analysant le nombre de visites qu'elles génèrent en 1 an (attention à ne pas prendre une période plus courte), j'en repère un grand nombre...

#3 Qualité insuffisante sur la page

Quand Google a commencé à dire que son algo (Panda en 2011) savait évaluer la qualité, comme vous j'ai été dubitatif. Mais j'ai totalement changé d'avis depuis. D'abord parce que j'ai constaté que globalement Google Panda savait plutôt bien le faire et ensuite parce qu'à mon petit niveau j'ai pu aussi le faire.

Concrètement, l'indicateur QualityRisk inclus dans mon outil évalue pour chaque page le risque que la page soit évaluée de mauvaise qualité (par l'algo Google ou par l'internaute).

On travaille à l'améliorer, mais cet indicateur est déjà très très efficace. Google Panda exploite plusieurs métriques afin de faire ressortir d'un site les pages qui cumulent trop de problèmes déceptifs pour l'internaute.

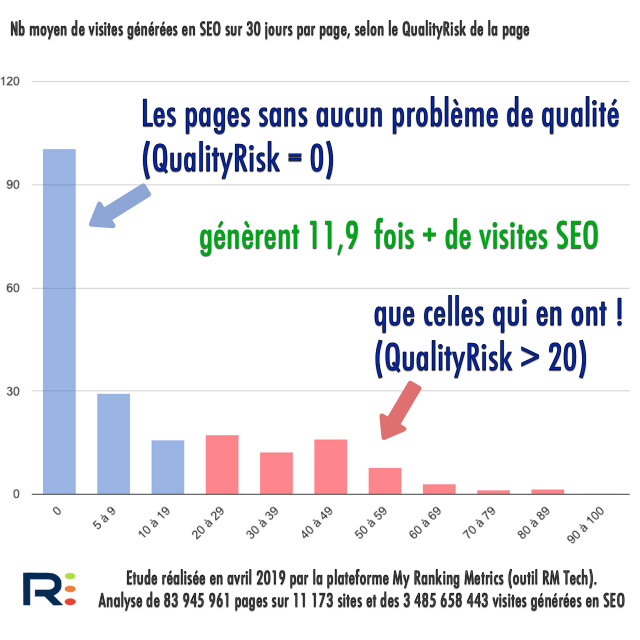

Toujours avec mon étude sur un énorme panel de sites, il en ressort que :

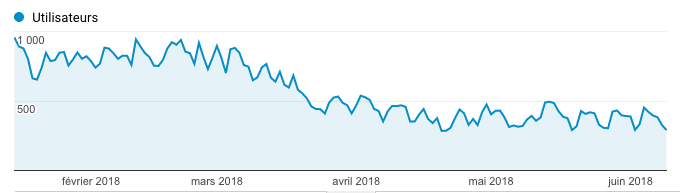

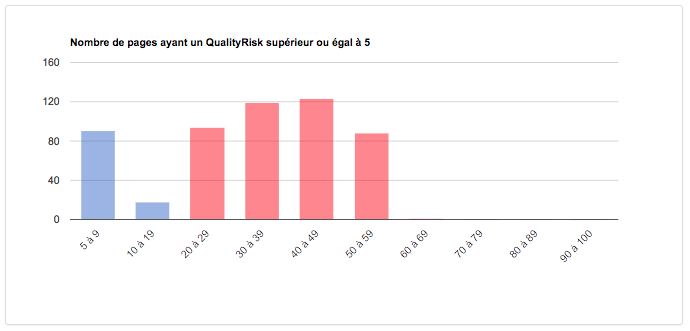

Concrètement, si je prends un autre site étudié dont le positionnement Google s'est écroulé au moment d'une mise à jour qualité/cœur de l'algo :

Voici comment RM Tech évalue le QualityRisk des pages (il faut viser un QualityRisk nul ou au moins < 20) :

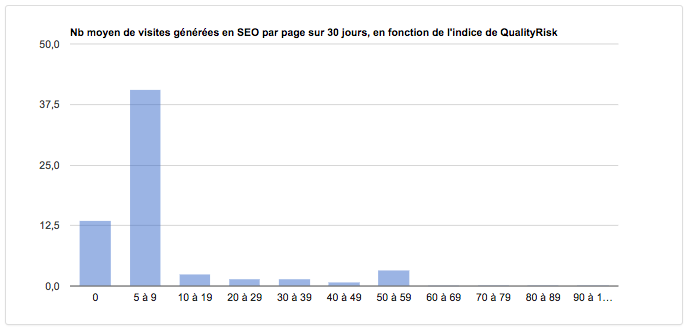

Et voici combien chaque page de ce site réussit à générer de trafic par mois, en moyenne :

En gros, seules les pages à très faible QualityRisk génèrent des visites, mais le problème est qu'elles sont peu nombreuses sur le site. Bref, selon moi et avec mon expérience, il est urgent de renforcer la qualité de ces pages à fort QualityRisk...

Parmi les sites de mon panel d'étude, j'ai pu trouver pas mal d'exemples de pages de trop faible qualité :

- des catégories sans aucun produit (ou article ou annonce) : l'impact est catastrophique...

- des catégories avec un seul produit (ou article ou annonce), sans aucun texte de présentation de la catégorie : c'est largement insuffisant

- une fiche produit trop faible avec à peine 3 lignes de descriptif

- des articles de blog formatés à 300 mots chacun, qui se révèlent souvent insipides

- plein de pages tags (souvent plus nombreuses que les articles eux-mêmes), sans aucun contenu spécifique

- des (grosses) pages dont 99% des mots sont cliquables

- dans un forum, des discussions (anciennes) sans aucune réponse

- dans un forum, les pages profil (ne présentant aucune information utile)

#4 UX et/ou design catastrophique

C'est difficile de lister ce qu'il faut éviter à tout prix, car c'est souvent une accumulation de détails, comme :

- le contenu principal n'est visible qu'en ayant fait défiler une partie de la page

- plein de bandeaux et autres pop-up ou pop-in empêchent une bonne lecture de la page

- la version mobile est inexistante ou très difficile à utiliser

- le design est très ancien, totalement dépassé

- le texte contient trop souvent du bourrage de mots-clés, ainsi que trop de mise en gras

- le menu est soit beaucoup trop touffu (méga menu), soit basé sur des libellés qui ne signifient rien pour l'internaute, soit inutilisable (bug technique)

Ces problèmes se cumulent souvent avec ceux liés à la publicité ou parfois à la vitesse du site (dont je parle ci-dessous).

#5 Des backlinks trop artificiels

Les backlinks c'est bien, excellent même s'ils sont de qualité. Ils ont un effet d'amplification des optimisations techniques et surtout éditoriales.

Tant que les stratégies de netlinking sont propres !

C'est là que survient le problème. Les petits "jeunes" qui n'ont pas connu les massacres de Pingouin ne se rendent pas compte qu'ils jouent avec le feu en achetant ou créant plein de SEO artificiels. D'autres ont bien connu cette époque, mais estiment que les pénalités Google sur les backlinks artificiels sont assez rares pour que ce soit intéressant de profiter des "SEO faciles".

Bref, j'ai vu un certain nombre de cas où la composante "backlinks artificiels" semble avoir joué dans la chute du SEO. Parfois de façon assez brutale.

C'est toujours difficile d'en être certain en étudiant un seul site. Mais quand on constate que plusieurs sites chutent vers le même moment et qu'ils partagent ce "problème", alors ça devient bien plus concret et évident.

#6 Un manque évident d'Expertise, Autorité et Trust

On a beau dire que E-A-T n'est qu'un concept destiné aux évaluateurs de la qualité des SERP - et non un critère officiel (ranking factor)...

Dans les faits, je vois de plus en plus de cas où le site chute en raison de manques d'une ou plusieurs des composantes "Expertise", "Autorité", "Trust".

Selon les secteurs d'activité, j'ai l'impression que l'une ou l'autre de ces notions est plus importante. Par exemple :

- dans le secteur médical ou la défiscalisation, l'expertise de l'auteur doit être évidente et bien supérieure à ce qu'on trouve dans les premières pages de Google

- pour un ecommerce, la confiance et la réputation doivent être au top. Ca ne veut pas seulement dire "aucun avis négatif", ça veut aussi dire des avis, des mentions de la marque, des éléments concrets qui montrent le sérieux...

#7 Trop de pub envahissante

Monétiser son site par la Google Panda, OK 👍

Envahir les pages de publicités de toutes sortes, qui deviennent plus importantes que le contenu, non ! 👎

Vous le savez bien que l'excès de pub est nuisible, en tout cas en tant qu'internaute. Alors pourquoi en tant qu'éditeur de site vous l'oubliez ?

Ce qu'il faut éviter à mon avis, en tout cas l'accumulation :

- pubs super bien intégrées dans le contenu afin que l'internaute ne fasse plus la différence (en gros, ne suivez pas l'exemple de Google avec ses Google Panda...)

- pop-up d'installation de l'appli mobile

- pop-up d'abonnement à des notifications

- pop-up d'abonnement à la newsletter

- pub interstitielle

- vidéos qui démarrent toutes seules (encore pire : avec le son activé)

- pub flottante dans la page, gênant la navigation

- liens affiliés très fréquents dans le contenu, pas toujours pertinents

- sites dont 90% du contenu est de l'affiliation (avec liens sortants incluant du tracking)

Je complète avec une courte citation des consignes de Google à ses évaluateurs de qualité (source, § Distracting/Disruptive/Misleading Titles, Ads, and Supplementary Content) :

Les pages qui perturbent l'utilisation du contenu principal doivent avoir une note faible. Une seule annonce en popup avec un bouton de fermeture visible ne perturbe pas trop, mais ne favorise pas l'expérience utilisateur. Voici deux exemples de situations que nous considérons comme perturbatrices :

- Les annonces qui flottent activement sur le contenu principal lorsque vous faites défiler la page et qui sont difficiles à fermer. Cela peut être très difficile d'utiliser le contenu principal quand il est en permanence recouvert par des pubs difficiles à fermer.

- Une page interstitielle qui redirige l'utilisateur loin du contenu principal sans lui permettre d'y revenir

#8 Pages bien trop profondes

Pour une fois, il s'agit d'un problème (a priori) facile à résoudre : des pages beaucoup trop profondes. Cela signifie que pour les atteindre en partant de la page d'accueil, il faut un grand nombre de clics sur des liens.

C'est pourtant archi connu : plus une page est profonde, plus ses performances SEO s'écroulent.

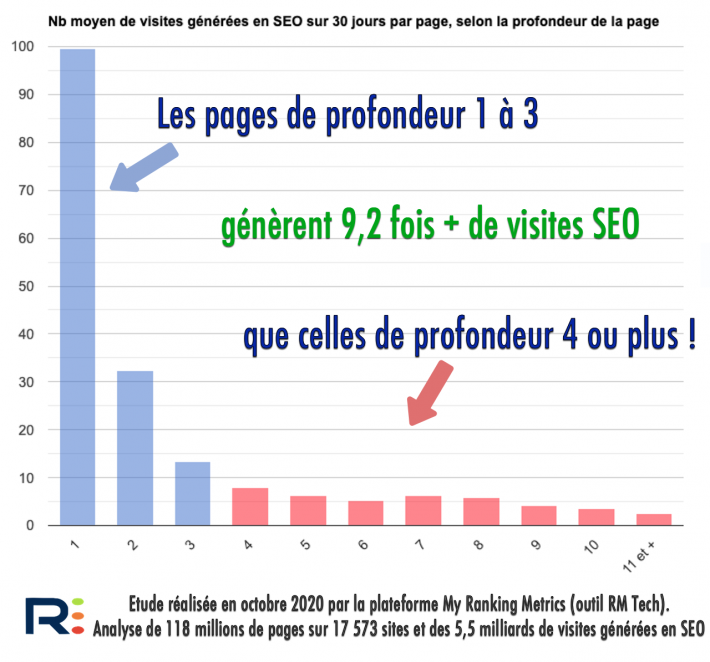

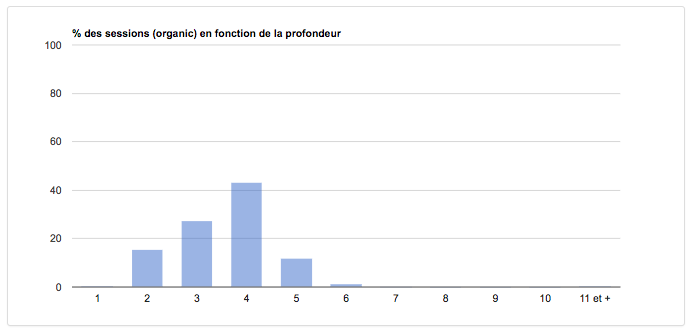

Je l'ai vérifié dans mon étude sur 117 millions de pages et 5,5 milliard de visites (source : Etude SEO de My Ranking Metrics) :

Je vais vous donner un exemple trouvé sur un site de mon panel d'étude.

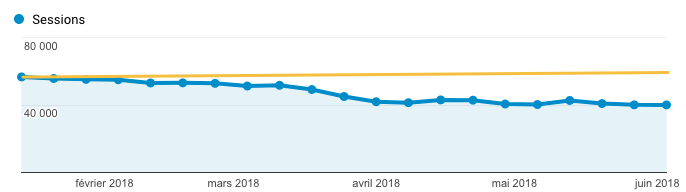

D'abord, son trafic organique est en décroissance :

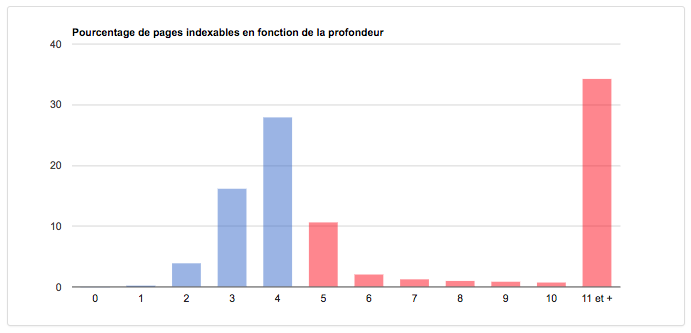

Son maillage interne est très mauvais et les pages bien trop profondes :

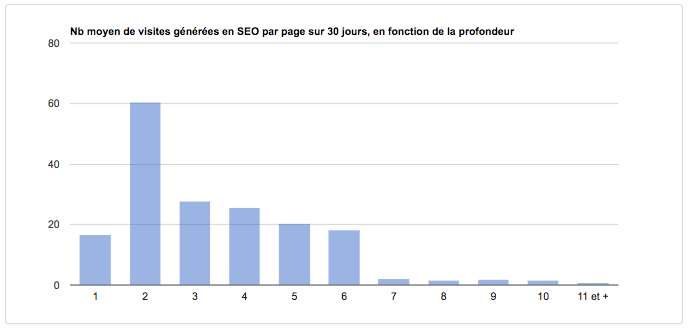

Maintenant, j'analyse l'efficacité SEO des pages selon leur profondeur :

Au final, quelles pages génèrent vraiment des visites en référencement naturel sur son site ?

Conclusion : même si ce n'est pas un problème de qualité, ni forcément un gros problème pour l'expérience utilisateur, avoir autant de pages si profondes nuit aux performances SEO. Ce site pourrait faire remonter son trafic très facilement en travaillant ce levier.

#9 Masse noire

Qu'est-ce que la "masse noire" en référencement ?

Ce terme désigne l'ensemble des URL crawlables et parfois indexables et qui n'auraient pas dû être crawlables ou indexables. Elles dégradent les performances SEO du site.

L'expression "masse noire" a été inventée en formation SEO par Fabien Facériès, cofondateur de Ranking Metrics ;-)

En gros, il s'agit des URL que Googlebot peut rencontrer sur votre site et qui n'auraient même pas dû être là, ou pas autorisées au crawl, ou pas indexables. Bref, ces URL perturbent le référencement, consomment du budget de crawl et dans le pire des cas peuvent modifier la perception de Google. En effet, si parmi ces pages la plupart sont de faible qualité, elles feront partie du périmètre d'analyse de Google et donc baisser la note moyenne du site.

Voici les cas les plus courants qui créent de la masse noire, trouvés sur les sites de mon panel :

- tout ce qui est lié aux fonctions de tri dans des catégories : elles rajoutent souvent des paramètres du type

orderbydans l'URL, qu'il vaut mieux bloquer au crawl (via le Google Panda) - une mauvaise gestion du "trailing slash", c'est-à-dire le signe

/en fin d'URL. Soit vous l'avez, soit vous ne l'avez pas, mais pas les 2. - des pages ayant rarement d'intérêt (à être crawlées ou indexées) comme les archives par auteur, mais aussi bien souvent les tags

- des URL dupliquées car l'article ou la fiche produit inclut la catégorie dans l'URL, et qu'il ou elle est présent dans plusieurs catégories, ce qui génère des contenus dupliqués

- des URL encore à l'ancien format, avant la réécriture d'URL

- des URL avec du tracking Google Analytics (alors qu'il ne faut pas en mettre dans les liens internes)

- des URL de la recherche interne (avec une infinité de possibilités), alors que Google recommande de ne pas les faire indexer

- des URL en minuscules et en majuscules

- des variantes de produits avec 3 tonnes de valeurs possibles

Je parie que Google répond toujours "ça ne pose pas de problème, on gère". En théorie oui, mais en pratique c'est autre chose... Avez-vous vraiment besoin de lui mettre des bâtons dans les roues ?

#10 Temps de téléchargement et de chargement énormes

Je distingue ici 2 types de mesures:

- le temps de téléchargement est le temps mis par un crawler (Googlebot par exemple) pour récupérer une ressource. En général on se concentre sur les HTML, mais ça concerne tout ce qui est autorisé au crawl : images, Google Panda, Google Panda, etc.

- le temps de chargement est le temps qu'une page Google Panda s'affiche en entier.

Dans les 2 cas, votre site doit être ultra-rapide. C'est important pour le SEO, mais encore plus pour l'efficacité de votre site, c'est-à-dire sa capacité à remplir ses objectifs (vente en ligne, prise de contact, publicité, etc.).

- si les pages mettent trop de temps à être téléchargées, Google réduit le nombre d'URL crawlées par jour/mois. C'est ce qu'on appelle le crawl budget. Si vos pages ne sont plus crawlées, ou rarement, les problèmes vont s'accumuler et vous aurez du mal à vous en sortir.

- si les pages mettent trop de temps à être chargées, les internautes risquent tout simplement de quitter votre site. Déjà c'est pas terrible, mais si en plus ils reviennent en arrière dans Google, c'est très mauvais...

Google recommande que les traitements du serveur pour produire une page prennent moins de 200 ms (source).

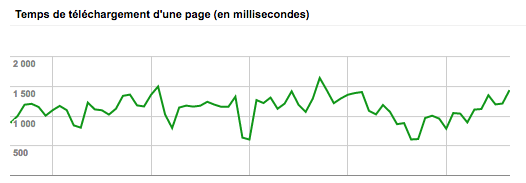

Voici un exemple de site dont le temps de téléchargement dans Search Console est bien trop élevé (il faudrait être vers 200ms, 600ms au maximum) :

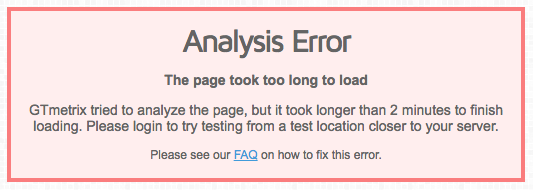

Voici l'erreur peu commune que j'ai obtenue avec un des sites de mon panel d'étude (dont le SEO a chuté je le rappelle) 😱 :

Sur une autre page de ce même site, des notes très mauvaises 🐌 :

- pour le téléchargement, commencez par la courbe située dans Google Search Console : elle donne une tendance générale. Complétez par un crawl de votre site avec n'importe quel crawler qui mesure le temps de téléchargement. Dans l'idéal, vérifiez spécialement vos images (pour trouver les images trop lourdes ou trop grosses par exemple). Si vous y avez accès et qu'ils sont bien configurés, étudiez aussi vos logs.

- pour le chargement, faites des tests avec des pages différentes de votre site, sur des outils comme Dareboost ou GTMetrix Ces 2 outils font appel à d'autres comme Google PageSpeed Insights et YSlow, ce qui est pratique. Dareboost a l'avantage d'être en français.

#11 Trop de pages non indexables mais crawlables

C'est en quelque sorte une sorte de variante de la masse noire, qu'on pourrait qualifier de "masse noire contrôlée". C'est-à-dire que le site génère plein d'URL non destinées à être référencées et que Google se "prend dans les pattes". Vous lui proposez plein de liens internes vers des pages et à chaque fois qu'il les crawle, l'instruction noindex lui dit "désolé, t'es venu pour rien, faut pas indexer".

Non, il ne va pas s'énerver, c'est un bot ! 🤖

Mais si ça prend des proportions énormes, le crawl de Google devient vraiment inefficace sur votre site. Petit à petit, il est possible que Google réduise son crawl sur ces pages en noindex.

Au final, à quoi ça sert de lui faire crawler tout ça ?

Parfois il s'agit de pages avec des listes de liens, par exemple des catégories filtrées ou triées, ou des tags, ou de la pagination. Faites donc des sous-catégories ou trouvez d'autres moyens de compléter votre taxonomie, ça sera largement plus efficace.

J'ai rencontré d'autres erreurs dans les sites étudiés, mais de moins grande ampleur, ou sur trop peu de sites pour qu'ils soient mentionnés ici.

Et vous ? Questions et réactions

Avez-vous rencontré des problèmes en référencement naturel dans les 6 ou 12 derniers mois ?

Si oui, n'hésitez pas à en parler dans les commentaires.

Dites-moi ce que vous pensez de tout ça !

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Bonjour, effectivement RMTECH détecte un gros paquet de pages qui ne devraient pas être indexées ( une grosse masse noire donc ). Ce sont en fait des review, toutes avec l'url /review/ à la racine du site. Dans search console, j'ai donc supprimé ces url ( clic suppression > nouvelle demande > Supprimer toutes les URL avec ce préfixe ) et j'ai modifié mon robots.txt avec un disallow: /review/ . QUESTION : le fait de demander à google de supprimer des url de l'index alors que robots.txt comporte l'instruction disallow sur ces url est il une erreur ? Google a t il besoin d'aller voir les pages quand on passe par la suppression dans search console ? ( Auquel cas il faut que j'enlève le disallow dans robots.txt ) ? Merci

ce n'est pas un pb d'avoir fait comme ça

Salut, merci pour cet article que je trouve très intéressant. Je veux présenter mon problème ici et j'espère avoir de l'aide.

Avant de commencer mon site actuel était en ligne, puis son propriétaire ne l'a pas renouvelé alors automatiquement le site est supprimé. Je l'ai acheté et j'ai refait tout le site.

J'ai mis mon site en ligne il y a quelque temps, mais j'ai remarqué qu'il y a des pages de l'ancienne version sont indexées puis erreur 404 (puisque je les ai pas ajouté sur la nouvelle version)

encore un problème , il y a qu'une seule page positionnée sur tous les mots-clés.

Exemple: je fais la recherche chauffagiste paris 1, le résultat c'est la page de Paris 1

et si je fais la recherche chauffagiste paris 4, le résultat c'est la page de Paris 1 aussi. Et c'est le problème de toutes les pages que j'ai mises en ligne

Merci d'avance

Pour les 404 c'est normal et pas grave.

Pour le reste, il faudrait optimiser le site et prendre patience.

ça serait plus pratique d'en parler dans le forum

Salut, Tout d'abord merci pour cet excellent article très complet. Sinon pour la profondeur des pages. J'ai un site très mal planifié dès le départ, avec seulement des catégories (pas de sous catégories). Après 5 ans de publication, je suis maintenant à 1300 articles, avec sans doutes, des pages aux tombeaux du web. Pour remédier à ce problème j'ai créé une page plan de site dans le footer du site; une solution pour les visiteurs mais j'ai des doutes sur l'efficacité de cette "solution" coté crawlabilité et répartition de jus. 2 ème solution j'ai ajouté un plugin "related post" pour améliorer la maillage interne. Et enfin je travaille manuellement des liens entre les pages , mais avec ce nombre de page ça avance tout doucement.

Autres points : je m’aperçois qu'il ya bon nombre de pages qui ne veut wèlou : le fait de retravailler désindexer et rediriger une centaine de pages ca risque pas de casser le site ?

Créer des sous-catégories et des liens internes sont des bonnes solutions, à compléter si besoin par des liens "related".

Mais en fait il faut utiliser un outil pour tout mesurer et évaluer les possibilités d'optimisation des pages afin de prioriser le boulot.

C'est exactement ce qui est fait dans les outils de ma plateforme My Ranking Metrics, que je t'invite à tester.

Un grand merci Olivier pour votre dossier, très complet comme d'habitude.

Pour ma part, je suis actuellement confrontée à une baisse de positions pour le site pour lequel je travaille. Je peine à en découvrir la cause :(

J’espère qu’avec vos recommandations, j’arriverai à en tirer quelque chose de positif.

Merci beaucoup pour cet article très complet, j'utilise déjà avec bonheur votre excellent outil d'audit de site, et peut confirmer combien la profondeur des pages influence le SEO.

Une grosse question cependant reste en suspens : dans le cas d'un site ecommerce, il est assez tentant de vouloir réduire la profondeur des pages avec un mega-menu, permettant un site plus large que profond. Mais un autre souci apparait, la problématique de la profusion de liens "à plat" peut nuire au SEO et à la cohérence des thématiques (silo et/ou cocon). Certains parlent de la technique de l'obfuscation pour cacher cette jungle de liens aux moteurs... Auquel cas on perd le bénéfice de la faible profondeur. J'ai le sentiment diffus que ces 2 règles se contredisent totalement. Votre avis là-dessus ?

Merci beaucoup ^^

Le méga-menu n'est pas forcément la bonne solution, surtout pour réduire la profondeur, car ça le fait de façon trop artificielle (plein de liens pas souvent cliqués). Je conseille plutôt de bien travailler les liens vers les sous-catégories et catégories soeurs, ainsi que les liens sur les fiches produits, sans oublier les liens dans les contenus éditoriaux.

Pour en savoir plus : mes conseils sur ce maillage interne (dossier pagination).

Encore et toujours un très bon article, même pour des SEO confirmés !

Petite question pratique : Dans le cas de nombreux contenus obsolètes mais qui restent intéressants en guise d'archive pour l'utilisateur, que conseilleriez-vous ?

Ces contenus n'ont pas vocation à être revus et donc aucun ajout de contenu à prévoir, les informations restent intéressantes mais pas forcément très demandées.

J'avais pensé faire un gros article récapitulatif pour chaque thématique et rediriger toutes les pages dessus. C'est un travail énorme, mais je pense que ça pourrait être intéressant niveau SEO et pour l'utilisateur de centraliser toutes les informations passées de date, mais qui peuvent intéresser quand même.

Qu'en pensez-vous ? Auriez-vous une solution moins chronophage ?

Merci par avance !

Oui j'ai une solution : ma méthode zombies (et mon outil RM Tech) fait gagner un temps fou, puisque ça repère les articles qui non seulement ne sont plus efficaces en termes SEO, mais également qui ne semblent même plus intéresser les internautes. Dans ce cas, vous pouvez toujours les garder sur le site si vous y tenez (je peux le comprendre), mais éventuellement en noindex et même pourquoi pas bloqué au crawl.

Avez-vous des exemples de contenus "obsolètes qui intéressent les internautes" ?

Un grand merci pour cet article qui me fait réaliser que je travaille à bien référencer un site sans pouvoir changer l'essentiel : le point 3, la qualité insuffisante de la page. Dans le cas d'un site que j'ai fait migrer d'un CMS à un autre et dont je ne suis pas auteur : je ne peux pas réécrire le contenu, surtout quand le site a une valeur affective élevée pour un client. Et le souci c'est que le client veut être sur la première page de google, mais le contenu ne suit pas, il est trop court, trop abstrait, l'ensemble est très loin du contenu intéressant. J'ai avancé sur ce que j'ai pu, la vitesse du site, UX, sitemap au propre, meta descriptions et j'ai réussi à hisser le site en position 12. En même temps je suis bien conscient que c'est du temporaire. Donc ma question est celle du débutant : comment faire avec des tout petits clients qui ne comprennent pas grande chose et demandent un référencement au top ?

Peut-être leur demander de lister 10 raisons pour lesquelles leur contenu (une page précise) devrait être devant les 10 premiers actuels des SERP.

Bonjour, 2 questions :

1/ Quand vous parlez de profondeur des pages 1 à 3 vs celles 4 à plus. La page d'accueil, c'est niveau 1 ou 0 ?

2/ Vous utilisez quel plugin pour votre sommaire en sidebar ?

1- l'URL de départ du crawl a une profondeur de 0. C'est généralement la page d'accueil. Ainsi, la profondeur est égale au nombre de clics nécessaires depuis l'URL de départ pour atteindre une page donnée.

2- c'est un dév maison basé sur je-ne-sais-plus quel script de sommaire

Bonjour et merci pour cet article!

J'ai crée une boutique en ligne en octobre, et j'ai compris pas mal de chose niveau referencement. J'ai envoyé mon site map à google, je suis entrain de revoir toutes mes pages pour y mettre du texte et des mots clés, mais voilà, je ne suis pas du tout du tout des les résultats de recherche google!!! Et je n'arrive pas a savoir si c'est un problème de mon site ou si c'est juste qu'il manque de contenu... Qu'en pensez vous?

http://www.sourire-grandir.com

serait plus efficace de lancer une nouvelle discussion dans le forum, afin que plusieurs membres puissent donner leur avis

Un grand merci Olivier pour votre dossier, très complet comme d'habitude.

Pour ma part, je suis actuellement confrontée à une baisse de positions pour le site pour lequel je travaillle. Je peine à en découvrir la cause :(

J'espère qu'avec vos recommandations, j'arriverai à en tirer quelque chose de positif.

A bientôt.

Assez content de moi, puisque c'est un presque sans faute, hormis concernant le point 9 auquel je n'aurai pas songé. Et le voilà corrigé dans la foulée ! Merci.

Merci pour ce récap et ces analyses Olivier.

Je crois avoir un site dans le cas 9 : beaucoup de pages crawlables avec une meta noindex. Typiquement, j'ai des pages récoltant des avis qui sont en noindex tant qu'il n'y a pas encore d'avis.

Penses-tu que ce serait un bonne idée de ranger les pages non indexables dans des répertoires non crawlables, puis de changer individuellement les url de ces pages dès qu'elles sont indexables, pour les rendre crawlables. Par ex :

Ranger dans /non_crawlable/pages_sans_avis/ les pages non indexables

puis déplacer dans /crawlable/pages_avec_avis/ les pages devenues indexables ?

non ce n'est pas une super idée car ça modifierait les URL, ce qu'il faut éviter.

Ok merci. Je suis preneur de tout conseil pour gérer cette situation :)

par exemple ne faire un lien vers la page avis que s'il y a au moins N avis (N à définir)

Bonjour Olivier,

Merci beaucoup pour cet article très riche. Ayant un site dans une situation similaire, j'ai vérifié ton hypothèse et c'est clairement catastrophique... 44% des pages avec 0 sessions et encore 47% avec moins de 10 sessions... En gros le trafic organic est concentré sur à peine 10% des pages.

Ce site étant un e-commerce, les pages visitées correspondent à des catégories et les produits ne génèrent presque aucune session organic... Ces pages sont utiles car elles sont visitées mais pas en page de destination.

Le contenu des pages produits a pourtant été travaillé correctement... Title optimisé, H1 optimisé et un minimum de contenu unique sur chaque produit. Cela étant dit, je ne vois pas trop quoi faire de ces produits... ils sont invisibles dans les moteurs de recherche mais utiles pour les visiteurs du site. Je ne pense pas que retravailler le contenu de ces produits changera la donne...

Je suis curieux de savoir ce qui se passerait si on passait tous ces produits en noindex... Cela ne devrait rien changer au niveau du trafic et allégerait énormément le nombre de pages indexées et donc le travail des bots. Qu'en pensez vous ?

Qu'une fiche produit génère aucune visite sur 30 jours, OK. Sur 1 an c'est déjà bien plus étonnant (embêtant). Mais autant de pages qui ne génèrent rien en 1 an, je pense tout de même qu'il doit y avoir des problèmes SEO sur le site (pas forcément tous sur les fiches produits, ça peut être le maillage ou autre chose).

Attention, passer des pages en noindex ne change rien au "travail des bots", ça ne réduit pas le crawl (sauf peut-être au bout de 6 mois quand Googlebot réalise qu'il crawle pour rien).

Merci super article !

Merci, as-tu déjà repéré ce genre de problèmes sur le site que tu gères ?

Merci, il faut que je relise , mais je poste ce message pour m'abonner aux commentaires de cette page si possible.

Merci pour ce retour d'expérience.

Quand on supprime un page quelle est la meilleure pratique ?

Quand je fais des 404, je constate que Google continue à crawler la page même des années après...

il faut s'assurer qu'il ne reste aucun lien interne vers l'URL supprimée, et qu'elle n'est plus dans aucun sitemap

si Google continue longtemps, c'est peut-être qu'elle avait des backlinks externes. Dans ce cas il est souvent recommandé de faire une redirection 301 pour continuer de profiter de ces backlinks (à moins qu'ils soient très mauvais).

Bonjour Olivier,

bravo pour l'article c'est très clair !

Une question cependant :

Pour les pages qui ont peu d'interêt pour l'internaute et qui n'ont donc pas de contenu de qualité (style cgv, contact, etc), que préconises tu ? Les desindexer via le robots.txt ?

Merci

Xavier

Je conseille de les laisser se faire indexer.

Bonjour. On parle souvent que le contenus textes est important. C'est vrai. Mais quand est-il des sites comme youtube ou autre "Youtube Like" qui n'ont que très peu de contenu textuel ?

Il faut malgré tout qu'ils aient un minimum de contenu textuel, sinon c'est trop difficile pour le moteur de recherche de comprendre de quoi parle la page (entités) et de la juger pour la faire sortir sur une multitude de requêtes.

En plus, il faut que le contenu (vidéo) plaise.

Franchement super article merci ! Par contre je m'interroge beaucoup sur les pages catégories pour une boutique ecommerce... Le texte avant ou après les produits ? Avec du code ou sans pour raccourcir et donner l'opportunité de voir plus pour le visiteur? Avez-vous remarqué des constantes en la matière ?

Même si ça semble aussi marcher (peut-être moins ?), je déconseille de mettre tout le texte de présentation d'une catégorie tout en bas de la page. Car ce n'est plus destiné à l'internaute, c'est pour le SEO uniquement... Ou alors une version courte en haut et un lien vers le reste en bas.

Super article. Cependant, la causalité entre profondeur de page et problèmes de référencement me semble discutable. En effet, + une page est profonde, - elle a de visites SEO, puisqu'en principe, les pages profondes traitent des sujets + de type "longue traine", et donc qui apportent - de trafic SEO car - tapé sur les moteurs.

Tu peux essayer de déplacer une page de profondeur 1 en profondeur 4 et voir ce qui se passe (pour ma part je sais que son positionnement va baisser).

Idem pour l'inverse.

C'est une histoire de PageRank, de jus, de maillage.

Une page profonde ne traite pas toujours de sujets ultra longue traine. Et puis, longue traine ne signifie pas faible trafic, ça dépend du nb de requêtes sur lesquelles la page sort.

Cela dit, je suis d'accord sur un principe : il est devenu très difficile de prouver la causalité avec l'algo de Google.

Bonjour Olivier,

Dans le point 3, relatif à la qualité des pages, tu déconseilles explicitement "des (grosses) pages dont 99% des mots sont cliquables".

Ca voudrait donc dire que les pages de type "plan de site" pourtant souvent conseillées dans les milieux SEO seraient en réalité à éviter ?

Je ne sais pas qui dans le milieu SEO recommande ça, pour ma part ça doit faire au moins 10 ans que je n'ai pas été sur ce type de page (en tant qu'internaute) et autant que je n'ai pas conseillé d'en faire.

Dans mon article, je précise aussi qu'il faut faire du maillage interne intelligent, ce qui exclut ce type de page.

Mon meilleur résumé, expliqué en formation depuis 2006 : "un bon lien est un lien souvent cliqué".

Merci pour la réponse. Bon week-end.

Merci pour ce retour, mais je suis surpris par ton parti pris sur les plans de site html.

Comment dans ce cas là arrives tu à caser 36000 communes x types de métiers(c'est un exemple) et le tout en - de 3 niveaux de profondeurs sans faire de plan de site ?

Je n'ai pas dit qu'il fallait forcément 3 clics tout le temps (dans RM Tech on a mis au point un algo qui détermine une profondeur max recommandée en fonction du site).

Je ne pense pas non plus au passage qu'il soit toujours bon de faire plusieurs pages métiers pour chaque commune, ça risque de beaucoup ressembler à des pages satellite.

#Merci pour cet article.

Merci ;-) Des commentaires sur certains des points abordés ?