Ce dossier extrêmement complet vous détaille toute ma méthode "Pages Zombies SEO, rendue publique fin 2018. Depuis, des centaines de SEO l'utilisent, ce qui me rend très fier !

Sommaire :

Qu'est-ce qu'une page zombie ?

Définition

Une page zombie n'est pas simplement une page qui ne génère pas de trafic SEO !

Pour les détails, voyez l'article C'est quoi une page zombie ?

Est-ce gênant pour le référencement d'avoir des pages zombies sur son site ?

Oui ça peut plomber votre SEO ! Je vous explique...

N'oubliez pas que Google juge la qualité globale de votre site : il tient compte de toutes les pages que vous lui demandez d'indexer. Cela fait très longtemps que c'est en place : dès 2011, Google l'a indiqué officiellement dans l’article donnant des conseils sur Panda dont voici ma traduction :

Si certaines parties d’un site sont des contenus de faible qualité, alors cela peut dégrader le positionnement de l’ensemble du site. En conséquence, le positionnement de votre contenu de haute qualité pourrait progresser si vous supprimez les pages de faible qualité, ou si vous regroupez ou améliorez le contenu de certaines pages superficielles pour en faire des pages plus utiles, ou si vous migrez vos pages de mauvaise qualité vers un autre nom de domaine.

Google, mai 2011 (source)

Vous devez donc être "fier" de 100% des pages que vous décidez de faire indexer.

Je résume : si vous avez trop de pages zombies 🧟♂️ 🧟♀️, comme dans l'imaginaire fantastique, elles vont attaquer les bonnes pages 😱

Je plaisante mais uniquement sur la façon de le décrire, car c'est bien la réalité de ce qui se passe avec l'algo de Google.

Pourquoi faut-il traiter les pages zombies ?

Je vous ai dit que la raison principale est liée à l'algo de Google. Mais il y a une raison bien plus simple et évidente

Toutes ces pages ne vous apportent rien (pas ou très très peu de visites, pas de conversions) et dégradent l'image de marque de votre site (et même de l'entreprise associée).

À chaque fois que vous améliorez une ou des pages zombies, elles vont se mettre à générer du trafic et des conversions, et améliorer votre image de marque. N'est-ce pas le but ?

En résumé : plus votre site a de pages à fort indice zombie, plus c'est risqué et inefficace :

- "risqué" car pour juger votre site, Google se base sur l'ensemble des pages que vous demandez de faire indexer. Laisser se faire indexer des pages “zombies” peut pénaliser vos bonnes pages

- "inefficace" car ces pages génèrent aucune ou très peu de visites et sont pas ou très peu consultées par vos visiteurs

Quel impact si on améliore les contenus de mauvaise qualité ?

Je viens de vous donner la raison principale : le but est d'améliorer la qualité globale de votre site. Mais en fait si on creuse un peu, on se rend compte que le traitement des pages zombies a au moins 3 avantages :

- vous améliorez la satisfaction des internautes : les contenus qu'ils découvrent sur votre site (via le référencement naturel) sont de qualité, puisque vous avez fait le ménage. L'expérience utilisateur est bonne, le risque que l'utilisateur quitte le site (pour revenir sur les SERP) est faible. Et donc, vous améliorez le taux de transformation, les conversions augmentent !

- vous améliorez le Quality Score que Google calcule (sans doute) pour l'ensemble de votre site. Les métriques liées à l'utilisateur sont bonnes (exploitées par exemple par l'algo Rank Brain) et donc votre positionnement progresse.

- vous optimisez votre budget de crawl : si votre site est très gros, l'analyse des pages zombies vous fait découvrir plein d'URL de la masse noire, qui n'auraient pas dû être indexées. Ou bien vous allez supprimer des pages totalement dépassées. Bref, ça fera + de ressources de crawl Google pour vos bonnes pages.

La suppression des pires pages zombies c'est du 100% bio !

Traiter les pages zombies sur votre site, c'est aussi important qu'élaguer de vos arbres ou supprimer les mauvaises herbes !

- comme l'élagage optimise la forme de l'arbre, l'analyse des pages zombies améliore l'architecture et l'arborescence du site. L'élagage aide l'arbre à résister au vent et à grandir avec des branches aux bons endroits, tout en réduisant le risque lié aux mauvaises branches et en améliorant l'esthétique.

- l'élagage maintient l'arbre en bonne santé : les branches entremêlées ou mal orientées sont coupées ou réajustées, les branches mortes sont supprimées, le système racinaire est plus efficace, la sève va dynamiser les branches restantes, l'arbre aura une croissance vigoureuse

Comment trouver les pages zombies ?

Réponse rapide : RM Tech vous les liste, avec un indice pour les trier !

Une page zombie, ce n'est pas une page sans trafic ou qui manque de contenu... L'indice pages zombie calculé par RM Tech tient compte de nombreux critères afin d'éviter de cataloguer comme affreuse une page qui en réalité est très utile au site (même si d'un point de vue référencement elle semble a priori mauvaise).

Il faut se baser sur de nombreux facteurs

Attention à ceux qui font une analyse bien trop superficielle ! Non, une page zombie n'est pas forcément :

- une page qui ne génère pas ou très peu de trafic

- une page au contenu éditorial très faible

Si vous vous basez uniquement sur ça, alors vous prenez d'énormes risques car vous allez supprimer des pages qui en réalité sont très utiles pour votre site...

Il faut récupérer le maximum de données, puis appliquer un algorithme pour repérer à quel point une page cumule des problèmes et des mauvaises performances dans les SERP de Google.

Je détaille ce process dans cet article : comment RM Tech trouve les pages zombies.

Au final vous n'avez rien à faire, tout est automatiquement intégré dans RM Tech, mon outil d'audit SEO sur ma plateforme My Ranking Metrics.

Une fois qu'on a pu récupérer toutes ces données, il faut calculer une métrique sous la forme d'un indice.

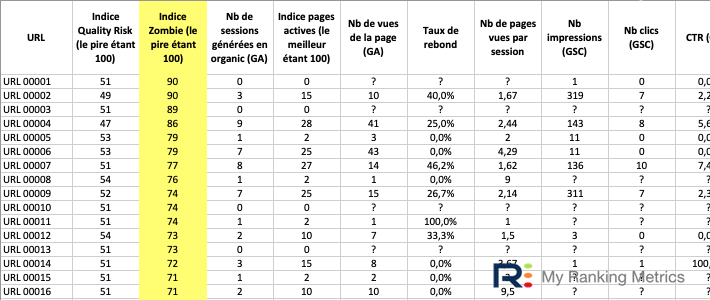

L'indice page zombie de RM Tech

Je me suis basé sur mon expérience en référencement, en particulier le repérage des pages de mauvaise qualité (cf. mon calcul d'indice QualityRisk).

J'ai pu faire d'énormes tests grâce à ma plateforme (vive le big data) et à des échanges avec d'autres experts.

Au final, chaque page indexable se voit attribuer un indice zombie entre 0 et 100

- un indice 0 signifie que la page n'a aucun problème

- un indice de 100 signifie que la page est au niveau maximal des problèmes

Cet indice est fourni dans l'annexe située dans la conclusion, juste à côté de l'indice QualityRisk :

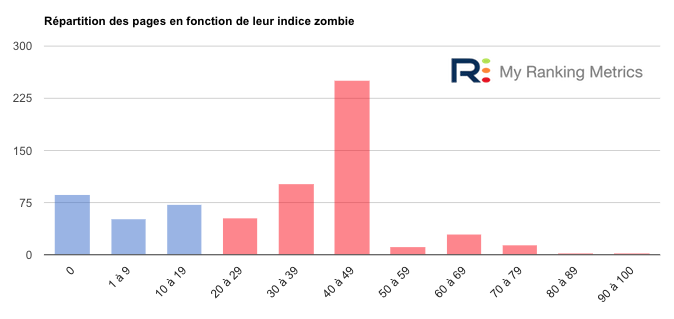

Pour vous rendre compte très simplement de la présence de pages zombies sur le site que vous analysez et de l'importance du problème, le rapport affiche un histogramme de ce genre :

Cet histogramme montre si vous avez beaucoup de pages à fort indice zombie. C'est en quelque sorte une version plus élaborée de l'histogramme QualityRisk (qui ne tient pas compte des données de Search Console).

Repérer les pages zombies et les trier selon un indice c'est bien, mais il reste à gérer ces pages et décider quoi en faire...

Avant ça, je préfère rappeler un point important : disposer de l'indice zombie de chaque page est extrêmement utile pour faciliter la vie, gagner du temps et de l'efficacité, mais ça ne remplace certainement pas l'analyse humaine. Profitez du temps dégagé par ce calcul d'indice zombie (automatique) pour réfléchir à ce qu'il faut prendre comme décision.

Comment traiter les pages zombies ?

Le but de la méthode est non seulement de vous aider à repérer les pages à fort indice zombie, mais aussi à comprendre la cause de cette contre-performance. Ainsi, vous allez améliorer vos pages et rendre efficaces des pages qui actuellement sont des boulets...

Voici les 3 points à savoir pour gérer les pages zombies...

Faut-il supprimer les pages zombies ?

Non, il ne faut pas supprimer les pages zombies, sauf cas extrême d'une page irrécupérable. De nombreux tutos sur le web recommandent leur suppression mais c'est une pratique dangereuse.

Le but de l'analyse des pages zombies est de :

- se rendre compte de la présence de pages zombies et de leur importance (indice entre 0 et 100)

- identifier des causes communes à des paquets de pages, afin de les corriger

- améliorer les pages pour qu'elles ne soient plus zombies

- repérer les cas extrêmes (pages qui n'ont plus de raison d'être sur le site)

Outil d'assistance pour corriger les pages zombies

Savoir quoi corriger sur ces pages n'est pas toujours simple : il s'agit généralement de problèmes techniques, éditoriaux et UX.

Pour simplifier la vie des SEO, j'ai donc complété mon outil RM Tech (qui repère les pages zombies) par RM Console, mon outil de suivi SEO et aide aux optimisations.

Le module "Pages à optimiser" de RM Console se nourrit des données de l'audit RM Tech (avec l'indice zombie de chaque page, et des dizaines d'autres métriques) ainsi que de celles de Google Search Console. L'algo en place utilise aussi l'IA.

Il fonctionne en 3 étapes :

- Choix de la page à optimiser : l'outil liste les pages au plus gros potentiel, mais vous pouvez aussi indiquer l'URL de votre choix (par exemple une page zombie)

- Optimisation de la page : l'outil liste plein de recommandations, que vous appliquez

- Mesure de l'impact SEO : l'outil le fait automatiquement

Si vous ne l'avez pas encore fait, vous pouvez tester gratuitement RM Console pendant 2 mois, sans fournir votre CB.

Autres détails

Si vous souhaitez plus d'explications, lisez mon autre article où j'explique comment traiter les pages zombies.

FAQ

Voici les questions les plus souvent posées à propos de ma méthode Pages Zombies SEO.

Quelle différence entre une page zombie et une page au contenu trop faible ?

L'indice page zombie ne se base pas seulement sur la quantité de contenu, car parfois un article avec peu de contenu éditorial rencontre un gros succès, de l'engagement auprès des internautes et même des revenus ou transactions/conversions.

C'est pourquoi l'analyse des pages zombies inclut de nombreuses autres métriques. Tout est combiné, à vous de prendre la décision finale, mais le gros du travail est fait : vos pages sont triées.

L'analyse des pages zombies est-elle réservée aux gros sites ?

Même si c'est particulièrement utile et efficace sur les gros sites, cette méthode est applicable à tous les sites. Même un petit site de quelques pages ou dizaines de pages doit faire en sorte que la qualité moyenne des contenus soit excellente. C'est important aussi bien pour l'internaute (bonne UX pour celui qui découvre votre site en venant de Google) que pour l'algo de Google.

A quelle fréquence faut-il examiner les pages zombies ?

Régulièrement ! Bien entendu, si vous publiez souvent de nouveaux contenus, c'est encore plus stratégique. Mais pour tous les sites, il faut s'assurer que les contenus sont toujours à jour. Il y a aussi des intérêts (des internautes) qui évoluent, des nouveautés qu'il faudrait aborder, sans compter l'impact technique de plugins ou de votre CMS qui demande des vérifications régulières.

La suppression des pages zombies est-elle risquée ?

Tout dépend de ce que vous appelez "page zombie". Si vous n'utilisez pas RM Tech, vous prenez le risque de croire que des pages sont à supprimer alors que ce n'est pas le cas. Donc si vous supprimez des pages sans réfléchir, oui c'est risqué.

L'analyse des pages zombies dans RM Tech permet d'obtenir un indice (de 0 à 100) pour prioriser les actions et vous aider à prendre des décisions. Le but est d'améliorer toutes les pages qui peuvent l'être et de supprimer celles qui sont vraiment irrécupérables. En suivant cette méthode, vous n'avez pas de risques de faire d'erreur.

Qu'est-ce que le Content Pruning en SEO ?

En référencement, le content pruning consiste à identifier des pages de mauvaise qualité indexées sur son site, et à la désindexer, dans le but d'améliorer globalement la qualité du site. "pruning" signifie "élagage". On parle aussi de Content Cruft ou de Site Detox).

C'est donc la même idée que mes "pages zombies", mais dans la plupart des articles qui expliquent comment faire du Content Pruning :

- on recommande surtout de supprimer et désindexer, alors que moi je conseille avant tout de comprendre pourquoi une page ne fonctionne pas bien (en SEO) et en dernier recours de la supprimer/désindexer

- on n'utilise bien souvent que trop peu de métriques. Par exemple, certains suppriment les pages sous prétexte qu'elles ne sont pas actives. RM Tech se base sur bien d'autres informations pour calculer l'indice zombie.

- le travail est à faire à la main ou en manipulant plein d'outils et de données. Avec RM Tech, tout ce travail est fait pour vous ! Vous pouvez vous concentrer sur les analyses à forte valeur ajoutée.

Exemples de pages zombies trouvées par RM Tech

Je termine ce dossier avec une sélection d'exemples de pages de type "zombie" trouvées par RM Tech.

Pour simplifier les choses (j'ai plein de sites à montrer avec leur contexte), je l'ai fait en vidéo. Quelques précisions :

- j'ai essayé de choisir des exemples variés, mais j'aurais pu en fournir 3x plus !

- j'ai également inclus des exemples de bonnes pages (prises sur les mêmes sites) pour vous aider à comparer. C'est impressionnant de voir que cette analyse aide à identifier les types de contenus qui cartonnent de façon durable.

- j'ai obtenu l'accord de chacun de ces sites pour tourner cette vidéo

Voici le genre de choses que l'algo zombie de RM Tech repère généralement très bien, même au milieu de dizaines de milliers de pages :

- les fiches produits périmées ou sans stock

- les fiches produits sans aucune description (ou 1 ligne)

- les catégories vides ou presque

- les pages correctes mais au titre complètement raté (balise title)

- le spam inefficace et risqué (notamment les pages satellite)

- les articles dont le contenu est totalement dépassé

- les pages en erreur qui répondent pourtant en code 200

- la saturation du (faible) contenu par la pub

- les problèmes majeurs d'UX (expérience utilisateur)

- la masse noire technique (URL indexables qui n'auraient même pas dû être crawlables)

- sur un site multilingue : les pages non traduites, ou trop partiellement

- ...

Arrivez-vous à repérer tout ça très rapidement pour chaque site étudié (sans utiliser RM Tech) ?

Retrouvez cette vidéo sur YouTube : Pages zombies SEO trouvées par RM Tech

Envie de savoir à quoi ressemble un audit RM Tech incluant l'analyse des pages zombies ?

On résume...

🧟 Il faut lancer RM Tech, l'outil d'audit SEO de la plateforme My Ranking Metrics. Dans le rapport d'audit, vous aurez l'indice zombie de chaque page, ainsi que des graphiques et des explications rédigées.

🧟♀️ Demandez à profiter d'un pré-audit gratuit pour voir un bilan des pages zombies sur votre site, avec les données réelles. Vous saurez si cette méthode vous serait utile ou pas.

🚧 Non ! Contrairement à ce que certains pensent, ce n'est pas ça. C'est même très risqué de se limiter au trafic uniquement. Notre algo exploite plein d'autres critères pour juger la qualité d'une page ainsi que ses performances.

🗑️ Non ! Ce n'est qu'en dernier recours, pour les pages irrécupérables. Le principe de la méthode est d'identifier rapidement les problèmes pour comprendre les causes. En corrigeant l'origine du problème, vous améliorez fortement la situation et votre référencement.

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Bonjour les pages catégories qui sert uniquement de listing pour les articles, faut'il les considérer comme des pages zombie?

Non, d'ailleurs c'est très rare de pouvoir dire "tel type de page est forcément une page zombie". Les pages catégories doivent être enrichies afin de ne pas être seulement un listing : éditorial soigné avec texte inédit, mise en avant de certains produits ou marques phares, image d'illustration, etc.

Merci pour cet article, il me redonne la motivation dont j'avais besoin. Cela faisait un an que je n'avais pas lu un article SEO avec autant de passion.

J'ai d'ailleurs remarqué qu'en améliorant le SEO d'anciens articles avec du contenu intéressant, que Google commençait à prendre au sérieux mon journal. 80 pages à refaire, heureusement que j'ai RankMath pour m'aider ^^

Très bon article ! :) merci beaucoup pour le concept de page zombie. J'ai cependant un problème pour détecter les pages indexées. J'ai suivi votre méthode de détection (en scrappant avec la commande site: les urls d'un site).

Voici mon pb :

Soit un site xxx.com, Je liste les urls indexées via la commande site : site:x.com (je trouve urla, urlb, urlc, urld, urle)

Hors j'ai une urlf dont je veux savoir pourquoi elle n'est pas dans l'index.

1 - Je regarde sur la searchconsole : et j'ai le résultat : Couverture : Indexée !

2 - je teste une recherche xxx.com mot-clef (contenu dans la page de l'urlf) et le résultat avec l'urlf apparaît dans les serp

Dois-je en conclure que cette page urlf est indexée puisqu'elle retournée dans la serp ? Je penche pour oui. Mais je fait peut-être erreur.

Je te conseille de te baser sur des métriques liées aux performances, comme le nb de visites que la page a générées via le référencement naturel, le nb de consultations de la page, le nombre d'impressions dans search console. D'après mon expérience c'est plus fiable et surtout ça permet d'éviter la classification "page indexée / non indexée".

Au passage, avant j'avais uniquement distingué les pages actives des non actives, et j'ai vu que c'était insuffisant, d'où la méthode des pages zombies.

As-tu testé RM Tech ?

Hello Olivier

Super interressant et enrichissant ton article sur les pages zombies. Mais il y a quand même un shmill...

« Explorée, actuellement non indexée » : Google a bien crawlé votre page mais décidé qu’elle ne méritait pas d’être indexée

« Découverte, actuellement non indexée » : Google a bien crawlé votre page mais décidé qu’elle ne méritait pas d’être indexée

Ils se trouve que certaines des pages que Google annonce comme non indéxées le sont bien, qu'on les trouve dans la search console en faisant une inspection d'URL, ou même en recherchant dans Google..

Une chose est sur c'est qu'il n'aime pas la page, et on se rend bien compte qu'elle "souffre de mille maux" pas pas de 1000 mots.. ;-)

Nicolas

En effet, parfois les indications de la search console ne sont/semblent pas cohérentes. En général, c'est dû à un décalage temporel : le rapport n'est pas à jour.

Bonjour

merci pour cet excellent article.

J'ai un site e-commerce, avec des produits d'occasion, donc des pages/produits en quantité 1. Lorsqu'ils sont vendus, ils restent en ligne comme "vendu".

Pensez-vous que ces pages produits "vendus" peuvent-etre considérées comme des pages "zombies" qui impactent négativement le SEO ? Devrait-on les supprimer ? simplement les mettre en "noindex" ? Merci pour vos lumières

Je ne vois pas bien l'intérêt de conserver ces pages, elles risquent de décevoir les internautes qui les consultent. Au minimum il faudrait une meta robots noindex.

Bonjour,

je ne comprends pas la différence entre les notions de " pages zombies " et le Quality Risk de l'audit Rank Metrics ?

Pouvez vous m'éaclairer ?

Cdt

Alexis

QualityRisk essaie d'évaluer les qualités intrinsèques d'une page sans avoir d'informations sur les performances effectives.

Zombie se base non seulement sur des éléments du type QualityRisk, mais aussi les performances effectives des pages. L'indice zombie est donc bien plus précis, il sait reconnaître qu'une page avec pourtant très peu de texte peut être très utile ou très efficace (et qu'il faut la conserver).

Bonjour,

Est ce que vous avez une idée du temps qu'il faut pour que le site remonte après un traitement des pages zombies ?

Je vois sur les exemples entre deux mois...et attendre un core update : je pensais que les mises à jour de la qualité des sites ne dépendait pas des core update et étaient régulières ?

Merci.

Je pense qu'il est impossible d'indiquer une durée, car :

- cela dépend de la situation de départ du site, de la volumétrie des problèmes

- cela dépend de l'ampleur des travaux d'amélioration de la qualité entrepris

- personne ne sait exactement en quoi consistent les core updates officialisés (ou pas) par Google

Bonjour, merci pour ce partage, j'ai une question par rapport au passage

"Voici le genre de choses que l’algo zombie de RM Tech repère généralement très bien [....] les articles dont le contenu est totalement dépassé"

Sur les sites d'actualités, faut il supprimer les anciennes actualités lorsque celles-ci ne génèrent plus aucun intérêt ?

Si oui, faut il supprimer uniquement les articles au qualityrisk élevé ou faut-il également désindexer les articles qui génèrent pas ou très peu de visites, même s'ils ont un qualityrisk de 0, qui sont de bonne qualité mais qui n'intéressent tout simplement plus personne ?

Merci beaucoup !

Il n'y a pas de réponse universelle, c'est là qu'il faut que l'humain intervienne !

Quelques remarques cependant :

- mieux vaut se baser sur l'indice zombie que sur QualityRisk, c'est plus complet

- il faut tenir compte de la stratégie de l'entreprise (souhaitez-vous conserver tous les articles en ligne, quitte à les bloquer à Google ?), en ne tenant pas seulement compte du SEO mais aussi d'autres aspects qui comptent pour la réussite

- si vous pouvez indiquer le nom de domaine du site, créez une discussion dans le forum et demandez l'avis des autres membres

Bonjour et merci pour votre réponse!

j'ai en effet ouvert un sujet dimanche (1 jour avant la publication de votre article) mais je n'ai pas eu de réponses à ce jour : https://www.webrankinfo.com/forum/t/pages-faiblement-actives-et-inactives-sur-site-dactualites.195029/

Je viens d'y indiquer un exemple

Excellent article. La valeur ajoutée de ton outil est bien le gain de temps dans l'analyse, je confirme.

J'ai un exemple de site e-commerce qui a un nombre important de pièces détachées et d'accessoires qui ont leurs propres URL. Il n'y a que peu de contenu sur ce type de page et elles ressortent beaucoup comme page zombie.

Y-a-t-il un risque à mettre beaucoup de ces pages en noindex ?

Il y a un risque à désindexer des pages qui présentent un intérêt à rester indexées.

Il faut tout faire pour améliorer les pages zombies plutôt que de les désindexer ou supprimer.

Mais sinon, si l'analyse humaine confirme que ces pages n'ont aucun intérêt (pas seulement SEO) et sont irrécupérables, alors autant les désindexer toutes, ça devrait être profitable.

Ce sont des articles qui se vendent (pas via le SEO du coup) les pages ont donc un intérêt commercial.

Une piste serait d'intégrer ces accessoires directement dans la page du produit fini et de les rendre achetables directement depuis la page du produit fini.

Ce qui apporterait encore du "contenu" à la page produit qui pourrait se positionner aussi sur son accessoire ou sa pièce détachée : "écran pour xxxxx"

Excellent article! Merci pour toutes ces informations.

J'aimerais cependant savoir dans le cas où je supprime des pages qui n'auraient pas dû exister : je dois faire des redirections ou je peux les laisser en 404 ?

S'il existe une URL (indexable) qui correspond très bien à la page qui n'aurait pas dû exister, autant faire la redirection 301.

Sinon une 404 (ou 410).

Bonjour, après analyse de ma Search Console, j'ai environ une centaine de pages zombies, de type "explorée mais non-indexée" qui correspondent à tous les médias uploadés sur mon WordPress (documents PDF et images). Ce ne sont donc pas de réelles pages de contenu en soi. Quelle recommandation serait la votre pour rendre ces typologies de pages non indexables ? Merci par avance !

S'agit-il vraiment d'URL de médias ou d'URL de pages HTML ne faisant qu'afficher des médias (attachments dans WordPress) ?

en tout cas ça n'est pas bien méchant j'imagine

Super retour d'expérience, cela donne envie de faire un peu de nettoyage cet hiver. La corrélation entre le nombre de pages désindexées et le boost de trafic du tweet de Raphaël Doucet est éloquent. J'ai eu envie de regarder mon rapport search console d'urls exlcues à la lecture de ton article, ce qui est bizarre, c'est que dans les urls explorées actuellement non indexées, j'ai aussi des articles assez qualitatifs qui ressortent malgré tout sur Google. Peut-on se fier à 100 % à ce rapport ?

Merci pour ton commentaire. C'est vrai que j'ai déjà trouvé des exemples de pages soit-disant non indexées qui le sont pourtant bien, mais c'est loin d'être la majorité. L'analyse RM Tech est fiable à 100% par contre, j'ai fait assez de tests pour le dire ;-)

Hello Olivier,

Tu m'as toujours convaincu de cet aspect important dans le positionnement d'un site.

J'ai une question pratico pratique. Sur un blog de contenu, dans lequel une série d'articles ("Les chiffres de la semaine") a été créé au fil du temps, avec un ratio texte très faible et des visites quasi nulles ... il y en a quelques centaines : quel traitement préconises-tu ? Tu disais que les redirection en masse vers la home peuvent être toxiques... du coup tu suggérerais de mettre tout en 410 ?

A priori code 410, sauf s'il y a des cas particuliers (par exemple pour une URL qui a reçu des bons backlinks, une 301 pourrait servir)

Bravo Olivier,

c'est un sujet dont nous avons déjà discuté et sur lequel tu te penches depuis un bon moment.

J'alerte également mes clients sur ce problème qui est très fréquent sur les sites e-commerce (mon coeur de cible).

Avoir un moyen de les repérer facilement et précisément avec RM Tech va simplifier le travail :)

Beau travail !

Oui, il faut parfois se rendre compte qu'un travail de qualité sur moins de produits est plus efficace...

Un article qui va faire grand bruit dans le monde du SEO ! Très intéressant et à partager sans modération