Sur les sites dynamiques, on trouve parfois/souvent des paramètres passés dans les URL (derrière le signe ?). Ils peuvent servir à configurer le contenu à afficher ou à gérer des options pour liées à l'internaute. Mais ils peuvent générer des contenus dupliqués (en donnant accès au même contenu via des URL différentes). Lisez ce tutoriel pour apprendre comment paramétrer cet outil complet intégré dans Google Search Console.

Remarque : la 1ère version de ce tutoriel date de septembre 2009, quand Google a sorti cet outil pour la première fois. A l'époque, il ne permettait que d'indiquer pour chaque paramètre si Google devait en tenir compte ou l'ignorer. Désormais les options de configuration sont bien plus nombreuses, ce qui explique que j'ai réécrit entièrement ce dossier.

Avant de commencer, si vous n'êtes pas à l'aise avec la notion de duplicate content (DC), lisez mon tutoriel sur les contenus dupliqués (incluant les solutions pour améliorer votre référencement naturel).

Egalement, sachez que Google Search Console (GSC) est le nouveau nom de Google Webmaster Tools (GWT) depuis 2015.

Enfin, même si vous devriez trouver la plupart des réponses à vos questions, je propose en fin d'article des solutions pour vous aider, notamment un audit de votre compte GSC.

Quels sites sont concernés ?

Certains sites dynamiques

Si vous avez un site dynamique, il est fort probable que cela vous concerne, sauf si vous avez déjà pris les mesures nécessaires. Si dans les URL de vos pages il y a parfois des variables (= paramètres) d'un des types suivants, alors vous êtes concerné :- paramètres de pagination

- paramètres de gestion du tri (nom du critère de tri et valeur, par exemple ascendant ou descendant)

- paramètres de filtrage (pour restreindre un listing en fonction de certaines valeurs)

- paramètres de traduction

A voir aussi : tutoriel sur la pagination

Si vous utilisez du tracking

Imaginons que vous ayez configuré votre flux RSS pour que les URL qui y figurent ne pointent pas directement vers vos articles mais incluent un paramètre de tracking, vous permettant de mesurer l'impact de votre flux RSS sur votre site web. AT Internet (XiTi) est par exemple connu pour son paramètre xtor. et Google Analytics pour ses paramètres commençant par utm_ (par exemple utm_source, utm_medium, utm_campaign).Ce type de paramètre crée du contenu dupliqué puisque votre contenu est accessible à plusieurs URL (avec ou sans ce paramètre, ou selon ses valeurs).

Google vous permet de lister ces variables dans votre compte Google Search Console. L'idée est que Google pourra fusionner les URL concernées et réduire les problèmes de contenus dupliqués pour votre site.

Remarque : la notion de tracking est essentielle pour le webmarketing ; si vous ne savez pas bien ce que cela signifie, je vous conseille de lire mon tutoriel sur le tracking des URL.

Si vous utilisez la réécriture d'URL

Si vous avez mis en place l'URL rewriting, vous ne pourrez pas configurer les paramètres dans GSC comme décrit ci-après. Mais cela ne veut pas dire que vous n'avez pas potentiellement des problèmes de contenus dupliqués ! Si ce n'est pas clair pour vous, voyez ici comment obtenir de l'aide.Mise en place pas à pas...

Allez dans GSC (lisez comment créer un compte Google Search Console si besoin) dans la rubrique Exploration > Paramètres d'URL.Tableau récapitulatif des paramètres d'URL

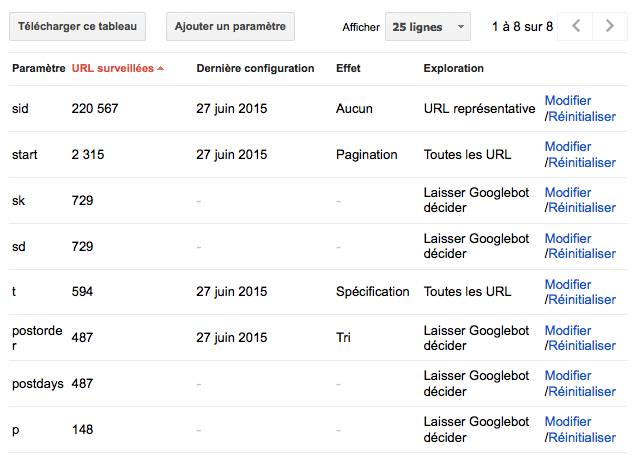

Google affiche un tableau listant tous les paramètres déjà détectés automatiquement ou configurés manuellement par une des personnes ayant accès à votre compte GSC. Voici à quoi il peut ressembler :

Pour chaque paramètre, Google indique :

- paramètre : nom de la variable présente dans l'URL

- URL surveillées : nombre d'URL incluant ce paramètre dont Google connait l'existence

- Dernière configuration : date de la dernière modification de la configuration

- Effet : indique si ce paramètre a un effet sur le contenu de la page ou pas

- Exploration : indique ce que Google va faire et quel genre d'URL son robot va crawler ("explorer")

Vous remarquez que vous pouvez télécharger la configuration de tous les paramètres (format CSV) ce qui peut être pratique pour la traiter autrement ou la transmettre à votre référenceur / prestataire / collègue.

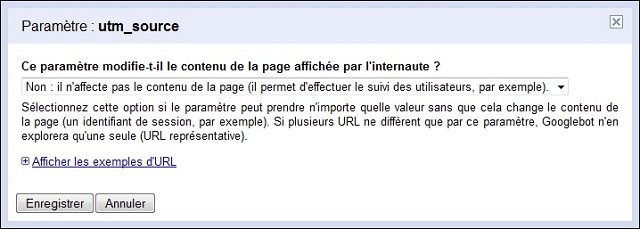

Configurer un paramètre sans effet sur le contenu

Si vous trouvez dans ce tableau des paramètres qui n'ont aucun effet sur le contenu (ils peuvent avoir n'importe quelle valeur, le contenu de la page restera inchangé), alors configurez-les comme tel :

En indiquant à Google que ce paramètre n'affecte pas le contenu de la page, Google se débrouillera pour ne crawler qu'une seule URL (je suppose l'URL sans ce paramètre, à vérifier).

En théorie ceci permet de résoudre le problème des sites avec des identifiants de session dans les URL qui freinent considérablement le crawl (et donc l'indexation).

Configurer un paramètre avec effet sur le contenu

Si au contraire vous trouvez dans ce tableau des paramètres qui ont un effet sur le contenu (le contenu de la page diffère selon les valeurs du paramètres), alors il faut les configurer au cas par cas. Une fois que vous avez indiqué que le contenu change en fonction du paramètre, vous devez indiquer comment ce paramètre affecte le contenu :- Tri : Cette option permet de trier le contenu comme indiqué dans le paramètre. Par exemple, vous pouvez afficher des fiches de produits triées par nom, marque ou prix.

- Restriction : Affiche un sous-ensemble de contenu spécifié par le paramètre (par exemple, des filtres pour afficher seulement les robes en taille M).

- Spécification : Spécifie de quoi traite la page (par exemple, le sujet, l'audience, le numéro de l'article, etc.).

- Traduction : Affiche le contenu dans la langue (par exemple, anglais ou klingon) spécifiée par le paramètre.

- Pagination : Affiche le contenu d'une page de type listing, pour un numéro de page donné.

- Autre : pour les autres cas.

Une fois que vous avez indiqué l'impact du paramètre sur le contenu, vous devez dire à Google ce qu'il doit faire :

- Laisser Googlebot décider : sélectionnez cette option si vous n'êtes pas sûr du comportement du paramètre ou si celui-ci diffère selon les parties du site. Googlebot analysera votre site pour déterminer comment gérer au mieux ce paramètre.

- Toutes les URL : Googlebot se base sur la valeur du paramètre pour déterminer si une URL est unique. Par exemple, www.example.com/robes/real.htm?productid=1202938 et www.example.com/robes/real.htm?productid=5853729 sont considérées comme deux URL totalement distinctes. Avant de sélectionner cette option, assurez-vous que le paramètre modifie vraiment le contenu de la page. Dans le cas contraire, il peut amener Googlebot à explorer inutilement des contenus en double sur votre site.

- Uniquement les URL dont la valeur est : (à sélectionner dans une liste). Googlebot explore uniquement les URL dont le paramètre est défini sur la valeur indiquée. Lorsque la valeur est différente, l'URL n'est pas explorée. Vous pouvez sélectionner cette option si le contenu de vos pages reste le même, mais s'affiche dans un ordre différent en fonction de la valeur définie pour le paramètre. Par exemple, www.example.com/robes/real.htm?sort=price_high présente le même contenu que www.example.com/robes/real.htm?sort=price_low. Utilisez cette option pour indiquer à Googlebot d'explorer uniquement les URL incluant le paramètre sort=price_low (et ainsi éviter d'explorer des contenus en double).

- Aucune URL : Googlebot n'explore pas les URL contenant ce paramètre. Cette option est utile si votre site utilise de nombreux paramètres pour filtrer le contenu. Par exemple, vous pouvez demander à Googlebot de ne pas explorer les URL incluant des paramètres moins importants, comme pricefrom et priceto (http://www.examples.com/search?cate...color=rouge&size=38&pricefrom=10&priceto=1000). Ainsi, le contenu déjà présent sur la page http://www.examples.com/search?category=chaussure&brand=nike&color=rouge&size=38, qui ne contient pas ces paramètres, ne sera pas exploré une seconde fois.

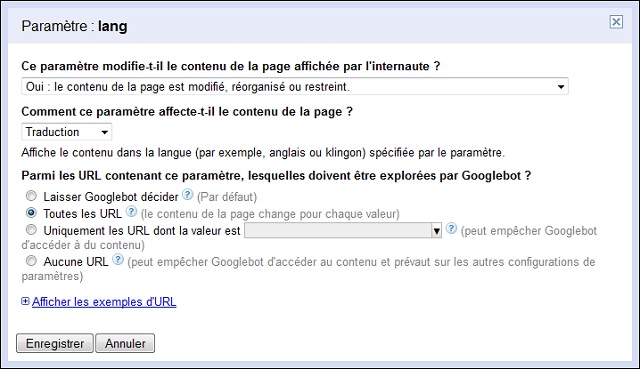

Gérer les langues

Si vous utilisez un paramètre qui code la langue pour gérez vos traductions de contenus, choisissez l'option traduction. A priori vous demandez à Google de crawler toutes les URL (quel que soit le code de langue) mais c'est à vous de voir en fonction de votre site. Voici un exemple :

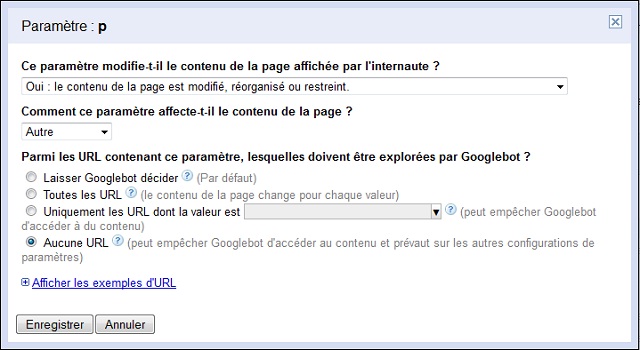

Interdire le crawl

Si vous repérez des URL que Google n'aurait pas dû crawler du tout (a priori c'est rare), vous pouvez configurer le paramètre pour interdire Googlebot de venir explorer les pages concernées :

Attention, avec cette configuration, Google ne viendra plus du tout crawler ce genre de pages. Faites bien attention !

Dernière édition: