Bonjour,

je souhaiterai optimiser mon site et empêcher google d'indexer "une suite d'URL" pour deux raisons.

Je prend un exemple :

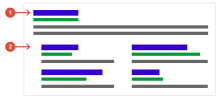

un site web : https://www.DOMAINE.com

a une partie Blog : https://www.DOMAINE.com/blog

une section articles : https://www.DOMAINE.com/blog/articles

mais aussi une section de rédacteurs d'articles : https://www.DOMAINE.com/blog/redacteurs

chaque rédacteurs auraient une page dédié de profil du type :

https://www.DOMAINE.com/blog/redacteurs/Boris

https://www.DOMAINE.com/blog/redacteurs/Clement

https://www.DOMAINE.com/blog/redacteurs/Sonia

On peut imaginer que la page des rédacteurs auraient aussi des liens pointant vers d'autres éléments :

https://www.DOMAINE.com/blog/redacteurs/Boris/parcoursDuRedacteur

https://www.DOMAINE.com/blog/redacteurs/Boris/biographieDuRedacteur

https://www.DOMAINE.com/blog/redacteurs/Boris/pointDuRedacteur

etc...

toutes ces pages ne sont pas forcément liée à un menu sur le site mais font partie du maillage interne et sont intégrer par le cms et les composants ...

comment indiquer a Google qu'on ne veut pas voir indexé toutes les pages /pointDuRedacteur

sachant qu'il en existe autant qu'il y'a de rédacteurs...

dans le même état d'esprit est ce qu'il est possible de dire index

https://www.DOMAINE.com/blog/redacteurs/Boris

mais pas

https://www.DOMAINE.com/blog/redacteurs/Clement

merci pour votre aide

je souhaiterai optimiser mon site et empêcher google d'indexer "une suite d'URL" pour deux raisons.

- D'une part par ce qu'il n'y a pas de raison particulière a ce que certaines pages soit indexer

- Et d'autres part parfois des pages inutiles se trouve avec des liens important (sous le nom de mon site web, dans le moteur de recherche) comme si il s'agissait de structure importante du site et je voudrait stopper ça ...

Je prend un exemple :

un site web : https://www.DOMAINE.com

a une partie Blog : https://www.DOMAINE.com/blog

une section articles : https://www.DOMAINE.com/blog/articles

mais aussi une section de rédacteurs d'articles : https://www.DOMAINE.com/blog/redacteurs

chaque rédacteurs auraient une page dédié de profil du type :

https://www.DOMAINE.com/blog/redacteurs/Boris

https://www.DOMAINE.com/blog/redacteurs/Clement

https://www.DOMAINE.com/blog/redacteurs/Sonia

On peut imaginer que la page des rédacteurs auraient aussi des liens pointant vers d'autres éléments :

https://www.DOMAINE.com/blog/redacteurs/Boris/parcoursDuRedacteur

https://www.DOMAINE.com/blog/redacteurs/Boris/biographieDuRedacteur

https://www.DOMAINE.com/blog/redacteurs/Boris/pointDuRedacteur

etc...

toutes ces pages ne sont pas forcément liée à un menu sur le site mais font partie du maillage interne et sont intégrer par le cms et les composants ...

comment indiquer a Google qu'on ne veut pas voir indexé toutes les pages /pointDuRedacteur

sachant qu'il en existe autant qu'il y'a de rédacteurs...

dans le même état d'esprit est ce qu'il est possible de dire index

https://www.DOMAINE.com/blog/redacteurs/Boris

mais pas

https://www.DOMAINE.com/blog/redacteurs/Clement

merci pour votre aide