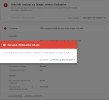

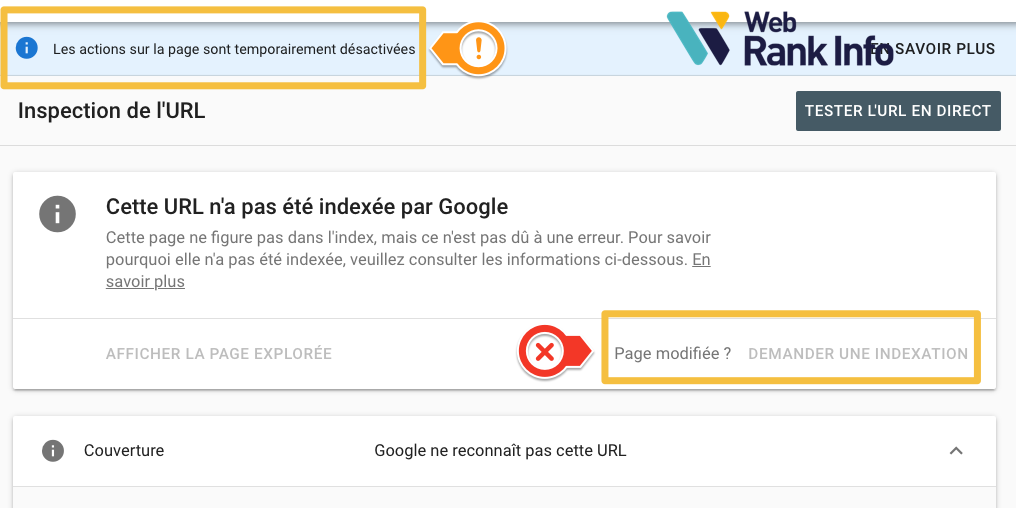

Vous avez certainement entendu parler ces derniers temps des bugs de Google concernant l'indexation. D'ailleurs, on en a déjà parlé ici dans quelques discussions. Et dans Search Console on ne peut plus demander l'indexation d'une URL (c'est désactivé)...

Google est le champion de l'IA, mais ne saurait plus indexer correctement les pages qu'il crawle ?

Il y a du vrai, mais d'après mes premières analyses, je pense qu'il y a une raison bien plus importante qui explique pourquoi certaines pages ne sont pas indexées : Google ne veut plus forcément indexer tout ce qu'on lui donne. Ca va même plus loin : il semble avoir une façon de prédire si ça vaut le coup de crawler des pages d'un site.

EDIT 1 : plutôt que de poursuivre sur cette discussion, lisez plutôt mon dossier sur le crawl prédictif de Google.

EDIT 2 : Le 22 décembre, Google a annoncé (enfin) que cet outil est remis en service. Mais ça ne change pas vraiment les choses, car ça n’est qu’un outil de dépannage. En effet, vos pages ne devraient pas avoir besoin de ça pour être (rapidement) indexées.

Je suis en train d'affiner les choses et d'essayer de valider des hypothèses. Je me suis dit qu'il serait intéressant de centraliser les discussions alors je vous propose quelques questions :

Merci d'avance pour votre participation ici ou là-bas !

Vous pouvez aussi me contacter en privé.

Je termine par les explications actuelles de Google...

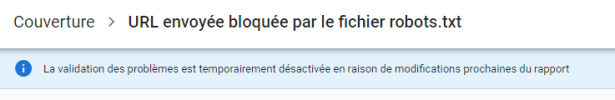

Selon Google (source), la fonction "Demander une indexation" de l'outil d'inspection d'URL a été désactivée afin d'effectuer certaines mises à jour techniques. Quand Google l'a annoncé le 14 octobre dernier, c'était censé être réactivé "dans les prochaines semaines". Google rappelle que le crawl et l'indexation continuent par des des méthodes habituelles.

Voici les conseils de Google pour favoriser/optimiser le crawl (source) :

Google est le champion de l'IA, mais ne saurait plus indexer correctement les pages qu'il crawle ?

Il y a du vrai, mais d'après mes premières analyses, je pense qu'il y a une raison bien plus importante qui explique pourquoi certaines pages ne sont pas indexées : Google ne veut plus forcément indexer tout ce qu'on lui donne. Ca va même plus loin : il semble avoir une façon de prédire si ça vaut le coup de crawler des pages d'un site.

EDIT 1 : plutôt que de poursuivre sur cette discussion, lisez plutôt mon dossier sur le crawl prédictif de Google.

EDIT 2 : Le 22 décembre, Google a annoncé (enfin) que cet outil est remis en service. Mais ça ne change pas vraiment les choses, car ça n’est qu’un outil de dépannage. En effet, vos pages ne devraient pas avoir besoin de ça pour être (rapidement) indexées.

Je suis en train d'affiner les choses et d'essayer de valider des hypothèses. Je me suis dit qu'il serait intéressant de centraliser les discussions alors je vous propose quelques questions :

- Est-ce que vous aussi vous avez des problèmes avec l'indexation Google ? Est-ce que ça concerne certains types de sites, ou de pages ? Est-ce que ça arrive sur des sites où vous n'aviez habituellement pas de problèmes ?

- Ou bien est-ce que vous ne vous êtes rendu compte de rien ?

- Ou bien vous ne savez pas comment on peut le savoir ou l'étudier ?

Merci d'avance pour votre participation ici ou là-bas !

Vous pouvez aussi me contacter en privé.

Je termine par les explications actuelles de Google...

Selon Google (source), la fonction "Demander une indexation" de l'outil d'inspection d'URL a été désactivée afin d'effectuer certaines mises à jour techniques. Quand Google l'a annoncé le 14 octobre dernier, c'était censé être réactivé "dans les prochaines semaines". Google rappelle que le crawl et l'indexation continuent par des des méthodes habituelles.

Voici les conseils de Google pour favoriser/optimiser le crawl (source) :

- Transmettre un sitemap

- Envoyer une demande d'exploration de pages individuelles (ce n'est pas possible en ce moment...)

- Utiliser des chemins d'URL simples, intelligibles et logiques pour vos pages, et avoir des liens internes clairs et directs sur le site.

- Identifier clairement la page canonique et les autres pages

- Utiliser hreflang pour renvoyer les internautes vers d'autres versions linguistiques de votre page.

- Utiliser le fichier robots.txt judicieusement, pour indiquer à Google les pages à explorer en priorité afin de protéger la charge du serveur, et non comme moyen de bloquer l'affichage de contenu dans l'index Google.

- Si vous spécifiez des paramètres d'URL sur votre site pour la navigation (par exemple, si vous indiquez le pays de l'utilisateur sur un site d'achat mondial), utilisez l'outil Paramètres d'URL pour signaler à Google les paramètres importants.

- Assurez-vous que Google peut accéder aux pages clés, ainsi qu'aux ressources importantes (images, fichiers CSS, scripts) nécessaires pour afficher correctement la page.

Dernière édition: