Bonjour, c'est un grand mystère !

Je vous décris l'étrange situation de notre site et n'hésitez pas à lancer vos idées, je suis preneur !

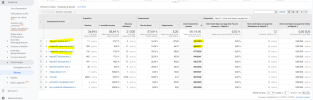

Sur Analytics, mon site enregistre des temps de sessions moyens de 15,16,18 HEURES depuis différents fournisseurs de services du type : aubervilliers bloc 2, poitiers bloc 1...

Comme dit Obelix... Voyez plutôt... :

Je vous décris l'étrange situation de notre site et n'hésitez pas à lancer vos idées, je suis preneur !

Sur Analytics, mon site enregistre des temps de sessions moyens de 15,16,18 HEURES depuis différents fournisseurs de services du type : aubervilliers bloc 2, poitiers bloc 1...

Comme dit Obelix... Voyez plutôt... :