Nouveau WRInaute

Bonjour,

Pour les fêtes de fin d’année, Google nous a fait disparaître d’Internet. Point. Après 20 ans d’existence.

Notre site a une certaine volumétrie : nous faisons plusieurs millions de visiteurs par an, des pics de plusieurs dizaines de milliers de visiteurs par jour.

Malheureusement, nous avons été hackés il y a 2 mois, victime du fameux hack « injection de mots clés japonais ».

Nous avons fait tout le nécessaire pour réparer : installation d’une solution de sécurité, basculement en CDN sécurisé, verrouillage des droits, suppression du contenu parasite, nettoyage de la base de données, suppression de quelques liens pourris, mise à jour complète, etc. Résultat :

https://sitecheck.sucuri.net/results/www.logitheque.com

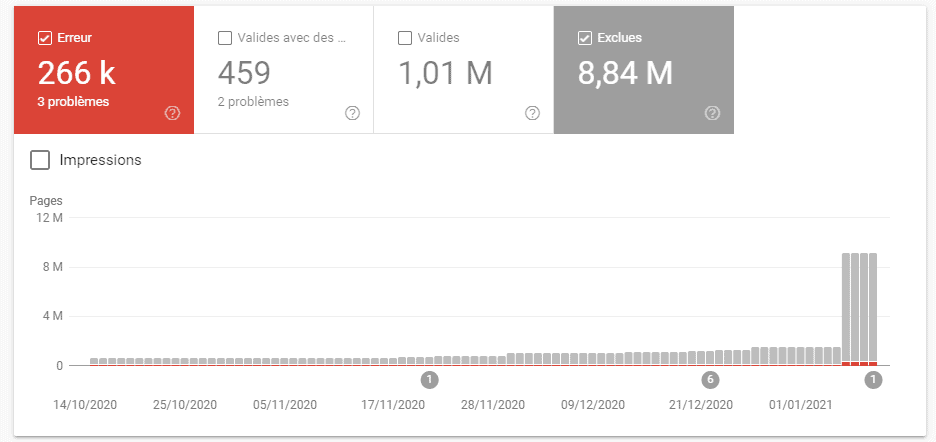

Le 13 novembre le site est opérationnel, nettoyé, relancé, nous sommes confiants, tout semble bien aller. Seul bémol : les pages référencées chez Google sont les anciennes pages du Hack. Nous savons qu’il faut attendre que Google mette à jour son cache petit à petit. Soit.

Le 18 décembre, 6H du matin : les visites s’écroulent. Le trafic n’est pas divisé par 2 ou 3 ou 5, c’est bien pire. Il disparaît complètement de la source de trafic Google.

Nous avons tout vérifié, tout testé, nous ne comprenons pas :

- aucune pénalité manuelle dans Search Console

- aucun problème de sécurité

- un crawl avec Screaming Frog nous indique que le site est accessible sans soucis : toutes les 200, 301, 4xx sont exactement là où on les attend, les pages sont indexées

- un crawl avec Semrush ne fait rien ressortir

- le site fonctionne parfaitement, accessible à travers tous les navigateurs, les périphériques, testé par VPN

- l’analyse des logs montre que les 2 Googlebot (desktop + mobile) passent bien sur le site à une bonne cadence

- nous avons posté deux messages sur le forum webmaster de Google, sans réponse pertinente

Cela fait une semaine maintenant que nous sommes dans cette situation, nous avons épuisé toutes nos idées :

- il nous est impossible de soumettre notre site à Google pour une revue

- nous n’avons aucune information de qui que ce soit sur ce qu’il se passe

- dans Search Console, Google nous indique une erreur 5xx quand on lui soumet une url pour inspection : cela n’a aucun sens, le site est accessible, les bots ne sont pas bloqués (nous les voyons passer), la page est visible par tous et tous les outils

Nous pensons que c’est la quantité de pages issues du hack qui doivent poser problème, mais il ne semble pas exister de solution pour sortir de cet entre-deux, de ce désert numérique.

Si vous avez été vous aussi victime d’une expérience similaire, ou si vous, ou l’un de vos clients, avez été confronté à ce type de désagrément, nous accueillons vos retours et vos conseils avec la plus grande bienveillance.

Sinon, notre site semble condamné, ce qui est grave avec de lourdes conséquences pour notre équipe.

Merci, portez vous bien et passez de bonnes fêtes,

www.logitheque.com

Pour les fêtes de fin d’année, Google nous a fait disparaître d’Internet. Point. Après 20 ans d’existence.

Notre site a une certaine volumétrie : nous faisons plusieurs millions de visiteurs par an, des pics de plusieurs dizaines de milliers de visiteurs par jour.

Malheureusement, nous avons été hackés il y a 2 mois, victime du fameux hack « injection de mots clés japonais ».

Nous avons fait tout le nécessaire pour réparer : installation d’une solution de sécurité, basculement en CDN sécurisé, verrouillage des droits, suppression du contenu parasite, nettoyage de la base de données, suppression de quelques liens pourris, mise à jour complète, etc. Résultat :

https://sitecheck.sucuri.net/results/www.logitheque.com

Le 13 novembre le site est opérationnel, nettoyé, relancé, nous sommes confiants, tout semble bien aller. Seul bémol : les pages référencées chez Google sont les anciennes pages du Hack. Nous savons qu’il faut attendre que Google mette à jour son cache petit à petit. Soit.

Le 18 décembre, 6H du matin : les visites s’écroulent. Le trafic n’est pas divisé par 2 ou 3 ou 5, c’est bien pire. Il disparaît complètement de la source de trafic Google.

Nous avons tout vérifié, tout testé, nous ne comprenons pas :

- aucune pénalité manuelle dans Search Console

- aucun problème de sécurité

- un crawl avec Screaming Frog nous indique que le site est accessible sans soucis : toutes les 200, 301, 4xx sont exactement là où on les attend, les pages sont indexées

- un crawl avec Semrush ne fait rien ressortir

- le site fonctionne parfaitement, accessible à travers tous les navigateurs, les périphériques, testé par VPN

- l’analyse des logs montre que les 2 Googlebot (desktop + mobile) passent bien sur le site à une bonne cadence

- nous avons posté deux messages sur le forum webmaster de Google, sans réponse pertinente

Cela fait une semaine maintenant que nous sommes dans cette situation, nous avons épuisé toutes nos idées :

- il nous est impossible de soumettre notre site à Google pour une revue

- nous n’avons aucune information de qui que ce soit sur ce qu’il se passe

- dans Search Console, Google nous indique une erreur 5xx quand on lui soumet une url pour inspection : cela n’a aucun sens, le site est accessible, les bots ne sont pas bloqués (nous les voyons passer), la page est visible par tous et tous les outils

Nous pensons que c’est la quantité de pages issues du hack qui doivent poser problème, mais il ne semble pas exister de solution pour sortir de cet entre-deux, de ce désert numérique.

Si vous avez été vous aussi victime d’une expérience similaire, ou si vous, ou l’un de vos clients, avez été confronté à ce type de désagrément, nous accueillons vos retours et vos conseils avec la plus grande bienveillance.

Sinon, notre site semble condamné, ce qui est grave avec de lourdes conséquences pour notre équipe.

Merci, portez vous bien et passez de bonnes fêtes,

www.logitheque.com