Bonjour,

Alors que mon site est responsive et s'adapte bien pour les smart-phone, nous avons constaté une baisse de classement suite à la mise a jour de gg à ce sujet.

Les causes peuvent être multiples, mais je pense qu'il est possible que l'une d'entre elles soie une mauvaise performance du site pour les mobiles.

Avec Google PageSpeed, sur une page type, Google me donne 95/100 en expérience utilisateur, mais descend à 67 / 100 pour la vitesse mobile (83 pour les ordinateur), Alors que sur Gmetrix, j'obtiens A pour le test "page speed" et C pour "Yslow".

Question 1 : Ce 67 / 100 en vitesse peut-il expliquer une partie de la baisse du trafic ?

Ensuite, j'ai fait de nombreux tests sur un environnement de dev sur ce qui impacterait le plus ce score. Le point rouge que m'assène google est le suivant :Éliminer les codes JavaScript et CSS qui bloquent l'affichage du contenu au-dessus de la ligne de flottaison

Pour les js, j'ai trouvé comment résoudre le problème. Pour les css, c'est plus compliqué. je ne parviens pas à déterminer ce qu'il considère bloquant.

J'ai tenté l'expérience suivante:

j'ai injecté tous les css directement dans le html, (l'affichage ce fait ainsi instantanément après avoir téléchargé la page).

Le résultat est surprenant: un gain de plus de 25 points à la note total ! J'écope du coup de l'indication "alléger votre code html", forcément, mais pour google, c'est mieux!

Je pourrai crier victoire et m'arrêter à cette solution, plus quelques petits détails, j'arrive ainsi a 95/100 en vitesse. Mais je pense que c'est le contraire du principe d'une page web, qui doit s'afficher au fur et à mesure du téléchargement du contenu.

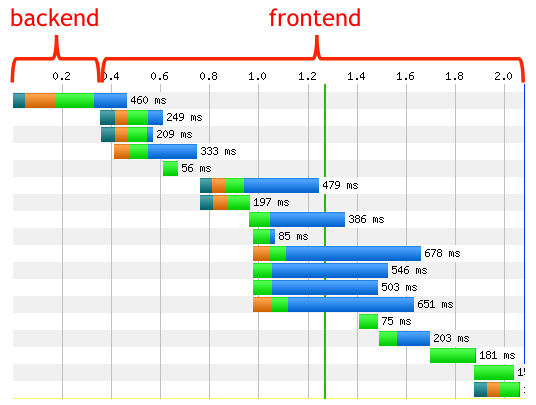

Il y a aussi le temps de réponse du serveur: il est énorme, entre 0.3 et 0.5s. je pensais qu'en le réduisant à 0.05 / 0.07 (ce que je considère comme un temps de réponse "normal"), je récupérerai beaucoup de points.

Après test, je ne récupère que 2 ou 3 points...

donc question 2 : l'outil de google est il fiable comparer a outils de Gmetrix?

Je pensais donc au compromis suivant: injecter la base des framework css dans le html, la base de mes propres styles, et le reste en source externe comme traditionnellement. Mais cela va quand même augmenter sensiblement la taille de mon flux html, qui pour moi doit être LE fichier le plus léger.

Donc questions 3 : passé d'un html de quelque ko à un html supérieur a 100 voir 150ko est-il une bonne idée, si cela permet un affichage dès réceptions du html comme le veut google ?

Merci d'avance pour vos éclaircissements !

Alors que mon site est responsive et s'adapte bien pour les smart-phone, nous avons constaté une baisse de classement suite à la mise a jour de gg à ce sujet.

Les causes peuvent être multiples, mais je pense qu'il est possible que l'une d'entre elles soie une mauvaise performance du site pour les mobiles.

Avec Google PageSpeed, sur une page type, Google me donne 95/100 en expérience utilisateur, mais descend à 67 / 100 pour la vitesse mobile (83 pour les ordinateur), Alors que sur Gmetrix, j'obtiens A pour le test "page speed" et C pour "Yslow".

Question 1 : Ce 67 / 100 en vitesse peut-il expliquer une partie de la baisse du trafic ?

Ensuite, j'ai fait de nombreux tests sur un environnement de dev sur ce qui impacterait le plus ce score. Le point rouge que m'assène google est le suivant :Éliminer les codes JavaScript et CSS qui bloquent l'affichage du contenu au-dessus de la ligne de flottaison

Pour les js, j'ai trouvé comment résoudre le problème. Pour les css, c'est plus compliqué. je ne parviens pas à déterminer ce qu'il considère bloquant.

J'ai tenté l'expérience suivante:

j'ai injecté tous les css directement dans le html, (l'affichage ce fait ainsi instantanément après avoir téléchargé la page).

Le résultat est surprenant: un gain de plus de 25 points à la note total ! J'écope du coup de l'indication "alléger votre code html", forcément, mais pour google, c'est mieux!

Je pourrai crier victoire et m'arrêter à cette solution, plus quelques petits détails, j'arrive ainsi a 95/100 en vitesse. Mais je pense que c'est le contraire du principe d'une page web, qui doit s'afficher au fur et à mesure du téléchargement du contenu.

Il y a aussi le temps de réponse du serveur: il est énorme, entre 0.3 et 0.5s. je pensais qu'en le réduisant à 0.05 / 0.07 (ce que je considère comme un temps de réponse "normal"), je récupérerai beaucoup de points.

Après test, je ne récupère que 2 ou 3 points...

donc question 2 : l'outil de google est il fiable comparer a outils de Gmetrix?

Je pensais donc au compromis suivant: injecter la base des framework css dans le html, la base de mes propres styles, et le reste en source externe comme traditionnellement. Mais cela va quand même augmenter sensiblement la taille de mon flux html, qui pour moi doit être LE fichier le plus léger.

Donc questions 3 : passé d'un html de quelque ko à un html supérieur a 100 voir 150ko est-il une bonne idée, si cela permet un affichage dès réceptions du html comme le veut google ?

Merci d'avance pour vos éclaircissements !