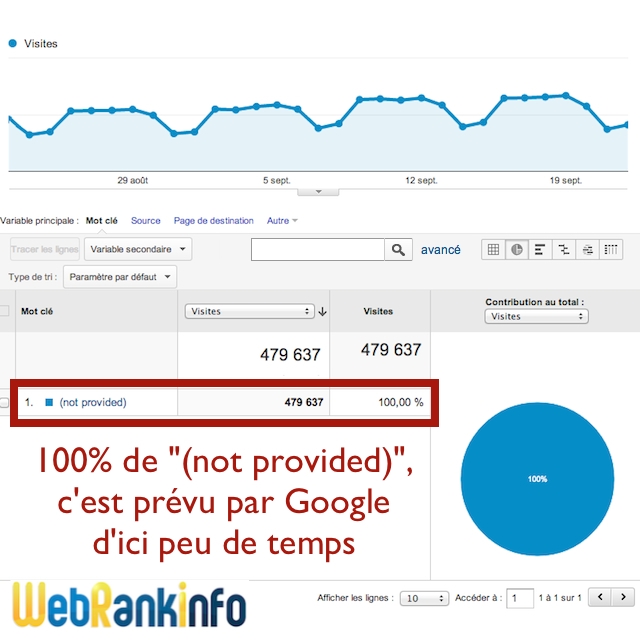

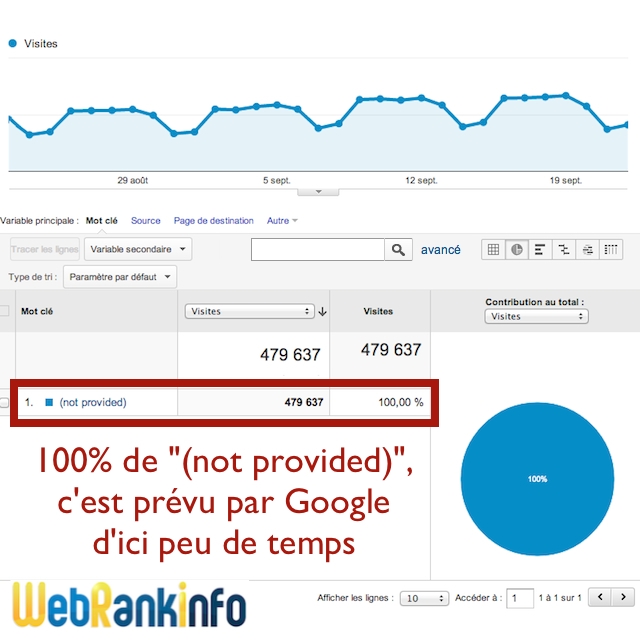

Google va imposer la recherche avec le protocole HTTPS pour tous les internautes, ce qui va conduire à 100% de not provided et donc 0% de mots-clés fournis aux stats

pour ce 23 septembre 2013, je suis actuellement à 92% de not provided sur WRI

il reste GWT mais ça n'est pas relié à la notion de session et donc de conversion (sans compter les pb de volumes et d'historique)

ne me demandez pas comment on va faire des analyses de ROI basées sur les mots-clés en SEO Google

Explications détaillées :

On savait bien que ça risquait d'arriver un jour, il semble que ce soit déjà le cas : Google impose désormais sa recherche sécurisée (HTTPS) à tous ses utilisateurs. Ceci empêche les webmasters de connaître les mots-clés générateurs de trafic, sauf s'ils achètent des publicités AdWords...

Article mis à jour le 21/01/2015, publié initialement le 24/09/2013

100% de not provided, c'est ce que vous aurez d'ici peu de temps...

Quand le site référent est un moteur de recherche, plutôt que de simplement indiquer l'URL de la page de provenance (qui contient en général de nombreux paramètres peu compréhensibles), les outils de web analytics tels que Google Analytics récupèrent parmi ces paramètres ce qu'on appelle la requête, c'est-à-dire les mots-clés tapés par l'internaute.

Sous prétexte que ces mots-clés peuvent contenir des données personnelles, Google a décidé en 2010 qu'il pouvait être utile de supprimer cette information. Ainsi, dans certains cas à l'époque, le webmaster qui recevait du trafic en provenance de Google ne pouvait plus identifier le mot-clé puisque Google le coupait en amont (avant que l'internaute n'arrive sur le site). N'ayant aucun mot-clé fourni à afficher, Google Analytics a décidé d'indiquer "(not provided)" (avec les parenthèses) en lieu et place du véritable mot-clé.

Hausse brutale du not provided en septembre 2013

Contacté, Google aurait répondu simplement :

Si pour les professionnels du webmarketing et tous ceux qui prennent le référencement au sérieux c'est une très mauvaise nouvelle, il ne faut pas oublier que pour l'écrasante majorité des utilisateurs de Google, c'est soit une information incompréhensible pour eux, soit un point positif pour la protection de leur vie privée...

Not Provided : même la version premium de Google Analytics ne peut fournir les mots-clésCLICK TO TWEET

Aucun outil de mesure d'audience, qu'il soit basé sur un marqueur dans les pages web ou sur les logs, qu'il soit intégré à votre CMS ou pas, ne peut résoudre le problème du not provided, puisque Google supprime l'information en amont, avant que l'internaute ne quitte réellement le moteur de recherche...

78.226.234.219 - - [22/Sep/2013:08:44:18 +0200] "GET /disque-dur-portable-dell-protege-par-mot-passe-t98610.html HTTP/1.1" 200 13946 770611 "https://www.google.fr/?gws_rd=sslurl?sa=t&rct=j&q=&esrc=s&source=web&cd=1&ved=0CC8QFjAA&ei=wJE-UvXIM4Wi0QX5zoGQBg&usg=AFQjCNEzsLWTYtFG-_b75ULz2BRoj-GH8Q&sig2=HsL3BfGYT6ZXxtjZ_32l_w&bvm=bv.52434380,d.d2k" "Mozilla/5.0 (Windows NT 6.2; WOW64; rv:24.0) Gecko/20100101 Firefox/24.0"

On voit bien que le contenu du paramètre "q" a été vidé. On ne peut pas savoir ce que l'internaute avait fait comme recherche, mais on sait que c'était sur google.fr et sur quelle page du forum il est arrivé. Il y a d'autres infos dans les autres paramètres d'URL mais ils ne contiennent pas la requête.

Conclusion :

Not Provided : aucune analyse des logs ne peut fournir les mots-clés supprimés par GoogleCLICK TO TWEET

Mais ne vous réjouissez pas trop vite, il s'agit d'une fausse solution au problème du not provided, puisque vous ne pouvez pas savoir si ces visites ont été efficaces pour vous. Vous ne pouvez pas mesurer un taux de conversion (ou "transformation") et encore moins des ventes générées. Conclusion : vous ne pouvez pas calculer de ROI (retour sur investissement)... à moins d'opter pour la solution payante ci-après !

Not Provided : Search Console fournit un échantillon de mots-clés, mais sans taux de conversionCLICK TO TWEET

A l'heure actuelle, ce rapport des requêtes les plus fréquentes dans Google Search Console (GSC) est limité par les contraintes suivantes :

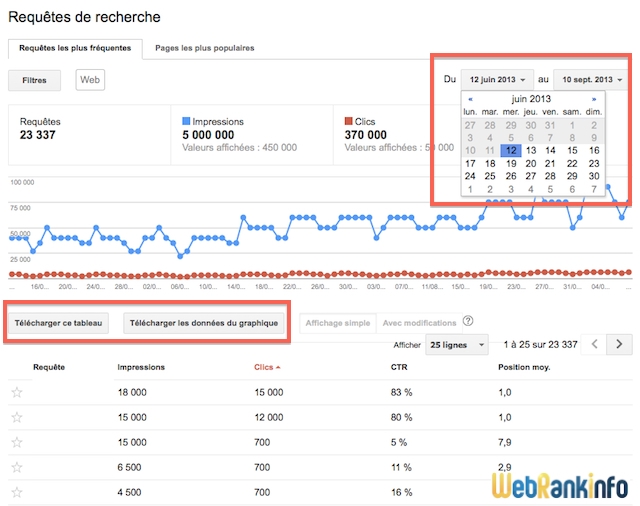

Voilà à quoi ça ressemble :

L'historique des données de mots-clés de trafic dans GSC

Ce rapport est également disponible dans Google Analytics (si vous reliez vos 2 comptes) mais ce n'est pas pour autant que les données de mots-clés sont raccordées aux données de sessions...

Contrairement à ce qu'on peut entendre, il n'y a pas ici d'entrave à la vie privée : les données consultables dans AdWords sont agrégées et non associées aux internautes. Pourquoi Google n'offre pas la même chose dans Analytics ? Bonne question, mais pourquoi le ferait-il ? Et surtout gratuitement ?

Vous pouvez détester autant que vous voulez l'idée de devoir payer pour obtenir du trafic depuis Google, si vous ne l'avez pas encore fait, je pense qu'il va être temps de créer votre 1ère campagne AdWords. Faites attention à bien vous faire accompagner pour ne pas y laisser trop de plumes ! Si vous débutez, lisez mon tutoriel. Ensuite, posez vos questions dans le forum Ads ou inscrivez-vous à ma formation.

Une fois que vous aurez une (ou plusieurs) campagne AdWords en cours, vous aurez donc à nouveau accès aux rapports sur les requêtes ("termes de recherche" pour reprendre l'appellation utilisée par AdWords). Mais attention, ce rapport ne liste pas tous les mots-clés de recherche : ne sont affichés que les termes de recherche utilisés par les internautes il y a au moins 24 heures et qui ont enregistré des clics au cours des 30 derniers jours, ou alors un grand nombre de recherches.

Mais en raison des parts de marché écrasantes de Google en Europe, vous aurez sans doute peu de données à vous mettre sous la dent... Et quand bien même, rien ne garantit que les statistiques soient transposables au trafic issu de Google.

L'idée est d'appliquer un filtre Google Analytics qui va renommer le "(not provided)" pour le remplacer par une combinaison du type "NP {URI d'arrivée}". Par exemple si quelqu'un arrive sur cette page https://www.webrankinfo.com/forum/t/100-de-not-provided-google-impose-la-recherche-en-ssl.167959/, enregistrée sous /dossiers/google-search/generalisation-not-provided dans Google Analytics, alors le filtre va renommer le soit-disant mot-clé "(not provided)" en "NP /dossiers/google-search/generalisation-not-provided".

Ceci permet d'affiner votre analyse, en sachant au moins quelle page de votre site s'est positionnée dans Google et sur laquelle l'internaute est arrivé.

Pour aller un peu plus loin, on peut envisager de coupler cette analyse avec l'étude détaillée du referrer, qui dans le cas de Google contient (parfois ?) la position du résultat cliqué. Il faut alors croiser cela avec une analyse de positionnement, mais en pratique je considère cela quasi impossible. Sans compter qu'avec la personnalisation des résultats, c'est encore plus compliqué.

pour ce 23 septembre 2013, je suis actuellement à 92% de not provided sur WRI

il reste GWT mais ça n'est pas relié à la notion de session et donc de conversion (sans compter les pb de volumes et d'historique)

ne me demandez pas comment on va faire des analyses de ROI basées sur les mots-clés en SEO Google

Explications détaillées :

On savait bien que ça risquait d'arriver un jour, il semble que ce soit déjà le cas : Google impose désormais sa recherche sécurisée (HTTPS) à tous ses utilisateurs. Ceci empêche les webmasters de connaître les mots-clés générateurs de trafic, sauf s'ils achètent des publicités AdWords...

Article mis à jour le 21/01/2015, publié initialement le 24/09/2013

100% de not provided, c'est ce que vous aurez d'ici peu de temps...

Définition du "not provided" et du referrer

D'abord, il faut savoir ce qu'on appelle le referrer, parfois noté référent en français. Quand un internaute clique sur un lien dans son navigateur pour aller d'une page d'un site A à une page d'un site B, le navigateur transmet au site B l'URL de la page du site A. C'est très pratique pour le webmaster du site B de pouvoir ainsi identifier précisément la provenance du visiteur. Dans Google Analytics, l'ensemble du trafic généré par les sites qui vous font des liens est regroupé dans les "Sites référents".Quand le site référent est un moteur de recherche, plutôt que de simplement indiquer l'URL de la page de provenance (qui contient en général de nombreux paramètres peu compréhensibles), les outils de web analytics tels que Google Analytics récupèrent parmi ces paramètres ce qu'on appelle la requête, c'est-à-dire les mots-clés tapés par l'internaute.

Sous prétexte que ces mots-clés peuvent contenir des données personnelles, Google a décidé en 2010 qu'il pouvait être utile de supprimer cette information. Ainsi, dans certains cas à l'époque, le webmaster qui recevait du trafic en provenance de Google ne pouvait plus identifier le mot-clé puisque Google le coupait en amont (avant que l'internaute n'arrive sur le site). N'ayant aucun mot-clé fourni à afficher, Google Analytics a décidé d'indiquer "(not provided)" (avec les parenthèses) en lieu et place du véritable mot-clé.

Ce que Google a changé en septembre 2013

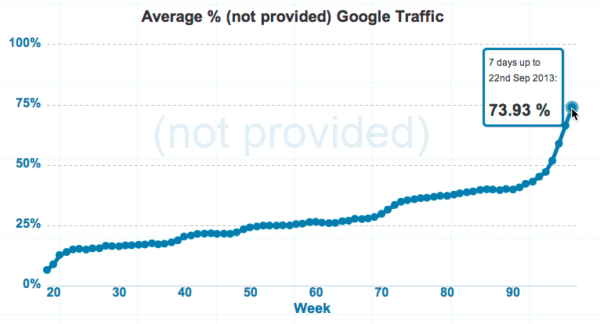

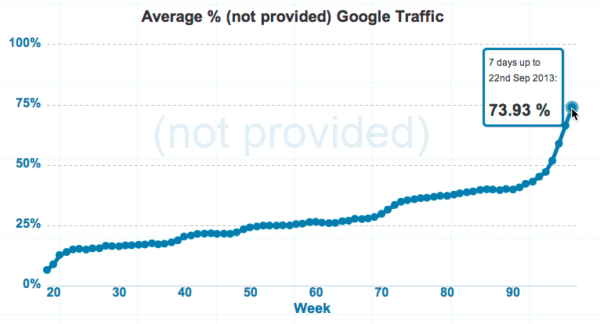

Apparemment, Google aurait petit à petit imposé la recherche en mode sécurisée à tous ses utilisateurs, depuis 1 mois selon l'expert Danny Sullivan (source). Ces changements de Google se sont traduits immédiatement par une hausse brutale du not provided comme le site notprovidedcount.com l'a mesuré sur son panel de 60 sites :

Hausse brutale du not provided en septembre 2013

Contacté, Google aurait répondu simplement :

Donc en gros, "nous travaillons actuellement afin d'apporter cette protection supplémentaire à plus d'utilisateurs qui ne sont pas connectés [à leur compte Google]".We added SSL encryption for our signed-in search users in 2011, as well as searches from the Chrome omnibox earlier this year. We’re now working to bring this extra protection to more users who are not signed in.

Si pour les professionnels du webmarketing et tous ceux qui prennent le référencement au sérieux c'est une très mauvaise nouvelle, il ne faut pas oublier que pour l'écrasante majorité des utilisateurs de Google, c'est soit une information incompréhensible pour eux, soit un point positif pour la protection de leur vie privée...

Historique des changements concernant le "not provided"

Voici la chronologie complète des recherches Google en mode sécurisé :- Mai 2010 : Google lance la recherche en mode sécurisé. Tous ceux qui l'utilisent privent les outils de web analytics d'informations sur la recherche qu'ils ont effectuée. Mais cela ne concerne que ceux qui font la démarche d'utiliser cette version spéciale de Google.

- Octobre 2011 : uniquement sur google.com, tous les utilisateurs connectés à leur compte Google sont automatiquement basculés sur la recherche sécurisée. Grosse hausse du not provided immédiate aux Etats-Unis.

- Mars 2012 : ce fonctionnement est alors étendu à toutes les versions de Google, y compris google.fr, ce qui fait exploser la part du not provided dans les stats des sites français. On a rapidement dépassé les 10% que Google avait prévu.

- Juin/juillet 2012 : avec la sortie de sa version 14, Firefox utilise désormais Google en mode sécurisé pour faire toutes les recherches (notamment via la barre de recherche du navigateur).

- Septembre 2012 : avec la sortie de iOS6, Safari sur mobiles utilise lui aussi Google en mode sécurisé, mais pour une raison assez obscure, la conséquence en termes de web analytics est bien pire puisque aucun referrer n'est transmis. Vous pouvez certainement voir dans vos stats une hausse brutale du nombre de visites en accès direct pour les utilisateurs de mobiles iOS. Le not provided ne progresse pas mais la part de requêtes connues chute autant.

- Janvier 2013 : Google impose la recherche SSL à tous les internautes utilisant Chrome 25, qu'ils soient connectés à leur compte Google ou pas.

- Septembre 2013 : Google impose petit à petit le SSL à tous les internautes... C'est la généralisation du not provided !

Les solutions au not provided

Je préfère être honnête avec vous : il n'y a AUCUNE réelle solution, il ne s'agit que de rustines.Google Analytics Premium n'est pas une solution

Imaginez-vous contourner le problème du not provided sous prétexte que vous déboursez 150.000$ par an pour cette version luxe de Google Analytics ? Perdu ! Même en payant ce prix exorbitant, vous n'aurez toujours pas accès aux mots-clés correspondant aux requêtes faites par les utilisateurs connectés à leur compte Google ! Vous aurez du (not provided) comme tout le monde...Not Provided : même la version premium de Google Analytics ne peut fournir les mots-clésCLICK TO TWEET

Aucun outil de mesure d'audience, qu'il soit basé sur un marqueur dans les pages web ou sur les logs, qu'il soit intégré à votre CMS ou pas, ne peut résoudre le problème du not provided, puisque Google supprime l'information en amont, avant que l'internaute ne quitte réellement le moteur de recherche...

L'analyse des logs n'est pas une solution

J'ai eu plusieurs questions que j'ai trouvées intéressantes et que je vous mets ici :- si Google passe effectivement en HTTPS, on ne devrait même pas avoir de referrer, alors y en a-t-il ou pas ?

- si je regarde dans mes logs, ne puis-je pas trouver les mots-clés de la requête tapée par l'internaute ?

- l'internaute arrive sur Google, qui le renvoie dans tous les cas vers une version sécurisée reconnaissable au fait qu'elle utilise le protocole HTTPS

- au moment où l'internaute clique sur le lien dans les résultats, Google n'envoie pas l'internaute directement vers le site web externe concerné : il le fait passer par une URL intermédiaire utilisant le protocole HTTP (et non plus HTTPS)

- c'est cette URL qui sera transmise en tant que referrer au site web qui reçoit la visite. Mais manque de chance, dans cette URL, là où est codée la requête de l'internaute, il ne reste plus rien : Google a supprimé la valeur du paramètre "q" (ou ses variantes).

78.226.234.219 - - [22/Sep/2013:08:44:18 +0200] "GET /disque-dur-portable-dell-protege-par-mot-passe-t98610.html HTTP/1.1" 200 13946 770611 "https://www.google.fr/?gws_rd=sslurl?sa=t&rct=j&q=&esrc=s&source=web&cd=1&ved=0CC8QFjAA&ei=wJE-UvXIM4Wi0QX5zoGQBg&usg=AFQjCNEzsLWTYtFG-_b75ULz2BRoj-GH8Q&sig2=HsL3BfGYT6ZXxtjZ_32l_w&bvm=bv.52434380,d.d2k" "Mozilla/5.0 (Windows NT 6.2; WOW64; rv:24.0) Gecko/20100101 Firefox/24.0"

On voit bien que le contenu du paramètre "q" a été vidé. On ne peut pas savoir ce que l'internaute avait fait comme recherche, mais on sait que c'était sur google.fr et sur quelle page du forum il est arrivé. Il y a d'autres infos dans les autres paramètres d'URL mais ils ne contiennent pas la requête.

Conclusion :

Not Provided : aucune analyse des logs ne peut fournir les mots-clés supprimés par GoogleCLICK TO TWEET

La solution du rapport de trafic dans Google Search Console

Comme vous le savez sans doute, malgré cette politique visant à masquer des données, Google continue de fournir les mots-clés générateurs de trafic en référencement naturel... mais uniquement de façon décorrélée des sessions. Concrètement, il s'agit d'une liste de requêtes ayant généré du trafic vers votre site depuis les SERP Google (SEO), avec la page d'arrivée.Mais ne vous réjouissez pas trop vite, il s'agit d'une fausse solution au problème du not provided, puisque vous ne pouvez pas savoir si ces visites ont été efficaces pour vous. Vous ne pouvez pas mesurer un taux de conversion (ou "transformation") et encore moins des ventes générées. Conclusion : vous ne pouvez pas calculer de ROI (retour sur investissement)... à moins d'opter pour la solution payante ci-après !

Not Provided : Search Console fournit un échantillon de mots-clés, mais sans taux de conversionCLICK TO TWEET

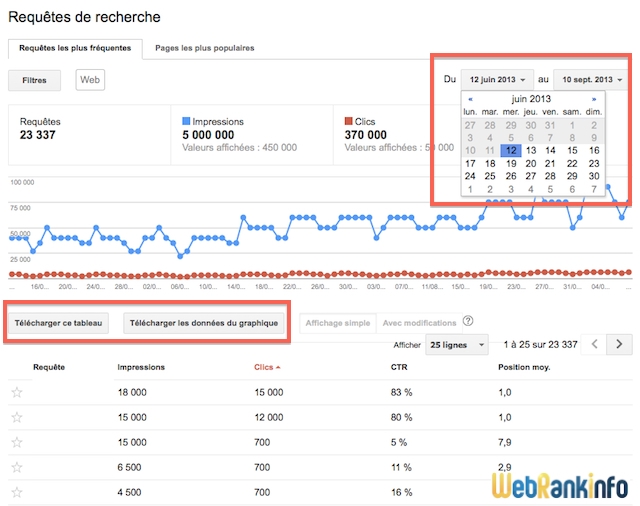

A l'heure actuelle, ce rapport des requêtes les plus fréquentes dans Google Search Console (GSC) est limité par les contraintes suivantes :

- aucun lien avec la notion de session et donc de taux de transformation

- les données des 16 derniers mois sont disponibles. Vous pouvez télécharger les données mais ce n'est pas pratique.

- seules les 1000 principales requêtes sont fournies

Voilà à quoi ça ressemble :

L'historique des données de mots-clés de trafic dans GSC

Ce rapport est également disponible dans Google Analytics (si vous reliez vos 2 comptes) mais ce n'est pas pour autant que les données de mots-clés sont raccordées aux données de sessions...

La solution Google AdWords

Je suppose que ça ne va pas vous étonner, mais comme par hasard les annonceurs AdWords (ceux qui contribuent à 95% des revenus de Google) ont la possibilité de connaître tous les mots-clés des requêtes des internautes. Et comme ils peuvent généralement faire le rapprochement avec les conversions (et/ou les ventes), c'est une solution très intéressante.Contrairement à ce qu'on peut entendre, il n'y a pas ici d'entrave à la vie privée : les données consultables dans AdWords sont agrégées et non associées aux internautes. Pourquoi Google n'offre pas la même chose dans Analytics ? Bonne question, mais pourquoi le ferait-il ? Et surtout gratuitement ?

Vous pouvez détester autant que vous voulez l'idée de devoir payer pour obtenir du trafic depuis Google, si vous ne l'avez pas encore fait, je pense qu'il va être temps de créer votre 1ère campagne AdWords. Faites attention à bien vous faire accompagner pour ne pas y laisser trop de plumes ! Si vous débutez, lisez mon tutoriel. Ensuite, posez vos questions dans le forum Ads ou inscrivez-vous à ma formation.

Une fois que vous aurez une (ou plusieurs) campagne AdWords en cours, vous aurez donc à nouveau accès aux rapports sur les requêtes ("termes de recherche" pour reprendre l'appellation utilisée par AdWords). Mais attention, ce rapport ne liste pas tous les mots-clés de recherche : ne sont affichés que les termes de recherche utilisés par les internautes il y a au moins 24 heures et qui ont enregistré des clics au cours des 30 derniers jours, ou alors un grand nombre de recherches.

La solution des autres moteurs de recherche

Vous allez bientôt adorer encore plus le trafic issu des autres moteurs... en tout cas tant qu'ils ne s'amusent pas à suivre Google dans cette tendance à imposer le SSL ! En consultant les rapports de trafic issu des rares autres moteurs (qui transmettent l'info), vous pouvez identifier les mots-clés qui vous génèrent du trafic.Mais en raison des parts de marché écrasantes de Google en Europe, vous aurez sans doute peu de données à vous mettre sous la dent... Et quand bien même, rien ne garantit que les statistiques soient transposables au trafic issu de Google.

La solution de l'analyse de la page d'arrivée

Attention, je vous le dis tout de suite : cette méthode ne vous indiquera aucun des mots-clés supprimés par Google, car c'est impossible à faire. Il s'agit ici de s'intéresser à une notion essentielle en web analytics : la page d'arrivée, la première page que découvre l'internaute qui arrive de votre site.L'idée est d'appliquer un filtre Google Analytics qui va renommer le "(not provided)" pour le remplacer par une combinaison du type "NP {URI d'arrivée}". Par exemple si quelqu'un arrive sur cette page https://www.webrankinfo.com/forum/t/100-de-not-provided-google-impose-la-recherche-en-ssl.167959/, enregistrée sous /dossiers/google-search/generalisation-not-provided dans Google Analytics, alors le filtre va renommer le soit-disant mot-clé "(not provided)" en "NP /dossiers/google-search/generalisation-not-provided".

Ceci permet d'affiner votre analyse, en sachant au moins quelle page de votre site s'est positionnée dans Google et sur laquelle l'internaute est arrivé.

Pour aller un peu plus loin, on peut envisager de coupler cette analyse avec l'étude détaillée du referrer, qui dans le cas de Google contient (parfois ?) la position du résultat cliqué. Il faut alors croiser cela avec une analyse de positionnement, mais en pratique je considère cela quasi impossible. Sans compter qu'avec la personnalisation des résultats, c'est encore plus compliqué.