Vous utilisez un navigateur non à jour ou ancien. Il ne peut pas afficher ce site ou d'autres sites correctement.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Update Fred : grosse mise à jour Google pour le SEO [mars 2017]

- Auteur de la discussion manubu

- Date de début

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

L'impression que l'éolienne de Spout tourne plus vite que d'habitude,

est-ce que je me trompe ?

L'impression que l'éolienne de Spout tourne plus vite que d'habitude,

est-ce que je me trompe ?

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

en même temps ça brasse pas mal de vent se genre de sujet.

Sinon je n'ai pas vu de changement pour mon site.

en même temps ça brasse pas mal de vent se genre de sujet.

Sinon je n'ai pas vu de changement pour mon site.

Update Fred de Google (enfin officielle) : infos et conseils

Que s'est il donc passé chez Google vers le 8 mars 2017 ? Un changement d'algo important c'est certain ! Suite à une blague sur Twitter, il a été appelé Fred. Voici mes trouvailles sur Fred v1...Article mis à jour le 03/04/2017 (détails par Gary Illyes de Google), publié initialement le 20/03/0217

La sortie non officielle de l'update Fred, finalement officialisée !

On a commencé à en entendre parler le 8 mars 2017 ici même sur le forum WebRankInfo, avant même le veilleur SEO le plus attentif, à savoir Barry Schwartz qui a publié son 1er article ensuite. C'est lui qui a popularisé ce nom "Fred" après une discussion avec Gary Illyes (de Google). J'utiliserai donc ce nom dans le reste de l'article (c'est pas plus ridicule que Panda, Pingouin ou Pigeon).A ce moment-là, les premiers sites touchés (impact négatif) semblaient surtout ceux gérés par des black hat, c'est-à-dire utilisant des méthodes contraires aux consignes de Google. Voyez par exemple cette discussion sur BlackHatWorld.

On a donc logiquement pensé que la mise à jour Fred était basée essentiellement sur les backlinks, puisqu'il s'agit encore des moyens les plus efficaces (en tout cas à court terme) pour booster un site dans Google.

Puis, d'autres témoignages sont arrivés, au fur et à mesure que d'autres sites ont été concernés. Comme je l'explique dans le reste de cet article, il est possible que le déploiement de Fred ce soit fait en plusieurs phases.

On a eu beau demander à Google une confirmation de cette mise à jour, on a eu droit au désormais traditionnel "Oui tout à fait, il s'est passé quelque chose ce jour-là, d'ailleurs il y a au moins 2 updates chaque jour

Comme d'autres fois, après 1 ou 2 semaines de pression, les "porte-parole" de Google ont fini par confirmer qu'il y a bien eu une mise à jour. D'abord Gary Illyes sur Twitter :

puis John Mueller dans un hangout vidéo :

Si l'on en croit John, il s'agit d'une mise à jour concernant l'évaluation globale de la qualité du site, ce qui colle à peu près à mon avis perso détaillé dans le reste de cet article.

Edit du 03/04/2017 : Gary Illyes a précisé qu'il y a eu plusieurs mises à jour autour des dates correspondant à ce qu'on appelle "Fred Update". Voici son tweet :

Dit autrement : il y a eu plusieurs mises à jour correspondant à des critères différents, à quelques jours d'intervalle. Pour moi cela colle bien avec l'idée qu'il y a effectivement eu une mise à jour de l'évaluation des backlinks (pour sanctionner ceux qui en ont trop d'artificiels) ET des mises à jour sur la qualité (similaires à celles de Panda et Phantom).From my perspective every update is a Fred, but there were a number of updates around the date @rustybrick declared Fred a single thing.

— Gary 鯨理/경리 Illyes (@methode) April 1, 2017

Mon avis sur l'update Fred

Ayant accès à pas mal de sites (clients consulting, clients de ma plateforme SEO, contacts en tous genres via WebRankInfo), j'ai comme toujours pour les gros "updates" fait ma petite enquête.Je vais vous donner toutes les infos que j'ai pu trouver, et même si ça ne vaut pas grand chose, j'espère que ça pourra vous aider. Dans ce cas, merci de partager cet article !

Comme pour toute mise à jour (brutale) d'algo de Google, j'ai fait un certain nombre d'analyses avec mes outils dont évidemment Google Analytics, Google Search Console et l'analyse du positionnement. Il s'agit ici d'abord d'établir s'il y a eu un impact (positif ou négatif). Dans le reste de l'article, j'utiliserai le terme "pénalisé" pour parler d'un site dont le trafic a chuté avec Fred, même si on ne devrait parler de pénalité que pour les actions manuelles.

Ensuite, surtout pour les sites impactés négativement par Fred, j'ai creusé.

Logiquement, j'ai commencé par auditer leurs backlinks, à la recherche de stratégies de netlinking risquées.

J'ai aussi évalué l'optimisation SEO globale de chaque site en lançant un audit RM Tech pour chacun. Même si tout le monde ne parlait que de backlinks, j'ai souhaité évaluer la qualité des pages concernées. Pour ça, l'algo maison QualityRisk de ma plateforme My Ranking Metrics me fait gagner un temps fou (d'ailleurs, je ne vois pas avec quel autre outil je pourrais ainsi repérer des pages suspectes parmi les milliers de ces sites web).

Enfin, sur les pages les plus concernées par la mise à jour, j'ai fait une analyse humaine.

Voici donc mes conclusions à l'heure où je publie cet article (cliquez pour partager sur Twitter)...

La 1ère cause de pénalité est l'abus de backlinks artificiels, c'est-à-dire ne respectant par les consignes de Google. Comme très souvent, c'est surtout une trop forte dose d'ancres exactes qui fait chuter (texte du lien = uniquement des mots-clés).

Un point très important à mon avis : les liens en cause peuvent être très anciens, au moins plusieurs années. C'est comme si Fred incluait une partie de Penguin (algo contre la suroptimisation SEO et particulièrement les backlinks), mais avec une évaluation différente. Je rappelle que Penguin est censé être inclus dans l'algo global de Google, et mis à jour en continu.

Marie Haynes a montré un exemple de site qui a remonté en flèche avec Fred, alors qu'il avait lourdement chuté en 2014 à cause des backlinks artificiels. Un gros travail de nettoyage avait été fait et c'est avec Fred qu'il a porté du fruit. C'est un indice de plus que la suppression ou le désaveu des liens toxiques peut effectivement aider à faire remonter un site.

Voilà son tweet :

J'ai lu que certains pensent qu'ensuite le site est pénalisé sur les requêtes concernées par ces backlinks artificiels, mais sur l'ensemble du site, pas seulement la page de destination. Voilà un exemple :

Ce n'est pas tout à fait mon avis, mais c'est quasi impossible de le savoir de façon très précise.

En fait, et c'est un autre élément majeur de Fred selon moi, l'algo cherche à évaluer si l'on peut encore faire confiance au site. Si Google repère un trop gros nombre de liens "toxiques", la confiance accordée au site chute d'un coup.

La conséquence est que le site perd des positionnements sur des requêtes pour lesquelles il était 1er depuis très longtemps, avec des pages 100% clean, y compris sans aucun backlink. La chute est bien moins forte que pour les pages recevant les BL artificiels (j'ai vu du -60% de trafic !) mais elle peut atteindre 10%, pile le même jour.

D'ailleurs, à part repérer ces chutes pour des pages n'ayant absolument rien à se reprocher, un autre indice m'a amené à cette conclusion sur cette "perte de confiance".

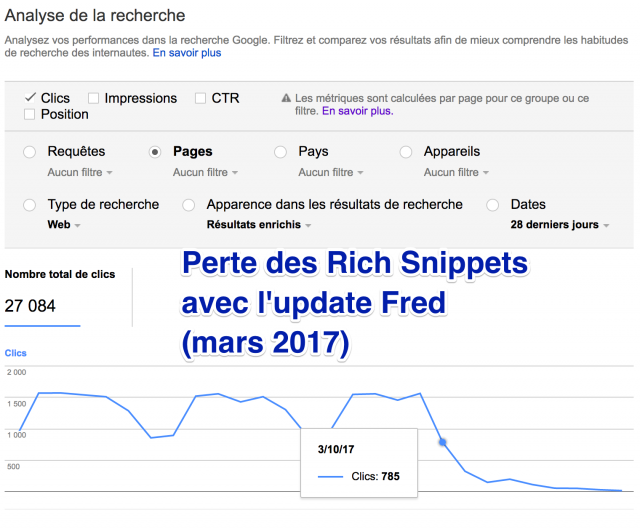

En effet, j'ai remarqué qu'un site pénalisé avec Fred perdait souvent l'affichage des étoiles dans les pages de résultats Google (on appelle ça les rich snippets liés aux avis). Vous le savez sans doute, pour bénéficier de cet "extrait enrichi", il faut non seulement respecter à la lettre les spécifications techniques mais aussi être sélectionné par l'algo.

Dans Search Console, vous pouvez obtenir le nombre de clics ou impressions dans les SERP de vos pages ayant un extrait enrichi. Voici ce que ça donne pour un site étudié :

Pour Google, ce site ne mérite donc plus cet affichage, même si les pages contiennent toujours le code requis. Il va devoir "revenir dans les clous" et prouver que Google peut encore "lui faire confiance"... Il s'agit de pages clean (j'ai vérifié, tous les liens sont OK et le contenu est de qualité) d'un site ayant par ailleurs des pages avec BL artificiels.

Autre sujet, la pub. La relation de Google avec la pub est vraiment "Je t'aime moi non plus", ne trouvez-vous pas ? C'est ce qui enrichit tant Google, mais qui peut aussi plomber ceux qui en abusent sur leur site. Pas Google, qui sur ce coup est plutôt "Faites ce que je dis mais (surtout) pas ce que je fais."...

Pas mal de sites pénalisés par Fred avaient un peu trop de pub, certes. Mais d'une part j'ai trouvé des sites sans aucune pub pénalisés et d'autre part la plupart des cas étudiés n'affichaient pas de publicité de façon excessive.

Peut-être qu'il faut la voir comme un élément qui dégrade la qualité perçue des pages, un critère parmi d'autres. Et que pour certains sites, c'est un mauvais point supplémentaire qu'il aurait fallu éviter ?

A part les mauvais liens et la pub, je vous avoue avoir du mal à distinguer ce qui déplait à Fred. En tout cas, ce qui le différencie des autres algos de Google.

Au fait, connaissez-vous les principaux ?Le top 10 des algos de Google

Je suis globalement assez d'accord avec Jennifer Slegg qui pense que Fred est une sorte de nouvelle méthode d'évaluation de la qualité d'un site, prenant en compte aussi bien les aspects internes (comme Panda et Phantom) qu'externes (comme Penguin).

Le problème que vous aurez après avoir lu son article, en tout cas c'était mon sentiment, c'est "je ne suis pas vraiment avancé"...

Que faire concrètement ?

Maintenant que le temps a passé, il est temps de décider quoi faire pour remonter, n'est-ce pas ?A votre place, voici les 2 premières actions que je ferais, dans l'ordre :

1- un audit vraiment exhaustif de vos backlinks, incluant même les plus anciens (ceux que vous n'aviez pas désavoués, pensant être passé "entre les mailles du filet"). Concentrez-vous sur ceux pointant vers les pages ayant très fortement chuté. Les backlinks indéniablement "artificiels" doivent être supprimés (je sais, c'est quasi impossible) ou désavoués (même si ça vous fait mal, avez-vous vraiment d'autres solutions ?).

Si vous ne savez pas comment faire,je peux faire un audit de backlinks

Evidemment, si par miracle vous pouvez obtenir des bons liens pour compenser, c'est encore mieux !

2- un audit de qualité de l'ensemble de votre site, en commençant là aussi par les pages ayant le plus chuté. Demandez-vous si la page est construite pour apporter une réponse à l'internaute qui débarque dessus depuis Google. Tout ce qui peut jouer en défaveur de sa satisfaction doit être corrigé (abus de publicité, contenu trop faible, temps de chargement trop long, incompatibilité mobile, inexactitudes dans les informations fournies, etc.).

Si vous avez un petit site ça devrait être rapide, mais dans le cas inverse c'est une autre paire de manches... Bon courage !

Pour un 1er repérage des pages de mauvaise qualité,regardez leur QualityRisk

Les autres avis

Juan Gonzalez de l'outil Sistrix a étudié 300 sites dont l'indice de visibilité dans Google (selon son outil) a chuté après le 13 mars. Il donne ici des exemples de sites pour l'Allemagne, l'Espagne, le UK et les USA. Voici son résumé :Ce qui signifie :Nearly all losers were very advertisement heavy, especially banner ads, many of which were AdSense campaigns. Another thing that we often noticed was that those sites offered little or poor quality content, which had no value for the reader. It seem that many, but not all, websites are affected who tried to grab a large number of visitors from Google with low quality content, which they then tried to quickly and easily monetize through affiliate programs.

Certains sites avaient pu croître très rapidement avant de s'effondrer avec cet update. C'est le cas par exemple d'un site qui se contente d'afficher sur chaque page le code postal d'une ville, noyé sous la pub :Presque tous les perdants contenaient beaucoup de publicités, surtout des bannières, AdSense pour la plupart. Nous avons également remarqué que ces sites offraient peu de contenus de qualité, ou des contenus pauvres sans valeur ajoutée pour le lecteur. Il semble que beaucoup des sites pénalisés (mais pas tous) tentaient de récupérer le plus de trafic possible depuis Google avec du contenu de faible qualité, pour ensuite essayer de le monétiser rapidement par de l'affiliation.

Voici sa conclusion :

Ce qui signifie :Through those nearly 300 domains it became very apparent that many pages had a lot of advertisement, outdated, thin and scraped content, as well as incomprehensible articles made up of 300 word “SEO texts” pumped to the brim with main keyword mentions and void of any useful information or a sense of readability.

Sur ces 300 sites, cela saute aux yeux que beaucoup avaient des pages avec trop de publicités et un contenu pas à jour, superficiel ou "pompé ailleurs" (scraped), ou bien des articles incompréhensibles de 300 mots de "textes SEO" pompés de partout avec des répétitions du mot-clé principal et vides de toute information utile ou de bonne lisibilité.

Et vous ?

PS : ils en parlent aux US, surtout du côté des black hat semble-t-il. rien de mon côté en tout cas !

https://www.seroundtable.com/google-algorithm-ranking-update-23523.html

Re: Mega baffe Google 07/03/2017 [update SEO]

2 sites avec une perte de > 60% du trafic organique depuis hier matin. SERP instauré en 1e page dans les premiers résultats en laissant faire Google sur 3 ans, sans optimisation particulière. J'ai lu que certains ont récupérés leur KW hier en fin d'après-midi. Où en êtes-vous ?

2 sites avec une perte de > 60% du trafic organique depuis hier matin. SERP instauré en 1e page dans les premiers résultats en laissant faire Google sur 3 ans, sans optimisation particulière. J'ai lu que certains ont récupérés leur KW hier en fin d'après-midi. Où en êtes-vous ?

Re: Mega baffe Google 07/03/2017 [update SEO]

Idem, j'ai deux sites qui se sont fait dégagés de manière brutale hier (-60% de trafic). Ces sites sont propres pourtant (en interne et même côté backlinks), pas d'optimisation particulière moi non plus et ils étaient bien placés dans l'index depuis pas mal de temps. J'avoue qu'à première vue j'ai du mal à comprendre la dégringolade.

Je note par contre une chose assez bizarre. Sur ces deux sites, le jour de la perte de positions, le temps de chargement des pages (données Analytics) est incroyablement haut. Temps de chargement X3 ou 4 par rapport à d'habitude.

Idem, j'ai deux sites qui se sont fait dégagés de manière brutale hier (-60% de trafic). Ces sites sont propres pourtant (en interne et même côté backlinks), pas d'optimisation particulière moi non plus et ils étaient bien placés dans l'index depuis pas mal de temps. J'avoue qu'à première vue j'ai du mal à comprendre la dégringolade.

Je note par contre une chose assez bizarre. Sur ces deux sites, le jour de la perte de positions, le temps de chargement des pages (données Analytics) est incroyablement haut. Temps de chargement X3 ou 4 par rapport à d'habitude.

Re: Mega baffe Google 07/03/2017 [update SEO]

Pareil, j'ai 2 sites qui ont une perte très importante de trafic.

Ils tournent tous les 2 à 2500 visites jours (à peu près) et là ils sont passés à 800.

Pourtant ils n'utilisent pas de black-hat.

Je pense à un gros bug ou encore un update non communiqué.

Pareil, j'ai 2 sites qui ont une perte très importante de trafic.

Ils tournent tous les 2 à 2500 visites jours (à peu près) et là ils sont passés à 800.

Pourtant ils n'utilisent pas de black-hat.

Je pense à un gros bug ou encore un update non communiqué.

Re: Mega baffe Google 07/03/2017 [update SEO]

Visiblement certain ont vue leurs pages revenir dans Google après quelques heures...

Source : https://productforums.google.com/forum/#!topic/webmasters/O0UelPsPOYk/discussion

Visiblement certain ont vue leurs pages revenir dans Google après quelques heures...

Source : https://productforums.google.com/forum/#!topic/webmasters/O0UelPsPOYk/discussion

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

https://www.seroundtable.com/google-fred-algorithm-update-23529.html

À prioris, c'est une mise à jour sur la qualité des liens et son petit nom est Fred.

https://www.seroundtable.com/google-fred-algorithm-update-23529.html

À prioris, c'est une mise à jour sur la qualité des liens et son petit nom est Fred.

WRInaute passionné

Re: Mega baffe Google 07/03/2017 [update SEO]

Et la bannière Adsense scotchée en haut de page (c'est d'ailleurs strictement interdit!) qui joue le rôle d'intersticiel, ça ne gêne pas peut être??? 8O (voir le WWW de ton profil en Desktop... en Mobile, l'affichage est bon)manubu a dit:Alors là je me suis pris une méga baffe

Re: Mega baffe Google 07/03/2017 [update SEO]

d'après Glenn Gabe, ça serait effectivement lié aux liens "artificiels"

d'après Glenn Gabe, ça serait effectivement lié aux liens "artificiels"

Re: Mega baffe Google 07/03/2017 [update SEO]

D'après ce que j'ai pu lire des forums et des discussions en cours, il semble que beaucoup de webmaster ont des sites de qualité sans lien artificiels et sans techniques obscures avec référencement naturel sur plusieurs années, mais ils sont touchés pareils (en mode faux positifs). :roll:

WebRankInfo a dit:d'après Glenn Gabe, ça serait effectivement lié aux liens "artificiels"

D'après ce que j'ai pu lire des forums et des discussions en cours, il semble que beaucoup de webmaster ont des sites de qualité sans lien artificiels et sans techniques obscures avec référencement naturel sur plusieurs années, mais ils sont touchés pareils (en mode faux positifs). :roll:

Re: Mega baffe Google 07/03/2017 [update SEO]

Merci pour ton retour, en fait j'ai l'impression que j'ai un problème avec le CSS qui a sauté en partie. Lorsque je réactualise tout rentre dans l'ordre. Et le problème n'apparaît pas sur tous les navigateurs. Je vois ça de suite.

anemone-clown a dit:Et la bannière Adsense scotchée en haut de page (c'est d'ailleurs strictement interdit!) qui joue le rôle d'intersticiel, ça ne gêne pas peut être??? 8O (voir le WWW de ton profil en Desktop... en Mobile, l'affichage est bon)manubu a dit:Alors là je me suis pris une méga baffe

Merci pour ton retour, en fait j'ai l'impression que j'ai un problème avec le CSS qui a sauté en partie. Lorsque je réactualise tout rentre dans l'ordre. Et le problème n'apparaît pas sur tous les navigateurs. Je vois ça de suite.

WRInaute passionné

Re: Mega baffe Google 07/03/2017 [update SEO]

Apparemment, ça apparaît surtout lors de la première visite sur le site :

A gauche avec Firefox, 2e accès : c'est bon. A droite, Edge, 1ère visite, c'est tout faux. Soit un souci JS (script sur les cookies?), soit CSS. Faut étudier.

Edit : c'est cool les pubs, on voit que je viens de visiter le site de Bose... :lol:

Apparemment, ça apparaît surtout lors de la première visite sur le site :

A gauche avec Firefox, 2e accès : c'est bon. A droite, Edge, 1ère visite, c'est tout faux. Soit un souci JS (script sur les cookies?), soit CSS. Faut étudier.

Edit : c'est cool les pubs, on voit que je viens de visiter le site de Bose... :lol:

Re: Mega baffe Google 07/03/2017 [update SEO]

Merci. En fait je viens de trouver ce script non pas en local, mais sur le code source lorsque le site est en ligne :

<div id="ggoggo" style="position:fixed;top:0px;left:0px;width:750px;overflow:visible;z-index:2147483645;"><script language="javascript" type="text/javascript" src="//pagead2.googlesyndication.com/pagead/show_ads.js"></script><div style="position:absolute;right:0;top:0;z-index:2147483646;opacity:1.0;width:60px;height:20px;padding:0px;margin:0px;"> </div></div>

Une personne a dû pénétrer dans le système et l'installer. Je sens que ça va être la galère. Comment trouver le script ?

Merci. En fait je viens de trouver ce script non pas en local, mais sur le code source lorsque le site est en ligne :

<div id="ggoggo" style="position:fixed;top:0px;left:0px;width:750px;overflow:visible;z-index:2147483645;"><script language="javascript" type="text/javascript" src="//pagead2.googlesyndication.com/pagead/show_ads.js"></script><div style="position:absolute;right:0;top:0;z-index:2147483646;opacity:1.0;width:60px;height:20px;padding:0px;margin:0px;"> </div></div>

Une personne a dû pénétrer dans le système et l'installer. Je sens que ça va être la galère. Comment trouver le script ?

Re: Mega baffe Google 07/03/2017 [update SEO]

Perdu près de 5000 visiteurs par jour. Franchement, je ne pense pas que google revienne en arrière. Barry sur seroundtable.com pense que les sites touchés ont un lien avec les pubs : pas assez de qualitatif et trop de pubs. Ceux qui seraient remontés auraient très fortement limiter et virer les pubs. Mais à priori tout le monde n'est pas d'accord dans la mesure où des sites sans pub ont été touchés. Comme d'hab on ne saura pas. Bon bref, la panade quoi.

Perdu près de 5000 visiteurs par jour. Franchement, je ne pense pas que google revienne en arrière. Barry sur seroundtable.com pense que les sites touchés ont un lien avec les pubs : pas assez de qualitatif et trop de pubs. Ceux qui seraient remontés auraient très fortement limiter et virer les pubs. Mais à priori tout le monde n'est pas d'accord dans la mesure où des sites sans pub ont été touchés. Comme d'hab on ne saura pas. Bon bref, la panade quoi.

Re: Mega baffe Google 07/03/2017 [update SEO]

Avez vous également constaté une chute importante de visiteurs sur Bing également et a la même période ? (le 08/03)

J'en parle ici

https://www.webrankinfo.com/forum/t/maj-importante-de-bing-le-08-03-2017.190444/

@Manubu : En pourcentage tu as perdu combien de visiteurs ? avant de repartir a zero mieux vaut attendre quelques jours pour voir comment ca va se passer et si il y a plus d'infos sur les causes de cette chute. 5000 visiteurs c’est effectivement énorme

Avez vous également constaté une chute importante de visiteurs sur Bing également et a la même période ? (le 08/03)

J'en parle ici

https://www.webrankinfo.com/forum/t/maj-importante-de-bing-le-08-03-2017.190444/

@Manubu : En pourcentage tu as perdu combien de visiteurs ? avant de repartir a zero mieux vaut attendre quelques jours pour voir comment ca va se passer et si il y a plus d'infos sur les causes de cette chute. 5000 visiteurs c’est effectivement énorme

Re: Mega baffe Google 07/03/2017 [update SEO]

je suis étonné qu'aussi peu de monde parle de cet update en France, car c'est bien plus fort que début février

moi aussi je trouve difficile de comprendre sur quoi se base l'update. Les BL sont semble-t-il un critère important, la pub également mais dans une moindre mesure.

je suis étonné qu'aussi peu de monde parle de cet update en France, car c'est bien plus fort que début février

moi aussi je trouve difficile de comprendre sur quoi se base l'update. Les BL sont semble-t-il un critère important, la pub également mais dans une moindre mesure.

Re: Mega baffe Google 07/03/2017 [update SEO]

Ouais on aimerait bien en savoir un peu plus sur cette MAJ. De toute façon il n'y a quasiment plus aucune transparence avec Google. On se contentera de "c'est juste une MAj parmi les 1000 chaque année". ou des "Si vous respectez les consignes vous n'avez pas à craindre les MAJ". Allons dire ça à tous les webmasters qui du jour au lendemain perdent une bonne partie de leur trafic sans comprendre les causes. A quoi sert de punir si on n'explique pas derrière. Faudrait que GG regarde un peu super nanni :roll:

C’est également chiant à la longue de voir des pages passer de la 1ere page a la 10eme page puis quelques mois après à la 1ere , puis quelques semaines après a la 20eme puis 3 mois après a la 2eme page etc. A un moment donné on a envie de lui demander "tu l'aimes ou tu l'aimes pas ma page bordel ?"

Et on attend toujours une MAJ réellement efficace contre les réseaux de sites (pages satellites, link wheel..) qui pullulent et se gavent toujours comme des porcs. Ceux qui abusent le plus et qui le font délibérément ne semblent pas forcément les cibles les plus touchées par leurs MAJ !

Ouais on aimerait bien en savoir un peu plus sur cette MAJ. De toute façon il n'y a quasiment plus aucune transparence avec Google. On se contentera de "c'est juste une MAj parmi les 1000 chaque année". ou des "Si vous respectez les consignes vous n'avez pas à craindre les MAJ". Allons dire ça à tous les webmasters qui du jour au lendemain perdent une bonne partie de leur trafic sans comprendre les causes. A quoi sert de punir si on n'explique pas derrière. Faudrait que GG regarde un peu super nanni :roll:

C’est également chiant à la longue de voir des pages passer de la 1ere page a la 10eme page puis quelques mois après à la 1ere , puis quelques semaines après a la 20eme puis 3 mois après a la 2eme page etc. A un moment donné on a envie de lui demander "tu l'aimes ou tu l'aimes pas ma page bordel ?"

Et on attend toujours une MAJ réellement efficace contre les réseaux de sites (pages satellites, link wheel..) qui pullulent et se gavent toujours comme des porcs. Ceux qui abusent le plus et qui le font délibérément ne semblent pas forcément les cibles les plus touchées par leurs MAJ !

Re: Mega baffe Google 07/03/2017 [update SEO]

Pour ma part, toujours pas de retour arrière. Toujours pénalisé.

J'ai perdu plus de 60% de trafic.

Je précise que sur les 2 sites qui ont perdu autant de visites, ce sont des sites essentiellement basés sur de l'adsense.

Ça me générait de beaux revenus mensuels qui sont en chute libre.

Je pense vraiment que Google pénalise les sites avec des faibles contenus par rapport aux nombres de pubs importantes.

Je ne sais pas trop comment améliorer ça car mes sites ont des pages qui se génèrent toutes seules (ça se compte en millions).

Pour ma part, toujours pas de retour arrière. Toujours pénalisé.

J'ai perdu plus de 60% de trafic.

Je précise que sur les 2 sites qui ont perdu autant de visites, ce sont des sites essentiellement basés sur de l'adsense.

Ça me générait de beaux revenus mensuels qui sont en chute libre.

Je pense vraiment que Google pénalise les sites avec des faibles contenus par rapport aux nombres de pubs importantes.

Je ne sais pas trop comment améliorer ça car mes sites ont des pages qui se génèrent toutes seules (ça se compte en millions).

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

Une grosse partie de mes sites connaissent une bonne progression vers la première page sur énormément de mots clés depuis la MàJ alors que d'autres en ont pris plein la face. Si ça peut en rassurer quelques uns, ça commence à "revenir à la normale" pour l'un d'entre eux.

Une grosse partie de mes sites connaissent une bonne progression vers la première page sur énormément de mots clés depuis la MàJ alors que d'autres en ont pris plein la face. Si ça peut en rassurer quelques uns, ça commence à "revenir à la normale" pour l'un d'entre eux.

Nouveau WRInaute

Re: Mega baffe Google 07/03/2017 [update SEO]

Bonsoir.

Que pensez vous de cette théorie sur FRED , un soucis de google analytics ?

http://www.logitheque.com/articles/google_fred_update_comment_recupere ... u_1494.htm

Bonsoir.

Que pensez vous de cette théorie sur FRED , un soucis de google analytics ?

http://www.logitheque.com/articles/google_fred_update_comment_recupere ... u_1494.htm

Re: Mega baffe Google 07/03/2017 [update SEO]

Fred est un changement d'algo, je ne vois pas comment cette histoire de bug analytics pourrait avoir un rapport

Fred est un changement d'algo, je ne vois pas comment cette histoire de bug analytics pourrait avoir un rapport

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

Bon, je pensais que c'était une (forte) accélération de Phantom V, mais là je suis rassuré. Même si je devrais pas. La baisse des positions a été plus flippante que l'impact sur la fréquentation.

C'est vrai que notre site est lié à pas mal de .de, .ru, mais je ne comprends pas pourquoi Google "le savant" l'AI n'analyse pas que ces sites posent eux même les liens. Il connait quand même ses sujets. :mrgreen: Quel impact sur la sacro sainte expérience utilisateur?

Pourquoi dégringoler des sites pour des liens qui seraient de sites black hats, comme si on s'amusait à faire copain avec des russes BH. Il blackliste ces liens de sites et terminé. Comme il me cause encore des erreurs 404 avec de (très) vieux topics de spammeurs éradiqués en -24H...

Après, le tuto ou un des tutos de WRI est assez flippant (et court) sur le désaveu de lien via google. Donc, je vais me renseigner.

Et concernant les pubs aussi, on dirait que les rules ont changées. Si quelqu'un peut me donner deux trois conseils sur adsense, je prends...

La bonne nouvelle, c'est les positions remontent doucement. Que les réseaux sociaux prennent un peu le relais.

Bon, je pensais que c'était une (forte) accélération de Phantom V, mais là je suis rassuré. Même si je devrais pas. La baisse des positions a été plus flippante que l'impact sur la fréquentation.

C'est vrai que notre site est lié à pas mal de .de, .ru, mais je ne comprends pas pourquoi Google "le savant" l'AI n'analyse pas que ces sites posent eux même les liens. Il connait quand même ses sujets. :mrgreen: Quel impact sur la sacro sainte expérience utilisateur?

Pourquoi dégringoler des sites pour des liens qui seraient de sites black hats, comme si on s'amusait à faire copain avec des russes BH. Il blackliste ces liens de sites et terminé. Comme il me cause encore des erreurs 404 avec de (très) vieux topics de spammeurs éradiqués en -24H...

Après, le tuto ou un des tutos de WRI est assez flippant (et court) sur le désaveu de lien via google. Donc, je vais me renseigner.

Et concernant les pubs aussi, on dirait que les rules ont changées. Si quelqu'un peut me donner deux trois conseils sur adsense, je prends...

La bonne nouvelle, c'est les positions remontent doucement. Que les réseaux sociaux prennent un peu le relais.

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

Bon, bon... complément d'info et je me réponds: le côté adsense semble plus que probable. Site non ultra niché (ou plutôt avec des extensions pour compléments d'infos), avec un peu pub sur certains articles. Voila que Google nous a pris pour une MFA. Et bien on retire. Pour ce que çà rapporte avec 3000VU de nos jours (çà file la nostalgie des RV mensuels sur WRI il y a dix ans). On faisait çà dans les clous pour faire Google team.... 3 Pubs par pages: bannière en haut, carré sur la colonne et une ligne en bas de page (le terme m'échappe tellement je mate la console adsense)

Là, on rentrerait bien dans les critères qu'avancent les ricains sur le sujet. :roll:

L'impact date du 03/03 avec une perte sur des KW importants mais pas de grosses baisses de fréquentation. Là, çà remonte mais on va enlever quand même la bannière en 700 pour commencer

Bon, bon... complément d'info et je me réponds: le côté adsense semble plus que probable. Site non ultra niché (ou plutôt avec des extensions pour compléments d'infos), avec un peu pub sur certains articles. Voila que Google nous a pris pour une MFA. Et bien on retire. Pour ce que çà rapporte avec 3000VU de nos jours (çà file la nostalgie des RV mensuels sur WRI il y a dix ans). On faisait çà dans les clous pour faire Google team.... 3 Pubs par pages: bannière en haut, carré sur la colonne et une ligne en bas de page (le terme m'échappe tellement je mate la console adsense)

Là, on rentrerait bien dans les critères qu'avancent les ricains sur le sujet. :roll:

L'impact date du 03/03 avec une perte sur des KW importants mais pas de grosses baisses de fréquentation. Là, çà remonte mais on va enlever quand même la bannière en 700 pour commencer

Re: Mega baffe Google 07/03/2017 [update SEO]

J'ai lu l'article (merci Olivier), mais j'arrive pas vraiment à comprendre ce qui différencie Fred et Pingouin.

Bien des noms pour la même chose en fin de compte.

Donc même si pingouin nous fou enfin la paix, on est pas a l'abri de se prendre le Fred !!

Moi qui pensait que l'outil de désaveu était devenu inutile depuis quelques mois (il me semblait avoir lu ça quelque part)

J'ai lu l'article (merci Olivier), mais j'arrive pas vraiment à comprendre ce qui différencie Fred et Pingouin.

Bien des noms pour la même chose en fin de compte.

Donc même si pingouin nous fou enfin la paix, on est pas a l'abri de se prendre le Fred !!

Moi qui pensait que l'outil de désaveu était devenu inutile depuis quelques mois (il me semblait avoir lu ça quelque part)

Nouveau WRInaute

Salut Fred !

Bonjour,

Et voilà, Google m'a retuer

Après une pingouinisation en règle en 2012, c'est une fredisation faciale qui dégomme définitivement mes sites encore vivants.

Pour résumer :

8 sites -> 4 sont tombés avec pingouin (jamais vraiment remontés) et 3 cette fois-ci depuis début mars... (mais 1 est remonté en 1ère page la semaine dernière)

Pubs adsense : 1 bandeau par page max.

Réseaux : fb+twitter+g+ pour chacun avec une activité limitée mais un bon nombre d'abonnés (jusqu'à 700 pour 3 des 8 sites)

Sites tous en https

7 sites sont sous SPIP et 1 sous phpbb.

1 site est tombé malgré une bonne fréquentation et des liens depuis des articles de journalistes depuis de grands médias nationaux.

Je n'ai jamais référencé dans des annuaires (tout du moins depuis 2008) et je ne pratique pas (sciemment en tout cas) de stratégies malsaines (don't be evil je crois qu'on dit(sait) ?) tout au plus des liens depuis les réseaux pour dynamiser un peu les sites (ça reste quand même un minimum, on ne va pas renier son propre travail)

Mes pages d'index sont parties dans les limbes et quelques pages profondes remontent sur les mots clefs.

C'est incompréhensible, d'autant plus quand on est nul en référencement...

Le plus comique, c'est qu'un site "vitrine" totalement dénué de visites et statique au possible est super bien classé sur ses mots clefs. J'ai un peu le sentiment que les serps, c'est comme les aquariums, plus tu touches aux poiscailles, plus tu déséquilibres.

Moralité : une page statique sous Frontpage express avec la recette du thon au Nutella et ça roule !

A rien n'y comprendre.

Bonjour,

Et voilà, Google m'a retuer

Après une pingouinisation en règle en 2012, c'est une fredisation faciale qui dégomme définitivement mes sites encore vivants.

Pour résumer :

8 sites -> 4 sont tombés avec pingouin (jamais vraiment remontés) et 3 cette fois-ci depuis début mars... (mais 1 est remonté en 1ère page la semaine dernière)

Pubs adsense : 1 bandeau par page max.

Réseaux : fb+twitter+g+ pour chacun avec une activité limitée mais un bon nombre d'abonnés (jusqu'à 700 pour 3 des 8 sites)

Sites tous en https

7 sites sont sous SPIP et 1 sous phpbb.

1 site est tombé malgré une bonne fréquentation et des liens depuis des articles de journalistes depuis de grands médias nationaux.

Je n'ai jamais référencé dans des annuaires (tout du moins depuis 2008) et je ne pratique pas (sciemment en tout cas) de stratégies malsaines (don't be evil je crois qu'on dit(sait) ?) tout au plus des liens depuis les réseaux pour dynamiser un peu les sites (ça reste quand même un minimum, on ne va pas renier son propre travail)

Mes pages d'index sont parties dans les limbes et quelques pages profondes remontent sur les mots clefs.

C'est incompréhensible, d'autant plus quand on est nul en référencement...

Le plus comique, c'est qu'un site "vitrine" totalement dénué de visites et statique au possible est super bien classé sur ses mots clefs. J'ai un peu le sentiment que les serps, c'est comme les aquariums, plus tu touches aux poiscailles, plus tu déséquilibres.

Moralité : une page statique sous Frontpage express avec la recette du thon au Nutella et ça roule !

A rien n'y comprendre.

WRInaute accro

Re: Mega baffe Google 07/03/2017 [update SEO]

Il est vilain Gogole pas gentil la... si il se met a pénaliser les innocents qui n'ont rien fait de mal...

Mais jusqu'ou s'arretera-t-il ????

C'est trop injuste....

Moralité : une page statique sous Frontpage express avec la recette du thon au Nutella et ça roule !

A rien n'y comprendre.

Il est vilain Gogole pas gentil la... si il se met a pénaliser les innocents qui n'ont rien fait de mal...

Mais jusqu'ou s'arretera-t-il ????

C'est trop injuste....

WRInaute discret

Re: Mega baffe Google 07/03/2017 [update SEO]

Tiens tiens, forte chute Serp (pas réellement en trafic, le site est réputé consistant) dès le 3 mars sur certains mots clés sous SPIP également (cf mes topics du mois) et PhpBB, avec en parallèle une forte augmentation des pages crawlés, comme si Google recompilait toutes les pages déclassées: à voir pour le côté quality, je pense que cette activité des bots et a prendre en considération, puis indexation des images sur ce CMS, balises Hs.

Et peut être responsivité. Pourquoi pas, car c'était le sujet du début d'année et SPIP n'est pas très mobile friendly... Donc un mixe dans mon cas: qualité -car je suis obligé d'utiliser des rubriques et articles peu chargés pour des départs d'arbos-, la responsivité et enfin la densité pub sur des pages qui ne méritent pas adsense 8). J'ai des pages peu intéressantes(archives pour ma part) et une incongruité de fait possible dans l'arbo et dans la nav sous mobile: cela peux aussi froisser.

Je penche plus pour un côté Panda comme il se dit outre Atlantique. Je n'ai pas été réellement impacté par les pinguins, même si des sites étrangers de tous poils pointent. Après on peut échanger sur les sites en MP car SPIP engendre des spécificités que je travaille également à lisser avant de... migrer.

Désolé pour les édits, je cause et bois le café en même temps... :mrgreen:

Tiens tiens, forte chute Serp (pas réellement en trafic, le site est réputé consistant) dès le 3 mars sur certains mots clés sous SPIP également (cf mes topics du mois) et PhpBB, avec en parallèle une forte augmentation des pages crawlés, comme si Google recompilait toutes les pages déclassées: à voir pour le côté quality, je pense que cette activité des bots et a prendre en considération, puis indexation des images sur ce CMS, balises Hs.

Et peut être responsivité. Pourquoi pas, car c'était le sujet du début d'année et SPIP n'est pas très mobile friendly... Donc un mixe dans mon cas: qualité -car je suis obligé d'utiliser des rubriques et articles peu chargés pour des départs d'arbos-, la responsivité et enfin la densité pub sur des pages qui ne méritent pas adsense 8). J'ai des pages peu intéressantes(archives pour ma part) et une incongruité de fait possible dans l'arbo et dans la nav sous mobile: cela peux aussi froisser.

Je penche plus pour un côté Panda comme il se dit outre Atlantique. Je n'ai pas été réellement impacté par les pinguins, même si des sites étrangers de tous poils pointent. Après on peut échanger sur les sites en MP car SPIP engendre des spécificités que je travaille également à lisser avant de... migrer.

Désolé pour les édits, je cause et bois le café en même temps... :mrgreen:

Nouveau WRInaute

Re: Mega baffe Google 07/03/2017 [update SEO]

Merci Furtif et spout, vachement agréable de causer avec vous ! Mépris et condescendance vis-à-vis des idiots-qui-ne-savent-pas-referencer (tiens, ça me rappelle pourquoi j'ai boudé WRI avec le temps, un gros complexe d'infériorité et de gros frais de psychanalyse). Pour un forum d’entraide, ça la fout mal quand même d'avoir toujours quelqu'un qui t'en met plein la tête ! :twisted:

Et concernant SPIP, @redaccabanes depuis les dégâts de pingouin, je me suis demandé si ce n'était pas finalement le dénominateur commun (car, oui, je n'ai à priori rien à me reprocher)

Le responsive laisse à désirer (quoi que sur les dernières versions) mais je crois que Google fait bien la distinction et d'ailleurs je n'ai pas d'avertissement à ce sujet dans les wmt.

Mais bon, je ne vais pas m'attarder ici, il fait trop froid.

Merci Furtif et spout, vachement agréable de causer avec vous ! Mépris et condescendance vis-à-vis des idiots-qui-ne-savent-pas-referencer (tiens, ça me rappelle pourquoi j'ai boudé WRI avec le temps, un gros complexe d'infériorité et de gros frais de psychanalyse). Pour un forum d’entraide, ça la fout mal quand même d'avoir toujours quelqu'un qui t'en met plein la tête ! :twisted:

Et concernant SPIP, @redaccabanes depuis les dégâts de pingouin, je me suis demandé si ce n'était pas finalement le dénominateur commun (car, oui, je n'ai à priori rien à me reprocher)

Le responsive laisse à désirer (quoi que sur les dernières versions) mais je crois que Google fait bien la distinction et d'ailleurs je n'ai pas d'avertissement à ce sujet dans les wmt.

Mais bon, je ne vais pas m'attarder ici, il fait trop froid.

WRInaute accro

Re: Mega baffe Google 07/03/2017 [update SEO]

"C'est incompréhensible, d'autant plus quand on est nul en référencement..."

En 10 ans t'as rien appris ?? c'est la faute a Gogole ?

Il n'y a aucun mépris ou condescendance dans mes propos, simplement un constat : il est plus facile de trouver un coupable pour justifier tes pénalités, plutôt que de te remettre en question.. et corriger le tir..

Si Gogole "t'as retué" ca veut dire que tu n'as pas tiré les leçons de/des premières fois, et en général il n'y a pas de fumée sans feu... mais comme tu le dit, je cite :

"car, oui, je n'ai à priori rien à me reprocher"

Bé c'est la faute aux autres, c'est sûr....

Il est plus facile de se plaindre que de changer...

10 ans que tu fais du web et tu dis, je cite :Merci Furtif et spout, vachement agréable de causer avec vous !

"C'est incompréhensible, d'autant plus quand on est nul en référencement..."

En 10 ans t'as rien appris ?? c'est la faute a Gogole ?

Il n'y a aucun mépris ou condescendance dans mes propos, simplement un constat : il est plus facile de trouver un coupable pour justifier tes pénalités, plutôt que de te remettre en question.. et corriger le tir..

Si Gogole "t'as retué" ca veut dire que tu n'as pas tiré les leçons de/des premières fois, et en général il n'y a pas de fumée sans feu... mais comme tu le dit, je cite :

"car, oui, je n'ai à priori rien à me reprocher"

Bé c'est la faute aux autres, c'est sûr....

Il est plus facile de se plaindre que de changer...

Re: Mega baffe Google 07/03/2017 [update SEO]

Bonjour,

Les propos des "tontons flingueurs" commencent à devenir gonflants.

S'ils confondent dénigrement, moqueries ... et entraide, qu'ils retournent rejoindre les rangs des "Matheux beuh!"

Merci de faire quelque chose.

Cordialement,

Eric

Bonjour,

Les propos des "tontons flingueurs" commencent à devenir gonflants.

S'ils confondent dénigrement, moqueries ... et entraide, qu'ils retournent rejoindre les rangs des "Matheux beuh!"

Merci de faire quelque chose.

Cordialement,

Eric

WRInaute accro

Re: Mega baffe Google 07/03/2017 [update SEO]

Bah je dis ce que je pense, mais si tu préfères l'hypocrisie...

mais te concernant, je vais m'abstenir de te répondre car je risquerai d'être extrêmement désagréable...

Tu viens tellement souvent...

Et grâce a toi je prends conscience que le temps consacré au forum, me serait beaucoup plus profitable pour pas mal d'autres choses...

Tu vois tu auras au moins aidé quelqu'un sur ce forum...

Donc je te remercie pour ca, j'arrête mes contributions et mes blagues... tu vas retrouver la paix.. je quitte le forum...

Salut la Cie...

Les propos des "tontons flingueurs" commencent à devenir gonflants.

Bah je dis ce que je pense, mais si tu préfères l'hypocrisie...

mais te concernant, je vais m'abstenir de te répondre car je risquerai d'être extrêmement désagréable...

Tu viens tellement souvent...

Et grâce a toi je prends conscience que le temps consacré au forum, me serait beaucoup plus profitable pour pas mal d'autres choses...

Tu vois tu auras au moins aidé quelqu'un sur ce forum...

Donc je te remercie pour ca, j'arrête mes contributions et mes blagues... tu vas retrouver la paix.. je quitte le forum...

Salut la Cie...

WRInaute occasionnel

Re: Salut Fred !

Je reprend tes points positifs en fonction des autres posts :wink:

Je reprend tes points positifs en fonction des autres posts :wink:

Donc c'est pas la pub :wink:Dr Sbaitso a dit:Pubs adsense : 1 bandeau par page max.

Regarde le nombre de visiteurs effectifs qui viennent de là .... très pauvre.Dr Sbaitso a dit:Réseaux : fb+twitter+g+ pour chacun avec une activité limitée mais un bon nombre d'abonnés (jusqu'à 700 pour 3 des 8 sites)

donc pas de cause a effetDr Sbaitso a dit:Sites tous en https

Selon Gary Illyes (de Google), il y a eu plusieurs mises à jour autour des dates correspondant à ce qu'on appelle "Fred Update".

Dit autrement : il y a eu plusieurs mises à jour correspondant à des critères différents, à quelques jours d'intervalle.

Pour moi cela colle bien avec l'idée qu'il y a effectivement eu une mise à jour de l'évaluation des backlinks (pour sanctionner ceux qui en ont trop d'artificiels) ET des mises à jour sur la qualité (similaires à celles de Panda et Phantom).

Qu'en pensez-vous ?

Dit autrement : il y a eu plusieurs mises à jour correspondant à des critères différents, à quelques jours d'intervalle.

Pour moi cela colle bien avec l'idée qu'il y a effectivement eu une mise à jour de l'évaluation des backlinks (pour sanctionner ceux qui en ont trop d'artificiels) ET des mises à jour sur la qualité (similaires à celles de Panda et Phantom).

Qu'en pensez-vous ?

WRInaute occasionnel

Bonjour,

J'avais trois pubs par page et je venais de mettre (le mois dernier) le contenu correspondant.

Après être descendu de 1500 visites/j à 700 et en lisant les conseils, j'ai viré le contenu correspondant et je viens de remonter à 1000 visites.

Et un petit site nouveau, sans rajout de pub (pas de contenu correspondant) n'a pas bougé mais est en train de grimper alors que j'y travail rarement, genre un ou deux articles par mois.

J'avais trois pubs par page et je venais de mettre (le mois dernier) le contenu correspondant.

Après être descendu de 1500 visites/j à 700 et en lisant les conseils, j'ai viré le contenu correspondant et je viens de remonter à 1000 visites.

Et un petit site nouveau, sans rajout de pub (pas de contenu correspondant) n'a pas bougé mais est en train de grimper alors que j'y travail rarement, genre un ou deux articles par mois.

WRInaute passionné

Oui, ça semble coller à ce que j'observe : liens artificiels et qualité. Curieusement, des pages (de qualité, plus de 1000 mots parfois) qui avaient sensiblement baissées au cours de Mars (-2 ou -3 places, au profit de pages de bien moindre qualité -faible contenu- mais certainement peu travaillées en SEO) sont remontées ensuite avec une certaine stabilité, comme si les algos n'interagissaient pas ensembles simultanément mais étaient appliqués les uns derrière les autres.WebRankInfo a dit:Pour moi cela colle bien avec l'idée qu'il y a effectivement eu une mise à jour de l'évaluation des backlinks (pour sanctionner ceux qui en ont trop d'artificiels) ET des mises à jour sur la qualité (similaires à celles de Panda et Phantom).

Qu'en pensez-vous ?

WRInaute passionné

Ca dépend aussi de la position de ce bloc de contenu correspondant qui est assez long à charger : s'il est en fond de page (comme habituellement), je doute que ça ait une grosse influence sur des pages de qualité. S'il est assez haut dans la page, alors le temps d'affichage pourrait être pénalisant.DomTo a dit:Après être descendu de 1500 visites/j à 700 et en lisant les conseils, j'ai viré le contenu correspondant et je viens de remonter à 1000 visites...

Pour ma part, cette mise à jour de Mars ne viens de toucher mes sites que depuis le 5 avril.

je n'ai pas encore fait le tour de tout mes sites, ni tout analysé mais pour certain la perte est bien de 50-60 % de visiteurs par jours.

Elle s'explique basiquement par la disparition TOTALE des sites sur certains mots clés.

Alors que le site étaient premiere page sur un ensemble de mots clés, il a totalement disparu ( ce qui explique la perte de 50 % )

Il n'y a pas eu de référencement forcé , de mauvais référencement sur ces sites, du referencement naturel, des pages de qualités ect ...

Et par contre, quand sur ces mots clés je fait la recherche, je trouve que les nouveaux résultats ne sont pas pertinant.

Exemple inventé :

Je recherche "restaurant de fruit de mer sur star city"

* Avant je trouvais des restaurants de fruits de mer à star city dans les premiers liens, puis des restaurants tout court à star city.

* Maintenant je ne trouve plus de restaurant à star city, mais un article de journal de 2014 sur un restaurant à central city ou une star à mangé, ou un site de recette, avec une recette de fruit réalisé par une personne qui vit au bord de la mer ...

Les exemples sont certes inventé mais totalement cohérent avec la recherche réelle

En tant qu'utilisateur, je n'y trouve pas mon compte.

Je verrais en tant que vrais utilisateur comment ça se passe, mais je pense que si tout le monde est affecté de la meme maniere, la pertinence des recherches va s'en ressentir.

En attendant, je pleure les milliers de visiteurs perdu que je sais pas comment retrouver !!!

Comment un site classé 5eme peut totalement disparaitre ???

je n'ai pas encore fait le tour de tout mes sites, ni tout analysé mais pour certain la perte est bien de 50-60 % de visiteurs par jours.

Elle s'explique basiquement par la disparition TOTALE des sites sur certains mots clés.

Alors que le site étaient premiere page sur un ensemble de mots clés, il a totalement disparu ( ce qui explique la perte de 50 % )

Il n'y a pas eu de référencement forcé , de mauvais référencement sur ces sites, du referencement naturel, des pages de qualités ect ...

Et par contre, quand sur ces mots clés je fait la recherche, je trouve que les nouveaux résultats ne sont pas pertinant.

Exemple inventé :

Je recherche "restaurant de fruit de mer sur star city"

* Avant je trouvais des restaurants de fruits de mer à star city dans les premiers liens, puis des restaurants tout court à star city.

* Maintenant je ne trouve plus de restaurant à star city, mais un article de journal de 2014 sur un restaurant à central city ou une star à mangé, ou un site de recette, avec une recette de fruit réalisé par une personne qui vit au bord de la mer ...

Les exemples sont certes inventé mais totalement cohérent avec la recherche réelle

En tant qu'utilisateur, je n'y trouve pas mon compte.

Je verrais en tant que vrais utilisateur comment ça se passe, mais je pense que si tout le monde est affecté de la meme maniere, la pertinence des recherches va s'en ressentir.

En attendant, je pleure les milliers de visiteurs perdu que je sais pas comment retrouver !!!

Comment un site classé 5eme peut totalement disparaitre ???

WRInaute discret

Il y aurait eu des soupçons d'update google le 4 avril, peut-être es-tu dans ce cas ?

https://www.seroundtable.com/google-update-4-4-23667.html

Sinon, comme disent les autres en général, difficile de t'aider à interpréter si tu n'indiques pas quel est ton site

https://www.seroundtable.com/google-update-4-4-23667.html

Sinon, comme disent les autres en général, difficile de t'aider à interpréter si tu n'indiques pas quel est ton site

Nouveau WRInaute

Bonjour,

Idem pour moi, 2 sites qui ont dégagé en mars sont revenus à leur position initiale hier / avant-hier sur leurs mots clefs de référence.

Je n'ai fait aucune modification du code, de liens éventuels ci-ou-là, donc aucun bidouillage particulier, j'ai juste, las, laissé mourir ces sites sous le rouleau compresseur depuis le mois de mars.

Je persiste et signe -> A rien n'y comprendre !!!

Voilà, je partage cette info.

Caliméro

Idem pour moi, 2 sites qui ont dégagé en mars sont revenus à leur position initiale hier / avant-hier sur leurs mots clefs de référence.

Je n'ai fait aucune modification du code, de liens éventuels ci-ou-là, donc aucun bidouillage particulier, j'ai juste, las, laissé mourir ces sites sous le rouleau compresseur depuis le mois de mars.

Je persiste et signe -> A rien n'y comprendre !!!

Voilà, je partage cette info.

Caliméro

Nouveau WRInaute

Re: Mega baffe Google 07/03/2017 [update SEO]

D'ailleurs à revenir sur le forum :

Furtif tente de me faire passer pour un c** puisque son post a été modifié pour le rendre "moins" méchant :

- > Publié le le "Lun Mar 27, 2017 11:37"

Et modifié le :

-> Modifié en dernier par Furtif le Lun Mar 27, 2017 11:40, modifié 1 fois.

Soit 3 minutes plus tard.

HORS ceci est totalement faux, puisque Furtif a laissé au moins pendant 24 heures (et je suis gentil) un Gif animé absolument méprisant à mon égard avec une grosse dame probablement décérébrée d'une TV réalité débile qui pleure...

...puis il l'a modifié beaucoup plus tard car il devait se sentir vraiment bête !

Donc, je n'ai rien remonté à ce moment là, me disant qu'il préférait modérer son post, plutôt que de s'excuser, mais là, c'est carrément de la duperie puisque la date/heure de la modif du forum phpbb a été carrément modifiée !!!

C'EST UN PEU FACILE TOUT CA, MONSIEUR FURTIF !!!

Des excuses et tout serait rentré dans l'ordre, mais non... tu me fais passer pour un c** et c'est insupportable car je suis un humain comme toi et certainement très compétent, comme toi en référencement, mais sur des sujets qui t'échappent totalement et pour lesquels je ne me permettrais pas de t'envoyer de telles claques !

@Olivier Duffez, pourrais-tu éclairer ma lanterne, STP ?

Merci

Caliméro ("l'innocent pénalisé qui n'a rien fait de mal")

Furtif a dit:Moralité : une page statique sous Frontpage express avec la recette du thon au Nutella et ça roule !

A rien n'y comprendre.

Il est vilain Gogole pas gentil la... si il se met a pénaliser les innocents qui n'ont rien fait de mal...

Mais jusqu'ou s'arretera-t-il ????

C'est trop injuste....

D'ailleurs à revenir sur le forum :

Furtif tente de me faire passer pour un c** puisque son post a été modifié pour le rendre "moins" méchant :

- > Publié le le "Lun Mar 27, 2017 11:37"

Et modifié le :

-> Modifié en dernier par Furtif le Lun Mar 27, 2017 11:40, modifié 1 fois.

Soit 3 minutes plus tard.

HORS ceci est totalement faux, puisque Furtif a laissé au moins pendant 24 heures (et je suis gentil) un Gif animé absolument méprisant à mon égard avec une grosse dame probablement décérébrée d'une TV réalité débile qui pleure...

...puis il l'a modifié beaucoup plus tard car il devait se sentir vraiment bête !

Donc, je n'ai rien remonté à ce moment là, me disant qu'il préférait modérer son post, plutôt que de s'excuser, mais là, c'est carrément de la duperie puisque la date/heure de la modif du forum phpbb a été carrément modifiée !!!

C'EST UN PEU FACILE TOUT CA, MONSIEUR FURTIF !!!

Des excuses et tout serait rentré dans l'ordre, mais non... tu me fais passer pour un c** et c'est insupportable car je suis un humain comme toi et certainement très compétent, comme toi en référencement, mais sur des sujets qui t'échappent totalement et pour lesquels je ne me permettrais pas de t'envoyer de telles claques !

@Olivier Duffez, pourrais-tu éclairer ma lanterne, STP ?

Merci

Caliméro ("l'innocent pénalisé qui n'a rien fait de mal")

WRInaute accro

Re: Mega baffe Google 07/03/2017 [update SEO]

Impossible, après 6 heures on ne peut plus modifier un post, ça doit donc être un modérateur qui l'a fait.Dr Sbaitso a dit:puisque Furtif a laissé au moins pendant 24 heures (et je suis gentil) un Gif animé absolument méprisant à mon égard avec une grosse dame probablement décérébrée d'une TV réalité débile qui pleure...

...puis il l'a modifié car il devait se sentir vraiment bête !

Nouveau WRInaute

Re: Mega baffe Google 07/03/2017 [update SEO]

CLAIREMENT car j'ai vu le gif animé disparaître (et sans parler du texte mais je ne pourrais le jurer) et ce n'était pas 4 MINUTES après !

Donc tout s'est fait en loucedé ! Je trouve ça pitoyable

spout a dit:Impossible, après 6 heures on ne peut plus modifier un post, ça doit donc être un modérateur qui l'a fait.Dr Sbaitso a dit:puisque Furtif a laissé au moins pendant 24 heures (et je suis gentil) un Gif animé absolument méprisant à mon égard avec une grosse dame probablement décérébrée d'une TV réalité débile qui pleure...

...puis il l'a modifié car il devait se sentir vraiment bête !

CLAIREMENT car j'ai vu le gif animé disparaître (et sans parler du texte mais je ne pourrais le jurer) et ce n'était pas 4 MINUTES après !

Donc tout s'est fait en loucedé ! Je trouve ça pitoyable

WRInaute occasionnel

Re: Mega baffe Google 07/03/2017 [update SEO]

Déjà ce qui m'inquiète sur ce forum en 2017, c'est le manque de partage des informations.

Et surtout la désinformation (ou l'absense de réflexion) et en partie des légendes urbaines concernant les "sanctions". En plus, la majorité des sujets intéressants tournent de plus en plus en haut de boudain. Humour pas trop adéquate (ou pas trop compris) des anciens peut-être (parfois sans doute, c'est du langage bruxellois) et des plus nouveaux qui prennent quasiment tout au mot.

Dans le paquet, je met 6-7 posts juste au-dessus avec Furtif et Spout qu'on changera pas :wink: et des plus neufs (désolé pour le terme) comme Dr Sbaitso, eldk.

C'est un forum de référencement: il y a 10 ans, un producteur de champagne se pointait déjà ici pour annoncer qu'il allait supprimer du personnel parce que ses pages s'étaient écroulées: Une perte n'est pas liée à une volonté de Google de privilégier l'un ou l'autre, ni d'en tuer un autre mais à des modifications de classement lié à des modifs d'algorythme.

Pas toujours d'accord avec Furtif et d'autres, mais les réflexions "Google m'a tué", "J'ai rien fait", forcément, ca devient lourd à force. J'excuse pas les réponses humoristique en bas de paquerette et finalement sans rapport avec le sujet :roll: mais sur certains posts, on a tendance à répondre à une bétise par une autre ... connerie.

Google gagne sa vie avec Adsense (y compris sur nos sites), pourquoi il déclasserait des sites utilisant adsence modérément en respectant la chartre. Une MFA, c'est un terme de fin des années 90: petit exemple, site qui parle de piscine (donc plutôt rémunérateur) avec 3 adsence et 15 autres régies avec pas un réel contenu instructif sur le CONTENU. Quand la régie publicitaire Google décide de casser les revenus, plus aucune pub en fonction du contenu (chez moi, sur certaines pages de programmation: recevoir des pubs de rencontre, caddy de grandes surfaces en alimentaire et autres ... c'est mort comme revenu).

Les liens, faudra arrêter un jour de mettre tout sur le compte des autres

C'est pas les liens qui posent problèmes mais la manière de les mettre (y compris pour FRED et ... Pinguin)

J'aime bien le mail d'Olivier reçu fin de semaine concernant les sites Link :roll: (avec un lien d'un article de 2015).

1. vous voulez mettre des liens entre sites liés (qui ont l'habitude de se mettre des liens)? En fin de contenu. https://www.google.fr/search?sourceid=navclient&aq=&oq=os2&hl=fr&ie=UT ... Ucqk#spf=1 Un site .be avec 1 lien externe d'un autre site.

La technique d'Olivier en plein contenu est fausse (qui date de 2005) . C'est comme cela qu'on s'en est pris une avec Pinguin, puis peut-être sur FRED.

L'Anchor des liens répétitifs :roll: (analysé sur Pinguin et aussi valable ... en partie pour FRED): léggende urbaine de nouveau et repris sur ce forum. En 1998 et 2003 (entre-autre), des membres de ce forum avaient publié des résultats de tests au niveau des américains avec leurs gros moyens financiers.

J'ai plus des copains avec une équipe de tests sur ce forum, je teste plus vraiment non plus et mes sites sont tous basés sur de l'html. Autant dire que peu de liens internes sont répétitifs: tous les anchors sont fait manuellement, page par page. En interne, mettre des Anchor identiques ne casse pas le poids des liens internes, les modifier systématiquement OUI (je parle par expérience)

Ne virez pas les liens de sites pas trop standards (je l'ai fait avec un développement spécial et les sites ont dégringolés). On arrête de croire que le blackhat EXISTE pour des sites standards.

et je reprend un de mes posts sur ce tropic.

PS: si on arrêtait de poster des disputes et recommencer à PARTAGER, ca serait pas mal.

PS2: désolé Olivier, mais reprendre des vieux articles avec des tyechniques de deux ans, c'est pas logiques et pas correct (parle référencement)

PS3: les vieilles raisons de déclassement annoncé par des outils (les liens), faudra trouver autre chose sir on veux avancer

J'avais dis que j' m'énerverais plus

Déjà ce qui m'inquiète sur ce forum en 2017, c'est le manque de partage des informations.

Et surtout la désinformation (ou l'absense de réflexion) et en partie des légendes urbaines concernant les "sanctions". En plus, la majorité des sujets intéressants tournent de plus en plus en haut de boudain. Humour pas trop adéquate (ou pas trop compris) des anciens peut-être (parfois sans doute, c'est du langage bruxellois) et des plus nouveaux qui prennent quasiment tout au mot.

Dans le paquet, je met 6-7 posts juste au-dessus avec Furtif et Spout qu'on changera pas :wink: et des plus neufs (désolé pour le terme) comme Dr Sbaitso, eldk.

C'est un forum de référencement: il y a 10 ans, un producteur de champagne se pointait déjà ici pour annoncer qu'il allait supprimer du personnel parce que ses pages s'étaient écroulées: Une perte n'est pas liée à une volonté de Google de privilégier l'un ou l'autre, ni d'en tuer un autre mais à des modifications de classement lié à des modifs d'algorythme.

Pas toujours d'accord avec Furtif et d'autres, mais les réflexions "Google m'a tué", "J'ai rien fait", forcément, ca devient lourd à force. J'excuse pas les réponses humoristique en bas de paquerette et finalement sans rapport avec le sujet :roll: mais sur certains posts, on a tendance à répondre à une bétise par une autre ... connerie.

PS: désolé de commencer par ton post, c'est pas contre toi.rédac cabanes a dit:le côté adsense semble plus que probable. Site non ultra niché (ou plutôt avec des extensions pour compléments d'infos), avec un peu pub sur certains articles. Voila que Google nous a pris pour une MFA.

Google gagne sa vie avec Adsense (y compris sur nos sites), pourquoi il déclasserait des sites utilisant adsence modérément en respectant la chartre. Une MFA, c'est un terme de fin des années 90: petit exemple, site qui parle de piscine (donc plutôt rémunérateur) avec 3 adsence et 15 autres régies avec pas un réel contenu instructif sur le CONTENU. Quand la régie publicitaire Google décide de casser les revenus, plus aucune pub en fonction du contenu (chez moi, sur certaines pages de programmation: recevoir des pubs de rencontre, caddy de grandes surfaces en alimentaire et autres ... c'est mort comme revenu).

Dans beaucoup d'exemples, Oui. Par contre, il a une modif en fonction de la langue: definition XX (avec le même XX en Français qu'en anglais), maintenant, les sites US ont déménagés sur Google.fr.NoWayHome a dit:Les exemples sont certes inventé mais totalement cohérent avec la recherche réelle

Les liens, faudra arrêter un jour de mettre tout sur le compte des autres

C'est pas les liens qui posent problèmes mais la manière de les mettre (y compris pour FRED et ... Pinguin)

J'aime bien le mail d'Olivier reçu fin de semaine concernant les sites Link :roll: (avec un lien d'un article de 2015).

1. vous voulez mettre des liens entre sites liés (qui ont l'habitude de se mettre des liens)? En fin de contenu. https://www.google.fr/search?sourceid=navclient&aq=&oq=os2&hl=fr&ie=UT ... Ucqk#spf=1 Un site .be avec 1 lien externe d'un autre site.

La technique d'Olivier en plein contenu est fausse (qui date de 2005) . C'est comme cela qu'on s'en est pris une avec Pinguin, puis peut-être sur FRED.

L'Anchor des liens répétitifs :roll: (analysé sur Pinguin et aussi valable ... en partie pour FRED): léggende urbaine de nouveau et repris sur ce forum. En 1998 et 2003 (entre-autre), des membres de ce forum avaient publié des résultats de tests au niveau des américains avec leurs gros moyens financiers.

J'ai plus des copains avec une équipe de tests sur ce forum, je teste plus vraiment non plus et mes sites sont tous basés sur de l'html. Autant dire que peu de liens internes sont répétitifs: tous les anchors sont fait manuellement, page par page. En interne, mettre des Anchor identiques ne casse pas le poids des liens internes, les modifier systématiquement OUI (je parle par expérience)

Ne virez pas les liens de sites pas trop standards (je l'ai fait avec un développement spécial et les sites ont dégringolés). On arrête de croire que le blackhat EXISTE pour des sites standards.

et je reprend un de mes posts sur ce tropic.

patrick_lejeune a dit:Je reprend tes points positifs en fonction des autres posts :wink:

Donc c'est pas la pub :wink:Dr Sbaitso a dit:Pubs adsense : 1 bandeau par page max.

Regarde le nombre de visiteurs effectifs qui viennent de là .... très pauvre.Dr Sbaitso a dit:Réseaux : fb+twitter+g+ pour chacun avec une activité limitée mais un bon nombre d'abonnés (jusqu'à 700 pour 3 des 8 sites)

donc pas de cause a effetDr Sbaitso a dit:Sites tous en https

PS: si on arrêtait de poster des disputes et recommencer à PARTAGER, ca serait pas mal.

PS2: désolé Olivier, mais reprendre des vieux articles avec des tyechniques de deux ans, c'est pas logiques et pas correct (parle référencement)

PS3: les vieilles raisons de déclassement annoncé par des outils (les liens), faudra trouver autre chose sir on veux avancer

J'avais dis que j' m'énerverais plus

Re: Mega baffe Google 07/03/2017 [update SEO]

tu veux dire qu'il ne faut pas mettre les liens dans leur contexte, mais à la fin de la page ? c'est sûr que c'est tellement plus pratique pour l'internaute

Google ne gagne pas d'argent avec les éditeurs qui affichent des AdSense, mais avec les annonceurs qui paient les campagnes AdWords. J'ai vu assez de cas, dont certains hallucinants, me permettant de conclure que l'algo de Google se fiche totalement qu'un site soit affilié AdSense ou pas.patrick_lejeune a dit:Google gagne sa vie avec Adsense (y compris sur nos sites), pourquoi il déclasserait des sites utilisant adsence modérément en respectant la chartre.

tu parles des liens internes ou externes ?patrick_lejeune a dit:La technique d'Olivier en plein contenu est fausse (qui date de 2005) . C'est comme cela qu'on s'en est pris une avec Pinguin, puis peut-être sur FRED.

tu veux dire qu'il ne faut pas mettre les liens dans leur contexte, mais à la fin de la page ? c'est sûr que c'est tellement plus pratique pour l'internaute

WRInaute discret

Vu le nombre de message et la date d'inscription au 1er avril, p_lejeune m'a tout l'air de ce que l'on appelle un troll.

Mes sources à l'époque où l'Update à commencé pour cette analyse, furent les sites de SEO US les plus compétents qui se sont penchés, avant tout le monde, sur des stats en temps réels qui correspondaient à cette date à une sanction de type MFA entre autres. Donc, avant de de parler de conneries il faut mettre un filtre entre son cerveau et son clavier.

Mes sources à l'époque où l'Update à commencé pour cette analyse, furent les sites de SEO US les plus compétents qui se sont penchés, avant tout le monde, sur des stats en temps réels qui correspondaient à cette date à une sanction de type MFA entre autres. Donc, avant de de parler de conneries il faut mettre un filtre entre son cerveau et son clavier.

Membre Honoré

Les gens sont ici pour partager des idées. Keep cool.rédac cabanes a dit:Vu le nombre de message et la date d'inscription au 1er avril, p_lejeune m'a tout l'air de ce que l'on appelle un troll.

Re: Mega baffe Google 07/03/2017 [update SEO]

Après, avec adsense, même si le site n'a pas gg analytics, gg peut savoir si l'internaute reste plus ou moins longtemps sur un site et donc avoir quelques éléments permettant de reconnaitre si le site a réellement du contenu intéressant ou est juste du MFA

euh, un MFA a une ergonomie tentant de faire croire aux internautes que la pub n'est que du lien interne : l'internaute va donc cliquer puis s'apercevoir ensuite qu'il a changé de site. Il va donc refermer la page. Mais l'annonceur va refuser de payer ce clic vu que l'internaute a fermé sa page moins de 2 seconde après y être arrivé. Donc à force de voir nombre de clics refusés par les annonceurs, gg va supprimer les pubs rentables sur les sites à risques. Ca peut être aussi l'annonceur, qui vérifie les referers de ses visiteurs en provenance de pubs et qui souhaite ne pas afficher sur des sites de mauvaise qualité.patrick_lejeune a dit:Google gagne sa vie avec Adsense (y compris sur nos sites), pourquoi il déclasserait des sites utilisant adsence modérément en respectant la chartre. Une MFA, c'est un terme de fin des années 90: petit exemple, site qui parle de piscine (donc plutôt rémunérateur) avec 3 adsence et 15 autres régies avec pas un réel contenu instructif sur le CONTENU. Quand la régie publicitaire Google décide de casser les revenus, plus aucune pub en fonction du contenu (chez moi, sur certaines pages de programmation: recevoir des pubs de rencontre, caddy de grandes surfaces en alimentaire et autres ... c'est mort comme revenu).

Après, avec adsense, même si le site n'a pas gg analytics, gg peut savoir si l'internaute reste plus ou moins longtemps sur un site et donc avoir quelques éléments permettant de reconnaitre si le site a réellement du contenu intéressant ou est juste du MFA

WRInaute occasionnel

Chez nous, on utilise une expression dans une salle de lotto, cette dernière est "coup de sac" . La personne qui annonce les numéros(un crieur) les tire d’un sac. Quand les joueurs deviennent frustrés ou agacés parce que leurs numéros ne sortent pas, ils demandent un coup de sac, c’est à dire un ‘secouement’ du sac pour que les numéros qui sont au fond viennent à la surface. La réponse, de la part du ‘crieur’, c’est en général « Un coup de sac pour le plaignant ».

Alors Fred, pingouin etc ne serait pas en partie un simple coup de sac...

Bonne bonne

Yule

Alors Fred, pingouin etc ne serait pas en partie un simple coup de sac...

Bonne bonne

Yule

WRInaute occasionnel

Re: Mega baffe Google 07/03/2017 [update SEO]

Ces algorythmes ne sont pas analysables directement.

On est bien d'acccord.WebRankInfo a dit:Google ne gagne pas d'argent avec les éditeurs qui affichent des AdSense, mais avec les annonceurs qui paient les campagnes AdWords. J'ai vu assez de cas, dont certains hallucinants, me permettant de conclure que l'algo de Google se fiche totalement qu'un site soit affilié AdSense ou pas.patrick_lejeune a dit:Google gagne sa vie avec Adsense (y compris sur nos sites), pourquoi il déclasserait des sites utilisant adsence modérément en respectant la chartre.

Interne et externe mais j'en ai déjà discuté en MP. La technique des liens en plein contenu est mort. La technique des liens (surtout sur chaque page et encore plus externe) est morte comme en 2005. Les liens répétitifs (décriés à fait) n'est PAS morte: en 2017, difficile pour des wrinautres normaux de discuter sur mes sites puisqu'ils sont inconnus. Un truc quand même, j'utilise pas de CMS, c'est de l'HTML modifié: quasiment aucun lien n'est automatique et encore moins répétitif, ca ma pas empécher EN INTERNE de me faire déclasser par PINGUIN (et en petite partie par FRED). En en bricolant (ou plutôt en suprimant mes bricolages sur un site ...) de revenir quasiment avant Pinguin et de prendre une petite baffe avec FRED. Comme quoi, la méthode de déclassement n'est pas liée ou c'est une grosse couche supplémentaire. Parierais pour la deuxième avec les quelques bricolages que j'ai laissé.WebRankInfo a dit:tu parles des liens internes ou externes ?patrick_lejeune a dit:La technique d'Olivier en plein contenu est fausse (qui date de 2005) . C'est comme cela qu'on s'en est pris une avec Pinguin, puis peut-être sur FRED.

tu veux dire qu'il ne faut pas mettre les liens dans leur contexte, mais à la fin de la page ? c'est sûr que c'est tellement plus pratique pour l'internaute

Ces algorythmes ne sont pas analysables directement.

j'ai toujours autant de mal à comprendre ce que tu veux dire dans tes posts ;-)

"La technique des liens en plein contenu est mort" : pauvre Wikipedia, ça explique sa descente aux enfers

"La technique des liens en plein contenu est mort" : pauvre Wikipedia, ça explique sa descente aux enfers

WRInaute occasionnel

Wiki est un peu différent: d'abord, il est protégé. En deuxième, la majorité des liens entre pages sont finalement ... en fin de contenu: pas le liens internes entre pages en navigation (juste des catégories et quasiment chaque fois dans la même thématique) avec du nofollow quasiment partout (et je cache pas être contre les liens en nofollow). J'ai aussi analysé WIKI à la sortie de Pinguin :wink: . Pourtant, Wiki est aussi descendu un peu avec Pinguin.WebRankInfo a dit:j'ai toujours autant de mal à comprendre ce que tu veux dire dans tes posts ;-)

"La technique des liens en plein contenu est mort" : pauvre Wikipedia, ça explique sa descente aux enfers

Reste maintenant à voir si FRED est une extension de Pinguin ou un ensemble de modification plus larges (y compris reprenant des liens). Au niveau taux de rebond peut-être, ergonomie mobile (on sait que les modifs posts-pinguin n'ont rien changé), pas sortir des théories passe partout mais des réelles pistes.

tu vois peu de liens dans le contenu sur wikipedia ? et tu vois des liens internes nofollow "quasiment partout" ?

on ne doit sans doute pas parler du même site

et donc sinon, selon toi le meilleur emplacement pour les liens internes (et/ou externes ?) c'est après le contenu ? n'est-ce pas à l'inverse de ce que souhaite l'internaute ?

on ne doit sans doute pas parler du même site

et donc sinon, selon toi le meilleur emplacement pour les liens internes (et/ou externes ?) c'est après le contenu ? n'est-ce pas à l'inverse de ce que souhaite l'internaute ?

WRInaute occasionnel

Après le contenu et pas dans les navigations.WebRankInfo a dit:et donc sinon, selon toi le meilleur emplacement pour les liens internes (et/ou externes ?) c'est après le contenu ? n'est-ce pas à l'inverse de ce que souhaite l'internaute ?

D'un autre coté, j'ai même plus de GSM (l'entreprise a deux abonnements GSM avec connection Internet et comme je l'utilise pas ...) Un GSM "Internet", c'est visualiser le texte (avec de petites images), pas suivre des liens en plein contenu. Et Google (comme Microsoft) ne voit plus Internet par un ordinateur mais par un smartphone.

Tu sais que poster des résultats de tests prend du temps (avec les exemples, graphiques, ...), je vais essayer dans les semaines qui viennent.

➡️ Offre MyRankingMetrics ⬅️

pré-audit SEO gratuit avec RM Tech (+ avis d'expert)

coaching offert aux clients (avec Olivier Duffez ou Fabien Faceries)

Voir les détails ici

Discussions similaires

- Réponses

- 0

- Affichages

- 1K

- Réponses

- 6

- Affichages

- 4K

- Réponses

- 24

- Affichages

- 3K

- Réponses

- 8

- Affichages

- 12K

- Réponses

- 11

- Affichages

- 2K

- Réponses

- 19

- Affichages

- 4K

- Réponses

- 5

- Affichages

- 10K

- Réponses

- 6

- Affichages

- 5K

- Réponses

- 177

- Affichages

- 27K

- Réponses

- 12

- Affichages

- 9K

- Réponses

- 21

- Affichages

- 4K

- Réponses

- 25

- Affichages

- 15K

- Réponses

- 74

- Affichages

- 20K

- Réponses

- 7

- Affichages

- 14K

- Réponses

- 4

- Affichages

- 5K

- Réponses

- 41

- Affichages

- 20K

- Réponses

- 14

- Affichages

- 18K

- Réponses

- 24

- Affichages

- 16K

- Réponses

- 0

- Affichages

- 3K