Vous utilisez un navigateur non à jour ou ancien. Il ne peut pas afficher ce site ou d'autres sites correctement.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Vous devez le mettre à jour ou utiliser un navigateur alternatif.

Le filtre Google contre le spam (suroptimisation SEO) [24-04-2012]

- Auteur de la discussion WebRankInfo

- Date de début

Mon site est pénalisé mais par les unnatural links de façon manuelle et il a aussi été touché par Penguin le 24. Mais ces pénalités touchent les gros mots clés et pas les mots clés de longue traîne pour la plupart, donc j'ai été peu impacté.Writer a dit:Ne fais pas l'héro car ton site ne fait par partie des sites pénalisés aléatoirement par Google.. Pourtant tes backlinks n'ont aucune diversités (en majorité le mot "piscine") avec plein de CP ... Par la logique (s'il y en a) de Google tu dois être le premier à être pénalisé mais c'était juste un coup de chance vue que le système de Google est aléatoire et partiel..XoSt a dit:C'est un geek old school avec un pc portable pour serveur... il s'en fout d'avoir un vrai site ou non. Rock'n'Roll les mecs !

J'ai d'autres sites qui étaient sur de gros mots clés et qui ont totalement disparus.

WRInaute impliqué

Je suis tombé sur cet article et je trouve l'analyse intéressante:

http://www.micrositemasters.com/blog/penguin-analysis-seo-isnt-dead-bu ... -to-do-so/

Pour résumer les 2 facteurs qu'ils pensent être importants sont le pourcentage de liens ayant le même anchor text (au dela de 60%), et la trop faible proportion de liens venant de sites de la même thématique.

http://www.micrositemasters.com/blog/penguin-analysis-seo-isnt-dead-bu ... -to-do-so/

Pour résumer les 2 facteurs qu'ils pensent être importants sont le pourcentage de liens ayant le même anchor text (au dela de 60%), et la trop faible proportion de liens venant de sites de la même thématique.

Bonjour,

Je suis un vieil homme que n'a jamais trop bien compris comment se rendre visible sur le Web

Mon site a été touché par Penguin comme beaucoup mais je vois que ce sont les pages produits qui

remontent le plus vite

Je pense que j'avais et j'ai toujours, un trop grand nombre de mots clés qui se répètent et mes balises

title sont ainsi nomduproduit - 1 mots clés ( environ 5 variantes )

J'ai fait un peu de ménage, cela peut être la raison de la remontée de mes pages produits ( les plus vendus )

Je pense que nous n'avons pas encore suffisamment de renseignements sur ce nouvel algo complémentaire et j'agis

doucement et avec une extrême prudence

Ceci étant dit, je vais suivre ce sujet important avec attention en évitant de trop casser de pipes, j'en suis

à la 8 ème, d'ailleurs je vais envoyer la facture à Google

Je suis un vieil homme que n'a jamais trop bien compris comment se rendre visible sur le Web

Mon site a été touché par Penguin comme beaucoup mais je vois que ce sont les pages produits qui

remontent le plus vite

Je pense que j'avais et j'ai toujours, un trop grand nombre de mots clés qui se répètent et mes balises

title sont ainsi nomduproduit - 1 mots clés ( environ 5 variantes )

J'ai fait un peu de ménage, cela peut être la raison de la remontée de mes pages produits ( les plus vendus )

Je pense que nous n'avons pas encore suffisamment de renseignements sur ce nouvel algo complémentaire et j'agis

doucement et avec une extrême prudence

Ceci étant dit, je vais suivre ce sujet important avec attention en évitant de trop casser de pipes, j'en suis

à la 8 ème, d'ailleurs je vais envoyer la facture à Google

WRInaute impliqué

Moi j'ai finalement pas été vraiment touché ...

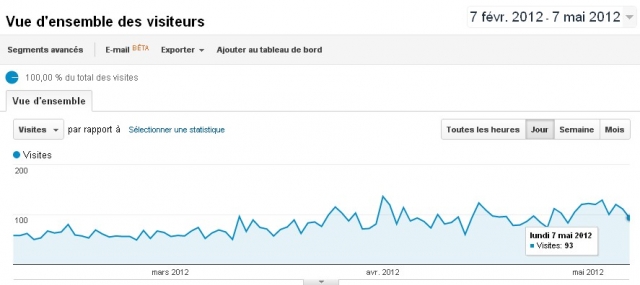

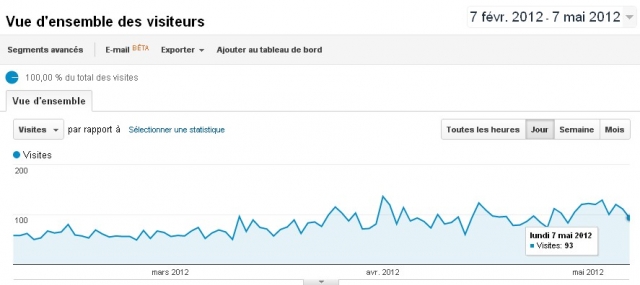

Le site sur les tortues (croissance constante) :

Le site sur les serpents (très grosse croissance) :

Le site sur les lézards (croissance constante) :

Et pourtant malgré un site dont les performances sont vraiment à désiré ... je suis entrain de trouver le moyen d'optimiser le thème wordpress + le .htaccess

Le site sur les tortues (croissance constante) :

Le site sur les serpents (très grosse croissance) :

Le site sur les lézards (croissance constante) :

Et pourtant malgré un site dont les performances sont vraiment à désiré ... je suis entrain de trouver le moyen d'optimiser le thème wordpress + le .htaccess

@fredfan , tu à l’embarras du choix du pourquoi la sanction va en s'amplifiant, entre : PANDA 3.5; WEBSPAM: PANDA 3.6, plus ne pas avoir fait les bonnes modification demander par google.

certains pourrai ne même pas savoir sur quel filtre dancer, c'est la nouvelle nouvelle google DANCE en fait.

certains pourrai ne même pas savoir sur quel filtre dancer, c'est la nouvelle nouvelle google DANCE en fait.

WRInaute discret

Après plusieurs jours de recul et analyses concernant deux de mes sites touchés par Penguin le 24/04 (l'un s'est pris -50% et l'autre environ -20%), voici mes conclusions :

- l'anchor text semble effectivement avoir son importance : sur mon site de jeux gratuits : seules les pages pour lesquelles j'avais fait un échange de lien manuel sont tombées. Un lien suffit, pourtant ces liens étaient sur d'autres sites de jeux (tous des sites différents) mais l'ancre était la même que le titre de mes pages jeux.

CEPENDANT :

- sur mon site touché à 50% je constate que des pages n'ayant aucun lien externe tombent alors que le contenu est pertinent (introuvable ailleurs, garanti!) - je pense que sur ce site la chute de la page d'accueil a entraîné toutes les pages internes qui ont un lien sur cette page d'accueil.

- ma page d'accueil a été sévèrement touchée mais c'est parce que (je pense hein, aucune certitude) 40% des 214000 BL ont la même ancre (issus d'une topliste).

Je vais essayer de contacter tous les webmasters qui participent à cette topliste pour leur demander de modifier l'ancre et on verra bien ce qu'il se passe mais j'ai peu d'espoir.

J'ai quand même l'impression que le -50% (vraiment net sur les stats, stables depuis le 24 avril) est une sanction qui a fait baissé mon site : je veux dire par là que l'algo de google a détecté le trop grand pourcentage d'anchor text identique ciblant la page d'accueil et du coup pénalisé le site de -50%.

Vous voyez ce que je veux dire ? Pourquoi -50% pile ou presque, on dirait que la suppression (ou baisse) aléatoire de mes pages dans les résultats a été calculée par google pour faire en sorte qu'il m'envoie 2x mois de visiteurs.

C'est juste une impression.

Et vous, qu'allez-vous mettre en place pour sortir de penguin ?

Si vous avez été touché hein, car j'imagine d'ici les "Bah, rien, j'ai un site Clean et Penguin m'a fait progressé dans les SERP"

- l'anchor text semble effectivement avoir son importance : sur mon site de jeux gratuits : seules les pages pour lesquelles j'avais fait un échange de lien manuel sont tombées. Un lien suffit, pourtant ces liens étaient sur d'autres sites de jeux (tous des sites différents) mais l'ancre était la même que le titre de mes pages jeux.

CEPENDANT :

- sur mon site touché à 50% je constate que des pages n'ayant aucun lien externe tombent alors que le contenu est pertinent (introuvable ailleurs, garanti!) - je pense que sur ce site la chute de la page d'accueil a entraîné toutes les pages internes qui ont un lien sur cette page d'accueil.

- ma page d'accueil a été sévèrement touchée mais c'est parce que (je pense hein, aucune certitude) 40% des 214000 BL ont la même ancre (issus d'une topliste).

Je vais essayer de contacter tous les webmasters qui participent à cette topliste pour leur demander de modifier l'ancre et on verra bien ce qu'il se passe mais j'ai peu d'espoir.

J'ai quand même l'impression que le -50% (vraiment net sur les stats, stables depuis le 24 avril) est une sanction qui a fait baissé mon site : je veux dire par là que l'algo de google a détecté le trop grand pourcentage d'anchor text identique ciblant la page d'accueil et du coup pénalisé le site de -50%.

Vous voyez ce que je veux dire ? Pourquoi -50% pile ou presque, on dirait que la suppression (ou baisse) aléatoire de mes pages dans les résultats a été calculée par google pour faire en sorte qu'il m'envoie 2x mois de visiteurs.

C'est juste une impression.

Et vous, qu'allez-vous mettre en place pour sortir de penguin ?

Si vous avez été touché hein, car j'imagine d'ici les "Bah, rien, j'ai un site Clean et Penguin m'a fait progressé dans les SERP"

viggo a dit:J'ai quand même l'impression que le -50% (vraiment net sur les stats, stables depuis le 24 avril) est une sanction qui a fait baissé mon site : je veux dire par là que l'algo de google a détecté le trop grand pourcentage d'anchor text identique ciblant la page d'accueil et du coup pénalisé le site de -50%.

Je pense comme toi, sur 3 sites touchés la baisse est quasiment pil-poil à -50%. Ce qui me fait dire que c'est le site entier qui est touché.

Ca peut aussi être un motif d'espoir parce que cela voudrait dire que l'on peut en sortir aussi vite qu'on y est rentré... bon OK je sais c'est facile à dire... :mrgreen:

hello

J'ai voulue supprimer une de mes pages pour me débarrasser des backlinks

ma premiere idée à ete de créer une nouvelle page et d'appliquer une redirection 301 à l'ancienne, bonne idée , ben NON

Je me suis aperçu que les backlinks me suivaient toujours....j'ai donc supprimer avec les outils GWT la mauvaise page et supprimé la redirection 301.....

Mais voila dans la cache google, la redirection est toujours présente! et page rank de la nouvelle page tjoujours celui de l'ancienne, comment faire pour accélérer ça suppression de l'ancienne page du cache et que google ne tienne plus compte de la redirection ?

merci de vos réponses

J'ai voulue supprimer une de mes pages pour me débarrasser des backlinks

ma premiere idée à ete de créer une nouvelle page et d'appliquer une redirection 301 à l'ancienne, bonne idée , ben NON

Je me suis aperçu que les backlinks me suivaient toujours....j'ai donc supprimer avec les outils GWT la mauvaise page et supprimé la redirection 301.....

Mais voila dans la cache google, la redirection est toujours présente! et page rank de la nouvelle page tjoujours celui de l'ancienne, comment faire pour accélérer ça suppression de l'ancienne page du cache et que google ne tienne plus compte de la redirection ?

merci de vos réponses

WRInaute accro

Vue que tu as fait une 301 c'est un peut tard ... tu as indiqué page déplacée définitivement, bref si tu ne veux pas être suivi par tes BL (qui vont coller au cul de cette page) il faut que la nouvelle cible de la 301 disparaisse et qu'une nouvelle (sans 301) apparaisse.

Je vois pas trop comment le faire autrement peut être que d'autres auront une idée mais j'y crois pas.

Pour la petite histoire la 301 en cas de sanction c'est le syndrome du beurre et de l'argent du beurre. Espérer conserver le jus d'une page pourri sans payer le prix est a mon avis utopique.

Je vois pas trop comment le faire autrement peut être que d'autres auront une idée mais j'y crois pas.

Pour la petite histoire la 301 en cas de sanction c'est le syndrome du beurre et de l'argent du beurre. Espérer conserver le jus d'une page pourri sans payer le prix est a mon avis utopique.

oui, merci de ta réponse....mais justement je l'ai supprimée cette 301 ! mais c'est trop tard ? meme la 301 retiré google continue à la suivre ?

sinon, pour info j'ai refais d'autre url sans 301 et les pages sont bien revenue dans le classement pas aussi bien, mais presque!

sinon, pour info j'ai refais d'autre url sans 301 et les pages sont bien revenue dans le classement pas aussi bien, mais presque!

Google ne suit pas une 301 qui n'existe plus. C'est juste un problème de cache. Par contre c'est bien possible que la sanction soit collée à la nouvelle page maintenant. A la limite remets la page à son ancienne adresse et attends qu'elle soit à nouveau sanctionnée pour l'effacer.

L'ensemble de l'opération est du rafistolage de toute façon. Il ne faut pas rêver trop avec ce genre de techniques. Ca agite un chiffon rouge black hat sous les yeux de googlebot

L'ensemble de l'opération est du rafistolage de toute façon. Il ne faut pas rêver trop avec ce genre de techniques. Ca agite un chiffon rouge black hat sous les yeux de googlebot

WRInaute accro

ça semble le plus logique et a mon avis la meilleure idée pour se débarrasser de l'étiquette spam quand c'est lié au BLs.loupiot77 a dit:sinon, pour info j'ai refais d'autre url sans 301 et les pages sont bien revenue dans le classement pas aussi bien, mais presque!

@viggo : Je suis d'accord que sur le fait que quand la page d'accueil est durement touché dans les serps, elle entraine avec elles les pages internes linkées depuis cette page.

Je me demande si il ne faudrait pas supprimer le plus de liens interne de cette home temporairement pour voir l'effet.

Je me demande si il ne faudrait pas supprimer le plus de liens interne de cette home temporairement pour voir l'effet.

Déjà un site de piscine qui ne passe plus sur le mot et ses dérivés ... permet moi de douter que tu n'ai pas réellement été impacté :wink: Ton site est pas réellement créé pour le long traine (en plus) pourtant, sur un site pénalisé j'ai exactement la même chose: toutes les grosses recherches impactées et la longue traine qui augmente. Un seul de mes sites monte et lui ne cherche que la longue traine. C'est pas une piste sérieuse mais peut-être une idée.XoSt a dit:Mon site est pénalisé mais par les unnatural links de façon manuelle et il a aussi été touché par Penguin le 24. Mais ces pénalités touchent les gros mots clés et pas les mots clés de longue traîne pour la plupart, donc j'ai été peu impacté.

J'ai d'autres sites qui étaient sur de gros mots clés et qui ont totalement disparus.

En discutant par MP avec quelques uns, il semble que tous les sites qui utilisent un système de fiche (à part les sites de vente en ligne) s'en sont pris une: reste à voir pour ceux-là si c'est la technique de liens internes , de liesn externes directement vers les pages internes ou un contenu super-optimalisé (ou tous ensemble).

Petite question... pour différents sites, la courbe de descende est brusque avec Pinguin mais beaucoup plus lissé avec la dernière version de Panda. As-tu fait des modifs sur ce site entre le 26 et le 05/05? Si oui, les quelles en gros?Writer a dit:Allez Google encore un effort et tu réussi à m'injecter du Top 100 (pour un site qui été au podium et actuellement N°1 sur Bing et Yahoo)

J'ai effectué pas mal de modifications depuis le 28 avril; Diminution de la densité du mot clé sur les pages du site.. Suppression des liens footer depuis les sites partenaires, suppression des duplicate content... Bon là c'est mort je compte changer de domaine et tout refaire, surtout que des sites lancés il y a à peine 30 jours se trouvent facilement dans la première page.ybet a dit:Petite question... pour différents sites, la courbe de descende est brusque avec Pinguin mais beaucoup plus lissé avec la dernière version de Panda. As-tu fait des modifs sur ce site entre le 26 et le 05/05? Si oui, les quelles en gros?Writer a dit:Allez Google encore un effort et tu réussi à m'injecter du Top 100 (pour un site qui été au podium et actuellement N°1 sur Bing et Yahoo)

difficile de croire que Google inflige des pénalités uniquement à cause de BL toxiques car ça ouvrirait en grand les portes au négative seo. Il serait plus logique d'ailleurs d'imaginer que Google donne simplement moins de poids à ce type de BL douteux.

Je pense plutôt que les sites pénalisés accumulent un ensemble d'anomalies aux yeux de Google. Il faut donc penser Panda + Pingouin pour "nettoyer" les sites...

Personnellement j'ai un site qui a été impacté et objectivement c'est assez logique. Tous les autres n'ont pas été touchés mais j'ai quand même constaté une valse des positions dans les résultats de recherche. Il faut attendre un peu pour que tout ça se stabilise et intervenir sereinement

Je pense plutôt que les sites pénalisés accumulent un ensemble d'anomalies aux yeux de Google. Il faut donc penser Panda + Pingouin pour "nettoyer" les sites...

Personnellement j'ai un site qui a été impacté et objectivement c'est assez logique. Tous les autres n'ont pas été touchés mais j'ai quand même constaté une valse des positions dans les résultats de recherche. Il faut attendre un peu pour que tout ça se stabilise et intervenir sereinement

boboweb a dit:difficile de croire que Google inflige des pénalités uniquement à cause de BL toxiques car ça ouvrirait en grand les portes au négative seo. Il serait plus logique d'ailleurs d'imaginer que Google donne simplement moins de poids à ce type de BL douteux.

Personnellement j'ai un site qui a été impacté et objectivement c'est assez logique. Tous les autres n'ont pas été touchés mais j'ai quand même constaté une valse des positions dans les résultats de recherche. Il faut attendre un peu pour que tout ça se stabilise et intervenir sereinement

Je ne suis pas vraiment d'accord avec ce que tu dis. Mes sites impactés sont tout à fait normaux pas du tout optimisés au niveau du texte et assez anciens (entre 5 et 6 ans).

J'ai cherché dans tous les sens quel point commun ils pouvaient avoir et j'ai du me rendre à l'évidence. C'est ma "façon" de faire des backlincks qui est en cause à savoir que j'admets dans le temps avoir toujours fait des liens en optimisant les ancres et en variant assez peu me focalisant sur les mots clés qui m'intéressent (en plus c'est con parce que ça favorise pas la longue traine).

C'est clair c'est chiant pour en sortir mais bon avec une bonne dose de courage si c'est ça je pense que c'est possible.

WRInaute passionné

Vu le rythme des modifications, je ne sais pas si la sérénité sera au rdv un jour... du coup, on risque de devoir attendre longtemps. Mais, à l'avenir, il faudrait surtout éviter de baser une activité sur trop peu de requêtes, voir sur quasiment une seule pour certains.boboweb a dit:Il faut attendre un peu pour que tout ça se stabilise et intervenir sereinement

WRInaute impliqué

Je ne comprend plus grand chose avec ce :evil: :evil: de pinguin :evil: :evil:

en essayant de diagnostiquer un de mes sites ( le + gros ) je me suis aperçu que :

-Les pages ou la concurrence est rude et pour lesquelles j'avais un peu bourriné sur les mots clé sont parties dans les profondeurs du classement.

-Les pages vers lesquelles pointaient des liens trop identiques et/ou trop sculptés sont aussi super descendu.

-les pages ou je n'avais pas bourriné sur les mots et qui n'étaient pas en 1ere page n'ont pas monté dans le classement ( et des sites suroptimisés restent devant )

-les pages sans liens externe n'ont pas trop bougées

-Et certaines pages, correctement optimisées mais pas trop, avec quelques bons BL qui etaient jusqu'a la en 1ere position (voir dans le top 3) sur leur mot clé sont descendu de 2 ou 3 places ( donc comme seuls les 3 1ers sont correctement cliqués -> visites % 2)

J'ai essayé :

-de désoptimiser des pages trop optimisées --> résultat rien ( voir pire )

-de faire supprimer des BL en masse de certains sites --> résultat aucun changement

-a l'inverse de réoptimiser certaines pages qui ne l'étaient pas assez --> peau de balle ca bouge pas ( voir pire )

-de trouver quelques bons BL ni trop ni pas assez optimisés pour les pages qui n'en avaient pas ---> nada

-de ne rien faire --> ca repose mais ca ne bouge pas non plus

et comme certains l'ont déja constaté je suis pile poil a -50% au niveau des visites et a -50% au niveau des revenus adsense, a croire que google a pris sa calculette pour punir les webmaster en leur infligeant nominativement -50% :evil: :evil:

concrètement quoi faire ?

en essayant de diagnostiquer un de mes sites ( le + gros ) je me suis aperçu que :

-Les pages ou la concurrence est rude et pour lesquelles j'avais un peu bourriné sur les mots clé sont parties dans les profondeurs du classement.

-Les pages vers lesquelles pointaient des liens trop identiques et/ou trop sculptés sont aussi super descendu.

-les pages ou je n'avais pas bourriné sur les mots et qui n'étaient pas en 1ere page n'ont pas monté dans le classement ( et des sites suroptimisés restent devant )

-les pages sans liens externe n'ont pas trop bougées

-Et certaines pages, correctement optimisées mais pas trop, avec quelques bons BL qui etaient jusqu'a la en 1ere position (voir dans le top 3) sur leur mot clé sont descendu de 2 ou 3 places ( donc comme seuls les 3 1ers sont correctement cliqués -> visites % 2)

J'ai essayé :

-de désoptimiser des pages trop optimisées --> résultat rien ( voir pire )

-de faire supprimer des BL en masse de certains sites --> résultat aucun changement

-a l'inverse de réoptimiser certaines pages qui ne l'étaient pas assez --> peau de balle ca bouge pas ( voir pire )

-de trouver quelques bons BL ni trop ni pas assez optimisés pour les pages qui n'en avaient pas ---> nada

-de ne rien faire --> ca repose mais ca ne bouge pas non plus

et comme certains l'ont déja constaté je suis pile poil a -50% au niveau des visites et a -50% au niveau des revenus adsense, a croire que google a pris sa calculette pour punir les webmaster en leur infligeant nominativement -50% :evil: :evil:

concrètement quoi faire ?

Honnêtement, je suis pas sûr que faire des changements on-site change grand chose ou alors faut vraiment avoir fait de la sur-optimisation bourrin.

Vu que le problème est certainement sur les backlincks, il ne faut pas non plus s'attendre à des changement d'un coup d'un seul google visitant les sites à une certaine allure il prend en compte les changements doucement je pense.

Personnellement, j'essaie de prendre ma liste GWT et de faire changer ce que je peux comme ancres (j'ai réussi sur quelques uns) et j'essaie de créer des nouveaux liens avec des ancres très diversifiées. A mon sens, il n'y a que comme ça et de la patience que ça pourra remonter...

Vu que le problème est certainement sur les backlincks, il ne faut pas non plus s'attendre à des changement d'un coup d'un seul google visitant les sites à une certaine allure il prend en compte les changements doucement je pense.

Personnellement, j'essaie de prendre ma liste GWT et de faire changer ce que je peux comme ancres (j'ai réussi sur quelques uns) et j'essaie de créer des nouveaux liens avec des ancres très diversifiées. A mon sens, il n'y a que comme ça et de la patience que ça pourra remonter...

Peut-être mais à ce que je vois sur quelques sites, j'hésiterais fortement à supprimer les liens externes vers la page d'entrée (en footer ou en navigation), quelque soit le nombre. Je pense pas que GG s'attaque à ces liens massifs (au mieux, il en tient un petit peu compte, au pire il ne les utilise pas MAIS en les supprimant, ca ressemble à de la vente de liens.franckM a dit:Honnêtement, je suis pas sûr que faire des changements on-site change grand chose ou alors faut vraiment avoir fait de la sur-optimisation bourrin

Pour les techniques de liens externes, il y a deux grosses méthodes: les liens répétitifs de navigation et les liens intextes vers des pages internes. J'ai nettement l'impression que c'est ces derniers que GG est en train de supprimer et pas le contenu.

-http://www.materiel-informatique.be/netbios.php 16 liens internes, 22 externes de 12 sites (avec chaque fois le mot clé en plein dedans) dont 1 d'un "copain du groupe" et jamais que 9 X le mot dans le texte (si c'est pas de la sur-optimalisation :roll: ) et pas sanctionné (le reste du site y est complètement). D'accord, j'ai d'autres pages sanctionnées qui font la même technique. Pourtant, en supprimant toutes les parties navigations farfelues depuis 10 jours, pas de modifs. .... je crois que la direction à envisager, c'est les liens in-textes, internes ou externes.

@patrick: tu dis, j'ai deuxéléments sur mon site, comme je bidouille sur l'un et qu'il ne se passe rien, c'est surement l'autre. Ai-je bien compris? Si oui, c'est un sophisme, non : qu'est-ce qui empêche -du seul point de vue de la la logique- que ce soit être un troisième type d'élément ou autre facteur qui compte réellement, meêm si pas présent suer ton site?

JanoLapin a dit:@patrick: tu dis, j'ai deuxéléments sur mon site, comme je bidouille sur l'un et qu'il ne se passe rien, c'est surement l'autre. Ai-je bien compris? Si oui, c'est un sophisme, non : qu'est-ce qui empêche -du seul point de vue de la la logique- que ce soit être un troisième type d'élément ou autre facteur qui compte réellement, meêm si pas présent suer ton site?

Dans un sens oui ...

J'ai aussi un site qui est pas mal passé sur Pinguin avec une technique de liens internes plus que discutable (parle au niveau référenceur, pas Google) :wink: C'est la comparaison entre les deux + les MP et mails échangés ces 10 derniers jours. Pour le moment, je travaille pas réellement sur le site sanctionné mais bien sur les autres du groupe (même thématique, techniques de liens entre-eux strictement in-texte mais surtout vers celui sanctionné). En plus, à part 1, ce sont tous des .be (géolocalisés sur Belgique donc ) et bizarement, toutes les recherches sanctionnées sur le site sanctionné (y compris les quelques unes qui n'y sont pas réellement) donnent une MEILLEURE position sur GG.FR que sur GG.be: c'est exactement l'inverse de ce qui devrait se produire. Ca ressemble bien à des liaisons entre les sites (et j'utilise jamais de liens de navigation entre mes sites, rien que dans le contenu - suis trop vicieux :mrgreen: )

http://searchengineland.com/google-talks-penguin-update-recover-negati ... seo-120463

Quelqu'un a eut confirmation de cette info ? Je ne sais pas d'où il la sort, mais dans ce cas, cela voudrait dire que ceux qui ont effectué des modifs ne pourront voir les effets que dans quelques semaines ? J'ai du mal à y croire quand même.

Penguin is not constantly running but rather is used to tag things as spam above-and-beyond Google’s regular spam filtering on a periodic basis.

Quelqu'un a eut confirmation de cette info ? Je ne sais pas d'où il la sort, mais dans ce cas, cela voudrait dire que ceux qui ont effectué des modifs ne pourront voir les effets que dans quelques semaines ? J'ai du mal à y croire quand même.

Avec 3 mises à jours en ... 10 jours, Google doit être en train de faire la même chose que nous: regarder ce qui se passe :wink: De toute façon, personne ne sait ce qui se passe et aucun site n'est réellement remonté depuis Pinguin ... malgré un tas (trop) de corrections de tous bords genre supprimer les liens en footer pointant vers le site (qui ont juste augmenté la chute de quelques uns) . A force de regarder Pinguin, une grosse part des webmasters sont en train de casser ce qui fonctionne en oubliant les bases du référencement: la patience.

La seule réelle chose à faire pour le moment c'est de voir quoi est touché et quoi ne l'est pas (ou même a profité de Pinguin) pour se donner une idée et éventuellement faire quelques petites corrections.

La seule réelle chose à faire pour le moment c'est de voir quoi est touché et quoi ne l'est pas (ou même a profité de Pinguin) pour se donner une idée et éventuellement faire quelques petites corrections.

Pour ma part j'ai licencié 3 employés déjà mais je pense que ça ne sera pas suffisant pour combler le manque du à Penguin.

Penguin semble favoriser les sites de spam, j'entends par là les doorways sites, ceux avec du contenu à la chaîne ciblé sur des mots clés précis, surtout ceux de longue traine. On vois pas mal de WM sortir ce type de sites, ils font 1000 articles sur 1000 mots clés ciblés sur une niche et un peu réf et hop.

Je réfléchi sérieusement à lancer une petite horde de ce type de sites, faire de la qualité ça ne paye pas avec Google, la qualité ça veut dire produire peu de contenu sur peu de mots clés, faire des sites de type doorway ça permet de se placer absolument partout, sur toutes les requêtes de la niche cible tout en produisant un contenu de type "blabla" très facile à écrire.

Vaut mieux être première page sur 1000 mots clés qui font 100 recherches par mois que d'être nulle part avec 50 articles de qualité qui ciblent 50 mots clés ultra concurrentiels. J'ai déjà fait le test c'est pour ça que j'en parle.

Même niche, j'ai fait deux sites, un site m'a coûté 15 000 euros de contenu ultra top qualité, j'ai ciblé peu de mots clés mais j'ai le meilleur contenu de la niche. A côté de ça j'ai fait 6 mois plus tard un site de merde avec autant d'articles mais ça m'a coûté que 1 000 euros parce que c'est surtout du blabla et j'ai ciblé que des mots clés sans me préoccuper du contenu, le deuxième site rapporte déjà 1500 euros par mois, le premier site ne rapporte pas grand chose.

Penguin semble favoriser les sites de spam, j'entends par là les doorways sites, ceux avec du contenu à la chaîne ciblé sur des mots clés précis, surtout ceux de longue traine. On vois pas mal de WM sortir ce type de sites, ils font 1000 articles sur 1000 mots clés ciblés sur une niche et un peu réf et hop.

Je réfléchi sérieusement à lancer une petite horde de ce type de sites, faire de la qualité ça ne paye pas avec Google, la qualité ça veut dire produire peu de contenu sur peu de mots clés, faire des sites de type doorway ça permet de se placer absolument partout, sur toutes les requêtes de la niche cible tout en produisant un contenu de type "blabla" très facile à écrire.

Vaut mieux être première page sur 1000 mots clés qui font 100 recherches par mois que d'être nulle part avec 50 articles de qualité qui ciblent 50 mots clés ultra concurrentiels. J'ai déjà fait le test c'est pour ça que j'en parle.

Même niche, j'ai fait deux sites, un site m'a coûté 15 000 euros de contenu ultra top qualité, j'ai ciblé peu de mots clés mais j'ai le meilleur contenu de la niche. A côté de ça j'ai fait 6 mois plus tard un site de merde avec autant d'articles mais ça m'a coûté que 1 000 euros parce que c'est surtout du blabla et j'ai ciblé que des mots clés sans me préoccuper du contenu, le deuxième site rapporte déjà 1500 euros par mois, le premier site ne rapporte pas grand chose.

WRInaute passionné

exactement le même constat sur 2 sites touchés, du -50% pile-poil, j'ai lu pas mal d'exemples de sites avec trafic divisé par 2, c'est une "norme" ou il y a beaucoup de contre-exemples? (genre -20 ou-90%)et comme certains l'ont déja constaté je suis pile poil a -50% au niveau des visites et a -50% au niveau des revenus adsense, a croire que google a pris sa calculette pour punir les webmaster en leur infligeant nominativement -50%

WRInaute accro

il semble (je dis bien "il semble") que GG soit en mesure de fixer un "quota par site". Je l'ai constaté tant sur le trafic que sur les revenus que procurent Adsense, en réalisant des manipulations qui avait un impact direct sur le trafic ou le taux de transformation des annonces.

Ce que je constate toujours c'est une brusque envolée du trafic ou des transformation suite a la manip qui est invariablement suivie d'un retour à la normale ou normale plus un petit plus qui n'est jamais en rapport avec les chiffres obtenus dans la semaine qui suit les changements.

ça induit une forme de "note" que GG attribuerait tant a un site qu'a un compte et qui conditionnerait en live l'ensemble des services. On peut donc comprendre que techniquement certains sites ne soit pas impacté car il suffirait qu'il ai une popularité tel que les impact qualité ne suffirait pas a les déclasser. En revanche tous les sites border line qui ne serait pas associés a un "super compte" en prendrait plein la tronche pour les même causes.

Ce que je constate toujours c'est une brusque envolée du trafic ou des transformation suite a la manip qui est invariablement suivie d'un retour à la normale ou normale plus un petit plus qui n'est jamais en rapport avec les chiffres obtenus dans la semaine qui suit les changements.

ça induit une forme de "note" que GG attribuerait tant a un site qu'a un compte et qui conditionnerait en live l'ensemble des services. On peut donc comprendre que techniquement certains sites ne soit pas impacté car il suffirait qu'il ai une popularité tel que les impact qualité ne suffirait pas a les déclasser. En revanche tous les sites border line qui ne serait pas associés a un "super compte" en prendrait plein la tronche pour les même causes.

fran6 a dit:]et comme certains l'ont déja constaté je suis pile poil a -50% au niveau des visites et a -50% au niveau des revenus adsense, a croire que google a pris sa calculette pour punir les webmaster en leur infligeant nominativement -50%

Pas raconter n'importe qui non plus. Google est UNE GROSSE MACHINE à calculer l'argent (le changement de recherche en bas des pages de recherches en est une preuve) mais c'est aussi un outils mathématique (il n'y a rien de manuel chez GG: faudrait une véritable armée de chinois pour le faire manuellement). Calculer des baisses de 50 % de vkisiteurs et de adsenses est impossible statistiquement (je descend plus sur un site et je suis pas le seul ... mais d'autres sites bougent pas ou montent). Les descendes sur Adsense sont probablement aussi parce que les sites "pourris" se sont rendus compte qu'ils montaient ... pouquoi payer pour des visiteurs alors qu'on les a gratos via les recherches

GG ne "punit pas" des webmasters, le changement de classements fait baisser des sites et d'autres montent (OK, les moins corrects pour l'instant). C'est aussi pourquoi GG va corriger ... probablement pas en notre faveur sur les sites qui proposent adsense mais surtout pour remettre ses annonceurs (ses clients) dans des limites raisonnables.

Faudrait arrêter de croire que GG est un petit webmaster (genre gestionnaire d'un annuaire), c'est une équipe d'ingénieur et de mathématiciens sur-diplomés (dans le sens moyennes de 8/10, pas tricherie comme le PDG de Yahoo).

La grosse connerie qu'il vient de déclarer:Rogers a dit:http://searchengineland.com/google-talks-penguin-update-recover-negative-seo-120463

Penguin is not constantly running but rather is used to tag things as spam above-and-beyond Google’s regular spam filtering on a periodic basis.

Quelqu'un a eut confirmation de cette info ? Je ne sais pas d'où il la sort, mais dans ce cas, cela voudrait dire que ceux qui ont effectué des modifs ne pourront voir les effets que dans quelques semaines ? J'ai du mal à y croire quand même.

... J'espère qu'il rigole.If you've cleaned and still don't recover, ultimately, you might need to start all over with a fresh site

WRInaute passionné

ybet attention avec tes quotes, ne me fais pas dire ce que je n'ai pas dit :wink:

si c'est super simple : tu n'affiches le site sur ses requêtes qu'une fois sur 2, ceci dit ce n'est pas le cas ici vu que les baisses de visite sont dûes à des baisses de position donc tu as sûrement raison, l'hypothèse d'une pénalité genre de x % est peu probable mais elle le reste un peu quand mêmeCalculer des baisses de 50 % de vkisiteurs et de adsenses est impossible statistiquement

c'est un "filtre Google contre le spam (suroptimisation SEO)" tu n'appelles pas ça une "punition" toi?GG ne "punit pas" des webmasters

Penguin a touché WPMU.org aussi.. Grand coup de gueule http://antonstetner.visibli.com/share/4ADG10

Mais il y a bien une punition de type quota. Avant-hier entre 17h22 et 17h54 --> 0 visiteur (on est censé être dans les heures pleines). Dans le même soir, vers 22h, 22h30, je me suis retrouvé avec un trafic quasi équivalent à celui des heures pleines. Il ne faut pas me faire croire que les mecs étaient à la pêche à 17h et sont rentrés à 22h. Il y a clairement une "limite", une sorte de robinets qu'ils ouvrent et ferment.

WRInaute accro

Bah déjà tes positions sur les datascenters ne sont pas les mêmes toute la journée (du moins pas forcment), je les voie varier assez souvent. Et ensuite pour induire X% de baisse de trafic avec la plus grosse base de données sur le trafic du monde il suffit de reculer les site de N positions et c'est réglé.fredfan a dit:Je ne comprends pas comment vous imaginez une punition au trafic si les positions sont les mêmes toute la journée sur tous les datacenters

Techniquement c'est vraiment pas super compliqué.

Il n'est pas difficile d'imaginer que les classement dans les SERP soit évalué non pas vis a vis de la pertinence sur une requête, mais sur celle ci plus un coef pondérateur de trafic décidé ou calculé (pas a la main c'est évident).

D'ailleurs la position changeante de google Adresse ou google Actu dans les SERP montre clairement une action significative de GG sur les SERP pour avoir son propre trafic interne (je les voie rarement a la même hauteur).

Ensuite comment feriez vous pour pénaliser un site ?

Concrètement si je devais blacklister http://www.example.com je m'amuserait pas a faire baisser sa pertinence sur ses requêtes, je me contenterait de pondérer l'affichage par un coef régulateur.

On a eu des exemples évident quand GG Actu était en procès en belgique avec un gros quotidien de presse, bizarrement le quotidien a perdu son trafic organic. GG n'a pas fait disapraitre le site de ses crawls et classement il l'a pondéré.

Quand vous vous mangez une pénalité genre linking bourrin trop rapide ... votre site site est toujours là mais 200 pages plus loin, bref coef de pondération encore sur la durée (allez pas croire que GG va pondérer sur la pertinence pour vous dé-pondérer 3 mois plus tard (il en finirait jamais))

Souvenez vous de GG avant les grosses réformes on avait des SERP propres et pertinentes CAD qu'il triait effectivement bien sur des notions de contenu (c'est d'ailleurs là qu'est apparu le keywordstuffing). par la suite on a vue GG se battre contre ces optimisation de contenu et là c'était moins évident pour lui (normal je met au défi n'importe quel Bot de savoir si un contenu est du bon Français, anglais ou autre de façon algorithmique c'est impossible).

De nos jours, on a pas une nette impression que c'est résolu car on trouve encore des bouses trafiqué en haut MAIS GG est capable de plomber une page ou un site a volonté. C'est donc pas son algo lié a la pertinence textuelle qui est affecté mais une surcouche "pénalité" qui altère le résultat naturel.

C'est altération peut être Automatique ou manuelle voir semi-manuelle.

* Automatique avec un truc genre pinguin ou panda qui prend X critères et passe tous les sites a la moulinette pour ensuite réévaluer les facteurs de pondération.

* Manuelle car modifier un coef en urgence peut être motivé par un évènement (genre l'exemple procès que je donne plus haut)

* Semi-manuelle car avec les formulaires de "balançage" qu'a google on peut très bien avoir une équipe qualité qui prend en compte le retour humain (formulaire), plus les données maison pour décider d'une action manuelle ou pas.

Alors quand je parle de coef "pondérateur" c'est pas forcement un coef unique, on peut imaginer un groupe de coef qui forme le coef final (tête du client, vitesse du vent, degré d'humidité, etc ...), Mais il semble pertinent de penser que ce genre de mécanisme existe sinon il serait ingérable de rester "clean sur le search avec un algo" tout en intégrant des facteurs politique, économiques et policiers.

Rogers a dit:Mais il y a bien une punition de type quota. Avant-hier entre 17h22 et 17h54 --> 0 visiteur (on est censé être dans les heures pleines). Dans le même soir, vers 22h, 22h30, je me suis retrouvé avec un trafic quasi équivalent à celui des heures pleines. Il ne faut pas me faire croire que les mecs étaient à la pêche à 17h et sont rentrés à 22h. Il y a clairement une "limite", une sorte de robinets qu'ils ouvrent et ferment.

surprenant, peut-être vérifier que ce ne soit pas un concours de circonstances... je me souviens à la sortie de panda d'un site client qui a dégringolé dans Google. Après plusieurs jours de stress on sait rendu compte que c'était finalement un simple problème technique avec l'hébergement du site !!!

franckM a dit:Je ne suis pas vraiment d'accord avec ce que tu dis. Mes sites impactés sont tout à fait normaux pas du tout optimisés au niveau du texte et assez anciens (entre 5 et 6 ans).

J'ai cherché dans tous les sens quel point commun ils pouvaient avoir et j'ai du me rendre à l'évidence. C'est ma "façon" de faire des backlincks qui est en cause à savoir que j'admets dans le temps avoir toujours fait des liens en optimisant les ancres et en variant assez peu me focalisant sur les mots clés qui m'intéressent (en plus c'est con parce que ça favorise pas la longue traine).

C'est clair c'est chiant pour en sortir mais bon avec une bonne dose de courage si c'est ça je pense que c'est possible.

il y aurait donc des pénalités infligées rétroactivement en fonction de la date des backlinks !!! Je m'explique :

backlinks douteux qui ont par exemple 5 ans = Google sanctionne

backlinks douteux récents = on touche à rien car possibilité de négative SEO (au pire google diminue le poids des BL d'où la valse actuelle des positions dans les résultats de recherche)

Techniquement rien n'empêche Google de mettre ça en place et ça expliquerait pourquoi de nombreux sites anciens sont touchés...

Moi je pense que Google gère tellement de données qu'il ne peut pas non plus faire des calculs de malades sur chaque site et chaque page et chaque lien de chaque page.

A mon avis Google trust certains NDD plus que d'autres et si ces NDD postent de nouvelles pages elles prennent directement de bonnes positions, peu importe s'ils ont écrit de la merde ou pas.

Le référencement de nos jours ce n'est pas du On Page ou du backlinks, il faut faire truster son NDD, plus ton score augmente plus tu as de chances de te classer sur de nombreuses requêtes.

Partant de ce principe si un site a un petit trust Google peut réguler le trafic envoyé vers ce site, du genre "trust <= X { on limite à X cliques }else{ trust >= X { pas de limite de cliques et le site peut recevoir tout le trafic qu'il peut depuis sa position }

A mon avis Google trust certains NDD plus que d'autres et si ces NDD postent de nouvelles pages elles prennent directement de bonnes positions, peu importe s'ils ont écrit de la merde ou pas.

Le référencement de nos jours ce n'est pas du On Page ou du backlinks, il faut faire truster son NDD, plus ton score augmente plus tu as de chances de te classer sur de nombreuses requêtes.

Partant de ce principe si un site a un petit trust Google peut réguler le trafic envoyé vers ce site, du genre "trust <= X { on limite à X cliques }else{ trust >= X { pas de limite de cliques et le site peut recevoir tout le trafic qu'il peut depuis sa position }

Je pense que tu te trompes.Moi je pense que Google gère tellement de données qu'il ne peut pas non plus faire des calculs de malades sur chaque site et chaque page et chaque lien de chaque page.

Voilà telle que je vois la chose:

Google a une serie d'algorithme permettant d'attribuer une note à un site sur un certain critère, et chaque note à un coéficient comme au bac quoi

Exemple:

- on-page:

-- title:

--- coef: 4

-- meta:

--- coef: 1

- off-page:

-- trust-rank:

---coef: 4

-- page-rank

---coef: 2

Après des algo de densité de mot, du tf idf pour le rank, et bien sûr les résultats personnalisés

Donc toutes ses notes seraient calculées à une certaine fréquence suivant la thématique du site (1-2 min pour de l'actu, ...).

Enfin c'est ma vision des choses (peut être simpliste )

J'ai déjà fait le test sur un très bon site, j'ai mis des pages de merde en ligne et elles étaient super bien classées. Du vrai blabla qui ne veut rien dire, donc c'est forcément le trust du domaine qui impacte ton référencement total, ensuite ils ont des signaux plus ou moins bidons mais au final si ton site est pas trusté tu ne vas pas loin.

WRInaute accro

A oui ? et le PR (dont on se contrefiche au passage) c'est quoi sinon un calcul par page ? Le fait qu'il soit mis a jour une fois toute les lunes peut justement indiquer que le temps machine pour l'évaluer est important.XoSt a dit:Moi je pense que Google gère tellement de données qu'il ne peut pas non plus faire des calculs de malades sur chaque site et chaque page et chaque lien de chaque page.

Et partant de là tu ne te demande pas pourquoi Panda est mis en branle par période au lieu d'être un "filtre live".

Les sites avec vidéo et autres blogs sont déjà dans le colimateur de Google (il y a trois ans, tu prermettais de mettre des commentaires sur une page et tu montait (pas dans le top mais tu montais) Maintenant, pour les target blank, GG s'en fout par contre, les "nouveaux navigateurs supposés plus sécurisés" bloquent ces accés ... appuyez sur CTRL en cliqunat sur ... Pas sanctionnés par Google mais bien par les visiteursmalfesia a dit:Que pensez vous des sites de type "vidéos", "blog" ou autre qui ouvrent les pages en blanck (nouvelle pages) à l’intérieur de celui ci?

Google pénalise t-il cela ?

> writer: le post est hors sujet ... et le probléme des blogs (gratuits ou juste installés) c'est qu'ils reprennent sur la page d'entrée le contenu des derniers posts (repris dans chaque post) -> duplicate.

Pour le target blank, GG voit pas de différence, juste que les navigateurs actuels sont contraignats vis à vis des simples liesn "target="blank".

Pour le target blank, GG voit pas de différence, juste que les navigateurs actuels sont contraignats vis à vis des simples liesn "target="blank".

Mais la grande question pour moi c'est vraiment que faire ?

Mon petit site s'est fait exploser, atomiser, éparpiller aux quatre coins de Paris, par Pingou... ok mais que faire?

Oh dieu Google j'ai fauté, oui j'ai commis le pêché de faire des diggs, des cp et des annuaires (whouahou le black hat, une vraie racaille que je suis).

Ces foutus liens ils sont là maintenant et on ne peut pas les supprimer.

-----

Bon maintenant plus sérieusement on ne parle pas beaucoup ici des liens d'affiliation, en ce qui me concerne j'en ai pas mal sur mon site, Pingou n'en aurait-il pas aussi un peu contre ce genre de liens ?

Je me demande vraiment si ce ne serait pas plutôt les liens d'affil que la centaine de liens venant de digg et de cp qui sont la cause de mon désarroi ?

Mon petit site s'est fait exploser, atomiser, éparpiller aux quatre coins de Paris, par Pingou... ok mais que faire?

Oh dieu Google j'ai fauté, oui j'ai commis le pêché de faire des diggs, des cp et des annuaires (whouahou le black hat, une vraie racaille que je suis).

Ces foutus liens ils sont là maintenant et on ne peut pas les supprimer.

-----

Bon maintenant plus sérieusement on ne parle pas beaucoup ici des liens d'affiliation, en ce qui me concerne j'en ai pas mal sur mon site, Pingou n'en aurait-il pas aussi un peu contre ce genre de liens ?

Je me demande vraiment si ce ne serait pas plutôt les liens d'affil que la centaine de liens venant de digg et de cp qui sont la cause de mon désarroi ?

Bonjour,

Je suis tombé sur ces pages :

http://www.pubcontact.com/sortir-penguin-google

http://www.pubcontact.com/sortir-penalite-penguin

J'ai fais quelques modifs sur un site secondaire, on verra bien...

Je suis tombé sur ces pages :

http://www.pubcontact.com/sortir-penguin-google

http://www.pubcontact.com/sortir-penalite-penguin

J'ai fais quelques modifs sur un site secondaire, on verra bien...

bizarre ces résultats, Penguin est-il en temps réel ou pas ? faudrait savoir. Matt Cutts semble bien avoir indiqué récemment qu'il fallait attendre une prochaine mise à jour de Penguin.

Bonjour,

Je suis l'auteur de deux posts mentionnés plus haut.

Concernant le fait que Penguin soit en temps réel ou pas, l'article sur searchengineland indique qu'il faut attendre la prochaine mise à jour mais je ne vois pas où Matt Cutts a dit ça. Quoi qu'il en soit, je me base surtout sur mes positions pour dire que j'en suis sorti, le trafic n'étant pas vraiment représentatif. Sur ce point les résultats sont là, tout est remonté.

Je suis l'auteur de deux posts mentionnés plus haut.

Concernant le fait que Penguin soit en temps réel ou pas, l'article sur searchengineland indique qu'il faut attendre la prochaine mise à jour mais je ne vois pas où Matt Cutts a dit ça. Quoi qu'il en soit, je me base surtout sur mes positions pour dire que j'en suis sorti, le trafic n'étant pas vraiment représentatif. Sur ce point les résultats sont là, tout est remonté.

WebRankInfo a dit:bizarre ces résultats, Penguin est-il en temps réel ou pas ? faudrait savoir. Matt Cutts semble bien avoir indiqué récemment qu'il fallait attendre une prochaine mise à jour de Penguin.

Je pense effectivement pas que Pinguin soit en temps réels, et Matt Cutts l'a effectivement dit. En faisant des petites corrections de liens entre sites plus ou moins liés, il y a effectivement modifs de positionnement (mais surement pas des grosses remontées). Seul problème, c'est que le même type de modif fait monter une fois une page et en fait descendre une autre. De toute façon, 200 ou 180 change strictement rien en terme de visiteurs.

Je ne sais pas ce que tu entends par grosses remontées mais je ne pense pas que reprendre quinze places que tu as perdues depuis la première page des SERPs soit négligeable.

Pour les pages qui montent et d'autres qui descendent, je ne suis pas toutes les pages de mon blog mais dans la dizaine que j'ai travaillées et suivies, elles ont toutes remontées.

Pour les pages qui montent et d'autres qui descendent, je ne suis pas toutes les pages de mon blog mais dans la dizaine que j'ai travaillées et suivies, elles ont toutes remontées.

elles avaient baissé quand exactement ?

WRInaute discret

Et alors, qu'as tu fais pour arriver à contrer Penguin ? C'est ce qui nous intéresse.

Perso je suis en plein changements d'ancres de BL parce que je pense que le problème (chez moi) vient clairement d'ancres trop similaires. J'ai été trop bourrin alors maintenant faut assumé, avec ces qq jours de recul je me dis que ce Penguin part d'un bon sentiment. Mon site de 6 ans a été sanctionné à cause d'un profil backlink suspicieux (enfin j'imagine car je n'ai jamais cherché à varier les ancres, grosse erreur, mais bon, ce qui est fait est fait).

La question que je me pose maintenant (car j'ai changé qq ancres chez qq partenaires mais rien ne semble bouger, bon c'est encore récent (qq jours) donc attendons que google passe partout), donc la question que je me pose c'est :

Est-ce possible de sortir de Penguin à terme ? (après avoir effectué les changements nécessaires j'entends)

Car Google ayant assimilé notre site à un spam le 24 avril 2012, pourquoi nous dépénaliserai-t-il 1 mois plus tard ?

Est-ce que ça se passe de la même manière que pour Panda (je n'ai jamais été touché par cette bestiole) ?

Perso je suis en plein changements d'ancres de BL parce que je pense que le problème (chez moi) vient clairement d'ancres trop similaires. J'ai été trop bourrin alors maintenant faut assumé, avec ces qq jours de recul je me dis que ce Penguin part d'un bon sentiment. Mon site de 6 ans a été sanctionné à cause d'un profil backlink suspicieux (enfin j'imagine car je n'ai jamais cherché à varier les ancres, grosse erreur, mais bon, ce qui est fait est fait).

La question que je me pose maintenant (car j'ai changé qq ancres chez qq partenaires mais rien ne semble bouger, bon c'est encore récent (qq jours) donc attendons que google passe partout), donc la question que je me pose c'est :

Est-ce possible de sortir de Penguin à terme ? (après avoir effectué les changements nécessaires j'entends)

Car Google ayant assimilé notre site à un spam le 24 avril 2012, pourquoi nous dépénaliserai-t-il 1 mois plus tard ?

Est-ce que ça se passe de la même manière que pour Panda (je n'ai jamais été touché par cette bestiole) ?

Dans la nuit du 24 au 25WebRankInfo a dit:elles avaient baissé quand exactement ?

Tu trouves pas plus intelligent de faire des nouveaux bls avec de nouvelles ancres?viggo a dit:j'ai changé qq ancres chez qq partenaires mais rien ne semble bouger

Dans le genre suspect t'es le roi, ça risque pas de bouger en changeant les anciens liens.

WRInaute discret

Pas con... en même temps un fois que t'es sanctionné je pense pas que ça puisse être un mal de changer (un peu) les anciennes ancres. Mais bon trouver de nouveaux partenariats avec des ancres variés en aussi grande quantité ça va me prendre 6 nouvelles années lol. enfin lol jaune ^^

stephdim a dit:je confirme que ça bouge, tout du moins pour les désoptimisations on-site.

une partie du filtre doit être en temps réel.

j'en ai fais de la désoptimisation onsite, et ça ne bouge pas, ou quelques places dans le fond des serps, ce qui n'est pas significatif pour dire que c'est du temps réel. Dans une source que j'ai lu, on parle de 6 semaines pour la mise à jour du manchot...

_Soul a dit:Dans le genre suspect t'es le roi, ça risque pas de bouger en changeant les anciens liens.

Je vois pas où est le problème de changer des anciennes ancres... Google dit que c'est pénalisable d'avoir des ancres trop optimisées... ben tu corriges.

En + bien sûr de rajouter de nouveaux liens.

Sinon si le critère principal est off-site et lié aux backlincks et à leurs ancres (ce qui reste finalement à prouver...) je vois pas bien comment la mise à jour pourrait se faire en temps réel.

@philyd

XP PERSO je parierais plus en fonction de la page, de sont importance pour le site, plus une page est importante, en terme de nombre de visiteur et/ou de taux de changement(page actualiser fréquemment), si elle est corriger rapidement par rapport à WEBSPAM, exemple si c'est la page principale du site comme la racine / du site, ça peut être très rapide 3 à 4 jours au plus, du moins c'est se que j'ai pus constater, sur un site qui passer de la 461ième place à la 80ième, puis qui remonte doucement vers la 74ième places sur 5 jours.

je pense que les dé-sur-optimisations on-sites, ont plus de poids, que les modifications d'anciennes ancres hors site, si non se serai trop facile de pénalisé un concurrent, au mieux les anciens BLs sur-optimiser ne sont pas ou plus pris en compte, et n'ont d'autant pas de poids qu'ils ne drainent pas de visiteurs réel ayant un intérêt à venir sur le site via ses mêmes BLs hyper sur-optimiser.

en plus pour les BLs, parfois difficile, de contacter le webmaster du site qui est à l’abandon depuis plus de X années pour qu'il daignent changer une ancre, car parfois on à pas ou plus la main sur certaines BLs hors annuaires.

XP PERSO je parierais plus en fonction de la page, de sont importance pour le site, plus une page est importante, en terme de nombre de visiteur et/ou de taux de changement(page actualiser fréquemment), si elle est corriger rapidement par rapport à WEBSPAM, exemple si c'est la page principale du site comme la racine / du site, ça peut être très rapide 3 à 4 jours au plus, du moins c'est se que j'ai pus constater, sur un site qui passer de la 461ième place à la 80ième, puis qui remonte doucement vers la 74ième places sur 5 jours.

je pense que les dé-sur-optimisations on-sites, ont plus de poids, que les modifications d'anciennes ancres hors site, si non se serai trop facile de pénalisé un concurrent, au mieux les anciens BLs sur-optimiser ne sont pas ou plus pris en compte, et n'ont d'autant pas de poids qu'ils ne drainent pas de visiteurs réel ayant un intérêt à venir sur le site via ses mêmes BLs hyper sur-optimiser.

en plus pour les BLs, parfois difficile, de contacter le webmaster du site qui est à l’abandon depuis plus de X années pour qu'il daignent changer une ancre, car parfois on à pas ou plus la main sur certaines BLs hors annuaires.

mipc a dit:se que j'ai pus constater, sur un site qui passer de la 461ième place à la 80ième, puis qui remonte doucement vers la 74ième places sur 5 jours.

C'est ce que j'ai dis, ce n'est pas significatif ! Que tu sois 400ième ou 80ième, je ne vois pas la différence en terme de traffic. De plus, ce que je constate, c'est que tu peux plonger et remonter et vice et versa tous les jours. Le manchot lui, mettra à jour dans 6 semaines pour les BL lors de sa mise à jour.

http://www.journaldunet.com/solutions/seo-referencement/penguin-update-et-penalite-google.shtml

WRInaute discret

C'est là que c'est "compliqué" : faut avoir des ancres variés majoritairement sur des sites de même thématique, bref, faut que ça ait l'air naturel quoi, comme si tes petites mi-mines étaient innocentes de toute demande d'échange de lien.

Et ensuite, rien ne garanti que ça suffise pour en sortir. "Bref, fallait pas essayer de faire connaitre mon site" ^^ (lol, hein)

Et ensuite, rien ne garanti que ça suffise pour en sortir. "Bref, fallait pas essayer de faire connaitre mon site" ^^ (lol, hein)

Impossible car n'importe qui peut faire un lien vers un site qui plait, ce qui fait que l'on se retrouve avec des centaines de liens hors thématique sans compter les sites à la con qui vous créez des centaines de liens sans rien demander...bref, c'est quasi incontrôlable.faut avoir des ancres variés majoritairement sur des sites de même thématique

Par ailleurs, je ne suis pas certains que d'avoir des ancres variés ou des liens hors thématique joue un grand rôle dans ce filtre. L'un de mes concurrents qui est une plateformes de créations de sites en ligne est passé en première place depuis l'update et pourtant la majorité des sous domaines (donc des sites créés) portent la même ancre et pointent vers la même url et son totalement hors thématique (environ 63 000 000 liens)...pour le côté "naturel", c'est un peut raté..non?

tryan a dit:Hello,

Question simple : faut il faire la chasse aux liens externes et sur quelle(s) critères(s) pour sortir de cette pénalité ?

Merci

pas aux liens en eux même, mais aux ancres de liens sur-optimiser et pas toujours les mêmes ancres, il faut varier les ancres et les liens.

mais je pense qu'il vaut mieux des nouveau BLs avec aucunes ancres, et des BLS sur pages profondes.

pour l'instant chez moi se qui fait une remonter importantes, viré les ancres sur optimiser des liens de sorties on-site.

J'ai du mal à comprendre alors excuse moi d'avance. Tu dis qu'il faut virer les ancres sur optimiser des liens qui sortent de mon site et si c'est bien ça, ça signifie alors qu'il faut que je modifie les liens de mes partenaires car les seul liens sortant optimisés sont ceux la (et quand je dis optimiser c'est un bien grand mot puisque ce sont de simples liens dont l'anchor correspond à leurs thématiques et forcément à la mienne)...je suis un peut perdu la!

On est sur un forum WH? Les liens sont censé être fait par les utilisateurs. Tient si aujourd'hui je change les ancres de mes liens sortant? Et bien sur ta 100 clampins qui font la même action...franckM a dit:Je vois pas où est le problème de changer des anciennes ancres... Google dit que c'est pénalisable d'avoir des ancres trop optimisées... ben tu corriges.

En + bien sûr de rajouter de nouveaux liens.

Je rappelle que faire sois-même des liens vers son site et hors charte Google, ils disent que c'est "illégal" dans leurs TOS.

@tryan

le problème, quant tu fais des liens vers des sites avec la même thématiques, surtout des liens en bas de page, cela peut être considérer et parfois à tort comme de la vente ou de l'échange de lien, google déteste les échanges de liens, surtout le spam massif de liens en pied de page.

moi je pense que pour les BLs externes avec ancres sur-optimiser, ses liens ne sont pas pris en compte pour le positionnement par google, donc le mieux c'est de repartir sur une base saine, c'est à dire avec des BLs neuf sur de nouveau site internet de qualité, et dans ancres varier et avec parfois pas d'ancres du tout, et aussi penser au pages profondes du site, en faite il faut donnée l’illusion que le lien à été fait spontanément et sincèrement par un de tes visiteurs/clients.

aussi j'ai l'impression, que google accorde moins d'importance voir pas, aux liens qui ne fournissent pas ou plus de vrai nouveaux visiteurs, et des visiteurs dit de qualité, se sont des visiteurs qui:

-restent suffisamment longtemps sur le site.

-le cas échéant cliquent sur les pubs.

-on visité suffisamment de pages et semblent avoir lue tout ou partie des pages du site.

- des visiteurs qui se sont convertie aux objectifs, c'est à dire créer un compte et remplie le panier.

bref des visiteurs qui génères du chiffre d'affaire, les autres liens qui ne fournissent pas ou plus de visiteurs, ne valent rien ou presque.

il faut des liens qui fournissent des visiteurs, de qualité sur la durée et le plus longtemps possible.

le problème, quant tu fais des liens vers des sites avec la même thématiques, surtout des liens en bas de page, cela peut être considérer et parfois à tort comme de la vente ou de l'échange de lien, google déteste les échanges de liens, surtout le spam massif de liens en pied de page.

moi je pense que pour les BLs externes avec ancres sur-optimiser, ses liens ne sont pas pris en compte pour le positionnement par google, donc le mieux c'est de repartir sur une base saine, c'est à dire avec des BLs neuf sur de nouveau site internet de qualité, et dans ancres varier et avec parfois pas d'ancres du tout, et aussi penser au pages profondes du site, en faite il faut donnée l’illusion que le lien à été fait spontanément et sincèrement par un de tes visiteurs/clients.

aussi j'ai l'impression, que google accorde moins d'importance voir pas, aux liens qui ne fournissent pas ou plus de vrai nouveaux visiteurs, et des visiteurs dit de qualité, se sont des visiteurs qui:

-restent suffisamment longtemps sur le site.

-le cas échéant cliquent sur les pubs.

-on visité suffisamment de pages et semblent avoir lue tout ou partie des pages du site.

- des visiteurs qui se sont convertie aux objectifs, c'est à dire créer un compte et remplie le panier.

bref des visiteurs qui génères du chiffre d'affaire, les autres liens qui ne fournissent pas ou plus de visiteurs, ne valent rien ou presque.

il faut des liens qui fournissent des visiteurs, de qualité sur la durée et le plus longtemps possible.

Ok, merci de tes réponses @mpic.

Franchement c'est chaud ce que tu évoques car tout mes liens externes sont certes des échanges de liens mais sont aussi pour la majorité de gros sites bien placés dans ma thématique donc de qualité.C'est comme si j'obtenais pour mon 3w du profil un échange avec "leboncoin" et que tu me dises qu'il faut que je le vire..ça fait mal au c*l quand même!

Franchement c'est chaud ce que tu évoques car tout mes liens externes sont certes des échanges de liens mais sont aussi pour la majorité de gros sites bien placés dans ma thématique donc de qualité.C'est comme si j'obtenais pour mon 3w du profil un échange avec "leboncoin" et que tu me dises qu'il faut que je le vire..ça fait mal au c*l quand même!

Pas le viré, juste de comprendre qu'au bout d'un moment, google risque de ne plus en tenir compte, pour le positionnement dans les SERP, à plus fortes raison si les ancres sur leboncoin.fr et les sites equivalent a se site, si les ancres sont sur optimiser et presques toutes les mêmes, et/ou pointes presque toutes sur la même page.

en clair, si tes liens sur le site leboncoin.fr, t'apporte de vrai visiteurs qualifier et de grande qualité, et qui donne un bon taux de conversion, alors c'est gagner, donc garde de les elles sont très bien là ou elles sont comme elles le sont, par contre il est fort probable que ses liens fait depuis se site, si les ancres ne sont pas varier, et ne donne pas l'impression d'avoir été fait de manière naturel par un client ou un visiteur de ton site, alors google risquerai de ne pas en tenir compte pour le positionnement dans les SERP, car après tous un lien c'est juste un lien ça ne peux pas faire de mal, c'est juste que l'ancre sur-optimiser du lien google n'en tiendra pas compte pour positionner le site dans les SERP.

il faut en premier lieu privilégier les liens qui permet de générer du CA, donc d'apporter des visiteurs qui sont convertibles en clients, c'est grace à ça que tu monte dans les SERP durablement.

en clair, si tes liens sur le site leboncoin.fr, t'apporte de vrai visiteurs qualifier et de grande qualité, et qui donne un bon taux de conversion, alors c'est gagner, donc garde de les elles sont très bien là ou elles sont comme elles le sont, par contre il est fort probable que ses liens fait depuis se site, si les ancres ne sont pas varier, et ne donne pas l'impression d'avoir été fait de manière naturel par un client ou un visiteur de ton site, alors google risquerai de ne pas en tenir compte pour le positionnement dans les SERP, car après tous un lien c'est juste un lien ça ne peux pas faire de mal, c'est juste que l'ancre sur-optimiser du lien google n'en tiendra pas compte pour positionner le site dans les SERP.

il faut en premier lieu privilégier les liens qui permet de générer du CA, donc d'apporter des visiteurs qui sont convertibles en clients, c'est grace à ça que tu monte dans les SERP durablement.

_Soul a dit:On est sur un forum WH ? Les liens sont censé être fait par les utilisateurs

Donc, quand tu lances un site, tu attends qu'un "égaré" te fasse un lien ? :mrgreen:

Et bien bon courage. WH ne signifie pas qu'il faut attendre un lien, on peut aussi provoquer tout en restant à la limite des guideslines. C'est comme si tu disais que le boulanger du coin déclare tout son C.A, car les guideslines du fisc etc...

Google dit depuis 1998... et après se dédit tous les ans, puis tous les 6 mois, puis 3, puis 1, et maintenant paraît-il que c'est du temps réel... : en clair, ce qui est bien aujourd'hui, deviendra l'enfer demain. Qui est WH dans ce cas ? Lui ou nous ? Google veut happer pour son propre compte les revenus des money keys, point barre :wink:

tryan a dit:Ok, merci de tes réponses @mpic.

Franchement c'est chaud ce que tu évoques car tout mes liens externes sont certes des échanges de liens mais sont aussi pour la majorité de gros sites bien placés dans ma thématique donc de qualité.C'est comme si j'obtenais pour mon 3w du profil un échange avec "leboncoin" et que tu me dises qu'il faut que je le vire..ça fait mal au c*l quand même!

Attends un peu et ne prends pas pour argent comptant tout ce qui est dit car pour l'instant en fait personne ne sait vraiment comment pingouin fonctionne.

La chose qui revient le plus souvent reste les ancres externes trop optimisées vers ton site.

Les échanges de liens, les liens en footer... personne ne sait si cela impacte un site et de toute façon c'était déjà pas très conseillé... J'ai des sites qui n'avaient AUCUN lien en footer et qui ont étés impactés.

et qui donne un bon taux de conversion, alors c'est gagner

Comment google peut le savoir si comme moi la personne n'utilise pas analytics ?

Je rappelle que faire sois-même des liens vers son site et hors charte Google, ils disent que c'est "illégal" dans leurs TOS.

Les inscriptions dans les annuaires, c'est interdit ?

A tout hasard, est ce qu'un nombre conséquent de backlinks venant d'un même domaine peut avoir des conséquences (échange de lien toute page donc même ancre)? Si tel est le cas, est t'il préférable de ce limiter à un lien par domaine ou peut on "jouer" avec le "nofollow" pour être présent partout chez le partenaire (par exemple sur 10 000 liens » 1 lien dur » 9999 liens en nofollow)?

tryan a dit:A tout hasard, est ce qu'un nombre conséquent de backlinks venant d'un même domaine peut avoir des conséquences (échange de lien toute page donc même ancre)? Si tel est le cas, est t'il préférable de ce limiter à un lien par domaine ou peut on "jouer" avec le "nofollow" pour être présent partout chez le partenaire (par exemple sur 10 000 liens » 1 lien dur » 9999 liens en nofollow)?

Je me suis posé la même question mais à ce compte là ce serait trop facile: tu trouves un échange avec un site qui a par exemple 200000pages indexées, tu mets en ancre l'adresse du site: http://example.com et tu sors de la pénalité.

Mais bon, je dis ça, j'en sais rien en fait !

WRInaute accro

Pas évident que le nombre de liens soit pris en compte de façon aussi "simple", a la place de GG je prendrait en compte le nombre de domaines différents ...franckM a dit:et tu sors de la pénalité.

j'en ai pas mal qui sont réciproque ou pas et cela ne semble pas m'affecter.A tout hasard, est ce qu'un nombre conséquent de backlinks venant d'un même domaine peut avoir des conséquences

zeb a dit:Pas évident que le nombre de liens soit pris en compte de façon aussi "simple", a la place de GG je prendrait en compte le nombre de domaines différents ...

Oui c'est bien ce que je disais.

Le truc que je voudrais vraiment savoir c'est si il y a une pondération par ancienneté du lien.

Ma question n'était pas en ce sensfranckM a dit:Je me suis posé la même question mais à ce compte là ce serait trop facile: tu trouves un échange avec un site qui a par exemple 200000pages indexées, tu mets en ancre l'adresse du site: http://example.com et tu sors de la pénalité.

La seconde était : peut on garder les 200 000 liens si un seul est en dur et les autres en nofollow?

@zeb : par réciproque, tu entends par combien (grosso modo) un même lien provenant d'un même domaine?

WRInaute accro

* j'ai une masse d'environ 500 / 550 000 liens répartis sur 8 domaines qui pointent sur un accueil (entre autre) avec des anchors proches mais différents issus de site à thématique complémentaire en bonne majorité pour lesquels je ne fait pas de liens retour sur le site visé (enfin un ou deux liens retours sur une page perdu au milieu du site mais pas pour les 8 domaines).tryan a dit:@zeb : par réciproque, tu entends par combien (grosso modo) un même lien provenant d'un même domaine?

* J'ai aussi 2 sites pour lesquels je fais du réciproque (home pour home) sur toutes les pages.

* Et un autre site ou c'est l'inverse (moi je le link toutes pages lui ne me fait qu'un lien accueil (mais je suis le seul a en profiter))

* Un partenaire page profonde que je lie depuis des pages profondes vers des pages profondes à lui (en réciproque) (un autre a l'étude dans le même style)

* Mon linking regroupe 426 domaines différents (pur bio pour la petite histoire si on met de côté les 12 cas au dessus, car j'ai sollicité une trentaine d'annuaire et un site de CP, plus fait de la com sur une trentaine de blog au max (france et canada))

Un des sites qui me link le plus (500 000 liens de ceux évoqués ci dessus) est totalement non sollicité de ma part et pas sous mon contrôle.

Un autre site de cette masse cité plus haut est le maintenant célèbre "uddowner.com" qui me balance plus de 2000 liens (c'est pas énorme mais significatif) vers 39 pages distinctes.

* A côté de cette "masse", beaucoup de liens wiki non sollicités (vers de multiples pages profondes), des sites .gouv non sollicité, du blog a gogo (certains me font du pompage d'article avec liens profond compris donc je les oblige a citer la source et conserver les liens) pas mal de sites divers sur domaines propres (pour illustrer leur contenu) le tout non sollicité.

C'est assez varié comme tu peut le voir une bonne piste est donc de brouiller les cartes en introduisant une grosse dose de tout et n'importe quoi.

Côté "on page" je gère rien en footer le met tous dans un menu quand c'est pour un partenaire. Mes footer ne contiennent que des liens internes utiles.

Je dis que c'est l'ancre du lien qui peux posé problème pour google, pas le lien en lui même, se que je note c'est que les ancres de lien interne du site on beaucoup d'importance, si sur votre site internet, vous faites des liens sortant sur-optimiser, vous êtes sanctionnable par pingouin(WEBSPAM).

Plutôt que de supprimer vos backlinks sur-optimiser qui pointes vers votre site, vous pouvez modifier l'ancre des backlinks, mais le mieux c'est de recréer de nouveaux backlinks avec des ancres varier, vers de multiples pages de votre site, des backlinks depuis un grand nombres de nouveaux domaine, donnée l'impression que vos backlinks, sont fait par des visiteur/clients/lecteurs de votre site internet et pas par vous ou un PRO du SEO.

Plutôt que de supprimer vos backlinks sur-optimiser qui pointes vers votre site, vous pouvez modifier l'ancre des backlinks, mais le mieux c'est de recréer de nouveaux backlinks avec des ancres varier, vers de multiples pages de votre site, des backlinks depuis un grand nombres de nouveaux domaine, donnée l'impression que vos backlinks, sont fait par des visiteur/clients/lecteurs de votre site internet et pas par vous ou un PRO du SEO.

➡️ Offre MyRankingMetrics ⬅️

pré-audit SEO gratuit avec RM Tech (+ avis d'expert)

coaching offert aux clients (avec Olivier Duffez ou Fabien Faceries)

Voir les détails ici

Discussions similaires

- Réponses

- 14

- Affichages

- 5K

- Réponses

- 22

- Affichages

- 13K

- Réponses

- 50

- Affichages

- 10K

- Réponses

- 2

- Affichages

- 2K

- Sondage

- Réponses

- 3

- Affichages

- 3K

- Réponses

- 35

- Affichages

- 6K

- Réponses

- 38

- Affichages

- 5K

- Réponses

- 1

- Affichages

- 2K

- Réponses

- 7

- Affichages

- 3K

- Réponses

- 52

- Affichages

- 7K

- Réponses

- 90

- Affichages

- 12K

- Réponses

- 2

- Affichages

- 2K

- Réponses

- 2

- Affichages

- 3K

- Réponses

- 3

- Affichages

- 2K

- Réponses

- 4

- Affichages

- 4K

- Réponses

- 141

- Affichages

- 40K

- Réponses

- 4

- Affichages

- 2K

- Réponses

- 3

- Affichages

- 3K

- Réponses

- 6

- Affichages

- 3K