Cet article fait partie des archives de WebRankInfo : certes, il est ancien, mais complet et détaillé pour son époque. Si vous cherchez d'autres informations, faites une recherche sur le site ou participez au forum. Contactez-moi si besoin.

Sommaire

- Chronologie de Panda

- Explications sur Panda, conseils pour s'en sortir

- Discussions et aide sur Panda

- Consulting et formation Google Panda

- Vidéo d'un audit Google Panda

- Les évolutions de Panda en France

- Infographies

Qu'est-ce que Google Panda ?

Définition

Panda est le nom de code d'une mise à jour de l'algorithme Google en place depuis février 2011, visant à lutter contre le spam, notamment en pénalisant des types de sites comme les fermes de contenus ou les scrapers (pillage de contenus). Depuis 2016, Panda est intégré en continu au coeur de l'algo principal de Google et plus aucune date de mise à jour n'est communiquée.

Présentation

Suite aux critiques à répétition sur la qualité des résultats, qui se sont intensifiées depuis fin 2010, Google a mis en place au printemps 2011 une évolution majeure de son algorithme. Les principaux types de sites spécialement ciblés par cet algorithme sont les fermes de contenus, les scrappers (qui copient les contenus de tiers sans leur accord) et de nombreux sites intermédiaires (entre Google et les internautes) : comparateurs de prix, agrégateurs, codes de réduction (affiliation), annuaires d'entreprises ou locaux.

Dans les premiers jours, on parlait de Content Farm Update car on pensait que cette mise à jour concernait essentiellement les fermes de contenus. On apprit ensuite que le nom de code interne chez Google était Panda, du nom d'un ingénieur ayant participé à son élaboration.

La pénalité est globale à tout le site

Les pénalités Panda sont globales à tout un site. Autrement dit, il suffit que ce nouvel algo identifie "un certain nombre" de pages de trop faible qualité pour que l'ensemble du site en pâtisse ! Apparemment en général, il est possible de s'en sortir en supprimant ces pages (reste à savoir les identifier...) ou en améliorant leur qualité.

2 exemples :

- un site annuaire d'entreprises qui n'aurait que des informations très générales sur chaque entreprise, déjà publiées à plein d'autres endroits sur le web. Tant qu'il n'a pas réussi à obtenir des avis utilisateurs pour enrichir ses pages, Google peut estimer qu'elles sont de trop faible qualité...

- un site de questions-réponses : tant qu'il n'y a pas de réponses à chaque question, Google peut estimer qu'elles sont de trop faible qualité...

Maile Ohye et Matt Cutts vont jusqu'à conseiller d'interdire l'indexation de ce genre de pages tant qu'elles n'ont pas assez de contenu ! Par exemple en utilisant la balise meta robots noindex (Maile Ohye le recommande plutôt que le blocage du crawl par le fichier robots.txt, afin que les crawlers continuent de venir crawler la page).

L'overdose de publicité peut-elle nuire gravement au référencement ?

Matt Cutts a confirmé que, en soi, avoir des publicités sur son site ne diminue pas sa qualité [perçue par Google ?]. Mais qu'il est possible d'en faire trop ! Par exemple, créer des pages qui dans la partie supérieure (au-dessus de la ligne de flottaison "above the fold") n'ont que des publicités. Ou alors des pages saturées de publicités, à tel point que l'internaute ne sait même plus trouver le contenu. D'ailleurs je sens que j'ai des améliorations à faire sur mon site à ce sujet ;-)

Conclusion : on va peut-être enfin arrêter de parler d'indice de densité de mots-clés et se mettre à parler d'indice de densité de publicités :-) A votre avis, si Google se base vraiment là-dessus, comment peut-il le mesurer ? Il calcule un ratio entre les surfaces (publicité / contenu) ?

Google réduit la fréquence de crawl des sites de faible qualité

Comme pour d'autres pénalités (ou "couches" de l'algorithme), si Google estime qu'un site est de faible qualité et le pénalise, alors non seulement le site aura moins de visibilité dans les pages de résultats, mais Google va également limiter le crawl. Ca peut donc valoir le coup de vérifier sur votre site à quelle fréquence Google crawle vos pages, éventuellement rubrique par rubrique. Pour cela, pour rentrer dans les détails, mieux vaut analyser les logs.

Historique : dates des mises à jour Google Panda

Panda 1.0 : 24/02/2011. La première version de Panda fut introduite le 24 février 2011 aux Etats-Unis uniquement, pour les requêtes en anglais. De très nombreux sites ont vu leur visibilité dans Google chuter dramatiquement, de plusieurs dizaines de pourcent selon différentes estimation. Les sites visés par Panda ont été les principales victimes, mais cette "update" a été largement critiquée en raison du nombre de dégâts collatéraux (des sites de qualité injustement touchés par les nouveaux filtres Panda).

Panda 2.0 : 11/04/2011. Le 11 avril 2011, Google étend Panda au reste du monde mais toujours uniquement pour les requêtes en anglais. Plusieurs analyses ont montré qu'il s'agissait de Panda 2, une version modifiée (améliorée ?) de la première mouture de Panda. D'après Google, Panda 2 tient également compte des retours utilisateurs sur la qualité des résultats, ce qui est une première. En effet, depuis mars 2011, les utilisateurs de Google Chrome peuvent installer une extension développée par Google pour bloquer définitivement un site jugé indésirable. Chaque site ainsi bloqué disparait donc des résultats Google, mais seulement pour l'utilisateur qui l'a bloqué. Néanmoins, on peut supposer que depuis la v2 de Panda, Google exploite ces données, a priori dans les cas où une majorité d'utilisateurs ont choisi de bloquer un site. Google a sans doute utilisé des techniques de détection de spam similaires à celles développées depuis des années pour détecter les clics frauduleux sur les annonces AdWords ou AdSense.

Panda 2.1 : 10/05/2011. Vers le 10 mai, une nouvelle mise à jour Panda 2.1 est mise en ligne. Seules les requêtes en anglais sont concernées.

Panda 2.2 : 16/06/2011. Vers le 16 juin, la version 2.2 de Panda a été diffusée. Seules les requêtes en anglais sont concernées. Barry Schwartz déclare être "sûr à 100%" qu'il s'agit bien de Panda 2.2, une nouvelle "instance" du dernier filtre Google qui fait trembler le web. Matt Cutts avait annoncé début juin qu'il y aurait bientôt une nouvelle version (la 2.2), censée mieux repérer les scrapers (pilleurs de contenus). Il avait également déclaré qu'aucune date n'était encore arrêtée pour un déploiement de Panda sur les autres langues que l'anglais. Enfin, il avait redit que Panda ne fait pas partie intégrante de l'algorithme, au sens où tous ses filtres s'appliquent en continu ; au contraire, Panda est lancé de temps en temps, voilà pourquoi on parle de Panda 1.0, Panda 2.0, 2.1 ou maintenant 2.2. On a su ensuite le 16/06/2011 que c'était officiel. Les premiers résultats font état une nouvelle fois de nombreuses chutes de trafic, mais aussi de certaines remontées (ce qui semble très rare chez les sites touchés par Panda depuis fin février aux USA).

Panda 2.3 : 23/07/2011. Vers le 23 juillet, la version 2.3 de Panda est sortie. Seules les requêtes en anglais sont concernées. Google a précisé au site SEL que cette nouvelle version des filtres Panda incorpore de nouveaux critères, permettant de mieux distinguer les sites de bonne et mauvaise qualité. Mais on ne sais pas lesquels ;-) Rappelons que Panda est un ensemble de filtres qui s'ajoutent à l'algorithme classique de Google (référencement naturel), ayant pour objectif de repérer les pages et les sites de mauvaise qualité afin de diminuer leur visibilité dans les pages de résultats. Panda n'est pas actif en continu, si bien que les sites pénalisés ne peuvent pas voir leur visibilité s'améliorer tant qu'une nouvelle version n'a pas été mise en ligne. C'est pour cette raison qu'on parle des différentes versions de Panda, cette dernière étant semble-t-il mineure.

Panda 2.4 : 12/08/2011. Le 12 août, Google étend étend Panda à toutes les langues sauf 3 asiatiques. Panda est donc enfin arrivé en France ! Depuis ce matin 12 août 2011, à en croire l'annonce officielle publiée par Amit Singhal en personne sur le blog officiel de Google France (il dirige le département Search Quality). Il indique que les retours utilisateurs qui ont pu être mesurés font état de résultats "très positifs". A partir de maintenant, Panda est appliqué à toutes les langues sauf le chinois, le japonais et le coréen, pour lesquelles Google doit encore "tester des améliorations potentielles". D'après Google, entre 6% et 9% des requêtes sont concernées en moyenne, toutes langues confondues.

Panda 2.5 : 28/09/2011. Vers le 28 septembre, Google a sorti la version 2.5 de Panda. A priori ceci concerne les mêmes langues que la 2.4. D'après Matt McGee, Google aurait confirmé officiellement cette nouvelle version sans donner aucun détail, ni sur la date ni sur les changements apportés. WebProNews confirme cette information, citant l'exemple d'un site qui vient de perdre 50% de son trafic, alors qu'il avait réussi à récupérer d'une première chute avec Panda 1.0. La dernière version officielle, la 2.4, arrivée le 12 août, était celle de l'extension à toutes les langues (ou presque). Par simplification on avait parlé de l'arrivée de Panda en France. Officiellement il n'y a donc rien eu entre le 12 août et le 28 septembre, alors que nous sommes plusieurs à avoir observé de très gros changements entre le 1er et le 4 septembre (plusieurs dizaines de pourcent de variation de trafic SEO Google sur des sites préalablement touchés le 12 août).

Panda 2.5.1 : 09/10/2011. Vers le 9 octobre, Google a sorti la version 2.5.1 de Panda

Panda 2.5.2 : 13/10/2011. Vers le 13 octobre, Google a sorti une version "mineure" intitulée Panda 2.5.2. D'après ce que j'ai pu observer, cette mise à jour a démarré mardi 11 et s'est amplifiée jusqu'à hier. Matt Cutts a confirmé qu'il s'agit bien d'un update lié à Panda, qu'on pourrait qualifier de mineur.

Panda 2.5.3 : 19/10/2011. Vers le 19/20 octobre, Google a encore sorti une version "mineure" intitulée Panda 2.5.3

Panda 3.1 : 18/11/2011. Vers le 18 novembre, Google a sorti une autre version "mineure". L'information a été fournie par le compte Twitter officiel de Google. Ce changement, lié à une mise à jour des données utilisées par l'algorithme Panda, devrait affecter moins de 1% des recherches Google.

Panda 3.2 : 18/01/2012. Vers le 18 janvier 2012, Google a sorti Panda 3.2, seulement une mise à jour des données mais pas de l'algo. Les infos viennent de Barry Schwarz qui dit avoir eu confirmation de la part de Google qu'une mise à jour du filtre Panda a eu lieu "il y a environ une semaine", ce qui la situe aux alentours du 18 janvier selon Barry (@rustybrick). La date n'étant pas précise, nous ne saurons pas si les mouvements observés vers le 14 janvier étaient liés ou pas à Panda. Rappelons que le 19 janvier, Google a annoncé qu'un nouvel algo est en place, consistant à analyser la mise en page des sites pour détecter les cas où la publicité est envahissante, notamment au-dessus de la ligne de flottaison. Ce nouveau changement vient perturber encore un peu plus les analyses si bien qu'il devient difficile de savoir par quel changement d'algo Google on est concerné... Google a indiqué qu'il ne s'agit que d'une mise à jour des données et qu'aucun changement n'a été effectué sur l'algorithme. En particulier, aucun nouveau critère n'a été ajouté.

Panda 3.3 : mi 02/2012. Courant février 2012, Google a sorti Panda 3.3, encore une mise à jour des données mais pas des critères de Panda. Comme pour Panda 3.2 (situé vers le 18 janvier 2012), il s'agit ici seulement d'une mise à jour des données utilisées par Panda. Aucun nouveau critère n'a donc été rajouté à l'algorithme Panda. Difficile dans ces conditions d'en dire plus et même de situer la date avec précision. Voici la source : "Panda update. This launch refreshes data in the Panda system, making it more accurate and more sensitive to recent changes on the web.".

Panda 3.4 : 23/03/2012. Vers le 23 mars 2012, Google a sorti Panda 3.4, une nouvelle mise à jour des données qui touche 1,6% des requêtes. Comme pour Panda 3.2 et 3.3 (respectivement en janvier et février 2012), il s'agit ici seulement d'une mise à jour des données utilisées par Panda. Aucun nouveau critère n'a donc été rajouté à l'algorithme Panda. D'après Google, environ 1,6% des requêtes seraient affectées. Difficile dans ces conditions d'en dire plus et même de situer la date avec précision. Rappelons que Google a indiqué récemment à Paris qu'il faut s'attendre justement à une mise à jour par mois pour Panda.

Panda 3.5 : 19/04/2012. Le 19 avril 2012, Google a sorti Panda 3.5, quelques jours seulement avant le Black Hat SEO Google Update...

Panda 3.6 : 27/04/2012. Le 27 avril 2012, Google a sorti Panda 3.6, 8 jours seulement après Panda 3.5 et uniquement 3 jours après l'algo pingouin Google... Comme pour toutes les mises à jour de Panda désormais, il s'agit ici seulement d'une mise à jour des données utilisées par Panda. Aucun nouveau critère n'a donc été rajouté à l'algorithme Panda. Par contre, au lieu d'attendre environ 6 semaines comme c'était le cas depuis fin 2011, Google a mis en place une nouvelle version (3.6) seulement 8 jours après la précédente (3.5) qui avait eu lieu le 19 avril. Il s'agit peut-être d'une exception car Google avait précisé qu'il faut s'attendre à une mise à jour par mois pour Panda. Le problème c'est qu'entre les 2, un autre changement a été appliqué également à l'algorithme, intitulé Penguin (littéralement, manchot...). Alors, pourquoi Google a-t-il jugé nécessaire de faire une version supplémentaire dans la précipitation ? Est-ce pour corriger un problème de la v3.5 de Panda ? (Par exemple un effet de bord imprévu de Penguin) Ou bien pour brouiller totalement les pistes de ceux qui essaient de comprendre sur quoi se base Google Penguin ?

Panda 3.7 : 08/06/2012. Le 8 juin 2012, Google a sorti Panda 3.7. Comme pour toutes les mises à jour de Panda désormais, il s'agit ici seulement d'une mise à jour des données utilisées par Panda. Aucun nouveau critère n'a donc été rajouté à l'algorithme Panda. D'après les informations fournies par Google, moins de 1% des requêtes sont concernées aux Etats-Unis et environ 1% dans le reste du monde.

Panda 3.8 : 25/06/2012. Le 25 juin 2012, Google a sorti Panda 3.8. D'après les informations fournies par Google, environ 1% des requêtes sont concernées dans le monde.

Panda japonais/coréen : 18/07/2012. Le 18 juillet 2012, Google a sorti une nouvelle version de Panda pour le japonais et le coréen. Selon Google, moins de 5% des requêtes sont concernées. Sauf erreur de ma part, il ne reste officiellement que les différentes variantes du chinois qui sont "épargnées" par l'algo Panda. L'annonce a été faite par Google sur Twitter.

Panda 3.9 : 25/07/2012. Le 25 juillet 2012, Google a sorti Panda 3.9. Le tweet officiel de Google précise que cette mise à jour est sortie dans la nuit du 24 au 25 juillet 2012. D'après les informations fournies par Google, environ 1% des requêtes sont concernées dans le monde. Comme pour toutes les mises à jour de Panda désormais, il s'agit ici officiellement seulement d'une mise à jour des données utilisées par Panda. Aucun nouveau critère n'aurait donc été rajouté à l'algorithme Panda. On discute de Google Panda 3.9 dans le forum.

Panda 3.9.1 : 19/08/2012. Le 19 août 2012, Google a sorti Panda 3.9.1. Le tweet officiel de Google précise que cette mise à jour est sortie dans la nuit du 19 au 20 août 2012 (lundi 20 selon l'heure de Moutain View). D'après les informations fournies par Google, environ 1% des requêtes sont concernées dans le monde. On discute de Google Panda 3.9.1 dans le forum.

Panda 3.9.2 : 18/09/2012. Le 18 septembre 2012, Google a sorti Panda 3.9.2. Le tweet officiel de Google précise que cette mise à jour est en train d'être appliquée et qu'on peut s'attendre à quelques modifications jusque dans les jours à venir. Néanmoins, d'après les informations fournies par Google, seulement 0,7% des requêtes seraient concernées dans le monde. Google reste sur une fréquence stable environ mensuelle : la mise à jour précédente était le 19/20 août 2012. On l'avait appelée 3.9.1 donc j'ignore si celle-ci sera la 3.9.2 ou la 4.0. D'après mes premières analyses, cette mise à jour est plus importante que la 3.9.1, elle est comparable à la 3.9 du 25/07/2012. On discute de Google Panda 3.10 dans le forum.

Panda 20 : 27/09/2012. Le 27 septembre 2012, Google a sorti Panda 20. On discute de Google Panda 20 dans le forum. Contrairement aux mises à jour précédentes, il ne s’agit pas d’un simple data refresh mais d’une nouvelle version avec changement des critères… Cette fois-ci il n’y a même pas eu de tweet ou de post officiel, simplement une confirmation au site SearchEngineLand de la part de Matt Cutts. Voici les informations officielles actuellement connues:

- il ne s’agit pas d’une simple mise à jour des données exploitées par Panda (comme la plupart des mises à jour précédentes) mais d’une mise à jour de l’algorithme de Google Panda. C’est étonnant car Matt Cutts avait récemment expliqué que Google n’ayant plus grand chose à modifier sur Panda, seules les données avaient besoin d’être rafraichies de temps en temps (environ chaque mois). Il avait donné cette explication quand on l’interrogeait sur le fait que Pingouin 2.0 n’était toujours pas en place.

- Panda 20 a commencé à être mis en place le 27 septembre mais ce n’est pas terminé. On peut s’attendre à voir encore des changements pendant 3 ou 4 jours. Néanmoins, les changements les plus visibles ont été mis en production dès le 27 septembre.

- L’impact est plus fort que pour les mises à jour précédentes : environ 2,4% des requêtes en anglais, mais seulement environ 0,5% en français

Panda 21 : 05/11/2012. Le 5 novembre 2012, Google a sorti Panda 21. Selon le tweet officiel, il s’agit d’une simple mise à jour des données et non pas d’une mise à jour de l’algorithme de Google Panda comme Panda 20. L’impact moyen est assez faible : pour environ 0,4% des requêtes le changement est repérable. Cette valeur monte néanmoins à 1,1% pour les requêtes en anglais aux Etats-Unis. On discute de Google Panda 21 dans le forum.

Panda 22 : 21/11/2012. Le 21 novembre 2012, Google a sorti Panda 22. L'information a été confirmée au site SearchEngine Roundtable. Pour l'instant on ne sait rien d'autre que la mise à jour a eu lieu le 21 novembre 2012 et que l'impact moyen est tel que pour environ 0,8% des requêtes le changement est repérable. De nombreux webmasters avaient repéré de gros changements quelques jours seulement avant. Certains avaient cru qu'il s'agissait d'une update officielle, mais ce ne fut pas le cas. Cet update avait été baptisé Google Poney (on va bientôt avoir un zoo entier).

Panda 23 : 21/12/2012. Le 21 décembre 2012, Google a annoncé Panda 23. L'information a été annoncée sur le compte Twitter officiel de Google. Ils parlent d'un simple "data refresh", mais pour ma part j'ai déjà identifié d'autres updates Panda soit-disant uniquement data refresh, mais dont le fort impact cachait sans doute un changement dans les critères ou leurs réglages... Officiellement, l'impact moyen est tel que pour environ 1,3% des requêtes le changement est repérable. De nombreux webmasters avaient repéré de gros changements autour du 13 décembre, mais Google a nié qu'il y ait eu le moindre update. Ont-ils fait des tests à cette époque ?

Panda 24 : 22/01/2013. Le 22 janvier 2013, Google a annoncé Panda 24. Cette mise à jour Panda concerne toutes les langues, y compris le français. Pour le français, on ne connait pas l’impact, mais officiellement, l’impact moyen pour l’anglais est tel que pour environ 1,2% des requêtes le changement est repérable.

Panda 25 : 15/03/2013. Le 15 mars 2013, Panda 25 est sans doute sorti. Google ne l'a pas officialisé mais avait annoncé la date quelques jours avant. Google a confirmé qu’aucun update Panda ne sera désormais officialisé.

Depuis mars 2013, Panda est officiellement intégré à l'algorithme général de Google. Les dates des mises à jour ne sont donc a priori plus toujours communiquées...

Panda 26 : Vers le 3 juin 2013, Panda 26 est sans doute sorti.

14/03/2013 : Matt Cutts indique que Panda ne sera pas déployé occasionnellement comme maintenant, mais de façon continue avec le reste de l’algorithme global de Google (« everflux »). Matt Cutts parle des updates Google Panda à la conférence SMX (image source searchengineland.com). Sa déclaration est :

Rather than having some huge change that happens on a given day. You are more likely in the future to see Panda deployed gradually as we rebuild the index. So you are less likely to see these large scale sorts of changes.

Jusqu'à présent, on était habitués à avoir une mise à jour environ mensuelle. L'avantage était de pouvoir identifier les baisses (ou hausses !) de trafic SEO Google en les associant à un update Panda quand la date correspondait. L'inconvénient était qu'il fallait attendre au moins 1 mois avant d'avoir des résultats de nos tests pour sortir des "pénalités Panda.

Mais désormais si c'est totalement mélangé au reste de l'algorithme SEO de Google, il sera impossible de savoir si un changement brutal de trafic issu de Google est lié à Panda ou pas...

Concrètement dans notre jargon on parle de "Panda Everflux".

Panda 27 : 18/07/2013. Google a annoncé que Panda 27 est sorti le 18 juillet 2013. Voici la déclaration d'un porte-parole de Google, rapportée par searchengineland.com : "In the last few days we’ve been pushing out a new Panda update that incorporates new signals so it can be more finely targeted.". La date n'est donc pas si précise que ça, mais au moins on a une information officielle, alors même que Matt Cutts avait annoncé que désormais Panda serait mis à jour en continu avec le reste de l'index et de l'algo Google. En réalité, il a précisé ensuite que les mises à jour de Panda se font environ chaque mois et que chaque mise en ligne s'étale sur une dizaine de jours. Vers le 11 juin, Matt Cutts avait déclaré que la dernière version de Panda datait de 1 mois et demi. D'après mes analyses, j'avais donc situé Panda 26 vers le 3 mai. Il y avait ensuite eu vers le 8 mai des bouleversements mais a priori pas d'update Panda (certains parlaient de Phantom Update). Egalement, certains ont noté de gros changements dans les SERP Google vers le 25 juin mais ça n'était sans doute pas non plus Panda. Voilà pourquoi j'estime que la version du 18 juillet est sans doute la n°27.

Panda 28 ou 4.0 : 20/05/2014. Google a annoncé que Panda 4.0 est sorti le 20 mai 2014. Voici l'annonce Twitter de Matt Cutts, en charge de la lutte contre le spam pour le moteur de recherche Google : "Google is rolling out our Panda 4.0 update starting today.". Quelques remarques :

- depuis mars 2013, comme cela avait été annoncé, Google n'annonce plus les dates de mise à jour de son algorithme anti-spam Panda, même si officiellement il continue d'être mis à jour environ chaque mois

- Matt Cutts la nomme Panda 4.0 alors que souvent on ne faisait que donner des numéros de sortie. Il veut sans doute signifier qu'il s'agit d'un changement majeur dans l'algorithme, et pas seulement une mise à jour des données.

- Matt Cutts avait annoncé qu'une version adoucie de Panda était en préparation, censée préserver les sites des PME et TPE : on ne sait pas si c'est cette version 4.0

- Il indique que la mise en ligne a commencé le 20 mai, pourtant nous sommes nombreux à avoir identifié des changements quelques jours avant. Je pense qu'il n'a pas annoncé la date précisément afin de brouiller les pistes

- Enfin, une autre mise à jour a également été annoncée officiellement par Google, la version 2 d'un algorithme visant à lutter contre certaines formes très précises de spam dans des niches verticales. Il s'agit par exemple du rachat de crédits.

Le 23 mai 2014, Matt Cutts a précisé que Panda 4.0 était comme une nouvelle architecture qui inclut certaines évolutions de l'algorithme visant à adoucir l'impact (sur les sites de TPE.PME comme annoncé sans doute) mais qui pose également des jalons pour des évolutions futures : "Think of it like P4 is a new architecture. Brings in some of the softer side, but also lays groundwork for future iteration."

J'ai trouvé un référenceur qui a étudié Panda aussi bien chez les sites qui ont progressé avec Panda 4.0 que chez ceux qui ont chuté (pour certains très lourdement, jusqu'à 70%).

Panda intégré au coeur de l'algo de Google en janvier 2016

En janvier 2016, on apprend que Panda est intégré dans le cœur de l'algo mais n'est pas temps réel...

La confusion règne autour des mises à jour de Google, concernant Panda, Penguin, Phantom et autres updates du cœur de l'algorithme. Voici un rappel des faits avérés concernant Panda.

En mars 2013, Matt Cutts avait déjà déclaré que Panda serait prochainement déployé de façon graduelle, au fur et à mesure que l'index de Google est reconstruit (ce que j'interprète comme "au fur et à mesure que Googlebot crawle les pages") :

Rather than having some huge change that happens on a given day. You are more likely in the future to see Panda deployed gradually as we rebuild the index. So you are less likely to see these large scale sorts of changes.

On avait parlé de "Panda Everflux" et d'intégration au cœur de l'algo Google...

Ensuite toujours en mars 2013, Google avait déclaré qu'il ne fallait plus compter sur le fait que Google annonce ou confirme chaque mise à jour de l'algorithme Panda.

Effectivement, il y eut dans les mois qui suivirent moins d'annonces officielles de Google concernant Panda. Pourtant, Google en annonça certaines, ce qui commença à semer le trouble.

Le pire étant sans doute en juillet 2015, quand Google expliqua que le déploiement commencé vers le 18/07/2015 allait s'étaler sur plusieurs mois (contre environ une semaine d'habitude). D'ailleurs, depuis cette date nous n'avons plus eu aucune nouvelle officielle concernant Panda : le déploiement commencé en juillet 2015 est-il terminé ou toujours en cours ? Y a-t-il eu d'autres mises à jour non officialisées entre temps ?

Vers le 8 janvier 2016, des mouvements importants dans les résultats Google ayant été repérés, les conjectures se sont vite répandues. Certains y voyaient l'arrivée tant attendue de Penguin, d'autres de Panda, d'autres de Phantom et d'autres ne remarquaient rien du tout...

Ce 13 janvier 2016, voici ce que nous pouvons affirmer, grâce à des déclarations enfin claires de la part des employés de Google qui se chargent de la communication :

- cette mise à jour n'était ni Penguin, ni Panda mais une mise à jour de l'évaluation de la qualité, comme il y en a beaucoup chez Google

- Panda fait actuellement partie du cœur de l'algorithme (depuis quand exactement, on ne sait pas)

- mais malgré cela, Panda n'est pas mis à jour en continu (Panda n'est pas en temps réel)

- Google travaille à rendre Penguin temps réel, ce qui devrait être le cas pour la prochaine mise à jour (attendue pour "début 2016")

Je vous suggère de partager ces infos en les tweetant :

ainsi que :

Parmi les sources officielles claires, voyez par exemple ce tweet de Gary Illyes :

Que signifie "Panda n'est pas en temps réel" ?

Suite à une discussion sur Twitter, voici mon point de vue (ce n'est donc pas "officiel" !) :

- Notion de mesures : l'algorithme Panda repose sur la mesure de certaines valeurs (critères, "signaux" pour reprendre le terme signals). Ces mesures se font tous les jours, au fur et à mesure que Google les récolte : par le crawl d'une page, par l'étude du comportement des internautes, etc.

- Notion de versions : cet algorithme est passé de la version 1.0 à une version X ou Y aujourd'hui. Il n'y a pas un changement de version tous les jours : quand c'est le cas, on peut parler d'un update Panda, d'une mise à jour plus ou moins importante de l'algo

- Peut-on sortir un site d'une "pénalité Panda" en dehors des dates officielles de mise à jour (si jamais il y en a encore) ? Il semblerait que oui : si selon les mesures en cours, le site satisfait les critères de qualité de Panda.

- Pourquoi ne rencontre-t-on pas d'exemple de sortie brutale d'une "pénalité Panda" ? Peut-être parce qu'on remonte petit à petit, au fur et à mesure qu'on corrige les problèmes et que l'algo Panda s'en rend compte... Et aussi parce qu'il est improbable qu'on résolve en 1 coup tout ce qui posait problème d'un point de vue Panda.

- Si c'est bien comme ça qu'il faut comprendre les choses, pour les mêmes raisons, un site peut voir sa visibilité chuter à cause des critères de Panda, en dehors d'une mise à jour officielle !

Syndication de contenu et contenus dupliqués

Plusieurs sites ayant fortement chuté (60% de baisse) avaient entre 20% et 30% de contenus dupliqués en raison de la syndication de contenus. Ils n'avaient pas indiqué que la source du contenu était externe (avec une URL canonique faisant référence à un autre site) et n'avaient pas empêché l'indexation des pages avec le contenu dupliqué (avec une balise meta robots noindex).

Glenn donne aussi l'exemple d'un site qui a désindexé 70% de ses pages car il savait qu'il avait une trop grosse proportion de contenus dupliqués sur son site. Depuis, il obtient plus de trafic avec moins de pages indexées...

Ici la situation concerne du contenu dupliqué sans doute repris de l'extérieur, mais n'oubliez pas que cela peut aussi venir de chez vous (du contenu dupliqué interne). En général c'est moins gênant, sauf si cela prend de trop grandes proportions. C'est le principe de l'évaluation de la masse noire que j'aborde en détails en formation. Vous devriez d'ailleurs régulièrement faire un audit technique de votre site pour vous assurer que vous n'avez pas ce genre de problèmes (vous pouvez demander un audit de votre site sur Ranking Metrics qui propose une version simplifiée mais gratuite de l'audit).

Insertion de blocs de contenus copiés

Il a également remarqué sur certains sites ayant chuté avec Panda 4.0 qu'ils avaient inséré au milieu d'un contenu original un ou des blocs de contenus tiers. Panda essaie justement de repérer le scraping, donc ce type de pratique est devenue risquée.

Engagement et expérience utilisateur

Il rappelle aussi qu'un élément essentiel de Panda est l'expérience utilisateur (UX). Si vous n'arrivez pas à créer un bon engagement avec l'internaute, surtout celui qui arrive directement de Google, alors vous serez sans doute sanctionné par Panda. Glenn confirme que le taux de rebond (tel que mesuré par Google Analytics) n'est d'aucune utilité, ou presque. Il existe en effet plein de cas où un fort taux de rebond n'est pas synonyme de déception de l'internaute. De son côté, il recommande de modifier Google Analytics afin de faire calculer un taux de rebond ajusté, tenant compte du temps passé sur la page. Concrètement, si l'internaute reste sur votre page un certain temps minimum (à vous de le fixer), alors un événement est enregistré dans Google Analytics. Les internautes n'ayant vu qu'une page mais étant restés suffisamment longtemps ne seront plus comptés comme ayant "fait un rebond". Pour plus d'infos, lisez ce post du blog officiel de Google Analytics.

Comme moi, Glenn semble persuadé que la notion clé pour Panda est la question suivante :

Est-ce qu'une trop grande partie des internautes arrivés sur mon site depuis Google reviennent en arrière dans les SERP, notamment au bout de peu de temps ?

Ce comportement d'allers-retours entre les SERP et les sites des résultats est appelé le pogosticking. Cette durée est appelée Dwell Time et je suis certain que Google l'exploite. Bing a confirmé que cette notion est utilisée pour évaluer la qualité des pages. Relisez mes explications de 2011, encore largement d'actualité sur l'impact de l'expérience utilisateur sur Panda.

Voilà selon lui le cocktail qui mène droit à des problèmes avec Panda :

Des sites visibles sur des masses de requêtes sur seulement quelques pages

Ce point-là est moins clair pour moi, mais Glenn indique qu'il a remarqué que certains sites arrivaient à se positionner sur un très grand nombre de requêtes sans avoir pourtant le contenu en conséquence. C'était souvent le cas avec des pages d'accueil qui sortaient sur plein de requêtes sans aborder vraiment le sujet dans la page.

Ces sites-là ont fortement chuté avec Panda 4.0.

Il rappelle qu'il est indispensable de créer un contenu de forte qualité, qui fournit toutes les informations que l'internaute vient chercher.

Panda 4.1 : vers le 23/09/2014. Google a annoncé que Panda 4.1 est sorti vers le 23 septembre 2014. Les infos officielles : "Plus tôt cette semaine, nous avons commencé à mettre en place doucement une version améliorée de l'algorithme Panda et nous prévoyons que tout soit terminé la semaine prochaine. En nous basant sur les retours des utilisateurs (et des webmasters), nous avons été en mesure de découvrir quelques nouveaux critères pour aide Panda à identifier plus précisément le contenu de faible qualité. Ceci se traduit par une plus grande diversité de petits et moyens sites de haute qualité mieux positionnés (dans les SERP Google), ce qui est bien. Selon les versions locales de Google, l'impact de cette mise à jour touche entre 3% et 5% des requêtes".

Mon analyse :

- depuis mars 2013, comme cela avait été annoncé, Google n'annonce plus les dates de mise à jour de son algorithme anti-spam Panda, même si officiellement il continue d'être mis à jour environ chaque mois. Mais il y a des exceptions comme cette fois-ci ou dernièrement Panda 4.0 sortie le 20/05/2014.

- Etant donné qu'il y a de nouveaux critères incorporés dans l'algorithme, il ne s'agit pas d'un simple data refresh (mise à jour des données)

- Il est probable que cette version 4.1 soit la fameuse version adoucie de Panda que Matt Cutts avait annoncée

Panda 4.2 : vers le 18/07/2015. Google a annoncé que Panda 4.2 est sorti vers le 18 juillet 2015. L'information a été fournie au très sérieux site Search Engine Land. Voici ce qu'on sait pour l'instant :

- le "refresh" a commencé le WE du 18-19 juillet (je ne sais donc pas s'il faut retenir le 17, le 18 ou le 19)

- vous n'avez sans doute rien remarqué car le déploiement va être spécialement lent, s'étalant sur plusieurs mois !

- l'algorithme touche (toujours) l'ensemble du site mais pourtant il pourra très bien n'y avoir aucun changement sur certaines pages de votre site

- pour ce qui concerne les requêtes en anglais, l'impact de cette mise à jour touche entre 2% et 3% des requêtes

Quelques remarques :

- depuis mars 2013, comme cela avait été annoncé, Google n'annonce plus les dates de mise à jour de son algorithme anti-spam Panda, même si officiellement il continue d'être mis à jour environ chaque mois. Mais il y a des exceptions comme cette fois-ci ou dernièrement en mai 2014 et en septembre 2014. Cela dit, ça devient très dur de continuer à croire à cette histoire de Panda intégré à l'algo, avec mise à jour mensuelle !

- on ne sait pas si Google a ajouté de nouveaux critères dans l'algorithme mais ça semblerait logique, sinon comment expliquer qu'ils aient attendu aussi longtemps et que le déploiement soit aussi long ? La communauté SEO l'a baptisé 4.2 plutôt que 5.0 ce qui laisse pourtant penser qu'il s'agit pas d'un simple data refresh (mise à jour des données)

- Google chercherait à brouiller les pistes (aux SEO) qu'il ne s'y prendrait pas autrement. En effet, en annonçant que le déploiement prendra des mois et que même si l'algorithme est sitewide (concerne l'ensemble du site), seules certaines pages peuvent être touchées (ou dans un premier temps ?), il sera extrêmement difficile de mener des analyses spécifiques à Panda. Je rappelle en effet que chaque jour l'algo peut changer (consultez ma liste des principales composantes de l'algorithme de Google). Par exemple, difficile de ne pas confondre Panda et Phantom !

Prestations pro

Audit de référencement spécial Panda

Si vous souhaitez l'aide d'un professionnel du SEO, je peux effectuer un audit détaillé, pour vous lister mes recommandations d'optimisation pour sortir de la pénalité.

Formation référencement : module incluant Panda

Ma formation contient évidemment (depuis 2011) une partie consacrée à Panda, dont voici le programme :

- Présentation et état des lieux (en France et ailleurs)

- Analyse des principaux critères utilisés par Google pour détecter les sites de mauvaise qualité

- Méthode pour savoir si votre site a eu une pénalité Google

- Conseils pour améliorer votre site maintenant que Panda est arrivé en France

Consultez le programme détaillé de cette formation Panda (filtre de l'algorithme Google).

Audit technique SEO : conseils Panda

Regardez cette vidéo (audit SEO sous l'angle Google Panda) pour apprendre comment étudier votre site avec RM Tech et trouver les corrections à apporter pour vous sortir de Panda :

Autres ressources WebRankInfo sur l'algo Panda

Explications audio

Jean-Olivier Pain, journaliste à la Radio télévision suisse (RTS), m'a demandé de répondre à quelques questions au sujet de Panda, l'algorithme de Google. Vous pouvez écouter l'extrait issu de l'émission "On en parle"...

Vous pouvez télécharger le fichier audio (7,3 Mo pour près de 8 minutes d'audio MP3) ou le retrouver en ligne sur leur site tant qu'il est encore accessible.

J'explique pourquoi Google a dû faire cette mise à jour, quels sont les types de sites qui ont été les plus pénalisés par les nouveaux filtres de l'algo, ce qui caractérise les fermes de contenus, etc.

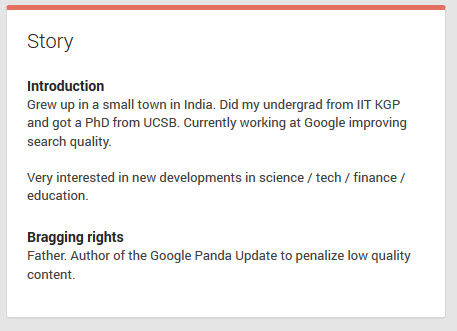

Brevet "Ranking Search Results" de Navneet Panda

Nous savions déjà que Panda était le nom de famille de l'ingénieur à l'origine de l'algorithme éponyme. Il apparait comme co-auteur d'un brevet attribué le 25/03/2014 à Google, intitulé "Ranking Search Results".

C'est bien entendu le spécialiste des brevets Bill Slawski qui a déniché l'info (il est spécialisé dans l'analyse des brevets attribué dans le monde des moteurs de recherche). Il explique d'ailleurs qu'en découvrant ce nouveau brevet, il a fait une capture d'écran de la section "Bio" du profil Google+ de Navneet Panda. En effet, ce bloc indiquait :

Auteur de la mise à jour Google Panda, destinée à pénaliser le contenu de mauvaise qualité

Suite à la publication de l'article de Bill, ce bloc a disparu de la bio de l'ingénieur de Google, ce qui confirme une fois de plus qu'il est effectivement l'auteur de l'algo. Il aurait peut-être dû rester plus discret...

Voici les informations concernant le brevet :

Ranking search results

Inventeurs : Navneet Panda et Vladimir Ofitserov

Attribué à : Google

US Patent 8,682,892

Attribué le 25/03/2014

Déposé le 28/09/2012

Si vous vous intéressez au référencement, vous devriez lire ce brevet ! Attention cependant, rien ne dit que ce brevet décrit même partiellement l'algorithme Panda. Et même si c'était le cas, il y a fort à parier que l'algorithme exploité actuellement par Google a changé par rapport au système décrit dedans...

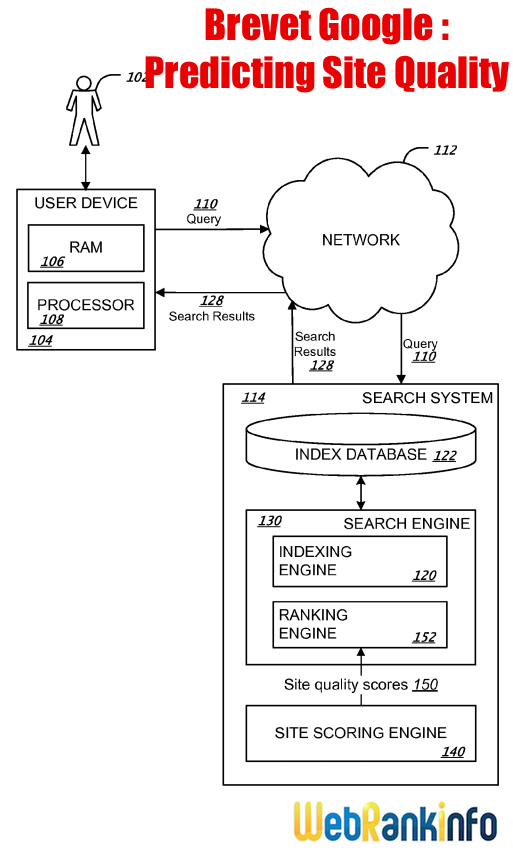

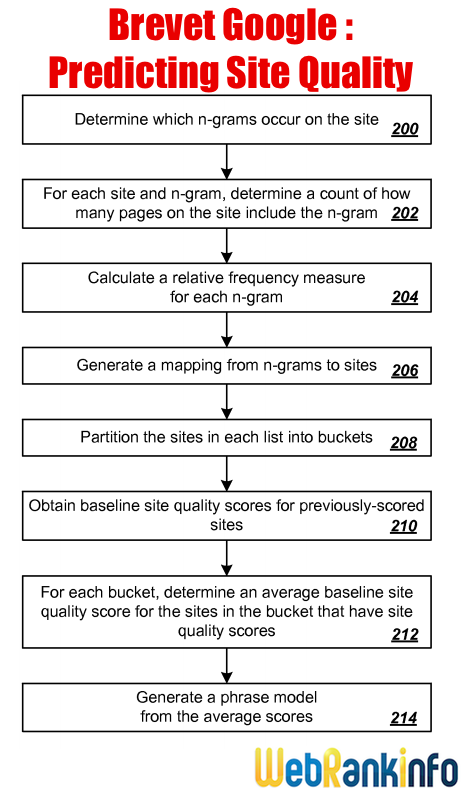

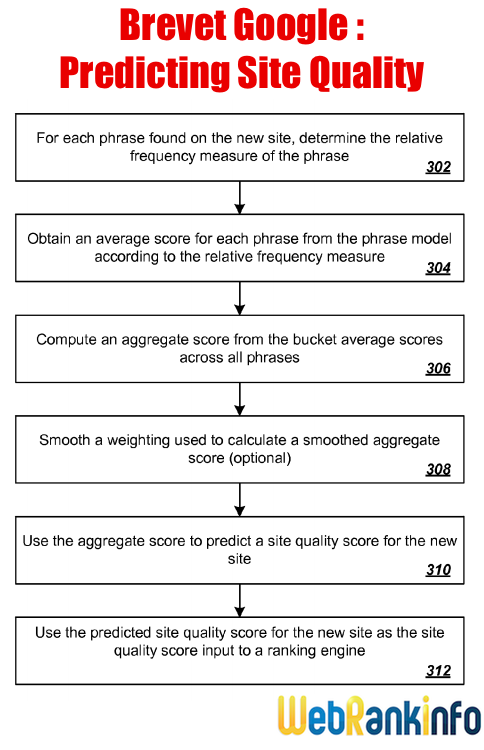

Predicting Site Quality, un brevet en relation avec l'algo Google Panda

Navneet Panda, l’ingénieur qui a conçu l’algorithme de Google permettant d’évaluer la qualité des sites, a obtenu un autre brevet le 18/09/2014. C'est une fois de plus Bill Slawski qui a déniché l'info et qui a résumé le brevet. Voici en gros ce que j'en ai compris :

- chaque page est décortiquée en fonction de ses mots et groupes de mots (en tenant compte de la ponctuation) : cela donne une série de n-grammes

- les textes des liens pointant vers chaque page sont considérés comme si c'était du texte présent sur la page (semble-t-il)

- calcul de la fréquence des n-grammes sur le site

- analyse de la qualité des sites (manuelle pour une sélection de sites au départ ?)

On ne sait pas précisément comment fonctionne l'analyse par groupes de mots, peut-être est-ce similaire à l'analyse par syntagmes en place depuis longtemps dans l'algo de Google.

En résumé, ce brevet montre que la répétition de mêmes phrases dans un site peut servir à analyser la qualité du site. Attention, on ne sais pas si ce brevet correspond vraiment à l'algo Panda tel qu'il est utilisé chez Google...

Voici les schémas inclus avec le descriptif du brevet...

Image 1 :

Image 2 :

Image 3 :

Références du brevet : "Predicting Site Quality" inventé par Yun Zhou et Navneet Panda, déposé le 15/03/2014 et obtenu le 18/09/2014 sous le n°20140280011 USPTO.

Sources des images : USPTO

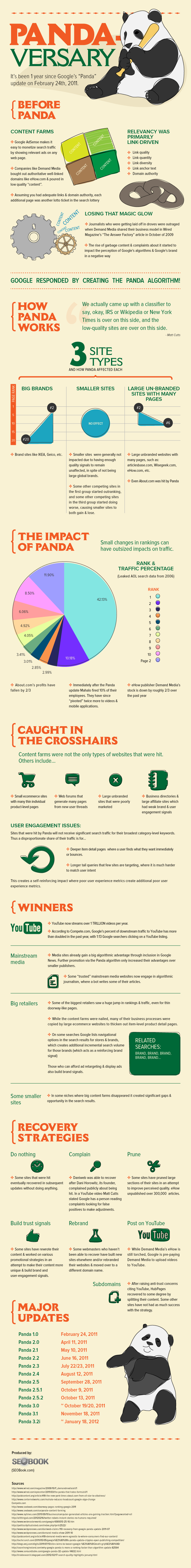

Infographies sur Google Panda

Pandaversary

A l’occasion du 1er anniversaire du filtre Google Panda (sorti le 24 février 2011), le site SEO Book a publié une infographie expliquant ce qu’est Google Panda et fournissant des conseils pour s’en sortir ou s’en prémunir, selon les cas…

L’idée de ce Pandaversaire est de lister ce qu’il faut retenir de Panda, 1 an après la sortie de la v1.

Je ne fais ici que résumer quelques aspects abordés sur cette infographie, n’hésitez pas à donner votre avis dans les commentaires…

Avant Panda...

C'était l'époque reine des fermes de contenus (content farms) :

- Avec AdSense on pouvait facilement monétiser le trafic issu du SEO.

- Des entreprises comme Demand Media ont massivement investi dans des sites comme eHow.com et les ont rempli de pages de contenu de faible qualité.

- A condition d'avoir suffisamment de notoriété sur l'ensemble du site, chaque nouvelle page mise en ligne était une opportunité de plus de gagner à la loterie de la recherche (via les moteurs).

Google a été contraint de réagir en créant l'algorithme Panda.

L'impact de Panda : différent selon les types de sites

- Globalement, les sites des grandes marques en ont largement profité, leur visibilité ayant été boostée avec Panda.

- Globalement, les gros sites avec plein de pages mais pas de marque connue ont été sévèrement touchés.

- Globalement, les petits sites ont pu s'en sortir sans être trop touchés, notamment parce que Google ne peut pas mesurer assez d'informations à leur sujet.

Quelques exemples :

- Les profits du site about.com ont chuté d'environ 60%

- 10% des employés du site mahalo.com ont été licenciés peu après la mise en place de Panda

- Le cours de l'action Demand Media a chuté d'environ 60% par rapport à l'année dernière (ce qui représente plusieurs centaines de millions de dollars de baisse pour sa capitalisation boursière).

- En Europe, près de 50 salariés ont été licenciés chez le comparateur de prix Twenga.

Les types de sites qui ont le plus souffert de Panda :

- Les fermes de contenus

- Les petits sites ecommerce avec plein de pages produit de faible contenu

- Les forums de discussion qui génèrent plein de pages pour chaque discussion

- Les sites avec plein de pages mais sans marque connue ni stratégie efficace de marketing

- les annuaires d'entreprises et gros sites affiliés avec une marque et des critères d'engagement de l'internaute faibles (pour comprendre ce point, lisez mon article sur l'impact du comportement de l'internaute dans le SEO)

Les gagnants : ceux qui ont profité de Panda

- Youtube : il n'y a qu'à voir les chiffres de sa croissance...

- Les grands sites média (d'ailleurs selon SEObook.com, certains média renommés commencent à tester de développer des logiciels qui écrivent des articles à la place des journalistes)

- Les grands sites marchands ont connu une forte hausse de trafic, y compris grâce à des pages de faible qualité, dans le même genre que celles (pénalisées) des fermes de contenus

- Certains petits sites de niche ont profité de l'effondrement des fermes de contenus

Les stratégies pour surmonter Panda

- Ne rien faire : certains sites ont eu la chance de remonter après Panda, sans avoir rien changé

- Certains ont testé de se plaindre publiquement à Google (par exemple Dani Horowitz de Daniweb)

- Supprimer de nombreuses pages de faible qualité : eHow aurait ainsi supprimé 300.000 articles. D'autres gros sites ont pu le faire avant l'arrivée de Panda en France, c'est le cas par exemple du site commentcamarche.net (lisez comment commentcamarche.net a anticipé Panda).

- Développer tous les aspects qui créent de la confiance, en retravaillant le contenu et en développant des stratégies de promotion pour rendre le contenu plus unique, bâtir une marque et renforcer l'engagement des internautes

- Changer de marque ou en tout cas de nom de domaine. Certains ont essayé avec les sous-domaines mais le succès n'est pas garanti.

L'infographie Panda

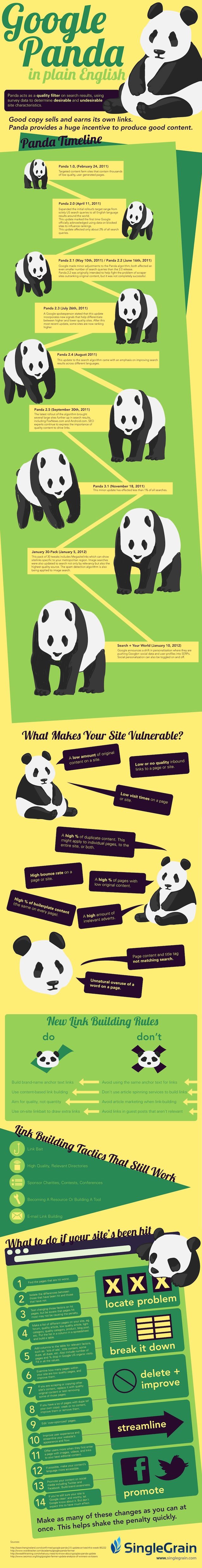

Infographie pour comprendre Google Panda

Ce qu'il faut retenir de Panda

Je ne fais ici que résumer quelques aspects abordés sur cette infographie, n'hésitez pas à donner votre avis dans les commentaires...

Quelques critères supposés que Panda pourrait sanctionner

Il s'agit des idées de SingleGrain (avec des liens vers mes articles qui expliquent les notions abordées) :

- faible quantité de contenu original

- faibles backlinks (ou de mauvaise qualité)

- faible durée de visite

- fort pourcentage de pages en duplicate content

- fort taux de rebond

- forte proportion de publicités

- rédaction qui ne semble pas naturelle

Des conseils sur les stratégies de liens

Voilà les idées de SingleGrain en termes de netlinking, n'hésitez pas à donner votre avis dans les commentaires...

- évitez d'avoir le même texte de lien

- évitez les services de spinning d'article pour obtenir des liens

- faites attention aux sites de publication d'articles (visez surtout la qualité)

- évitez les liens non pertinents dans les articles invités

Ce qui marche encore pour obtenir des backlinks avec Panda :

Là encore il s'agit des idées de SingleGrain, n'hésitez pas à donner votre avis dans les commentaires...

- linkbaiting

- annuaires de qualité pertinents

- sponsoring d'oeuvres de charité

- concours

- conférences

- création d'outils ou de contenu de référence

- recherches de liens par contact email

Comment faire pour sortir de Panda

Voici les idées de SingleGrain, vous avez sans doute les vôtres !

- Identifiez les pages de votre site qui ont le plus perdu (en référencement naturel Google)

- Repérez les différences entre les pages touchées et les autres

- Listez dans un tableau les types de pages de votre site et essayez d'indiquer dans les autres colonnes les caractéristiques de ces pages, en fonction des critères supposés de Panda décrits précédemment

- Mesurez combien il y a de pages de faible qualité sur votre site

- Améliorez la qualité des mauvaises pages ou supprimez-les

- Mettez à jour vos pages sur-optimisées

- Offrez davantage aux internautes qui arrivent sur votre site : images, vidéos et liens vers votre contenu éditorial riche

- Faites la promotion de vos contenus sur les réseaux sociaux (Facebook, Twitter) en ayant en tête de construire une marque

- Si vous avez entièrement nettoyé votre site, vous pouvez tenter d'en informer Google, même s'il vaut mieux ne pas trop en espérer de retours...

L'infographie :

Version HD : cliquez ici

Source : Single Grain

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Votre article est très intéressant, mon site "http://www.trotinettes.com" est pénalité: il tombe de de 1ère page à 5ème page de GOOGLE depuis MAI 2013, suivant votre conseille, j'ai remplié le formulaire de Google pour demander de ré-examiner, combien de tempe faut-il attendre pour un réponse de GG?

@olivier DUFFEZ : Désolé je réponds a ma requete du 12 mai.... JE n'ai pas vu la réponse. Il s'agissait (et il s'agit toujours) de la requete sur "aujourd'hui à nancy". Autrefois, nous avions plusiuers entrée. A l'heure où je réponds, deux entrée apparaissent lorsque que fais ma requete déconnecté à mon compte google (j'ai remarqué que déconnecté ou connecté, les résultats étaient différents)

EN tapant "aujourd'hui à Nancy", là où autrefois j'obtenais quasiment les même résultats que ceux évoqué ci-dessus), j'arrive en 2e position sans les sitelinks. Bizarre ou normal ?

Merci et désolé de ma réponse tardive

non il n'arrive plus il fera partie intégrante de l'algo :)

Alors, il arrive bientôt le prochain Google Panda ? :)

Quelle est la réelle efficacité de ce formulaire ?

Il y a également la possibilité d'utiliser au bas de la page des SERPs

"Envoyez nous vos commentaires" mais là aussi, je suis dubitatif....

@steph : si tu penses qu'un de tes concurrents ne respectent pas les consignes Google, tu as toujours la possibilité d'utiliser le formulaire de dénonciation google.

Personnellement depuis panda je gagne régulièrement des positions dans Google, sans doute parce que mes concurrents sont pénalisés ;)

Je vois toujours le site d'un des mes concurrents en tête de Google depuis des mois alors qu'il est rempli de pubs, répétition de mots clés, contenu pauvre et jamais actualisé, etc... J'avoue que je ne comprends pas car mon site ne remonte pas malgré tous mes efforts, décourageant !!

L'art de Gg est :

- d'en dire peu (donc tout le monde parle à sa place !)

- d'améliorer continuellement son algorithme Panda.

Du coup, il devient dangereux de trop s'éloigner des fondamentaux (richesse, utilité et unicité du contenu).

Concernant la répétition de mots clés au sein d'un même site, il est parfois difficile de faire autrement surtout si votre site a une seule thématique et que les synonymes sont inexistants. Dans ce cas, une solution est de créer du texte en image ;)

Je pense que l'adwords a quand même une influence sur le naturel.

Mon concurent en agence immobilière qui vient de démarrer avec une énorme campagne adwords est déja visible en naturel.Il n'aurait que du adwords.

Pour aller dans ton sens Anne, certains annuaires ont été en effet mis en valeur par la dernière mise à jour, plus exactement certains annuaires ont plutôt perdu de la puissance par rapport à d'autre.

La mise à jour pendant a affecter environ 10% des requêtes à peine, ce qui explique que les sites peu optimisés n'est pour la plupart pas été touché.

Concernant l'adwords, il n'a aucun impact à mon gout sur le naturel, pas directement en tout cas, car faire une campagne adwords et amener de nouveaux visiteurs sur son site peu entrainer via ces mêmes visiteurs des post sur des sites en faveur de votre structure si ils ont été agréablement servi par votre site.

en 2012, l'essentiel c'est varier son portefeuille de backlinks et également ne pas négliger les réseaux sociaux.

Le référencement dans google deviens de plus en plus complexe. L'algorithme mis en place par google ne permet plus un référencement à grande échelle.Google veut que le référencement d'un site soit le plus naturel possible, avec une attraction autour du site et non pas des backlinks obtenus avec un référencement intensif.

Le référencement naturel sera la priorité de google dans les années à venir . Il va falloir revoir tout la politique de référencement des sites internet ou blog.

Les mises à jour de panda se font de plus en plus fréquemment.

Pour tout les sites réglo il n'y a aucune raison de fliper devant ces mises à jour.

Petite erreur dans la mise à jour (panda 23 et non 22 ;))

Assez étrange en effet que certains annuaires aient (apparemment) été favorisés par Panda.

En revanche sur des sites "banals" moyennement ou peu optimisés, il me semble qu'en grande majorité il n'y a eu que très peu d'impacts par Panda et ses mises à jour.

Pour ce qui est de des questions de l'influence d'Adwords sur le référencement naturel, creusons plutôt côté de notre nouvel ami Google+ !

Tout d'abord, il serait intéressant que vous définissiez clairement ce que vous entendez vous, par preuve, car si vous attendez une dépêche officielle de GG, ou bien l'accès complet à son algo , avec en complément des aveux de ses équipes, c'est pas demain la veille. vous rêvez debout car effecitvement, ce genre de preuves n'est pas prêt de tomber du ciel.

De nombreux exemples existent pourtant, il y en a profusion, dès lors que vous consultez avec attention les résultats.

D'autre part, ne dit on pas, que l'argent, rend souvent aveugle ?

Si vous avez de véritables arguments, ne vous gênez surtout pas. Je suis favorable au débat .

Maintenant, vous pouvez néanmoins convenir du fait que votre position n'est pas des plus neutres.

Vous semblez faire l'erreur grossière de confondre causalité et corrélation. Ce n'est pas en regardant un (ou 10.000) exemples qu'on peut conclure à un lien de causalité.

Maintenant, me faire quasiment insulter sur mon propre site par un anonyme, désolé mais j'ai mieux à faire.

Cher Monsieur, votre avis sur le possible ou non avantage des sites plaçant du ad ...ense est on ne peut plus pauvre. Ce n’est pas très étayé.

Vous indiquez simplement, que vous ne pensez pas qu'il ait un avantage. C’est tout ?????

Il n'y a aucun argument. c'est pourtant ce que vous balancez à l’inverse, à ceux qui pensent le contraire.

Pourtant, pour le coup, il existe beaucoup d'éléments, qui montrerait à ceux qui se donnent la peine de voir, que des sites pauvres en contenu, voire intégralement copié collé sur d'autres sites , sont mieux positionnés que les véritables auteurs, dès lors qu'ils placent de la pub GG sur leur site.

Je ne vais pas ici même, lister ces sites. Cela les mettrait en défaut. Ce n'est pas le but. Il leur appartient de se comporter ainsi en copiant collant des contenus depuis d’autres sites dans le seul but d’afficher de la pub gg pour gagner de l’argent. C’est ce qui constitue en effet, la poubelle du web.

Mais la logique veut aussi qu'un site qui se trouve mieux classé dans les résultats de recherche et contenant la pub GG , augmente en conséquence les recettes du moteur. Vous ne pouvez contredire cet argument.

Aussi, comme il a pour habitude de mettre en avant ses propres services, il serait bien ridicule de penser que dans ce cas, qu’il n'avantagerait pas sa pub, et l'augmentation en conséquence de ses recettes publicitaires.

Quant à votre position, peut on la considérer comme " impartiale" dès lors que vous placez vous même la pub GG sur votre site. et que vous indiquez également faire des formations liées au positionnement sur ce même moteur.

La logique, là aussi, veut donc que vous le défendiez. Il vous permet de gagner de l'argent. Ce n’est pas neutre. Alors le raisonnement est pour le coup , paraît on ne peut plus clair.

Mais, si vous même , vous essayez d'observer les résultats , avec un regard détaché de ce que pourrait vous rapporter le moteur , vous verrez , vous aussi, croyez moi, les anomalies du classement, montrant les avantages de ses services, et notamment, celui évoqué ici.

Ce moteur n'est pas un saint. L'ignorez vous ? je pense que non

Convient t 'il alors de vous rappeler la pression qu'exerce ce moteur sur les médias français, les menaçant de les désindexer en cas de taxe.

Convient il de vous rappeler que le moteur possède son propre représentant à Bruxelles, pour faire du lobbying.

Est il judicieux d'indiquer le montant, que ce dernier doit au Fisc français.

Ou encore, convient il d'indiquer le nombre de condamnations à son encontre, que ce dernier n'a toujours pas à ce jour exécuté, et se félicitant presque de ne pas les honorer.

.......

.......

Je vous laisse le soin de compléter la liste. IL serait en effet intéressant d'observer le nombre de condamnations, d'abus, en complément du nombre d'acquissions. Le score pourrait être battu. On attend donc votre post, complet sur ce sujet.

Chacun a son point de vue et pour ma part je n'ai toujours vu aucune preuve des privilèges des sites AdSense/AdWords en SEO, aussi bien ici dans ces commentaires qu'ailleurs sur le web.

Mais puisque je suis jugé impartial, inutile que j'avance des arguments, ils seront rejetés...

Très intéressant comme dossier et très bon choix de thème!

Panda a été effectivement l’algorithme de google le plus actif et auquel cette firme a effectué beaucoup de changement!

Merci pour cet article sur les mises à jour Panda.

Je suis d'accord sur le fait que Panda a permis une amélioration des serp, pour autant on voit aussi que des cas posent problème et remettent en cause la légitimité de cette nouvelle politique de réf. A suivre donc...

c'est très clair , merci de votre réponse

ok Olivier , je me suis emporté et je ne peut rien affirmer, c'est juste que j'ai constaté à petite échelle que 2 de mes sites (5 ans et 6ans de boulot) et ceux de certains amis étaient positionnées bien après ceux qui avaient payés adword et qui n'avait que très peu de contenu avec une qualité qui laissait à désirer. Je n'ai pas la science infuse loin de moi , je fais juste une petite remarque et je viens de voir à l'instant en parcourant les articles que certains en ont fait la remarque mais bon .... Je sais que Google fait des effort en matiere de qualité de contenu mais y a t'il un sens pour tout le monde ou uniquement un plus pour ceux qui payent adword?

j'aimerais avoir votre opinion personnelle,

Cordialement

Ludovic

J'ai déjà donné mon avis il y a peu dans l'article sur le lien entre AdWords et référencement naturel : je pense qu'il n'y a aucun lien direct.

Laurie , ils doivent bien payer adword grassement et c'est la que l'on voit que le critère qualité de contenu laisse à désirer.

@advaloria : à quoi sert une telle accusation gratuite sans aucun fondement ni preuve ? pas au débat en tout cas.

y a un truc que je comprends pas. Y a des sites references dans le secteur du crédit ou rachat credit qui n'ont rien sur leur pages comme contenu et ils sont en 1ere page. Peux tu m'expliquer cela?

Bonjour,

Merci pour ce tuto.

@Olivier: peux tu STP me répondre sur cette question: comment s'avoir si google panda est lancé sur notre pays ou non (Tunisie) et a quel fréquence ?

Jusqu'au moment, on n'a rien remarqué sur le trafic de nos sites, tout semble encore naturel.

PS: Dans votre agende, y a-t-ils des conférences à organiser en Tunisie ?

Merci.

A ma connaissance, Google Panda est appliqué dans toutes les langues (ce n'est pas une histoire de pays mais de langues).

Aucune conférence n'est pour l'instant prévue en Tunisie. On a tenté de l'organiser mais c'est assez difficile depuis la France.

Merci pour cet article très complet sur les mises à jour Panda.

Je suis assez d'accord avec François, Panda a bien amélioré la qualité des SERPs même si l'algo n'a pas forcément touché que des mauvais sites. Beaucoup ont été pénalisés mais d'un autre coté cela ouvre un peu la concurrence.

Ca c'est dans tes reves.........

Hey ben ! Arrêtez de flipper avec Panda, si vous êtes réglo il n'y a aucune raison d'être attrapé par ce méchant algo :)

Bonjour.

Tout le monde a peur de ce Google Panda, un monstre. Il suffit d'être le plus naturel possible. Mais il est vrai que Panda veille de plus en plus

Je pense que globalement Panda a amélioré la qualité des SERP, même si la mise à jour a été très (trop ?) sévère avec certains sites.

@LaurentB : je ne pense pas que Google raisonne en terme de CPC ou autre indicateur qui reflète les revenus que peut générer une requête. Simplement, comme la concurrence est féroce pour ce type de requêtes, les sites qui créent peu de contenu ne remontent plus.

Toutefois on ne peut nier qu'il y a pour Google une volonté d'imposer Google Shopping qui fonctionne exactement comme les comparateurs que GG a tué. Si on lui appliquait Panda, Google Shopping disparaîtrait très rapidement des SERP...

@AnneCNGB : Oui, il y a un intérêt à traduire un contenu et le publier ! Les contenus traduits ne sont pas considérés comme des duplications par Google ;)

@kiamaru : C'est du côté de Pinguin qu'il faut regarder. Les échanges de liens sont à réaliser avec plus de précaution, par exemple éviter de réaliser des échanges 'sitewide'. Attention de bien lier également les thématiques pour les échanges de liens.

@ Detectimmobilier, je ne pense pas que les mises a jour panda et pingouin ont amélioré la pertinence des résultats sur google, car ces mises a jour ont touché principalement des pratiques d'ordres techniques ( DC , sur optimisation, backlinks ....) , mais question du contenu et de sa qualité, google est encore loin de donner de bon résultats.

Mais il faut avouer qu'on trouve du nouveau contenu par rapport a ce qu'on trouvait avant ces mises a jour.

Il semblerait qu'enfin, le moteur ait retrouvé une certaine pertinence au niveau des Serp's, à moins que tous les filtres aient été supprimés et qu'on soit revenu à une version de l'algo initiale.....

Les principaux types de sites spécialement ciblés par cet algorithme sont les fermes de contenus,Google Panda est censé aussi sanctionné le duplicate content, l'encyclopédie de commentcamarche.net est en libre accès et en libre reproduction.c'est vraiment une catastrophe.

@Olivier sur "... Les principaux types de sites spécialement ciblés par cet algorithme sont les fermes de contenus... annuaires d'entreprises ou locaux..." vrai pour les certains, pour nous, depuis le 05 Nov., c'est un up de +18,6% de visiteurs.

personnellement j'ai vu panda dans ses débuts comme une bonne chose pour le domaine du référencement même si certains sites sont injustement pénalisés, car certaines requêtes sur google qui étaient très compétitives et commerciales ne connaissaient plus un changement dans le top 30 même et cela a changé un peu avec panda, donc je me suis dis voila la concurrence est ouverte de nouveau, mais avec la multitude de ces mises à jour, google a vraiment bouleversé le trafic, on connait de plus en plus de changements sur le classement dans plusieurs requêtes et cela change comme un indice de valeur boursier, on aimerait bien que cela se stabilise mais on n'y peut rien car on est à la merci de google

Merci pour cet article bien complet cela permet de voir où nous en sommes avec ce panda.

Pour l'instant panda ne semble pas bien méchant pour les blogs classiques, à l'inverse du pinguouin dont le retour risque de faire encore plus mal... un peu comme gilette et ses x lames...

bientôt super pinguin 2 le retour... des news dessus Olivier ?

Non, pas d'infos sur Pingouin 2.0

bonjour

j'ai 10 boutiques en ligne. j'ai mis les liens de chaque boutique sur les autres. ce qui fait que chaque boutique a 9 liens sortants vers les autres et 9 liens entrant.

à la base c’était une même boutique mais les produits vendus étaient tellement différents (mode, livres, bijoux, dvd, coque téléphone etc.) et n'est pas amazon qui veut. cela brouiller pas mal de visiteurs.

il y'a 2 mois j'ai donc décidé de créer une boutique différent par catégorie

2 boutiques font chacune environs 1000 visiteurs par jours

et les 8 autres quelques centaines seulement

ça pose un problème à google ces liens croisés a savoir que ce n'est que des sites de vente avec plusieurs produits et catégories et pas seulement des simples sites avec une ou 2 pages.

merci

Difficile de généraliser, c'est très lié au(x) site(s) concerné(s)

Bonjour,

Les mises à jour de Panda ne se ressentent pas autant que ça contrairement à celles de Penguin. C'est peut-être parce que celui-ci est mise à jour un peu trop souvent!

Effectivement cet article est très complet!

Merci

Alexandra

impressionnant ! je pense bien que c'est l'article le plus complet sur Panda sur le net. merci olivier

Personnellement j'étais touché gravement avec perte de 80% de trafic j'ai refondu la presque totalité du site mais cela démontre aussi la dangerosité de la place dominante (voir abus de position?) de Google sur la recherche web.

Même retour d'expérience et ceux qui prétendaient ne pas avoir été touchés et/ou préconisaient un netlinking croissant, on ne les entend plus.....

Avec le recul et un bon paquet de sites traités, je n'ai personnellement pas encore vu un seul site récupérer sa présence pré-Panda.

Encore plus vicieux, on voit le site remonter, mais cet enfoiré de Google le garde bien éloigné des requêtes qui rapportent.

Bonjour

Je fais du SEO pour une boite anglaise, j'ecris et je publie des articles sur des directories de langue anglaise, mais je pourrais aussi les traduire et les publier en francais.

Je me demandais s'il y avait un quelconque interet a publier des articles sur des sites etrangers ?

Merci.

Anne

Le probleme de panda c'est qu'il est très coriace puisqu'il y a presque chaque mois une mise à jour, fini les beaux temps du SEO..

J'ai beaucoup lu et entendu sur ce fameux panda, mais maintenant je comprend bien mieux les tenants et les aboutissants. Je vois en tous cas que cela n'a pas commencé hier..et que ce n'est pas prêt de finir non plus...

Bonsoir Olivier,

impressionnant un article aussi complet, obligée de le marquer pour y revenir !!! Pas toujours évident de comprendre tous les points lorsqu'on débute O_o

Merci pour cet article, je suis en plein dans les débuts du référencement de mon site et j'aimerais ne pas faire n'importe quoi...

J'ai peur de l'ogre Google ... Merci

@François : Tu sors encore sur la recherche "vente stickers décoration", c'est que tout n'est pas perdu... Il faut souvent attendre plusieurs jours pour être certain d'avoir été bannis de google ! Es-tu certain que ni toi ni d'autres personnes de ton équipe n'aient fait de référencement un peu border-line ? Si c'est le cas, tu peux essayer d'effacer tes dernières actions et attendre, dans tous les cas, la patience est de mise !

@Olivier : en faisant cette recherche, je viens de découvrir l'absence des +1 sur les résultats de recherche, remplacés par "Partager"...

En effet, le +1 est remplacé par Partager, ce qui semble presque plus logique

Bonjour à tous,

Alors que je lis vos commentaires relatifs à Google Pingouin, pour comprendre ce qui arrive, j’avoue buter sur vos compétences en matière d’analyse de ce moteur, car rien de ce que je découvre ne répond à mon souci. Leader depuis 2008 de la décoration enfants, mon site vient de disparaître des écrans radar de Google (alors que tous les autres petits moteurs le mettent toujours en première page, pour cause du plus grand choix de déco murale enfant). La gamme est unique, les licences très demandées, rares aussi, et je viens d’être éliminé de Google. Je ne fais jamais de racolage email, ni de pub sur le site, ni de lien douteux, c’est ce qu’on appelle un site propre. Comme quoi. En revanche quand je tape l’un de mes produits sur Google, apparaissent désormais des sites étrangers, des généralistes, des comparateurs et parfois des sites inconnus dont le lien est répétés jusqu’à 10 fois de suite, le mien ne sort plus. Il semble que ce moteur ait éliminé les spécialistes pour cause de mot répétitifs, forcément, une petite boutique n’a qu’un seul genre de produit, un libraire va mettre « livre » à toutes les lignes, un magasin de jouets en bois, ce sera le mot « bois ». D’ailleurs je note que mes concurrents habituels ont également disparu pour certains. Les sites trouvés par Google ne sont pas concernés par ce type de produit, ou alors de très loin. Amertume de subir sans comprendre, et d’avoir devant soi, deux mois de survie avant le dépôt de bilan.

François Debout

Est-ce que les pages en erreur 404 sont considérés comme des pages "pauvres" en contenu et sont alors la cible du panda ?

Mon site contient près de 5500 pages en 404 suite à la suppression de mon forum :s

@Emmanuel : il n'est jamais bon d'avoir de nombreuses erreurs 404, surtout pour l'internaute ! Mais pour répondre à ta question, si une page est en 404, elle est inaccessible, donc par définition on ne peut pas parler de son contenu. Donc pas de rapport avec Panda.

Cela dit, si tu supprimes un forum, il ne faut pas que ça génère des 404, il faut rediriger (en 301) vers une page pertinente. Ou alors faire désindexer tout le forum d'un seul coup (via le fichier robots.txt et une demande faite sur Google Webmaster Tools). Mais cette dernière solution n'est pas la meilleure car il restera des internautes qui tomberont sur l'ancien forum et auront des messages d'erreur 404.

Bonjour,

Entièrement d'accord avec Lionel sur ce point précis

Bonjour,

On oublie souvent de le signaler mais je pense qu'il faut concevoir un site destiné à convaincre les visiteurs afin que ce premier remplisse les objectifs de conversion fixés.

Le référencement doit ensuite s'effectuer par une optimisation mesurée "on site", un netlinking intelligent s'appuyant sur des sources diverses proposant des ancres variées et un travail de fond sur la notoriété du domaine.

Dans ce cas, "Pingouin", "Panda" ou autres filtres Google ne pénaliseront jamais un site Web.

amicalement

Bon je n'ai encore rien vu pour cette dernière mise à jour, pourtant j'ai souvent des liens pas forcément très propres (en même temps c'est "naturel" ;-)). Je pense que je vais faire tout de même de plus en plus attention. Restera toujours la marotte de beaucoup (dont Olivier non?): la longue traîne! Les rédacteurs ont de beaux jours devant eux.

nb: Il y a une coquille sur le lien pour l'infographie "SeachEngineLand.com", il manque le "r" :p

Bonjour, je ne comprends pas si c'est à cause de cet annuaire que j'ai ajouté ou de google panda, mais j'ai chuté de quelques pages sur les mots clés principaux.

Est-ce qu'un annuaire avec lien retour quasi obligatoire sur un sous dossier du domaine peut être plus pénalisant qu'avantageux ?

Ou est -ce que du fait que le site apparaisse sur des mots clés hors sujet ( de sites inscrits dans l'annuaire ) fait diminuer la position sur les mots-clés principaux ?

Ton problème ne serait-il pas lié à Pingouin et aux backlinks sur-optimisés que tu t'offres ?

pour ma part je n'ai pas senti de changements depuis google penguin

par contre la mise à jour du 8 juin je l'ai très fortement senti sur de nombreux sites c'était assez impressionnant

je pense qu'il s'agit vraiment d'une mise à jour majeure quoi que google en dise, j'ai des stats de sites très bien positionnés sur de grosses requêtes et c'est la seule mise à jour qui a vraiment complètement changé les résultats

Depuis qq tempsvlorsquon fait une recherche avec simplment le nom de domaine il n y a plus qu un seul resultat sobre la ou auparavant google ressortait plusieurs pages du site. Google allait meme a ressortir des liens issus du plan de mon site. C est terminé. Est ce de ma faute? une chose est certaine ca correspond a qq jours pres a la date de sortie de panda.

@slhuilli : je n'ai pas remarqué de disparition des sitelinks, c'est pour quelle requête ?

Je n'ai pas trouvé les nouveautés liées à Panda 3.7, c'est juste le chiffre qui change ?

Aucune info n'a été fournie par Google, autre que le fait qu'il s'agit d'un data refresh

Personne n'a ressenti de mouvements ver le 27 mai ?

J'ai un site impacté par Panda en Mars qui tourne à +50% depuis deux jours.

J'ai du mal à comprendre pourquoi Google pénaliserai les agrégateurs qui parfois sont légitime.

Google Panda ou la plus grande usine à gaz de tout le 20ème siècle en matière d'informatique (un peu hyperbolique dans le fond). Le seul résultat que ce nouvel algorithme à donner c'est l'augmentation des sites de faible contenu tel que Ehow, Answers.com et autres...

N'est ce pas un peu paradoxal pour une mise à jour sensée les stopper?

Je pense aussi que les webmasters deviennent de plus en plus dépendant du géant américain, chacun se met à trembler à la moindre annonce de mise à jour et commence à modifier l'intégralité du contenu de leurs pages, c.f. Ehow qui a supprimé 120'000 articles de faible contenu à l'annonce de Google Panda. Il serait temps de penser à se tourner vers une alternative, malheureusement, personne n'en propose (bing? Jamais réussit à tomber sur un résultat voulu après plusieurs tentatives d'utilisation).

@ATYQ : A part Panda 1.0, les autres ont malgré tout largement diminué le trafic des fermes de contenus...

Pourquoi une mise à jour sur WRI avec des POSTS datant de 2011 (c'est juste une constatation). J'avoue être plutôt réfractaire aux espèces de technologies ...

On résume les trois gros (je refuse systématiquement les demandes des autres et j'en recoit un paquet). Vais peut-être semblé méchant:

1. Face book, une liste de messages plus ou moins longs (le longs est acceptés) avec un paquet de conneries .. dans une news sur mon site j'ai largement donné mon opinion sur la méthode de Facebook pour récupérer des visiteurs ... Sur mon nom, j'étais (via Facebook ami avec tous les gros politiciens socialistes - Français et belges (je sais, je suis belge ... mais pas blonde quand même). Et finalement un paquet d'"amis" qui vous annoncent qu'ils ont pas trop envie de travailler aujourd'hui (cui*te, pas envie, le collègue me fait chi*er , mon supéri*eur est un co*).

2. Twitter (j'ai suivi pour le plaisir le compte d'Olivier), une liste de liens avec quelques mots pour camoufler l'ensemble (et pas que pour Olivier).

3. Google +, le pendant de Google nettement en dessous des autres (pour une fois que Google est derrière). Entre Twitter et Facebook. Plus difficilement compréhensible ... Pour les deux premiers, mettre un petit texte est finalement à la portée de tout le monde, Google + j'ai du réfléchir à deux fois.

Et les référenceurs sont persuadés que les 3 sites sociaux sont des sources de référencements? Ou sont en train d'essayé d'expliqué qu'une partie (parfois importante, je le conçoit) du référencement DOIT être basé sur ces trois sites puisqu'elle apporte des visiteurs

Le référencement, c'est des visiteurs. Pas l'inverse (ou j'ai rien compris depuis 8 ans): le nombre de visiteurs ne positionne pas une page.

[citation]

Qu'en sera t-il des communiqués de presse qui poussent comme des champignons et qui peuvent aussi être considérés comme des intermédiaires.[/citation]

Le problème des intermédiaires est souvent lié à du duplicate content. Prend 10 personnes pour faire des articles ca va passer, à 2-3, à la longue, ca va fatiguer et on va juste changer quelques morceaux de phrases.

[citation]

Qu'en est -il aussi des blogs proposant des commentaires "auto-approuvés" contenant des centaines voire des milliers d'OBL ?

[/citation]

Par expérience (Google, les autres quasiment pas ... il n'en reste finalement plus qu'un autre), met n'importe quel article en ligne avec la possibilité de mettre des commentaires "approuvés", met tes propres commentaires avec des pseudo bidons et la page passe nettement mieux. Pourtant, je pense que GG a retenu la leçon, probablement Panda a modifié le tir et il était temps.

Panda est un changement d'algo, ca ne supprime pas (plus) les sites spasmeurs ... https://www.webrankinfo.com/forum/t/google-panda-1-maj-par-mois-les-sous-domaines-sont-aussi-touches-seocampus.152499/#p1359036 et où sont passés les 300.000 VU journaliers de comment ca fonctionne? Comment ca ... n'est pas forcément spasmeurs, ils ont juste fait un bon référencement (structure de site - lien) en tenant compte des faiblesses d'il y a 2-3 ans (avec du contenu, on peut pas le nier).

Personne n'a de solutions pour GG Panda et les petits comme les gros imaginent des solutions. Si le référencement passe par les réseaux sociaux, pourquoi créer des sites?

Vais quand même reprendre un jour mais bro*ls de sites pour essayer de comprendre ce qui se passe, y compris les trois plus gros "trucs sociaux", disons publicitaires sans fantasmer sur les retombées "moteurs de recherche".

J'avoue ne pas avoir bien compris ton commentaire...

Bonjour Olivier,

Effectivement, les BL spontanés et ceux provenant des réseaux sociaux (malgré les création en masse de profils) peuvent être des critères de pertinence pour attribuer des positions.

amicalement

Bonjour Olivier,

Qu'en sera t-il des communiqués de presse qui poussent comme des champignons et qui peuvent aussi être considérés comme des intermédiaires.

Qu'en est -il aussi des blogs proposant des commentaires "auto-approuvés" contenant des centaines voire des milliers d'OBL ?

amicalement

Je ne suis pas "devin" ! Mais en effet on peut craindre qu'ils soient mal vus par Google, en tout cas tous ceux qui n'ont par réussi à se créer une notoriété. Par exemple tous ceux dont l'écrasante majorité du trafic vient du SEO sans connotation de marque, qui ne reçoivent pas de BL spontanés, qui soient peu partagés sur les réseaux sociaux.

L'avenir nous le dira !

Bonjour, je constate une forte chute de mon ref naturel depuis quelques semaines (environ 4/5) et je ne trouve aucune explication. Quelqu'un pourrait il m'aider - m'orienter ? Merci.

Quand je lis tous ces commentaires, je me rend compte que le sujet est toujours aussi flou : personne ne dit la même chose.

Ce que j'ai remarqué c'est que ma fréquentation baisse quand je laisse mon site sans nouveau contenu ou nouveau référencement.

Comme je fais les deux en même temps c'est difficile de savoir ce qui rapporte le plus.

Merci pour cette synthèse chronologique de Panda.

Pour ma part je ne pourrai comparer le PR de mon site que lors de la prochaine évolution puisque mon site n'a que 15 jours :)

J'ai eu une importante modification des positions de mes mots clés dans la nuit du 27 au 28 (43 mots clés sur 130). C'est peut-être le Panda 3.3 annoncé.

Et une version Panda de plus !

Merci pour l'info en temps réel !

J'ai du mal à comprendre pourquoi Google pénaliserai les agrégateurs qui parfois sont légitime. On pénalise un site pour nous faire aboutir à en consulter 10 de suite pour obtenir la même information. C'est un peu nul. Tous les agrégateurs de contenu ne peuvent pas être de mauvais liens.

Ce qui est tout de même étonnant avec le recul nécessaire, c'est de constater précisément que Google accorde à des pages type "ferme de liens", un crédit et une pertinence encore non négligeables.