Des chercheurs de Microsoft ont indiqué avoir mis au point un algorithme intitulé BrowseRank, permettant de mesurer l’importance d’une page sur le web. Contrairement au célèbre PageRank de Google qui, dans sa version initiale, ne se base que sur la présence de liens entre les pages, le BrowseRank tient compte aussi du trafic généré par ces liens ainsi que du temps passé par les internautes sur les pages.

Les avancées techniques du BrowseRank

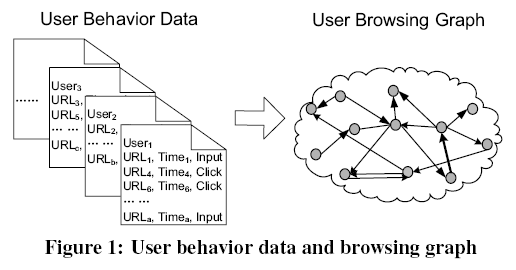

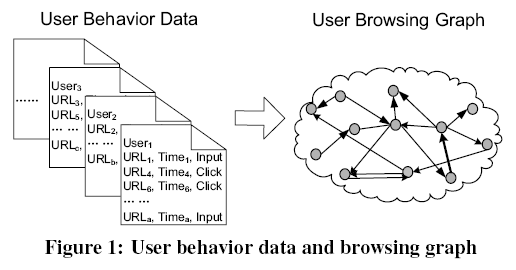

Pour développer leur algorithme, les chercheurs de Microsoft Research Asia (Bin Gao, Tie-Yan Liu et Hang Li) sont partis de la faiblesse des modèles de calcul de popularité basés uniquement sur le graphe des liens entres les milliards de pages que constituent le web. Ils expliquent que ces modèles (dont le plus célèbre représentant est certainement le PageRank) ne représentent pas assez bien la réalité, puisqu’ils ignorent le comportement des internautes. Le Browse Rank est donc un indice d’importance d’une page calculé à la fois à partir du maillage de liens mais aussi des clics sur ces liens, et du temps passé sur les pages d’arrivée :

Illustration du BrowseRank (image tirée de l’article publié par les chercheurs)

Comment Microsoft récolte les données nécessaires au BrowseRank

D’un point de vue pratique, l’algorithme du BrowseRank nécessite l’accès à des données issues du surf des internautes. C’est chose possible avec les barres d’outils que proposent la plupart des grands moteurs de recherche (MSN/Live dans le cas présent mais aussi Google ou Yahoo). Les utilisateurs de ces barres d’outils ont sans doute oublié qu’ils ont accepté de transmettre aux moteurs des informations sur les pages qu’ils visitent, mais ils sont pourtant des millions à fournir ainsi en permanence ces données.

Bien entendu, pour des raisons de confidentialité, les données personnelles ne sont pas exploitées par le BrowseRank ; d’ailleurs elles ne sont pas vraiment nécessaires.

Performances du BrowseRank

D’après les chercheurs, leur algorithme est plus performant que le PageRank et le TrustRank, aussi bien pour aider un moteur de recherche à classer les pages par pertinence que pour identifier le spam. Ils ont effectué des tests sur un échantillon de 10.000 sites web, que des utilisateurs ont analysé pour indiquer s’ils les considéraient comme du spam ou pas. Au passage, si quelqu’un peut m’expliquer comment ces chercheurs peuvent calculer le TrustRank, je suis preneur ! Cet algorithme utilise en effet une sélection manuelle de sites jugés comme étant absolument dignes de confiance aux yeux des moteurs ; 2 calculs du TrustRank basés sur des listes différentes aboutiront forcément à des valeurs différentes de TrustRank…

Sans surprise, les sites qui obtiennent les meilleurs scores de BrowseRank sont des sites populaires du web 2.0, sans doute à cause du temps que les internautes passent dessus (au top : MySpace, YouTube, FaceBook).

Le BrowseRank est-il déjà exploité ?

MSN/Live utilise-t-il déjà le BrowseRank ? C’est sans doute encore un peu tôt, d’autant plus que des améliorations doivent encore être apportées :

Google et son PageRank sont-ils dépassés ?

Toujours d’après ces chercheurs, même les versions les plus évoluées du PageRank sont dépassées par leur algorithme. Ils citent deux versions qui se rapprochent du BrowseRank :

A propos des auteurs

Tie-Yan Liu semble être indiqué comme l’auteur principal de cet article (le PDF ne semble plus disponible, j’ai enlevé le lien : BrowseRank: Letting Web Users Vote for Page Importance). Il est chercheur au centre de recherche de Microsoft à Pékin, il travaille actuellement dans le secteur de la recherche web.

Tie-Yan Liu semble être indiqué comme l’auteur principal de cet article (le PDF ne semble plus disponible, j’ai enlevé le lien : BrowseRank: Letting Web Users Vote for Page Importance). Il est chercheur au centre de recherche de Microsoft à Pékin, il travaille actuellement dans le secteur de la recherche web.

Les avancées techniques du BrowseRank

Pour développer leur algorithme, les chercheurs de Microsoft Research Asia (Bin Gao, Tie-Yan Liu et Hang Li) sont partis de la faiblesse des modèles de calcul de popularité basés uniquement sur le graphe des liens entres les milliards de pages que constituent le web. Ils expliquent que ces modèles (dont le plus célèbre représentant est certainement le PageRank) ne représentent pas assez bien la réalité, puisqu’ils ignorent le comportement des internautes. Le Browse Rank est donc un indice d’importance d’une page calculé à la fois à partir du maillage de liens mais aussi des clics sur ces liens, et du temps passé sur les pages d’arrivée :

- plus il y a d’internautes qui sont arrivés sur une page en ayant cliqué sur un lien, plus cette page est importante

- plus ces internautes sont restés longtemps sur cette page, plus elle est importante.

Illustration du BrowseRank (image tirée de l’article publié par les chercheurs)

Comment Microsoft récolte les données nécessaires au BrowseRank

D’un point de vue pratique, l’algorithme du BrowseRank nécessite l’accès à des données issues du surf des internautes. C’est chose possible avec les barres d’outils que proposent la plupart des grands moteurs de recherche (MSN/Live dans le cas présent mais aussi Google ou Yahoo). Les utilisateurs de ces barres d’outils ont sans doute oublié qu’ils ont accepté de transmettre aux moteurs des informations sur les pages qu’ils visitent, mais ils sont pourtant des millions à fournir ainsi en permanence ces données.

Bien entendu, pour des raisons de confidentialité, les données personnelles ne sont pas exploitées par le BrowseRank ; d’ailleurs elles ne sont pas vraiment nécessaires.

Performances du BrowseRank

D’après les chercheurs, leur algorithme est plus performant que le PageRank et le TrustRank, aussi bien pour aider un moteur de recherche à classer les pages par pertinence que pour identifier le spam. Ils ont effectué des tests sur un échantillon de 10.000 sites web, que des utilisateurs ont analysé pour indiquer s’ils les considéraient comme du spam ou pas. Au passage, si quelqu’un peut m’expliquer comment ces chercheurs peuvent calculer le TrustRank, je suis preneur ! Cet algorithme utilise en effet une sélection manuelle de sites jugés comme étant absolument dignes de confiance aux yeux des moteurs ; 2 calculs du TrustRank basés sur des listes différentes aboutiront forcément à des valeurs différentes de TrustRank…

Sans surprise, les sites qui obtiennent les meilleurs scores de BrowseRank sont des sites populaires du web 2.0, sans doute à cause du temps que les internautes passent dessus (au top : MySpace, YouTube, FaceBook).

Le BrowseRank est-il déjà exploité ?

MSN/Live utilise-t-il déjà le BrowseRank ? C’est sans doute encore un peu tôt, d’autant plus que des améliorations doivent encore être apportées :

- ils doivent tenir compte du nombre de mots et du poids des fichiers annexes à la page HTML afin de normaliser les durées

- ils doivent trouver une solution à l’absence de données de navigation sur les pages les moins populaires du web (pour lesquelles seul un algorithme conventionnel basé sur le maillage des pages est utilisable).

Google et son PageRank sont-ils dépassés ?

Toujours d’après ces chercheurs, même les versions les plus évoluées du PageRank sont dépassées par leur algorithme. Ils citent deux versions qui se rapprochent du BrowseRank :

- PageRank UBG : une sorte de PageRank pondéré calculé à partir de données de navigation des internautes

- Naive BrowseRank : une version basique du BrowseRank, obtenue en faisant le produit du nombre de clics (sur les backlinks) par le temps moyen passé sur la page.

- les liens qui génèrent du trafic ont plus de poids que les autres (d’où la moins bonne efficacité des liens en pied de page)

- les liens issus de pages de thématique proche ont plus de poids que les autres

- les données de la barre d’outil de Google peuvent être utilisées, que ce soit pour des calculs de taux de rebond ( »bounce rate ») ou de temps de visite de chaque page)

A propos des auteurs