Google pourrait tenir compte des relations entre les sites pour le poids des backlinks

On le sait déjà depuis longtemps, l'époque où la simple formule mathématique du PageRank régissait la partie off-page du référencement Google est dépassée. De nombreuses autres caractéristiques des liens sont prises en compte, comme je le détaille dans mon guide du netlinking (position du lien dans la page, nofollow, etc.). Google a obtenu en août 2010 un brevet intitulé Determining quality of linked documents, attribué à 3 de ses plus grands ingénieurs. Dans l'analyse de l'apport des backlinks pour le référencement d'un site, leur système tient compte des relations entre les sites. En résumé, mieux vaut obtenir des liens depuis des sites avec lesquels vous n'avez aucun rapport (hormis la thématique éventuellement) plutôt que vos autres sites ou ceux de vos amis. Explications...Un backlink aide plus ou moins pour le référencement

Aux débuts de Google, en termes de référencement, l'impact d'un lien d'une page A vers une page B dépendait uniquement du PageRank de la page A ainsi que du nombre de liens sortants de la page A. On avait donc compris que pour réussir, il fallait obtenir le plus de liens possible, issus de pages populaires (fort PR) et ne faisant pas "trop" de liens sortants.Depuis, Google n'a cessé d'améliorer son algorithme en rajoutant des critères, pour affiner cette analyse. En résumé, certains liens aident plus que d'autres, même s'ils ont un PageRank plus faible. Par exemple, il vaut mieux un lien avec un bon texte cliquable qu'un lien du style "Cliquez ici". J'ai rédigé un dossier sur les critères de qualité des backlinks, que je détaille en formation netlinking.

Un nouveau brevet Google sur l'analyse des backlinks

Le 24 août 2010, Google a obtenu un brevet déposé 6 ans plus tôt : Determining quality of linked documents (n°7 783 639). Les auteurs sont trois pointures de chez Google :- Krishna Bharat : créateur de Google News et pas mal d'autres produits Google

- Amit Singhal : le directeur du département Qualité du moteur de recherche

- Paul Haahr : inventeur de nombreux algorithmes et brevets, par exemple l'analyse des dates de création des documents, la détection des mots vides de sens (stopwords), les systèmes de Query Refinement (affinage/enrichissement des requêtes)

Le principe du brevet en quelques mots

Je vais vous résumer l'idée de ces 3 chercheurs : les plus courageux d'entre vous iront lire la source en anglais sur le site de l'USPTO ou son résumé (toujours en anglais).

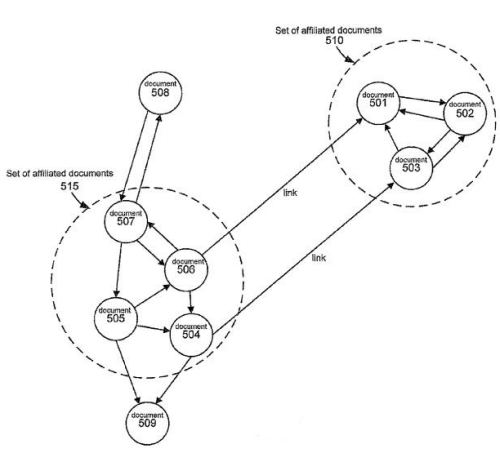

Dans l'analyse du maillage entre toutes les pages du web, le moteur de recherche tente d'estimer le type de relation qui existe entre les pages ou les sites reliés. En anglais on emploie le terme "affiliated pages" mais j'ai préféré éviter le mot "affiliation" sinon le public français aurait confondu avec le principe de l'affiliation (rétribution d'un affilié pour avoir apporté une visite ou une vente chez l'affilieur). J'utiliserai parfois en remplacement le mot "associé".

Plus les pages sont perçues comme étant proches, moins le lien a d'impact pour le référencement de la page de destination. Par exemple, si 10 pages d'un même site font un lien vers une page A, le poids de ces liens ne sera pas égal à 10 fois celui d'un seul lien (le poids sera inférieur).

Dans quels cas Google estime-t-il que les pages sont proches, c'est-à-dire que leur relation n'est pas si indépendante que ça ? C'est ce que nous allons voir maintenant.

Les critères analysés pour étudier la nature du lien entre pages ou sites

Le maillage (entre pages et sites)

Ne croyez pas que si vous faites un échange de liens triangulaire ou circulaire, Google n'est pas capable de comprendre qu'il s'agit de liens échangés (pour le référencement). Google n'analyse pas seulement les liens au niveau page mais aussi au niveau site Internet.Si 2 sites sont très interconnectés (en tout cas plus que la moyenne que Google détermine sur des millions de sites), alors les liens qu'ils se font auront sans doute moins de poids.

Quelles conséquences ?

- les échanges massifs de site à site ne sont pas efficaces (sitewide links : blogroll, footer, etc.) : si votre partenaire vous met un lien vers votre site sur chacune de ses 1000 pages, pensez-vous vraiment que ce soit compté comme 1000 "votes" ? Certainement pas, on peut même dire que dans ce cas, à partir d'un certain niveau, ça ne sert plus à grand chose d'obtenir d'autres liens.

- il est très intéressant d'obtenir un lien depuis un site qui ne vous avait encore jamais fait de lien. Ce type de lien sera sans doute pas ou peu considéré par Google comme "affilié" à votre site.

Les données de trafic

Des pages ou des sites visités par les mêmes internautes au cours d'une même session peuvent être considérés comme "associés".Google peut déterminer ce genre d'informations à partir des données récoltées pendant les requêtes sur son moteur, ou par d'autres moyens (barre d'outils, cookies de publicité DoubleClick, comptes Google, etc.). Si ce sujet vous intéresse, voyez comment Google agrège des données dans Google Ad Planner.

Les données liées à l'hébergement des sites

Des pages ou des sites ayant le même nom de domaine ou sous-domaine peuvent être considérés comme "associés".Des pages ou des sites hébergés sur des serveurs ayant la même adresse IP peuvent être considérés comme "associés". Cet aspect est assez controversé car Google ne peut pas pénaliser les sites hébergés sur un serveur mutualisé (qui partagent la même IP avec des centaines ou milliers d'autres sites). Google exploite peut-être ce critère dans les cas extrêmes.

On pourrait citer également l'analyse de la classe C de l'adresse IP (c'est-à-dire les 3 premiers nombres de l'adresse IP).

Ce qui suit ne fait pas partie des critères mentionnés par le brevet.

Les données liées à la chronologie des liens

Imaginons un petit futé qui publie sur plusieurs sites plusieurs articles intégrant des liens vers son site. Certes, il a pensé à rédiger des articles inédits pour éviter de tomber dans les problèmes de contenus dupliqués. Certes, ces sites de publication de communiqué de presse ou autres articles ne sont pas reliés entre eux.Mais pensez-vous vraiment que Google, qui associe une date à tout ce qu'il étudie, ne va pas se rendre compte que dans un laps de temps assez court, plusieurs sites indépendants font le même genre de liens vers un même site ou (pire !) une même page ?

Cela dit, Google doit démêler ce genre de pratiques du buzz ou des simples citations ou retweets...

Autres données

On rentre un peu plus dans les hypothèses :- deux sites qui utilisent le même compte Google Analytics peuvent être considérés comme "associés"

- deux sites qui utilisent le même compte Google AdSense peuvent être considérés comme "associés"

- deux sites qui sont déclarés dans Google Webmaster Tools avec le même compte Google peuvent être considérés comme "associés"

- deux sites dont les données WHOIS de leur nom de domaine ont en commun la même personne peuvent être considérés comme "associés" (cela dit, Matt Cutts a toujours dit que Google n'utilise pas les données du WHOIS, même si Google est un registrar officiel)

Attention aux mauvaises interprétations de ce brevet

Certains pourraient croire que les liens entre pages ou sites "trop associés" sont pénalisants (pour le site de destination). J'ai plutôt l'impression qu'il y a dans l'algorithme de Google une sorte de plafonnement, de capping : à partir d'un certain point, obtenir des nouveaux liens d'une page ou d'un site donné n'aide plus le référencement.En d'autres termes, si vous avez plusieurs sites, ou bien la possibilité d'obtenir plein de liens depuis un site partenaire, faites-le si cela présente un intérêt pour votre site (amener des visiteurs, des clients potentiels, etc.). Et ne vous en faites pas si ces liens n'apporteront rien au référencement.