En résumé :

- Plusieurs fois par an, Google modifie fortement son algo au cours d'une Core Update

- L'impact est parfois considérable sur la visibilité des sites dans Google, donc le trafic (et le chiffre d'affaires)

- Je vous offre un ebook (+ vidéo) détaillé pour remonter en cas de chute

- Je détaille ma méthode pour améliorer votre site et profiter des Core Updates

Accès rapide : définition de Core Update - que faire après un Core Update ? - liste des Core Updates Google

Cet article a été mis à jour suite à la dernière Core Update de Google. Annoncée le 30 juin 2025 par Google, son déploiement pourrait durer environ 3 semaines (source). Pour l'instant, aucun détail n'a été fourni sur les spécificités de cette dernière mise à jour.

C'est quoi une Core Update Google ?

Définition de Core Update Google

Une Core Update Google est une mise à jour principale de son algorithme de classement des résultats de recherche. Cela se produit seulement quelques fois par an, quand Google procède à des changements majeurs. L'impact concerne les résultats naturels (organiques) ainsi que Discover.

Pourquoi Google fait des Core Updates ?

Google effectue des Core Updates pour améliorer la qualité et la pertinence des résultats de recherche. Ces évolutions sont essentielles pour répondre aux critiques concernant la qualité des résultats, pour combattre le spam et pour s'adapter aux évolutions des attentes des utilisateurs. Parfois, on a l'impression qu'une mise à jour vient corriger des problèmes apportés par la précédente...

Chronologie d'une Core Update

Google met sans doute plusieurs mois à préparer une Core Update, pour adapter son algorithme. Le jour où il est déployé, vous pouvez remarquer des gros changements pour votre site dans les SERP. Ces variations peuvent durer plusieurs jours, généralement près de 2 semaines, parfois encore plus.

A mon avis, les données sur lesquelles Google se base pour une Core Update ne datent pas des jours qui précèdent le déploiement. Je suppose qu'elles sont collectées au moins plusieurs semaines avant. Donc si vous avez chuté, ce n'est sans doute pas à cause de ce que vous avez fait juste avant (quelques jours). De la même façon, pour remonter il faut être patient (et améliorer le site de façon significative).

Ne ratez pas plus loin dans ce dossier ce que je conseille de faire pendant le déploiement et après, pour remonter d'ici la prochaine mise à jour.

Comment être alerté

Si vous souhaitez être au courant des prochaines Core Updates, je vous conseille de suivre le compte "Search Liaison" de Google. Vous avez le choix entre X/Twitter (@SearchLiaison géré par Danny Sullivan), LinkedIn, le blog officiel ou cette page spéciale.

Une autre excellente façon c'est de me suivre sur X/Twitter ou LinkedIn, et d'être abonné à ma newsletter.

Que faire en cas de Core Update Google ?

Attention au conseil "ne touchez à rien" pendant le déploiement

Je suppose que vous avez déjà lu qu'il ne faut rien faire et rien modifier sur son site tant que le déploiement d'une mise à jour Google est en cours, notamment les Core Updates.

C'est faux ! En tout cas c'est plus subtil que ça :

- le positionnement du site peut fortement fluctuer tant que le déploiement n'est pas terminé. Donc même si c'est tenant de regarder pour savoir si vous progressez ou pas, il ne faut pas réagir à chaud pour tenter de retrouver des positions perdues.

- mais ça ne change rien au fait que si la qualité du site dans son ensemble est insuffisante, c'est une erreur d'attendre des semaines pour l'améliorer !

Comment savoir si on est pénalisé par une Core Update ?

Vous ne pouvez pas avoir de confirmation officielle que votre site est pénalisé par un changement chez Google. Les seuls cas où Google vous prévient, c'est quand une pénalité manuelle est appliquée au site. Dans ce dernier cas, vous le voyez dans la section "Actions manuelles" de votre compte Google Search Console.

Pour savoir si l'impact est négatif pour votre site, consultez :

- votre outil de suivi du positionnement Google pour vos principaux mots-clés

- Google Search Console pour voir votre trafic organique Google (clics)

Que faire si vous avez chuté 📉

La cause n'est généralement pas un problème technique (sinon votre chute a lieu en dehors des Core Updates). Cela ne signifie pas qu'il ne faut pas optimiser votre référencement naturel sous l'angle technique (car cela vous aiderait à remonter). Cela signifie que la cause de la chute est généralement liée à votre contenu ainsi qu'à l'expérience utilisateur sur le site. D'après mon expérience, ça ne concerne pas souvent les backlinks.

Il y a tellement de choses à dire que je les ai regroupées dans un ebook de 35 pages. J'ai également tourné un tuto vidéo d'environ 40 minutes pour expliquer comment mes outils facilitent grandement ces analyses.

Si vous avez progressé 📈

Tant mieux, ça veut dire que vous avez bien bossé, et/ou que votre site correspond mieux qu'avant (et/ou que vos concurrents) à ce que Google cherche à promouvoir en haut de ses résultats.

Je vous conseille malgré tout de faire une analyse comparative (une fois que l'update est terminée), en comparant plusieurs semaines avant et après. L'objectif est de repérer si la mise à jour a été profitable à certaines parties du site plus qu'à d'autres.

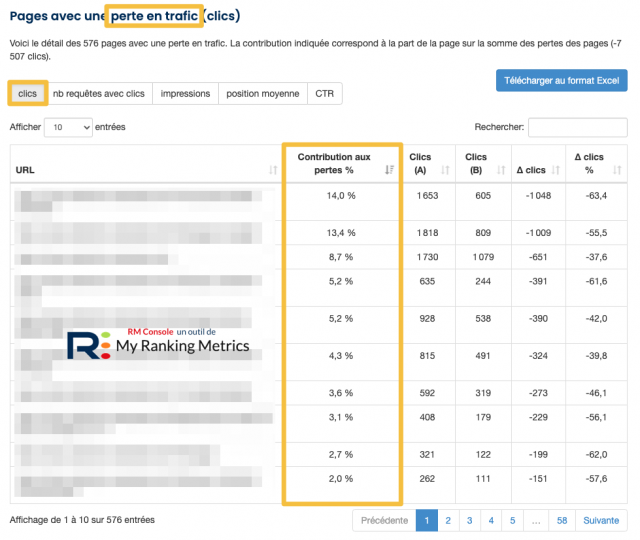

Cette comparaison se fait "en 3 clics" dans mon outil RM Console. Il suffit d'utiliser l'outil d'analyse de chute, qui montre en même temps les progressions. Vous obtenez une analyse qui vous prendrait au moins 1h à faire en exploitant manuellement toutes les données nécessaires...

Comment anticiper les prochains Core Updates

Les conseils de Google

On n'apprend jamais rien de vraiment exploitable... Voici ce que Google répète à chaque annonce :

Chaque jour, Google publie généralement une ou plusieurs modifications destinées à améliorer nos résultats. Certaines sont axées sur des améliorations spécifiques. D'autres sont des modifications générales. Parfois, il s'agit d'une mise à jour générale de l'algorithme de base. Nous procédons à ces mises à jour plusieurs fois par an.

Comme pour toute mise à jour, certains sites peuvent enregistrer des baisses ou des gains. Il n'y a rien de mal à ce que les pages soient désormais moins performantes. C'est plutôt que les changements apportés à nos systèmes profitent à des pages qui étaient auparavant sous-récompensées. Il n'y a pas de "solution" ("fix") pour les pages moins performantes, si ce n'est de continuer à se concentrer sur la création d'un contenu de qualité. Au fil du temps, il se peut que votre contenu soit plus performant que celui des autres pages.

Lisez cette page d'explications officielles de Google.

Mes conseils et ma méthode

Avec plus de 20 ans d'expérience en tant que consultant SEO, je connais parfaitement l'évolution de l'algorithme de Google. J'ai connu Panda en 2011, une des premières fois où la qualité du contenu comptait fortement. Et surtout, en tenant compte de l'ensemble du site (les mauvaises pages peuvent finir par dégrader les autres).

Cela fait donc ~15 ans que Google répète que la qualité globale du site est majeure. Et pourtant, encore beaucoup de monde néglige cet aspect...

C'est pour ça que ma méthode SEO repose dessus. Bien entendu, mon outil RM Tech (audit technique SEO) fournit une analyse :

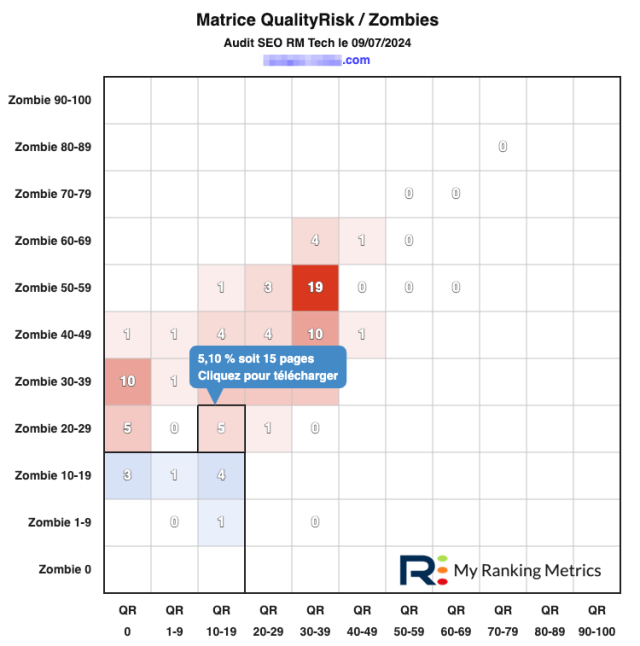

- de la qualité des pages (indice QualityRisk)

- et de leur pertinence selon Google (indice Zombie)

C'est le seul outil à vous fournir une telle analyse, et surtout une vue globale à l'échelle du site.

- QualityRisk indique à quel point une page cumule des problèmes techniques SEO

- Zombie va plus loin en tenant compte des performances SEO de la page depuis 1 an (mots-clés positionnés, positionnement, trafic)

- ces 2 indices vont de 0 (le mieux) à 100 (le pire)

En un coup d'oeil, la matrice QualityRisk Zombies montre à quel point le site est globalement de qualité et performant en SEO.

Voici les étapes à suivre (en boucle tous les mois) :

- Chaque mois, faites un audit du site avec RM Tech. Observez la matrice QualityRisk Zombies : la majorité des pages doivent être dans l'angle inférieur à gauche

- Dans votre travail SEO, chaque jour ou semaine, suivez ces 2 consignes :

- améliorez les mauvaises pages (indices QualityRisk et Zombies très élevés), essayez de "sauver" le maximum de pages, supprimez uniquement les pages irrécupérables ou sans aucun intérêt

- optimisez (encore) les bonnes pages, pour qu'elles dopent l'ensemble du site

- Mesurez l'impact de vos optimisations

Concrètement :

- la matrice est fournie avec l'audit RM Tech

- pour améliorer une page, vous êtes assisté avec RM Console. Cet outil utilise les données de l'audit et celles de Google Search Console pour vous fournir des recommandations grâce à l'IA

- pour savoir si vos optimisations fonctionnent bien, avec RM Console ça se fait en quelques clics

Dates des Core Updates de Google

Depuis 2018, Google utilise le terme "Core Update". Voici toutes les dates officielles (lien vers la discussion du forum WebRankInfo) :

- Core Updates en 2025 :

- Core Updates en 2024 :

- Core Updates en 2023 :

- Core Updates en 2022 :

- Core Updates en 2021 :

- Core Updates en 2020 :

- Core Updates en 2019 :

- Core Updates en 2018 :

En plus de ça, d'autres éléments majeurs ont été annoncés par Google :

- Helpful Content Update (HCU)

- Spam Update (lutte contre le spam)

- etc.

Avant 2019, les noms des gros changements d'algo Google étaient donnés par la communauté SEO. Il s'agit notamment de Panda et Penguin… Voyez ma liste des principaux algorithmes de Google.

Vos autres questions

Il y a généralement 2 ou 3 Core Updates Google par an, c'est variable d'une année sur l'autre. N'oubliez pas qu'il s'agit là des mises à jour principales de l'algorithme de classement, mais il y a des centaines ou milliers d'autres petits ajustements faits chaque année.

Personne ne peut prédire quand aura lieu la prochaine Core Update de Google. Parfois, Google annonce publiquement qu'une mise à jour sera bientôt déployée, mais on n'en sait pas plus. La fréquence des mises à jour n'est pas régulière.

La seule façon fiable de savoir si une Core Update Google est en cours, c'est de consulter la page Google Search Status Dashboard. Regardez dans la colonne "Duration" si la durée du déploiement est indiquée, ce qui signifie que la mise à jour est terminée. Sinon, c'est qu'elle est en cours.

La plupart des Core Updates de Google durent 2 à 3 semaines, au maximum 1 mois. Cette durée correspond à l'ensemble du déploiement, c'est-à-dire entre les 2 annonces officielles du début et de la fin. En réalité, il semble que le déploiement commence souvent quelques jours avant l'annonce officielle.

Google fait des milliers de mises à jour chaque année, mais certaines sont bien plus importantes que d'autres : on les appelle Core Update. Elles sont globales, basées sans doute sur une infrastructure importante d'algorithmes, de filtres et de traitements. HCU n'existe plus car c'est intégré dans les Core Updates.

Oui, les changements apportés par chaque Core Update de Google concernent aussi Discover, en plus des résultats de recherche traditionnels.

Non, je déconseille de désavouer des liens même si le site a été négativement touché par une Core Update. Sauf cas extrême, Google sait identifier les liens à ignorer. Ce n'est plus nécessaire de désavouer les liens. Contactez-moi si vous avez un doute.

Pour remonter après une Core Update, il faut généralement patienter plusieurs mois (3 à 6 mois environ). D'abord, car les améliorations nécessaires sur le site sont généralement importantes. Ensuite, car il faut que Google re-indexe chacune des pages concernées. Enfin, car il faut que Google ait le temps de récupérer des données liées aux utilisateurs avec ces nouvelles pages.

Pour suivre les fluctuations de positionnement de vos mots-clés pendant la Core Update, je vous conseille :

- Google Search Console car c'est gratuit (mais pas simple, vous allez perdre du temps)

- RM Console car c'est très simple et vous aurez le détail de tous vos mots-clés (des milliers)

- des outils de suivi de position si vous souhaitez compléter

Si vous avez des questions, posez-les dans le forum WebRankInfo.

Si vous préférez du consulting, j'en propose sur mon site WebRankExpert.

Bonjour Olivier,

J'ai une question : quels sont les updates à faire dans un article SEO en 2022 pour que Google considère ceux-ci comme tels?

Merci d'avance pour votre réponse.

La question n'est pas assez précise et de toutes façons personne ne peut vraiment dire comment mesurer un changement pour qu'il soit suffisant pour Google.

Le 1er niveau est de faire assez de modifications (ou ajouts ou suppressions) du contenu pour que Google décide de réindexer la page. On le voit parfois quand Google affiche une date pour la page, dans le snippet. Un paragraphe modifié ou ajouté, en plus d'une date mise à jour, peut suffire.

Le 2nd niveau est de faire assez pour que Google considère la page comme bien meilleure, à tel point que ça fait remonter le site s'il avait chuté après un core update. Dans ce cas, non seulement les améliorations doivent être significatives, mais ça doit concerner une grosse partie du site. Et ça nécessite un délai d'au moins 2 mois je dirais.

Bonjour Olivier ,

Question :sur le point #3 :

"Ajoutez aussi un filtre pour ne conserver que les pages dont l’indice QualityRisk est faible (par exemple inférieur à 20)"

Pourquoi, au contraire, ne pas filtrer les QualityRisk supérieur à 20 ?

Désolé, je n'arrive pas à saisir ce point :(

Merci :)

Les pages à QR supérieur à 20 sont généralement plus faciles à traiter, car il faut d'abord corriger leurs problèmes détectés par QR.

Celles à QR inférieur à 20 et pourtant NON performantes sont plus difficiles à repérer. Et l'analyse croisée avec Zombies est dans ce cas intéressante...

Merci pour cet article, effectivement rien d'étonnant dans les effets des updates. La méthode de l'indice zombie est très intéressante, à tester :)

Ca serait bien de pouvoir plugger search console et matomo pour ceux qui n'ont plus analytics.

Sinon je suis d'accord avec votre analyse sur les core updates

En effet Julien. Je suppose que tu as remplacé Analytics par Matomo à cause du RGPD

Excellent article qui synthétise bien ce qu'on observe, notamment au travers des nouveaux insights de la search console : si on déçoit le lecteur, Google s'en aperçoit et en tient compte !

Pour compléter, depuis début juin, je constate que la durée moyenne de lecture des sites dont nous nous occupons augmente alors que le trafic baisse. La qualité au détriment de la quantité, enfin !?

La durée moyenne de visite n'est pas un KPI assez fiable je trouve, sauf si c'est un site avec un grand nombre de pages vues par visite (genre Le Bon Coin)