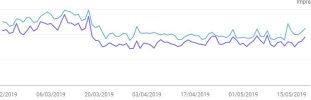

Google a confirmé sur Twitter avoir procédé à une mise à jour de son algorithme ("broad core algorithm update") comme ils le font plusieurs fois par an. Il s'agit dans ces cas d'une mise à jour (bien) plus importante que les centaines de petits détails qui sont modifiés au fil des semaines.

Voici une traduction de leur message :

Cette semaine, nous avons publié une vaste mise à jour de l'algorithme de base, comme nous le faisons plusieurs fois par an. Nos conseils au sujet de ces mises à jour demeurent les mêmes que ceux que nous avons décrits précédemment. S'il vous plaît voyez ces tweets pour plus d'informations à ce sujet.

Des SEO avaient remarqué hier des signes, comme on peut le lire ici.

Le nom choisi par les SEO pour cet update est "Florida 2". C'est idiot comme nom, mais c'est comme ça... C'est en référence à un événement SEO qui venait de se terminer et qui avait lieu en Floride, comme ce fut le cas il y a bien longtemps pour l'update Florida 1.

Ensuite, Google a proposé d'éviter de donner ce genre de noms, sans relation avec l'update, si bien que le nom final est Google Core Update March 2019...

Difficile de dire pour l'instant si c'est une mise à jour comparable à celle appelée "Medic" en août 2018, ou à celles qui ont suivi ensuite notamment fin septembre 2018.

EDIT du 10/04/2019 à 11h49 :

J'ai trouvé sympa l'article de Eric Lancheres à propos de cette mise à jour, voici donc quelques uns de ses commentaires ou conseils (ce sont les siens, pas les miens, j'ai juste ajouté quelques liens et commentaires) :

La mise à jour de mars 2019 de Google :

La procédure qui a fonctionné dans le passé pour récupérer les mises à jour "Core Update" est la suivante :

J'espère que ça en aidera un certain nombre parmi vous !

Voici une traduction de leur message :

Cette semaine, nous avons publié une vaste mise à jour de l'algorithme de base, comme nous le faisons plusieurs fois par an. Nos conseils au sujet de ces mises à jour demeurent les mêmes que ceux que nous avons décrits précédemment. S'il vous plaît voyez ces tweets pour plus d'informations à ce sujet.

Des SEO avaient remarqué hier des signes, comme on peut le lire ici.

Le nom choisi par les SEO pour cet update est "Florida 2". C'est idiot comme nom, mais c'est comme ça... C'est en référence à un événement SEO qui venait de se terminer et qui avait lieu en Floride, comme ce fut le cas il y a bien longtemps pour l'update Florida 1.

Ensuite, Google a proposé d'éviter de donner ce genre de noms, sans relation avec l'update, si bien que le nom final est Google Core Update March 2019...

Difficile de dire pour l'instant si c'est une mise à jour comparable à celle appelée "Medic" en août 2018, ou à celles qui ont suivi ensuite notamment fin septembre 2018.

EDIT du 10/04/2019 à 11h49 :

J'ai trouvé sympa l'article de Eric Lancheres à propos de cette mise à jour, voici donc quelques uns de ses commentaires ou conseils (ce sont les siens, pas les miens, j'ai juste ajouté quelques liens et commentaires) :

La mise à jour de mars 2019 de Google :

- est une mise à jour à l'échelle du site qui affecte toutes les pages d'un domaine

- n'affecte pas l'interprétation des mots sur une page

- accorde la priorité à l'expérience utilisateur plutôt qu'à la sur-optimisation. Les sites qui offrent une bonne expérience utilisateur ont connu une augmentation du trafic malgré certains problèmes à la page.

- Une publicité excessive qui mène à une mauvaise expérience utilisateur est l'une des principales raisons pour lesquelles les sites ont perdu du trafic.

- cible les sites qui offrent une mauvaise expérience utilisateur en raison de la lourdeur des éléments de la page (mauvaise navigation, pop-ups excessifs, etc.).

- a eu un impact négatif sur les pages excessivement commerciales qui se font passer pour des pages d'information.

- cible les sites dont le contenu est de faible qualité.

- Les sites qui offrent une bonne expérience utilisateur ont vu des améliorations dans les classements en dépit des problèmes persistants de cannibalisation des mots-clés.

- ne semble pas pénaliser les sites à cause des liens.

- La puissance de netlinking requise pour le classement est restée la même tandis que la quantité de backlinks diminuait.

- Les liens gouvernementaux ont tendance à devenir des propriétés de confiance.

- Bien que la mise à jour de base de mars repose toujours sur des mots-clés, LSI et des synonymes pour classer les pages, le terme correspondant exact est trouvé moins souvent qu'auparavant.

- Les sites ayant une intention commerciale élevée sont légèrement moins performants pour les requêtes commerciales après la mise à jour de base de mars 2019.

- Les sites à chargement rapide sont plus importants après la mise à jour de mars 2019. C'est probablement parce que des pages plus rapides mènent à une meilleure expérience utilisateur.

La procédure qui a fonctionné dans le passé pour récupérer les mises à jour "Core Update" est la suivante :

- Identifiez les pages au faible contenu, dupliquées et cassées qui gaspillent les ressources de Google, ce qui conduit finalement à une mauvaise expérience utilisateur.

- Améliorez, fusionnez ou supprimez les pages problématiques qui entravent la performance globale du site. (Note d'Olivier : ça correspond à ma méthode zombies)

- Identifiez les éléments répétés dans la plupart des pages qui peuvent contribuer à une mauvaise expérience utilisateur et faire rebondir les utilisateurs vers Google / quitter le site prématurément. (Il peut s'agir d'annonces excessives, d'une mauvaise navigation, d'un chargement lent des pages Web, etc.)

- Faites des tests d'optimisation fractionnés sur la page afin d'améliorer l'engagement des utilisateurs. (Augmenter le temps passé sur la page, le temps passé sur le site, le nombre de pages vues, réduire le taux de rebond, etc).

- Identifiez les contenus périmés qui ne sont plus utiles aux utilisateurs. (Note d'Olivier : encore similaire à mon approche zombies, ou bien aux pages inactives sur une longue période)

- Mettez à jour les contenus obsolètes ou supprimez-les. Attention à ne pas supprimer les pages contenant des backlinks.

- Effectuez une analyse à l'échelle du site des balises titre et des métadescriptions du site. Corrigez les balises de titre périmées qui pourraient contribuer à réduire le taux de clics (par exemple, les balises de titre qui contiennent une ancienne date).

- Effectuez une analyse complète des liens entrants (backlinks), en recherchant en particulier les liens à l'échelle du site qui auraient pu être utiles auparavant. Concentrez-vous sur l'augmentation de la puissance des pages tout en minimisant la quantité de liens. (Obtenez moins de backlinks, mais plus puissants, à partir de sources d'autorité.)

J'espère que ça en aidera un certain nombre parmi vous !

Dernière édition: